一、k-近邻算法简介

1.1、作者

k近邻法(k-nearest neighbor, k-NN)是1967年由Cover T和Hart P提出的一种基本分类与回归方法。

1.2、原理

存在一个样本数据集合,也称作为训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一个数据与所属分类的对应关系。输入没有标签的新数据后,将新的数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取样本最相似数据(最近邻)的分类标签。一般来说,我们只选择样本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数。最后,选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

通俗的讲:把样本提取特征标签,以标签为轴,用距离公式计算距离,统计 K 个距离最短的样本类型,以出现次数最多的类型作为新数据分类。

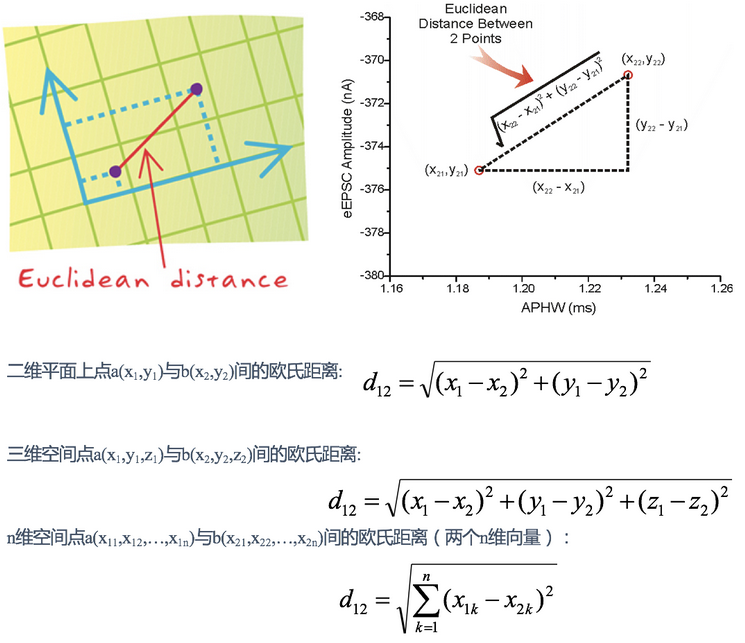

距离衡量的标准有很多,常见的有:欧氏距离、Lp距离、切比雪夫距离、马氏距离、巴氏距离、余弦值等。

1.3、欧氏距离公式

二、示例

2.1、电影分类

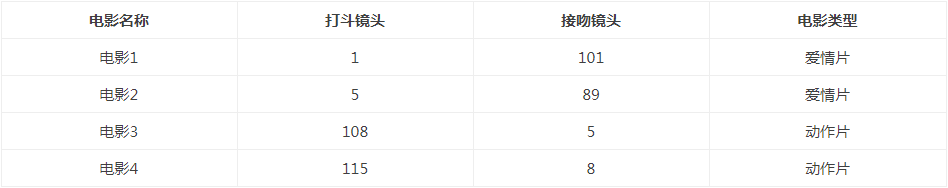

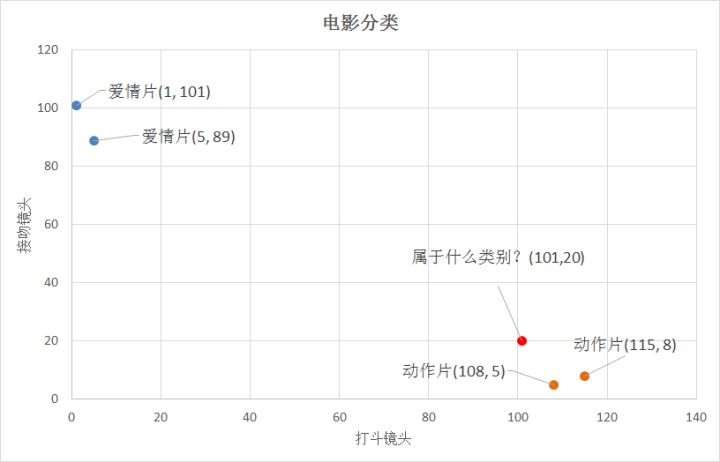

例如对电影进行分类:我们提取特征标签有打斗镜头、接吻镜头次数。

两个特征标签可以在二维坐标轴上,使用欧氏距离公式即为

d = √(x1-x2)2+(y1-y2)2

2.2、具体方法

- 准备数据:将数据分类,提取特征标签

- 分析数据:使用 K_NN 算法判断数据结果

计算每个训练数据和测试数据的距离,然后进行排序,取距离最近的前 K 个分类,分类最多的为测试数据最总分类。

2.3、python代码实现

# !/usr/bin/python

# -*- coding: utf-8 -*-

# @File : KNN_test1.py

import numpy as np

import operator

def createDataSet():

"""

函数说明:创建数据集

Returns:

group; 数据集

labels; 分类标签

"""

# 四组二维特征

group = np.array([[1, 101], [5, 89], [108, 5], [115, 8]])

# 四组特征的标签

labels = ['爱情片', '爱情片', '动作片', '动作片']

return group, labels

def classify0(inX, dataSet, labels, k):

"""

函数说明:kNN算法,分类器

Args:

inX: 用于分类的数据(测试集)

dataSet: 用于训练的数据(训练集)

labels: 分类标签

k: kNN算法参数,选择距离最小的k个点

Returns:

sortedClassCount[0][0]: 分类结果

"""

# numpy函数shape[0]返回dataSet的行数

dataSetSize = dataSet.shape[0]

# 在列向量方向上重复inX共1次(横向),行向量方向上重复dataSet共dataSetSize次(纵向)

diffMat = np.tile(inX, (dataSetSize, 1)) - dataSet

# 二维特征相减后平方

sqDiffMat = diffMat ** 2

# sum()所有元素相加,sum(0)列相加,sum(1)行相加

sqDistances = sqDiffMat.sum(axis=1)

# 开方,计算出距离

distances = sqDistances ** 0.5

# 返回distances中元素从小到大排序后的索引值

sortedDistIndices = distances.argsort()

# 定一个记录类别次数的字典

classCount = {}

for i in range(k):

# 取出前k个元素的类别

voteIlabel = labels[sortedDistIndices[i]]

# dict.get(key,default=None),字典的get()方法,返回指定键的值,如果值不在字典中返回默认值。

# 计算类别次数

classCount[voteIlabel] = classCount.get(voteIlabel, 0) + 1

# python3中用items()替换python2中的iteritems()

# key=operator.itemgetter(1)根据字典的值进行排序

# key=operator.itemgetter(0)根据字典的键进行排序

# reverse降序排序字典

sortedClassCount = sorted(classCount.items(), key=operator.itemgetter(1), reverse=True)

# 返回次数最多的类别,即所要分类的类别

return sortedClassCount[0][0]

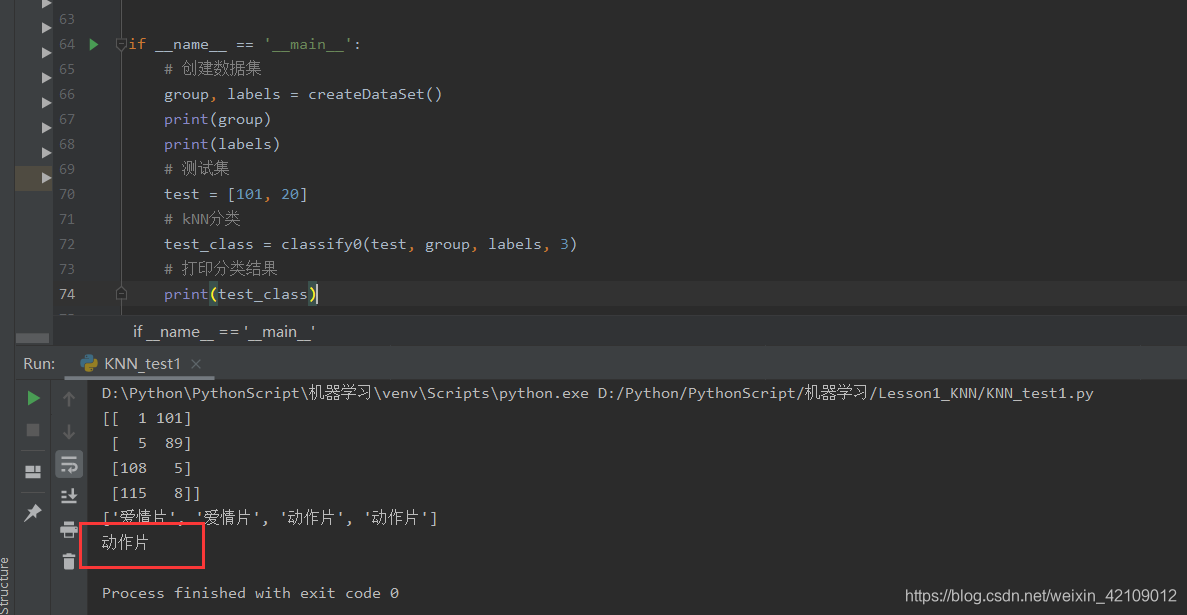

if __name__ == '__main__':

# 创建数据集

group, labels = createDataSet()

print(group)

print(labels)

# 测试集

test = [101, 20]

# kNN分类

test_class = classify0(test, group, labels, 3)

# 打印分类结果

print(test_class)

三、总结

3.1、优缺点

K-近邻法必须先把数据集存下来,然后类似于比对的来作比较。K近邻法实际上是利用训练数据集对特征向量空间进行划分,并且作为其分类的模型

优点:

- 多数表决规则等价于经验风险最小化.

- 精度高,对异常值不敏感,无数据输入假定

缺点:

- K值选择太小,意味着整体模型变得复杂,容易发生过拟合.但是K值要是选择过大的话,容易忽略实例中大量有用的信息,也不可取.一般是先取一个比较小的数值,通常采用交叉验证的方式来选取最优的K值.

- 计算复杂度高,空间复杂度高

3.2、注意

距离公式的选择和 K 的个数选择十分重要,例如:

(1)当 K 不同时,明显分类结果在改变

3.3、组成部分

(1)基准数据

(2)测试数据

(3)分类器