一.神经元模型

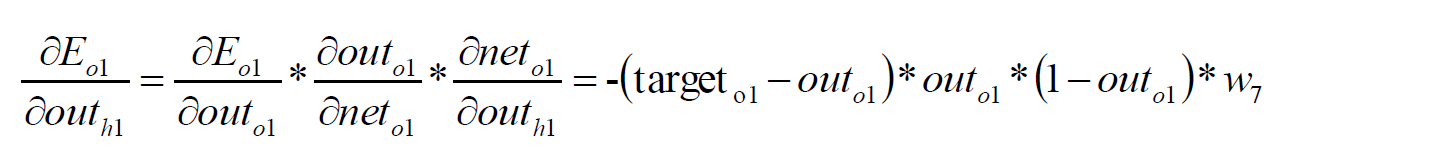

如下图是深度学习(deep learning)中神经元的模型,神经元是进行计算的基本单元。

其中x1、x2 和x3为输入,+1为偏置

神经元进行计算的数学公式可表示为:

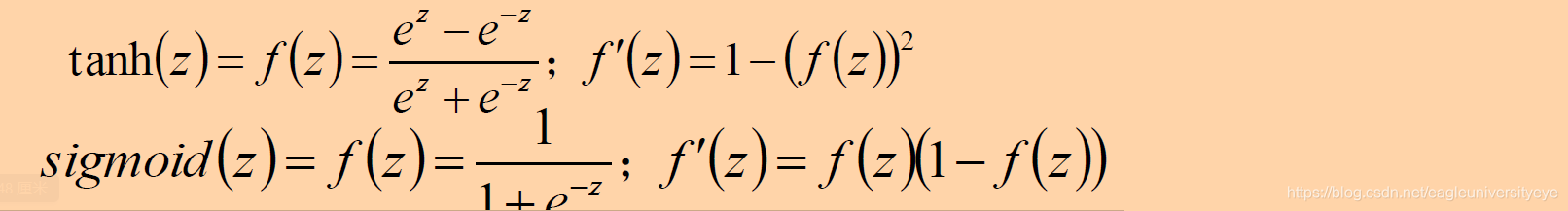

其中,激活函数F有多重,常用激活函数有sigmoid,Relu和tanh等

二.BP神经网络

2.1 BP神经网络原理

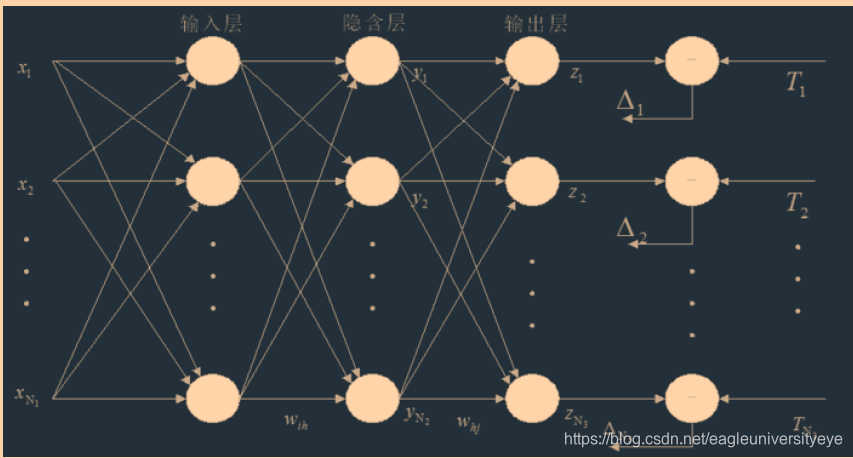

BP神经网络的工作原理图如下所示:

最左侧为输入,输入的右侧为神经元组成的各层,分别为输入层、隐含层、输出层。

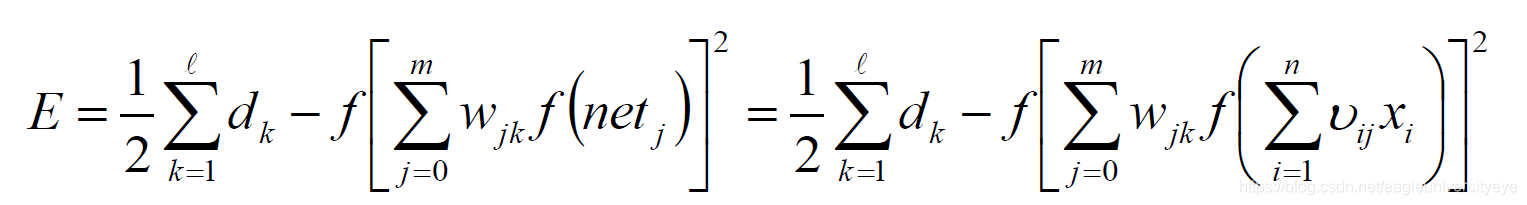

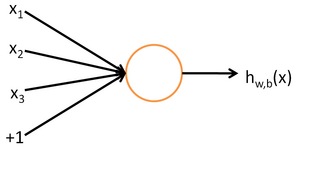

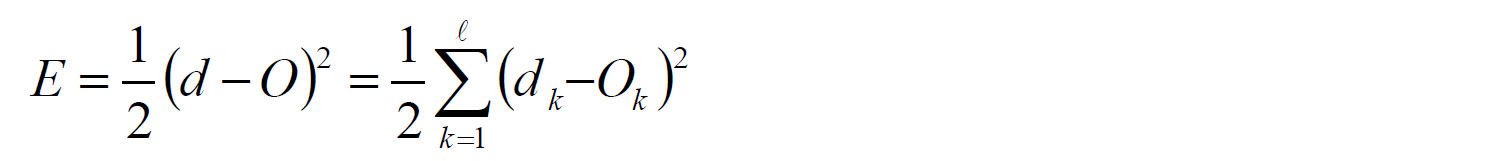

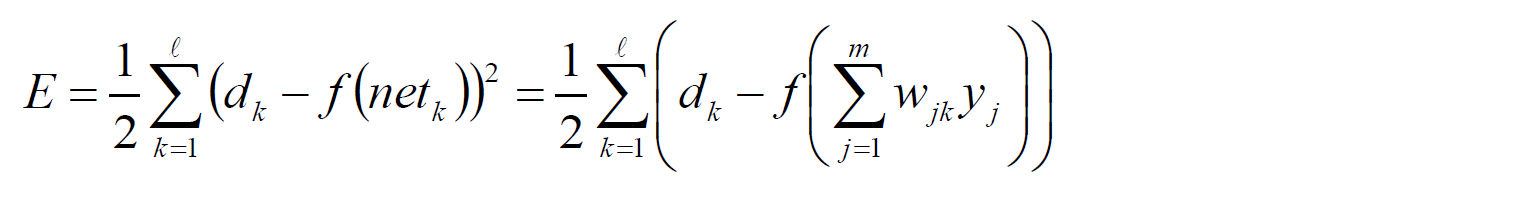

其中输入层的误差可用数学公式表达为:

2.2 BP神经网络应用示例

如下图是一个BP神经网络的模型,其中l1和l2为输入,这两者和偏置子b1构成输入层,w1到w12为权重,h1、h2、h3和偏置子b2构成隐含层,o1和o2构成输出层。

1)对权重和偏置赋初值

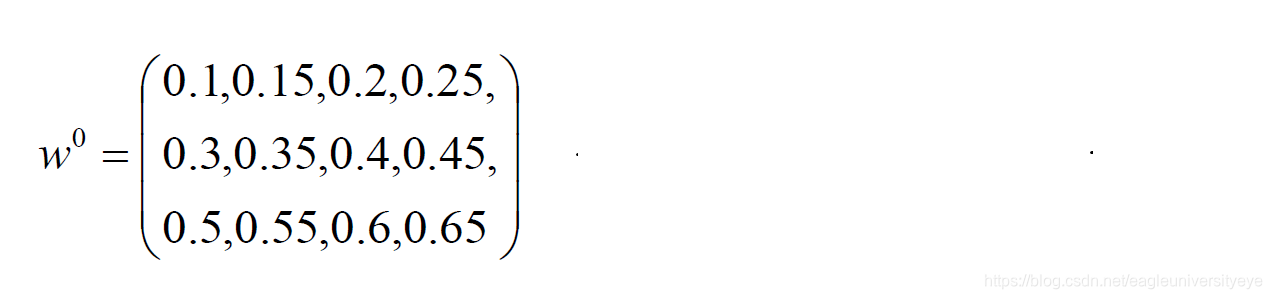

在起始阶段,首先使用随机函数对权重w和偏置b任意赋值,本例中对w1到w12和b1、b2分别赋以下初值。

w 0.1,0.15,0.2,0.25,0.3,0.35,0.4,0.45,0.5,0.55,0.6,0.65

b 0.35,0.65

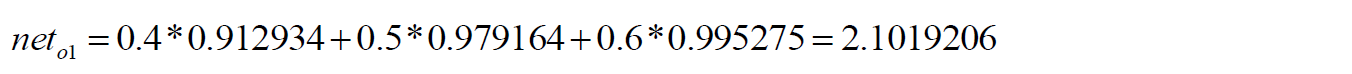

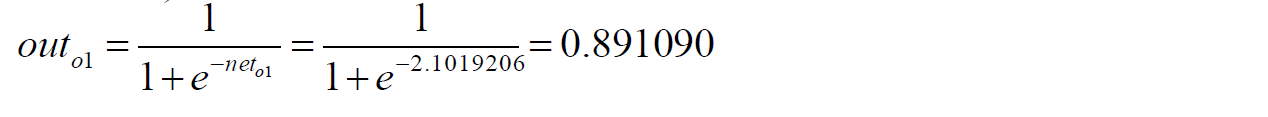

2)根据输入求出输出

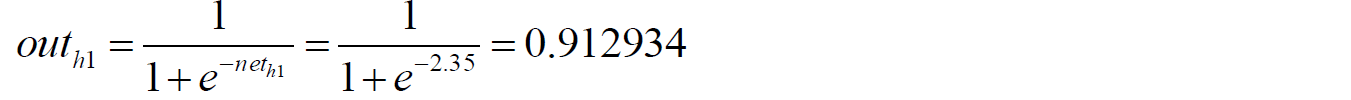

隐含层中h1的输入为:

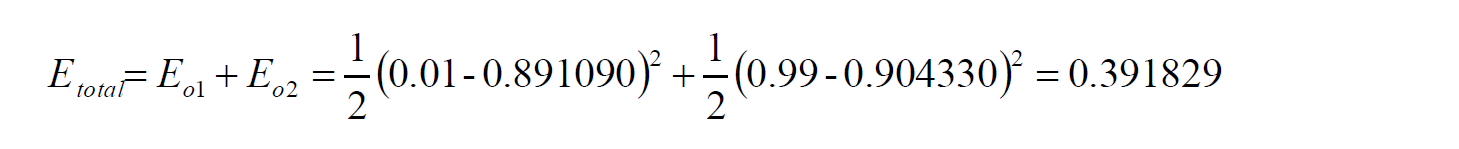

3)进行反向计算

在完成以上计算之后,根据求出的结果的误差,进行反向计算,采用偏导的方式,求各权重对总误差的影响,并根据影响的大小更新权重w和偏置b

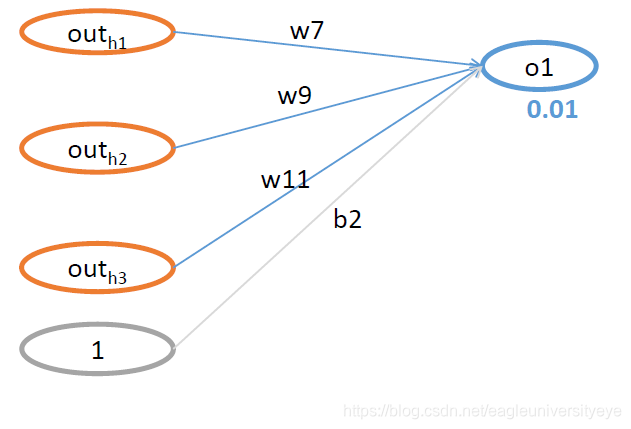

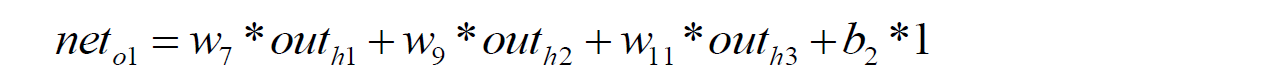

以隐含层偏置子w7和输入层偏置子w1两个偏置子为例,列举反向计算的方法

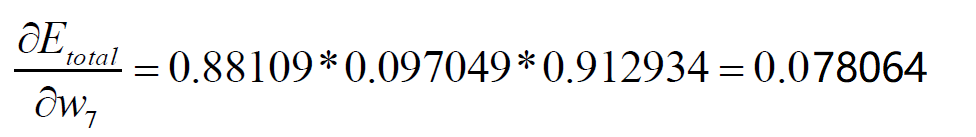

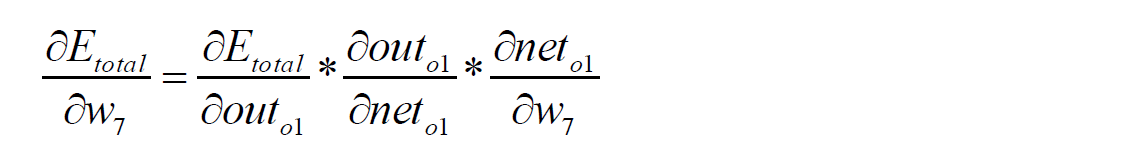

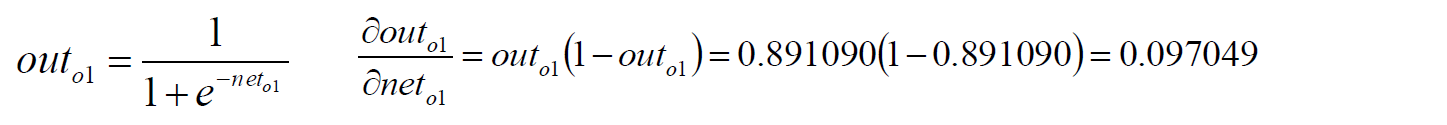

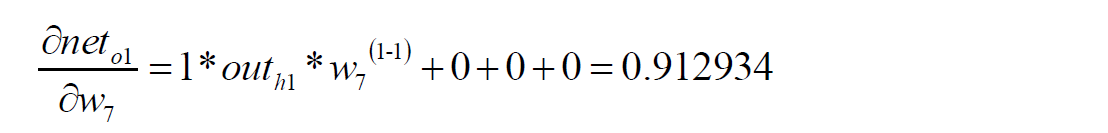

求w7对总误差的影响值:

由于无法直接计算w7对总误差的偏导数(没有体现w7和总误差关系的数学公式),所以利用BP神经网络,将w7对总误差的计算分为三部分的乘积,分别为o1的输出对总误差的偏导,o1的输入对o1的输出的偏导,w7对o1的输入的偏导

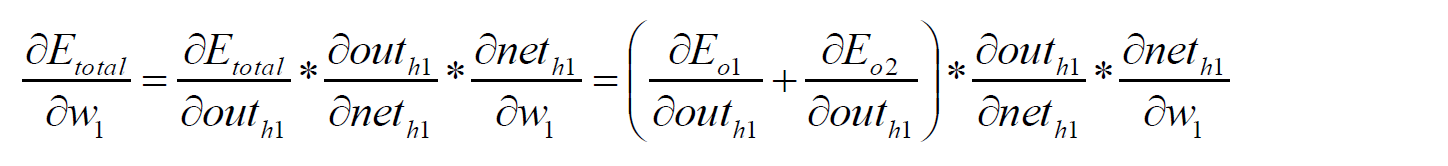

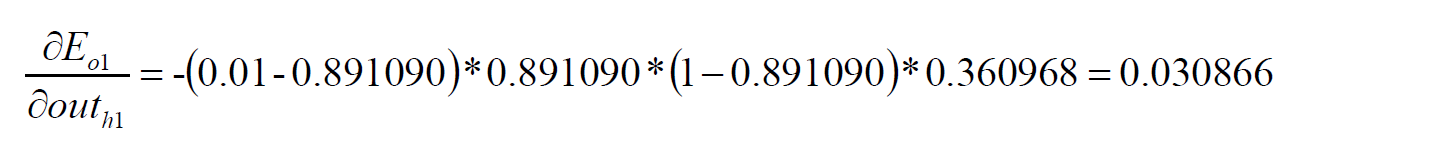

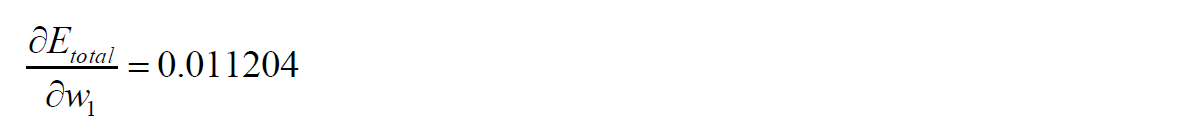

求w1对总误差的影响值:

由于w1是输入层的偏置子,所以其计算要比隐含层偏置子w7更麻烦一些。

如下所示,将w1对总误差的偏导进行分解,然后依次求出各部分的值

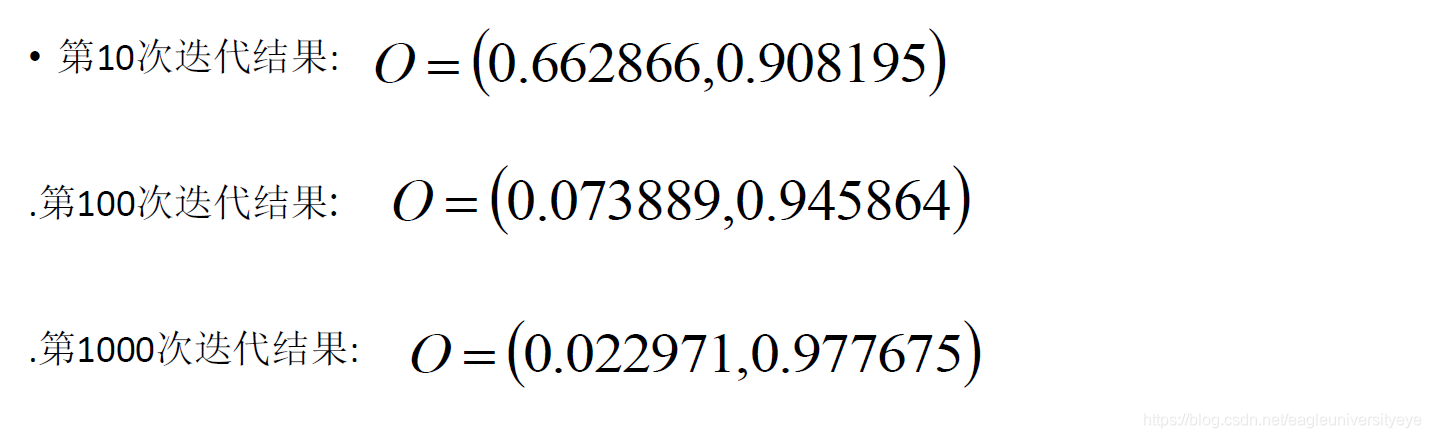

4)多次迭代

重复以上过程,多次迭代,以下为10次、100次、1000次迭代后的o1和o2的输出,迭代次数越多,效果越好

首次迭代前给w1到w12的赋值: