由于吴恩达离职百度,自立门户,他最近在网上特别火,连带着他的各种课程也跟着火了起来,那么在这个系列的博客里面,我会把吴恩达发布在Coursera上的Machine Learning课程中,每周的课程与任务摘要出来,给有中文学习需求的同学分享一下,同时也帮助我自己梳理一下知识网络,如有遗漏与错误,望CSDN的各位大神能够指点出来。

那么下面开始进入正文

WEEK 1:

首先是,

什么是机器学习?

Andrew给出了两种解释,第一种是:在不对电脑进行明确编程的条件下,使电脑获得学习能力。这种解释是机器学习刚刚诞生的时候,给出的对于机器学习的定义。而Andrew更加倾向于另外一种,更加现代化的定义:一个电脑程序可以通过任务T从经验E中学习并表现成为方法P(这里的P实际上指概率概率),然后通过经验E不断完善方法P。

有监督学习与无监督学习

主要说一下这两个的主要区别,有监督学习的输入数据,一定是带有标签的,这种机器学习方法,需要根据已有的标签来学习或预测之后的数据,常见的有监督普遍为回归算法和分类算法。无监督学习的输入数据是没有标签的,需要通过电脑来处理所有数据的值,并进行相应的判断与操作,常见的无监督普遍为聚类算法,但是已有的聚类算法的准确率却并不好测量,所以对于这类算法来说,难点在于如何计算准确率而不是设计算法。好了,回到刚刚的话题。

有监督学习的例子:数据{不同大小的房子在市场的真实房价},通过数据来预测不同大小房子的房价并得出准确率。无监督学习的例子:数据{1000000个不同基因},通过数据来使电脑自动的把这些基因分到几个不同的类别。

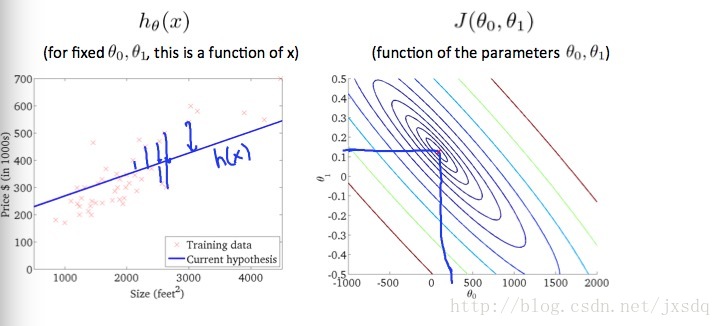

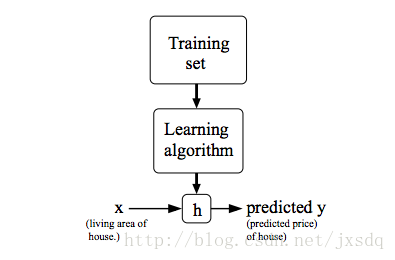

为了形象的表示,下图为机器学习的模型表示。

X代表输入数据input,y代表预测得到的数据output,中间的h是hypothesis的缩写,意思为处理数据X的方法或函数。而h由机器学习算法得来。

损失函数

损失函数(Cost Function)是第一周的重点讲述内容,其实不管在哪篇机器学习的入门课程中,cost function都是重中之重。损失函数代表了当前的h的质量,损失函数越小,证明h的质量越高。机器学习,是通过一个学习的过程而的到一个具有在处理同一类数据通用的方法h。那么h是在这个学习过程里面不断学习完善的,在这个学习的过程中,我们需要用到损失函数来对h进行调整。

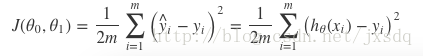

下面给出损失函数的公式:

其中,yi^为预测值,yi为真实值,J是损失函数,那么可以看出来,J是预测值与真实值的平方和的平均数,而J越小,上文提到过,当前这个函数的预测准确度就会越高。

之后Andrew举了两个例子,挑一个比较有代表性的说一下,由于我们目前所讨论的都是线性回归问题,这部分用到的是初中数学的斜率问题。

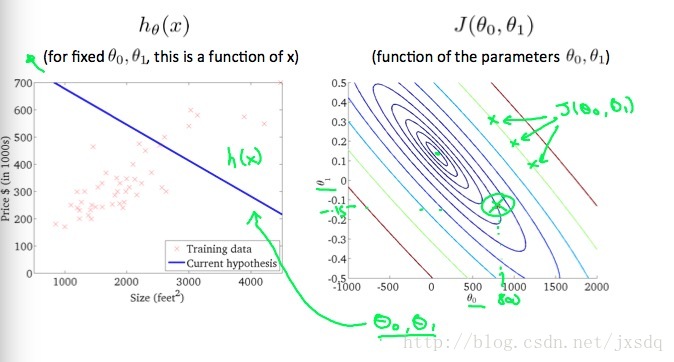

这边引入了一个等值线(contour line),下图右侧的就是一个等值线,图中的三个绿色点代表了三个斜率不同,但是损失值相同的三条回归方程线。

**

梯度下降:

**

好了,说完了损失函数,那么就要开始说如何通过损失函数,让我们的处理方法h逐渐变得合理,贴近最优解了。

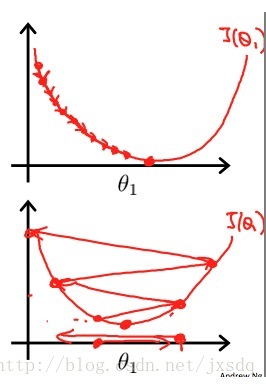

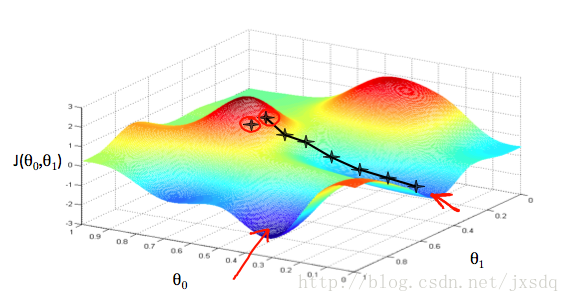

现在我们假设我们的h=θ0+ θ1*x那么可以把损失函数J构造成一个依赖于θ0和θ1的函数,那么如下图所示,我们只需要在开始的时候,随机定义一个θ0和θ1,然后找到该点的切线,然后根据梯度下降原理, 通过一个步长α(也就是学习率),来一步步找到最优解。

不过在这个图片中,大家可以看到热点图中,有两个表明红色箭头的位置,都是蓝色最优解,而且左边的蓝色明显比右边的要颜色更深,这代表着左边的损失函数值更小,但是通过目前的随机点,我们得到的是一个局部的最优解J2,而不是全局最优解J。这个是一个正常现象,梯度下降的一个缺点就是容易陷入局部最优,那么解决的方法就是使用模拟退火法,这个我猜测Andrew在之后的课程中会提及,我也会在之后的博客中写明这个问题,但是目前,可以带着这个问题,先继续往下看。

下面给出的是梯度下降的方程式:

通过不断地调整θj,我们最终会得到一个最优解θj。

这边Andrew强调了关于设置步长α的问题,假如α过大,那么我们可能会陷入一个死循环,每次都在最优解两侧不断徘徊而无法达到最优解,而如果α多小,我们就需要耗费太长时间来得到最优解,那么一个很好的解决办法是,让α自动的减小,而使θj能以最快的时间逼近最优解而不用担心第一种问题。

那么在本课时的最后,就是通过梯度下降来得到线性回归最优方程的一个实例,通过上述的损失函数和梯度下降,可以进行计算。

OK,WEEK1 COMPLETED!