AlexNet

:

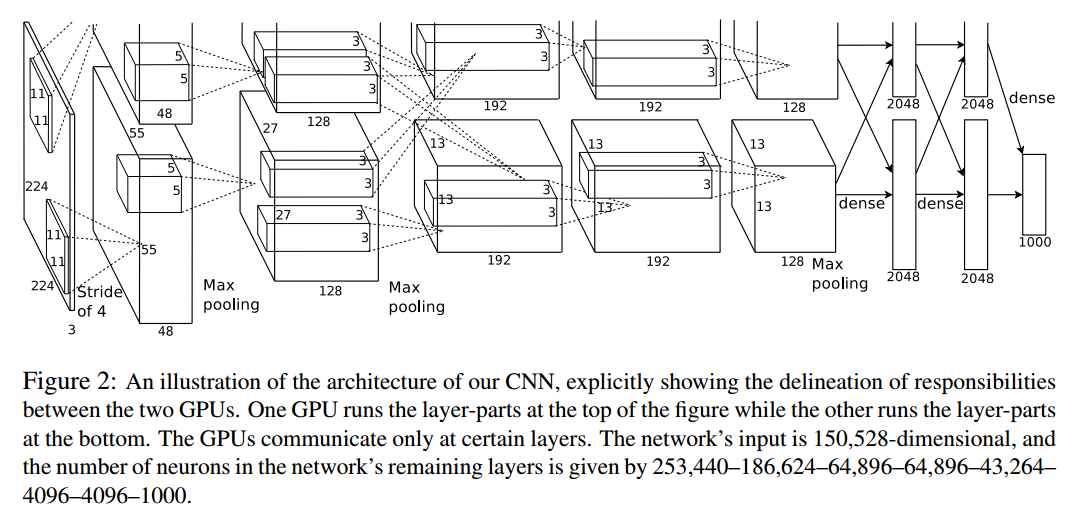

第一层:卷积层1,输入为 224×224×3 224 \times 224 \times 3224×224×3的图像,卷积核的数量为96,论文中两片GPU分别计算48个核; 卷积核的大小为 11×11×3 ; stride = 4, stride表示的是步长, pad = 0, 表示不扩充边缘;

卷积后的图形大小是怎样的呢?

wide = (224 + 2 * padding - kernel_size) / stride + 1 = 54

height = (224 + 2 * padding - kernel_size) / stride + 1 = 54

dimention = 96

然后进行 (Local Response Normalized), 后面跟着池化pool_size = (3, 3), stride = 2, pad = 0 最终获得第一层卷积的feature map

最终第一层卷积的输出为 27x27x96

第二层:卷积层2, 输入为上一层卷积的feature map, 卷积的个数为256个,论文中的两个GPU分别有128个卷积核。卷积核的大小为:5×5×48 ; pad = 2, stride = 1; (27-5+2*2)/1+1=27 27x27x128两组 然后做 LRN, 最后 max_pooling, pool_size = (3, 3), stride = 2;(27-3)/2+1=13 13x13x128两组

第三层:卷积3, 输入为第二层的输出,卷积核个数为384, kernel_size = (3×3×256), padding = 1, (13-3+1*2)/1+1=13 第三层没有做LRN和Pool 13x13x192两组

第四层:卷积4, 输入为第三层的输出,卷积核个数为384, kernel_size = (3×3), padding = 1,(13-3+1*2)/1+1=13 和第三层一样,没有LRN和Pool 13x13x192两组

第五层:卷积5, 输入为第四层的输出,卷积核个数为256, kernel_size = (3×3), padding = 1。(13-3+1*2)/1+1=13 13x13x128两组 然后直接进行max_pooling, pool_size = (3, 3), stride = 2; (13-3)/2+1=6 两组6x6x128

第6输入数据的尺寸是6x6x256,采用6x6x256尺寸的滤波器。4096个6x6x256尺寸的滤波器对输入数据进行卷积,通过4096个神经元的输出运算结果。

第6,7,8层是全连接层,每一层的神经元的个数为4096,最终输出softmax为1000,因为上面介绍过,ImageNet这个比赛的分类个数为1000。全连接层中使用了RELU和Dropout。

第7层输入的4096个数据与第8层的1000个神经元进行全连接