逻辑回归算法

机器学习可分为有监督学习,无监督学习,半监督学习,强化学习。对于LR来说,看成一种典型的有监督学习。

既然是有监督学习,训练集自然可以用如下方式表述:

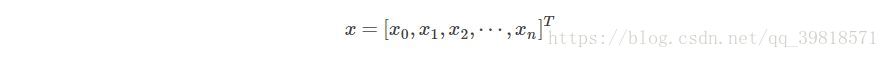

对于这m个训练样本,每个样本本身有n维特征。再加上一个偏置项x0, 则每个样本包含n+1维特征:

其中 x∈Rn+1, x0=1, y∈{0,1}

统计学习方法一书中:

分类是监督学习的一个核心问题,在监督学习中,当输出变量Y取有限个离散值时,预测问题便成为分类问题。这时,输入变量X可以是离散的,也可以是连续的。监督学习从数据中学习一个分类模型或分类决策函数,称为分类器(classifier)。分类器对新的输入进行输出的预测(prediction),称为分类(classification).

第一个有趣的问题产生了,Why使用logistics函数呢?

通过logistic函数的图像,我们很容易总结出他的以下优点:

1.他的输入范围是−∞→+∞ ,而之于刚好为(0,1),正好满足概率分布为(0,1)的要求。我们用概率去描述分类器,自然比单纯的某个阈值要方便很多;

2.他是一个单调上升的函数,具有良好的连续性,不存在不连续点。