如果对协方差不清楚的 点击这里《协方差的直观理解》

协方差矩阵

对于多维度数据通过协方差矩阵描述各个维度间的变换关系,而不是各个样本的之间的关系,对角线上是方差,非对角线是协方差;协方差为0时两者独立,其绝对值越大,两者对彼此的影响越大。

\[ C=\begin{pmatrix} cov(x,x)& cov(x,y)& cov(x,z)\\ cov(y,x)& cov(y,y)& cov(y,z)\\ cov(z,x)& cov(z,y)& cov(z,z) \end{pmatrix} \]

可见,协方差矩阵是一个对称的矩阵,而且对角线是各个维度上的方差。

理解协方差矩阵的关键就在于牢记它计算的是不同维度之间的协方差,而不是不同样本之间,拿到一个样本矩阵,我们最先要明确的就是一行是一个样本还是一个维度,心中明确这个整个计算过程. ‘

机器学习-降维方法

降维不仅可以降低数据维度,减少计算量,便于优化,更可以可以去除数据噪点,其更深层次的意义在于有效信息的提取综合及无用信息的摈弃。因为在降维的过程中,会选择最大化分散程度的方向。便于提取具有跟大特征意义的维度。

目的

数据降维的目的:数据降维,直观地好处是维度降低了,便于计算和可视化,其更深层次的意义在于有效信息的提取综合及无用信息的摈弃。

好处

降维可以方便数据可视化+数据分析+数据压缩+数据提取等。

方法

**映射方法 _**线性映射方法:PCA、LDA、SVD分解等

PCA(Principal Component Analysis)

PCA方法简介 主成分分析的思想,就是线性代数里面的K-L变换,就是在均方误差准则下失真最小的一种变换。是将原空间变换到特征向量空间内,数学表示为Ax=λx。

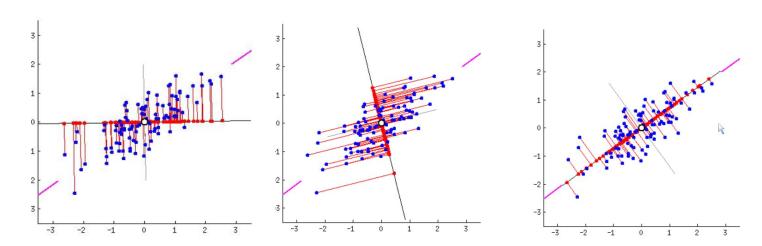

通俗理解:就是找出一个最主要的特征,然后进行分析。最大化投影后数据的方差(让数据更分散),如果投影到线上,发现数据越紧密,那么模型越难将这些点区分.

思想

• 投影后样本越分散,保留的信息越多

PCA优缺点:

优点:1)最小误差。2)提取了主要信息

缺点:1)计算协方差矩阵,计算量大

PCA步骤

假设原始数据是10(行,样例数,y1-y10)*10(列,特征数x1-x10)的(10个样例,每样例对应10个特征)

(1)、分别求各特征(列)的均值并对应减去所求均值。

(2)、求特征协方差矩阵

对角线上是方差,非对角线是协方差;协方差为0时两者独立,其绝对值越大,两者对彼此的影响越大。

(3)、求协方差阵的特征值和特征向量。

(4)、将特征值按照从大到小排序,选择其中最大的k个。将其对应的k个特征向量分别作为列向量组成特征向量矩阵。

这个矩阵就是我们要求的特征矩阵(也称特征脸),里面每一列就为样本的一维主成分。把样本矩阵投影到以该矩阵为基的新空间中,便可以将n维数据降低成k维数据。

(5)、将样本点投影到选取的k个特征向量上。

这里需要捋一捋,若原始数据中样例数为m,特征数为n,减去均值后的样本矩阵仍为MatrixDATA(m,n);

协方差矩阵是C(n,n);

特征向量矩阵为EigenMatrix(n,k);

投影可得: FinalDATA(m,k)=MatrixDATA(m,n) * EigenMatrix(n,k) 。