Multi-Oriented Scene Text Detection via Corner Localization and Region Segmentation发表于2018年的cvpr,该文章通过结合角点检测和图像分割来对图像文字进行定位

Introduction

目前文字定位方法分为两个分支,一是基于物体检测的方法(SSD,YOLO,DenseBox),如TextBoxes,FCRN,EAST等。还一种是基于图像分割的方法。本文是将上述两种方法结合,提出的一种新的检测方法。

通过文章的结果可以看出F-measure会比EAST高一点,但是速度比EAST慢。

Network

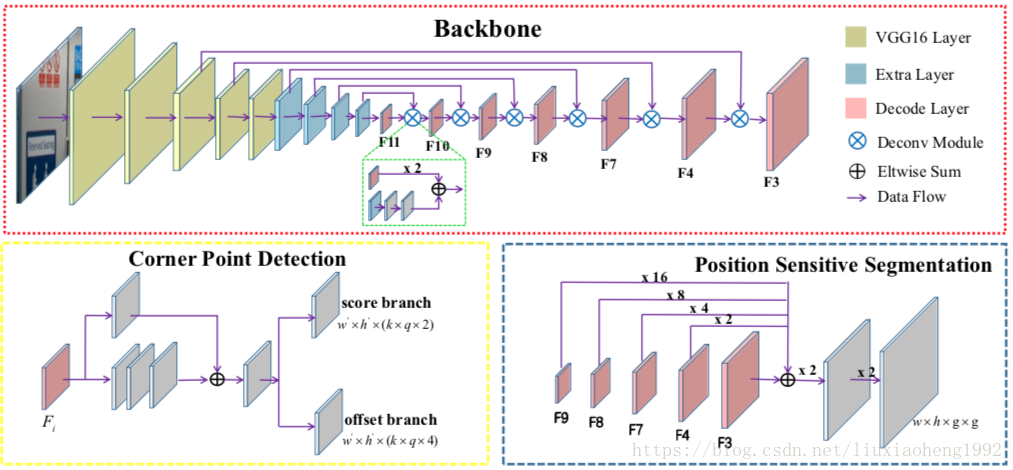

文章中的网络结构采用FPN/DSSD的网络结构,如下图所示

1. Feature Extraction

如上图红色框所示,文中采用VGG16,将fc6和fc7层换成卷积层conv6和conv7,并在后面添加了一些卷积层(conv8, conv9, conv10, conv11),用于增加感受野的范围。之后采用DSSD的top-down pathway结构,解卷积采用了从conv11到conv3的feature map(其中conv10到conv3的featrue map被重用),输出的feature命名为

。最后得到的conv11,和所有解卷积的feature maps用于角点和位置敏感图(position-sensitive)的预测

2. Corner Detection

对于一个旋转矩阵来讲,可以通过顺时针分布的四个角点

来得到,这四个点位置分别为左上,右上,左下,右下。为了更方便的检测角点,文中对角点进行的新的定义,

,其中

代表一个角点如(

这个左上角点),同时它也是一个水平矩形的中心点,ss代表的是待检测旋转矩形的短边。这里意思就是将待检测角点用一个水平矩形表示,角点的位置就是这个水平矩形的中心,检测出水平矩形就相当于检测出角点的位置。

通过上面角点的重新定义,检测角点的方法就可以类似于SSD和DSSD,利用定义的default boxes(类似于Faster RCNN中的anchor boxes)来进行矩形的检测。与物体检测有所不同的是,同一个位置可能存在多个角点(例如同一个位置可能同时为左下角点和右上角点)。所以对于大小为 的feature map同时有k个default boxes的情况,score branch输出的类别分数(是否存在角点)通道数为 ,offset branch输出的通道数为 ,其中q代表角点的类型,默认为4。这部分如上图中的黄色框所示。

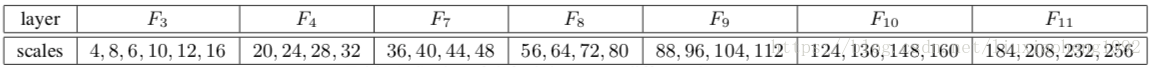

default boxes的scales设置如下表所示,其中default boxes的长宽高比为1。

3. Position-Sensitive Segmentation

这部分如上图中的蓝色框所示

对于一个文本框,可以将框等分为

部分,本文中分为

也就是四个区域,这部分的预测用于对上面检测出的框打分使用。下面会说明。

这部分的输出是重用了

,上采用至

大小然后相加,最后连续使用两个Conv1x1- BN-ReLU-Deconv2x2 块,得到

通道大小与输入图像一样的feature map。

Training and Inference

1.Training-Label Generation

对于每个输入训练样本,首先将标注转换成包围字符区域最小的矩形,然后确定4个角点的位置。

对于一个旋转矩形,4个角点的确定遵循下面两个规则:

- 左上与左下两个点的x坐标小于右上和右下两个点的x坐标

- 左上与右上两个点的y坐标小于右上和右下两个点的y坐标

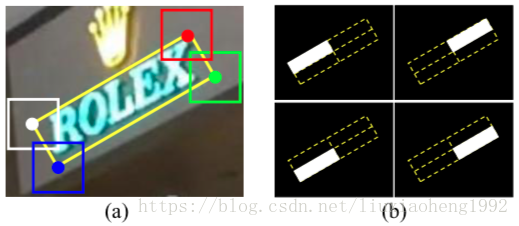

通过确定好的4个角点就可以确定旋转矩阵的位置了,计算旋转矩阵的短边就可以使用一个水平正方形重新定义角点了,通过一件确定的旋转矩阵可以很方便的求的position-sensitive segmentation掩码,所得的label结果如下图所示

2.Training-Optimization

损失函数如下:

其中, 和 表示角点检测中score branch和offset branch输出的loss, 表示position-sensitive segmentation的损失函数。 表示正例default boxes的个数, 表示分割maps中的像素个数(分割)。 和 为loss函数的平衡因子,文中分别取值为1和10。

采用的是交叉熵计算

表示真实标签,

表示预测值

采用smooth L1 loss计算:

和

定义同Fast RCNN

采用Dice loss:

表示label值,

表示预测值

3.Inference-Sampling and Grouping

在通过角点检测得到一系列的角点后,将score小于0.5的角点忽略,然后使用NMS得到最终的候选角点信息。

因为一个旋转矩阵能通过两个点和垂直与两点连线的一条边确定,在预测各个角点时短边长度已知,这时将所有候选角点与对应短边组合就可以得到一系列的候选矩形了。

在得到候选矩形的过程中有一些过滤的规则:

- 比如左上角点的x坐标是必须小于右上角点的x坐标

- 旋转矩形的短边必须大于某个阈值,文中设为5

- 两个待组合点预测的短边 必须满足

4. Inference-Scoring

对于得到的候选矩形,将其划分为

,然后利用segmentation maps,将属于每一块(总共

块)的segmentation对应的像素相加后求平均,最后将

个平均值再求平均值得到候选矩形框的分数,此过程如下图所示。

设定阈值为0.6,旋转矩形分数小于阈值的被过滤

到这基本就是该文章的所有原理了。

欢迎加入OCR交流群:785515057