一元线性回归:

对于样本[(x1,y1),(x2,y2),……(xn,yn)],xi为特征,yi为标签。(字幕i代表下标)

假定y与x有:

y = f(xi) = w*xi + b

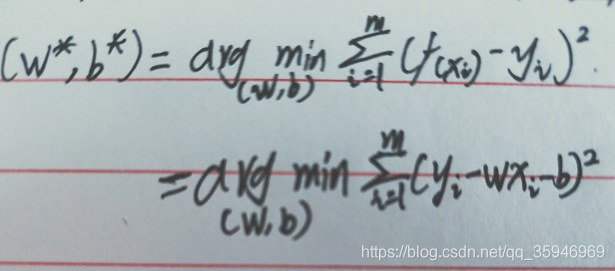

确定参数w和b的值的关键在于如何衡量f(x)与y之间的差距,即

** 基于均方误差最小化来进行模型求解的方法成为“最小二乘法”。与之前所讲的梯度下降法同属一类。

求解上式的过程被称为线性回归模型的最小二乘“参数估计”。

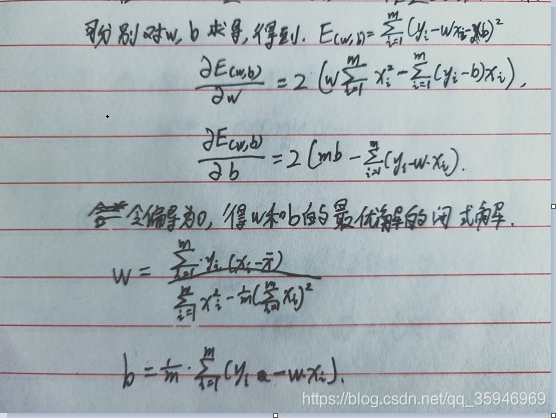

过程如下:

具体推导过程……懒得推……

多元线性回归的推导

多元线性回归的推导与一元线性回归有所不同,可以使用代数表示和矩阵表示两种方法来推导。

我们简述一下矩阵推导过程:

对于多元变量x,有假设函数:

f(xi) = w的转置 * xi + b (w、xi、b均为向量)

则有如下推导表示:

梯度下降法在之前的一片记录过,之后还会对BGD和SGD进行一次记录。