有一个公众号叫 “夕小瑶的卖萌屋” ,这位公众号推荐说 李航的《统计学习方法》是一门基础课。因此我从网上找了找资源 ,着手去看了。觉得写得确实很棒。

首先,以前看机器学习理论总是单独看,分着看,觉得关联规则就是关联规则,神经网络就是神经网络。但是这本书能让我有着一种想法,就是将整个机器学习串联起来。

首先什么是统计学习呢,统计学习也称作统计机器学习。按照百度百科的意思就是从统计学的角度上,发展起来的机器学习理论。

统计学习三要素

在本书中,将统计学习建模过程概括为三个要素。模型,策略,算法。

模型:不同的模型功效不一样

策略:

损失函数:也叫做代价函数,这个比较熟悉了,比如普通最小二乘回归中用的均方误差就是损失函数,或者信息熵等等。

风险函数:就是损失函数的期望值,也可以叫做期望损失。定义如下:

这里面的L就是损失函数,p就是x与y 的联合分布。。意思就是如果知道联合分布之后就能够知道风险函数了。 但是这不可能啊,知道联合分布了,求边际分布很容易就求出来了,然后求条件概率不就求出来了么,所以说这个想法行不通。

由于以上的策略行不通,所以又想了个策略。根据大数定律,无穷样本的均值就是期望值。但是现实中也不可能有无穷的样本,所以说对这个方法需要改进才能使用。所以自然而然就想到了经验风险最小。

当样本量足够大时,极大似然估计就是经验风险最小化的一个例子。但是当样本量很小的时候,经验风险最小化就容易产生过拟合现象。

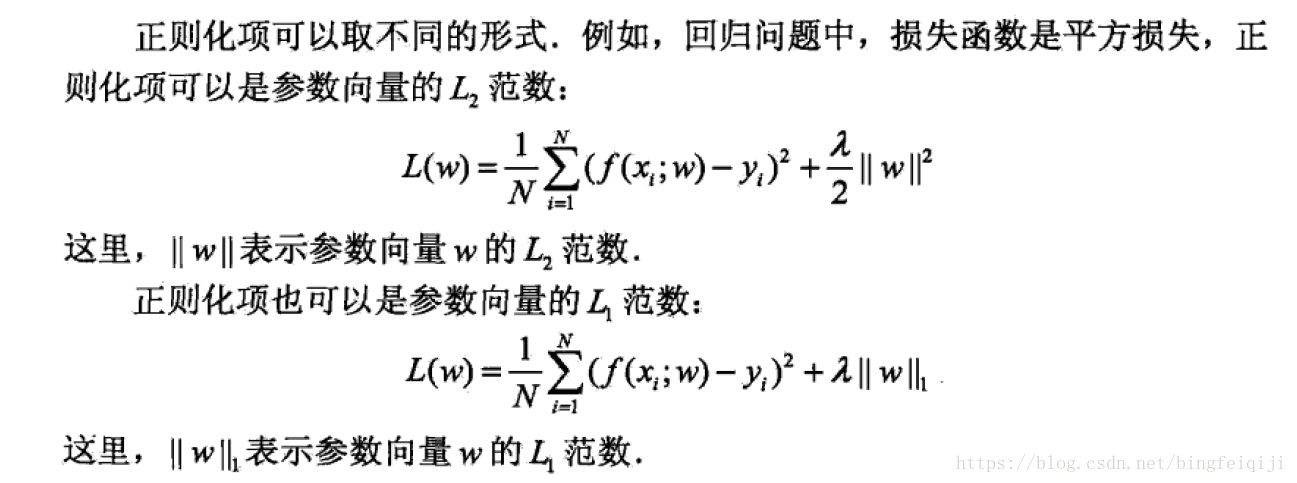

结构风险最小化是为了防止过拟合而提出来的策略。结构风险最小化等价于正则化。就是加入正则化项或者叫惩罚项。当然正则项人们都知道有第一范数和第二范数,,之后用时候再说吧。

算法:算法是指学习模型的具体计算方法。

模型评估与模型选择

对于模型的评估,在这本书里仅仅说了用训练误差和测试误差来对模型进行评估,其实我到现在也是只知道这种方法对模型进行评估,看误差大不大,,最多就是画一个交叉图,离散数据的话查看数据分类的正确率。

对于模型的选择,由于训练模型存在过拟合问题,所以可能需要加上一个正则项,,或者交叉验证。

正则项与交叉验证

正则项有两种范数两种范数

根据奥卡姆剃刀原则:在所有可能选择的模型中,能够很好的解释已知数据并且十分简单才是最好的模型,也就是 应该选择的模型。

交叉验证:

如果数据充足,将模型分为三个部分,训练集、验证集和测试集。

如果数据不充足,有三种方法可以使用。简单交叉验证,S折交叉验证,留一交叉验证

简单交叉验证:最简单的将数据几几开,分为训练集与测试集。然后对模型进行评估

S折交叉验证:将数据分为S个互不相交的大小相同的子集,然后利用S-1个子集数据进行模型训练。利用余下的子集测试模型。将这一个过程重复进行,最后选出测试误差最小的模型

留一交叉验证: 就是极值的将数据分为N个样本集,用S折交叉验证的方法,意思就是每个样本就是一个数据集。进行交叉验证,这种方法是在数据缺乏的情况下使用的。

ojbk,第一章完事了。泛化能力这一章搞得不是很懂,以后再说吧,坑是自己挖的,,以后慢慢补。其他章没什么好说的,都是基础。不说了

2018-8-20 21:09