1、统计学习三要素

除了介绍一些基本概念之外,李航《统计学习方法》第一章的重点是提出了统计学习的三要素,即

方法 = 模型 + 策略 + 算法

更确切地说,统计学习方法包括模型的假设空间、模型选择的准则以及模型学习的算法。今后在学习任何统计学习方法的时候可以从这三方面着手。

1.4节“模型评估与模型选择”与1.5节“正则化与交叉验证”都是对1.3.2节“策略”的补充。

“策略”指的是,既然在选定的模型空间中有很多具体的模型,我们要如何从中选出在测试集上表现最好的模型。书中只考虑监督学习问题,这时我们的目标是选出期望风险(式(1.9))最小的模型,从式(1.9)可以看出,要计算期望风险,就需要先计算输入/输出的联合分布,而这个联合分布又是不知道的(如果知道了就可以推出条件概率,也就不必“学习”了)。

解决这个“病态问题”的方法是,用经验风险或结构风险去近似期望风险。经验风险是模型在训练集上的平均损失,如果训练集样本容量足够大,根据大数定律,经验风险对期望风险的近似就足够好。但是如果训练集样本容量不足够大,仍用经验风险的话就会过拟合,就要对经验风险加以矫正,即加上正则项得到结构风险,来近似期望风险。正则项表示模型的复杂度,因此正则化符合奥卡姆剃刀原理。

从贝叶斯估计的角度看,正则化项对应于模型的先验概率。可以假设复杂的模型有较小的先验概率,简单的模型有较大的先验概率。

另一种解决训练样本较少的方法是交叉验证,交叉验证是一种重复利用数据的方法。关于交叉验证,可参考这篇文章 里的Lecture 2部分。

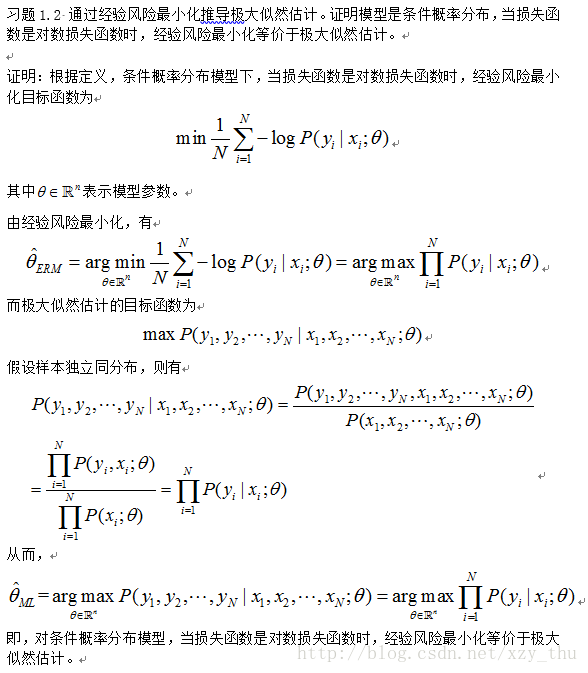

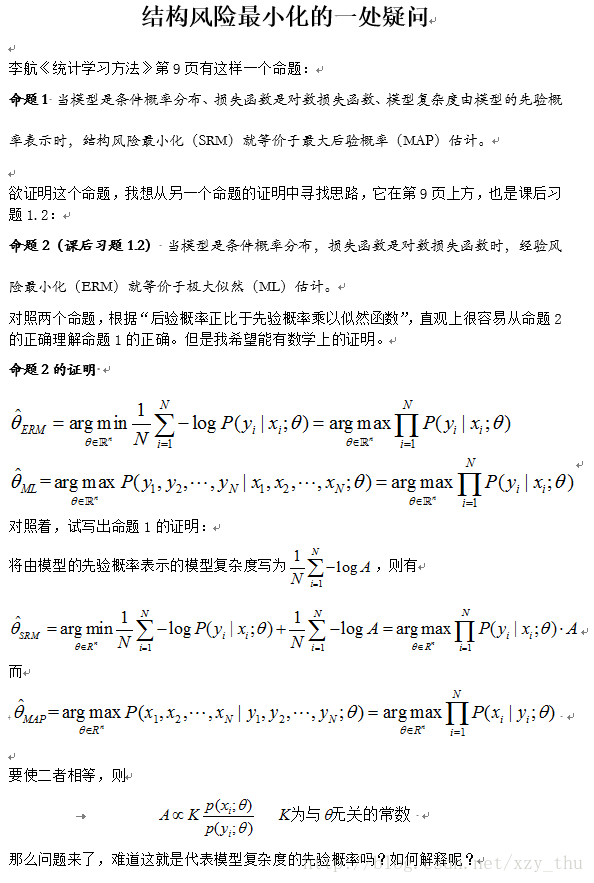

书中还说,在特定情况下,极大似然估计就是经验风险最小化的一个例子,最大后验概率估计就是结构风险最小化的一个例子。前者即习题1.2,我的证明将在下文给出。我在证明后者的过程中遇到了问题(也在下文给出),望本文读者不吝赐教。

关于“在特定情况下,最大后验概率估计就是结构风险最小化的一个例子”,可参考这篇知乎专栏 。

2、精确率、召回率、F1 值、ROC、AUC 各自的优缺点是什么?

可参考52ml的这篇文章 。