Cao Z, Wei F, Dong L, et al. Ranking with recursive neural networks and its application to multi-document summarization[C]// Twenty-Ninth AAAI Conference on Artificial Intelligence. AAAI Press, 2015:2153-2159.

##Abstract

RNN MDS

它将句子排序任务划分为一个层次回归过程,它将在解析树种同时测量句子及其成分的显著性。(每个非终结节点)

##Introduction

- RNN 句法分析,情感分析,话语分析表现不错

从单词级到句级的引导,RNN能够自动学习排名特征 - 具体说来,R2N2采用手工字特征作为输入。在前向传播步骤中,它用其子节点对递归地计算父节点的表示。

- 在反向传播步骤,对模型的权重监督性指导下更新树

- RNN对多文档摘要的贡献

- 它将句子排序转换成一个分层的回归任务。因此,可以考虑更多的监督知识。

- 它能够自动学习额外的句子排序特征,同时解析树上的成分

- 它提供了从单词到句子的一致的排名分数,这使得更准确的句子选择方法成为可能

##Relatedwork

- n-grams

N元模型详解-csdn - SVM

SVM原理详解

##Model - 输入都是相同维数的向量

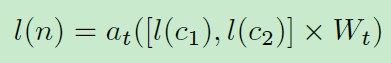

RNN通过在每个节点重复应用相同的神经网络来处理结构化输入(通常是二叉树)。可以从下往上计算每个节点的表示式:

Wt是转移矩阵,at是激活函数

l(,)表示节点的向量

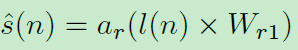

为了复制神经网络,所有节点必须具有相同的维数作为输入。 - 对于排序问题,每个非终端节点n与显著度s(n)相关联。在这种情况下,递归神经网络的目标是双重的。首先,它根据公式1计算树上的新表示。第二,它通过回归过程度量节点的重要性:

Wr1是回归矩阵,ar是回归函数

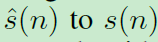

反向传播算法,更新Wt,以下面两个的误差作为引导

##Ranking Framework upon RNN (R2N2)

- Pre-processing

模型的输入结构是句子的解析树

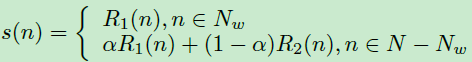

一个前端节点,因为它与一个字相关联,我们只是用rouge-1(R1)得分,它的上一层,rouge-1(R1)和rouge-2(R2)组合评分来衡量其重要性

一个显着的父节点预示着它的孩子也是显着的,反之不成立。由于ROUGE得分范围从0到1,我们选择

sigmoid(?)作为回归函数(ar =?)并进行评估

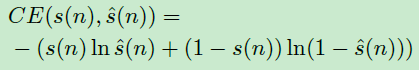

交叉熵(CE)的结果:

- Ranking with RNN

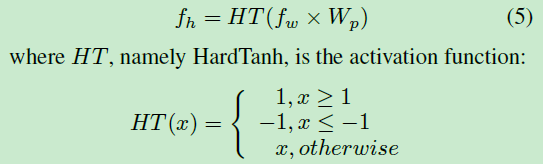

添加一个投影层,将原始fw转换成隐藏特征fh。

HT的优点是廉价的计算,同时留下良好的泛化性能。

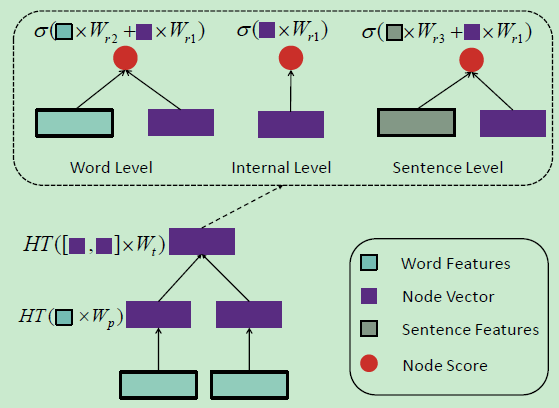

我们发现raw features大大提高了学习功能的性能。这种现象在机器翻译任务中也可以找到 - 模型如图:

一个圆表示一个值,而矩形代表一个向量。不同的颜色被用来区分特征类型,黑色边框表示这种类型的功能是手工制作的。我们使用虚线矩形表示三个文本级别的回归差异

##Features for Sentence Ranking

The input of our model consists of two parts: word-level features

fw and sentence-level features fs

##Sentence Selection - Greedy based Sentence Selection

- ILP based Sentence Selection