版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/Harrytsz/article/details/82817624

借鉴至:LionKing数据科学专栏

假设有一个数据集,希望通过一些特征

x

1

x_{1}

x 1

x

p

x_{p}

x p

y

y

y

y

y

y

y

≈

a

0

+

a

1

x

1

+

⋅

⋅

⋅

+

a

p

x

p

y \approx a_{0} + a_{1}x_{1} + \cdot \cdot \cdot +a_{p}x_{p}

y ≈ a 0 + a 1 x 1 + ⋅ ⋅ ⋅ + a p x p

记第

i

i

i

(

x

1

(

i

)

,

.

.

.

,

x

n

i

,

y

i

)

(x_{1}^{(i)},..., x_{n}^{i}, y^{i})

( x 1 ( i ) , . . . , x n i , y i )

n

n

n

第

i

i

i

y

^

(

i

)

=

a

0

+

a

1

x

1

(

i

)

+

.

.

.

+

a

p

x

p

(

i

)

\widehat{y}^{(i)} = a_{0} + a_{1}x_{1}^{(i)} + ... + a_{p}x_{p}^{(i)}

y

( i ) = a 0 + a 1 x 1 ( i ) + . . . + a p x p ( i )

我们将

a

0

,

a

1

,

.

.

.

.

.

,

a

p

a_{0}, a_{1}, ....., a_{p}

a 0 , a 1 , . . . . . , a p 最小化均方误差(Mean Squared Error) :

L

(

a

0

,

a

1

,

.

.

.

.

.

,

a

p

)

=

1

n

[

(

y

(

1

)

−

y

^

(

1

)

)

2

+

.

.

.

+

(

y

(

n

)

−

y

^

(

n

)

)

2

]

L(a_{0}, a_{1}, ....., a_{p}) = \frac{1}{n}[(y^{(1)} - \widehat{y}^{(1)})^{2} + ... + (y^{(n)} - \widehat{y}^{(n)})^{2}]

L ( a 0 , a 1 , . . . . . , a p ) = n 1 [ ( y ( 1 ) − y

( 1 ) ) 2 + . . . + ( y ( n ) − y

( n ) ) 2 ]

假设

x

0

=

1

,

x

1

,

.

.

.

.

.

.

,

x

p

x_{0} = 1, x_{1}, ......, x_{p}

x 0 = 1 , x 1 , . . . . . . , x p

X

n

×

(

p

+

1

)

X_{n\times (p+1)}

X n × ( p + 1 )

X

T

X

X^{T}X

X T X

(

a

0

,

a

1

,

.

.

.

.

.

.

,

a

p

)

(a_{0}, a_{1}, ......, a_{p})

( a 0 , a 1 , . . . . . . , a p )

X

T

X

[

a

0

a

1

.

.

.

a

p

]

=

X

T

y

X^{T}X\begin{bmatrix}a_{0}\\ a_{1}\\ ...\\ a_{p}\end{bmatrix} = X^{T}y

X T X ⎣ ⎢ ⎢ ⎡ a 0 a 1 . . . a p ⎦ ⎥ ⎥ ⎤ = X T y

因为

X

T

X

X^{T}X

X T X

p

p

p 梯度下降(Gradient Descent) 近似地估计参数。

Python中的 scikit-learn 包 可以进行线性回归模型的训练:scikit-learn线性回归模型文档

print ( __doc__)

import matplotlib. pyplot as plt

import numpy as np

from sklearn import datasets, linear_model

from sklearn. metrics import mean_squared_error, r2_score

diabetes = datasets. load_diabetes( )

diabetes_X = diabetes. data[ : , np. newaxis, 2 ]

diabetes_X_train = diabetes_X[ : - 20 ]

diabetes_X_test = diabetes_X[ - 20 : ]

diabetes_y_train = diabetes. target[ : - 20 ]

diabetes_y_test = diabetes. target[ - 20 : ]

regr = linear_model. LinearRegression( )

regr. fit( diabetes_X_train, diabetes_y_train)

diabetes_y_pred = regr. predict( diabetes_X_test)

print ( 'Coefficients: \n' , regr. coef_)

print ( "Mean squared error: %.2f"

% mean_squared_error( diabetes_y_test, diabetes_y_pred) )

print ( 'Variance score: %.2f' % r2_score( diabetes_y_test, diabetes_y_pred) )

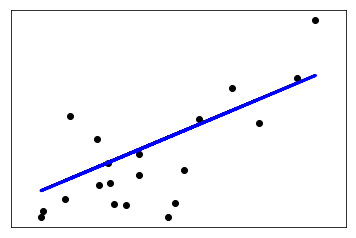

plt. scatter( diabetes_X_test, diabetes_y_test, color= 'black' )

plt. plot( diabetes_X_test, diabetes_y_pred, color= 'blue' , linewidth= 3 )

plt. xticks( ( ) )

plt. yticks( ( ) )

plt. show( )

输出:

当数据矩阵

X

n

×

(

p

+

1

)

X_{n\times(p+1)}

X n × ( p + 1 )

X

T

X

X^{T}X

X T X 数据的共线性

n

⩽

p

n \leqslant p

n ⩽ p

X

T

X

X^{T}X

X T X

解决共线性的方法主要有两种。第一种是找出共线性的列并且删除其中一列直到数据列满秩。第二种是使用正则化(Regularization)。

对于线性归回,正则化的两种是使用岭回归(Ridge Regression)或Lasso。

l

2

l_{2}

l 2

L

λ

(

a

0

,

a

1

,

.

.

.

,

a

p

)

=

L

(

a

0

,

a

1

,

.

.

.

,

a

p

)

+

λ

n

[

a

0

2

+

a

1

2

+

.

.

.

+

a

p

2

]

L_{\lambda}(a_{0}, a_{1},..., a_{p}) = L(a_{0}, a_{1},...,a_{p}) + \frac{\lambda}{n}[a_{0}^{2} + a_{1}^{2} + ...+ a_{p}^{2}]

L λ ( a 0 , a 1 , . . . , a p ) = L ( a 0 , a 1 , . . . , a p ) + n λ [ a 0 2 + a 1 2 + . . . + a p 2 ]

类似原来的正规方程,新的方程为:

(

X

T

X

+

λ

I

p

+

1

)

[

a

0

a

1

.

.

.

a

p

]

=

X

T

y

(X^{T}X + \lambda I_{p+1})\begin{bmatrix} a_{0}\\ a_{1}\\ ...\\ a_{p}\end{bmatrix} = X^{T}y

( X T X + λ I p + 1 ) ⎣ ⎢ ⎢ ⎡ a 0 a 1 . . . a p ⎦ ⎥ ⎥ ⎤ = X T y

由于

X

T

X

X^{T}X

X T X

λ

>

0

,

X

T

X

+

λ

I

p

+

1

\lambda > 0, X^{T}X + \lambda I_{p+1}

λ > 0 , X T X + λ I p + 1

λ

\lambda

λ

X

T

X

+

λ

I

p

+

1

X^{T}X + \lambda I_{p+1}

X T X + λ I p + 1

Lasso的思想是在均方损失误差的基础上加上参数的

l

1

l_{1}

l 1

L

λ

(

a

0

,

a

1

,

.

.

.

,

a

p

)

+

λ

n

[

∣

a

0

∣

+

∣

a

1

∣

+

.

.

.

+

∣

a

p

∣

]

L_{\lambda}(a_{0}, a_{1},..., a_{p}) + \frac{\lambda}{n}[|a_{0}| + |a_{1}| + ... + |a_{p}|]

L λ ( a 0 , a 1 , . . . , a p ) + n λ [ ∣ a 0 ∣ + ∣ a 1 ∣ + . . . + ∣ a p ∣ ]

Lasso的求解相对于岭回归复杂一些,主流的算法是 Least Angle Regression(LARS).

弹性网络(Elastic Net)结合了两者,同时使用

l

2

l_{2}

l 2

l

1

l_{1}

l 1

L

λ

(

a

0

,

a

1

,

.

.

.

,

a

p

)

=

L

(

a

0

,

a

1

,

.

.

.

,

a

p

)

+

λ

n

(

τ

∥

β

∥

2

2

+

(

1

−

τ

)

∥

β

∥

1

)

L_{\lambda}(a_{0}, a_{1}, ..., a_{p}) = L(a_{0}, a_{1}, ..., a_{p}) + \frac{\lambda}{n}(\tau \left \| \beta \right \|_{2}^{2} + (1 - \tau)\left \| \beta \right \|_{1})

L λ ( a 0 , a 1 , . . . , a p ) = L ( a 0 , a 1 , . . . , a p ) + n λ ( τ ∥ β ∥ 2 2 + ( 1 − τ ) ∥ β ∥ 1 )

其中,

0

⩽

τ

⩽

1

0 \leqslant \tau \leqslant 1

0 ⩽ τ ⩽ 1

τ

=

0

\tau = 0

τ = 0

τ

=

1

\tau = 1

τ = 1

弹性网络回归的好处是即保留了稀疏性,又可以把相关性高的变量同时找出来。

线性回归采用最小化残差平方和主要有三个原因:第一,数学上残差平方和的解,在数据列满秩的前提下,存在且唯一;第二,平方和的解有显式数学解可以精确求得;第三,最小化残差平方和等价于正态(Gaussian)假设下的最大似然估计(Maximum Likelihood Estimation)。

对于第三点,假设数据来自

y

=

X

β

+

ε

y = X\beta + \varepsilon

y = X β + ε

ε

∼

N

(

0

,

σ

2

)

\varepsilon \sim N(0, \sigma^{2})

ε ∼ N ( 0 , σ 2 )

给定数据

(

X

(

1

)

,

y

(

1

)

)

,

.

.

.

.

.

,

(

X

(

n

)

,

y

(

n

)

)

(X^{(1)}, y^{(1)}),.....,(X^{(n)}, y^{(n)})

( X ( 1 ) , y ( 1 ) ) , . . . . . , ( X ( n ) , y ( n ) )

i

i

i

y

(

i

)

−

X

(

i

)

β

y^{(i)} - X^{(i)}\beta

y ( i ) − X ( i ) β

L

i

=

1

2

π

a

e

x

p

[

−

(

y

(

2

)

−

X

(

i

)

β

)

2

2

σ

2

]

L_{i} = \frac{1}{\sqrt{2\pi a}}exp[-\frac{(y^{(2)}-X^{(i)}\beta)^{2}}{2 \sigma ^{2}}]

L i = 2 π a

1 e x p [ − 2 σ 2 ( y ( 2 ) − X ( i ) β ) 2 ]

总体的似然为

L

=

L

1

L

2

.

.

.

L

n

L = L_{1}L_{2}...L_{n}

L = L 1 L 2 . . . L n

l

=

l

o

g

L

1

+

.

.

.

+

l

o

g

L

n

l = logL_{1} + ... + logL_{n}

l = l o g L 1 + . . . + l o g L n

l

o

g

L

i

=

−

l

o

g

(

2

π

σ

)

−

1

2

σ

2

(

y

(

i

)

−

X

(

i

)

β

)

2

logL_{i} = -log(\sqrt{2\pi} \sigma) - \frac{1}{2 \sigma^{2}}(y^{(i)} - X^{(i)}\beta)^{2}

l o g L i = − l o g ( 2 π

σ ) − 2 σ 2 1 ( y ( i ) − X ( i ) β ) 2

l

=

−

n

l

o

g

(

2

π

σ

)

−

1

2

σ

2

[

(

y

(

1

)

−

y

^

(

1

)

)

2

+

.

.

.

+

(

y

(

n

)

−

y

^

(

n

)

)

2

]

l = -nlog(\sqrt{2 \pi}\sigma) - \frac{1}{2 \sigma^{2}}[(y^{(1)} - \widehat{y}^{(1)})^{2} + ... + (y^{(n)} - \widehat{y}^{(n)})^{2}]

l = − n l o g ( 2 π

σ ) − 2 σ 2 1 [ ( y ( 1 ) − y

( 1 ) ) 2 + . . . + ( y ( n ) − y

( n ) ) 2 ]

因此最大化

l

l

l

[

(

y

(

1

)

−

y

^

(

1

)

)

2

+

.

.

.

+

(

y

(

n

)

−

y

^

(

n

)

)

2

]

[(y^{(1)} - \widehat{y}^{(1)})^{2} + ... + (y^{(n)} - \widehat{y}^{(n)})^{2}]

[ ( y ( 1 ) − y

( 1 ) ) 2 + . . . + ( y ( n ) − y

( n ) ) 2 ]

岭回归从概率意义上可以看作在数据服从高斯噪声假设下,参数的先验分布(Prior Distribution)为以 0 为中心的正态分布。

β

\beta

β

N

(

0

→

,

τ

2

I

p

+

1

)

N(\overrightarrow{0}, \tau^{2} I_{p+1})

N ( 0

, τ 2 I p + 1 )

β

\beta

β

p

r

i

o

r

(

β

)

=

C

e

x

p

−

∥

β

∥

2

2

2

τ

2

prior(\beta) = Cexp-\frac{\left \| \beta \right \|_{2}^{2}}{2\tau^{2}}

p r i o r ( β ) = C e x p − 2 τ 2 ∥ β ∥ 2 2

其中

C

C

C

p

p

p

τ

\tau

τ

L

L

L

p

o

s

t

e

r

i

o

r

(

β

;

X

,

y

)

∝

p

r

i

o

r

(

β

)

L

posterior(\beta; X,y) \propto prior(\beta)L

p o s t e r i o r ( β ; X , y ) ∝ p r i o r ( β ) L

l

o

g

(

p

o

s

t

e

r

i

o

r

(

β

;

X

,

y

)

)

=

C

−

1

2

τ

2

∥

β

∥

2

2

−

1

2

σ

2

[

(

y

(

1

)

−

y

^

(

1

)

)

2

+

.

.

.

+

(

y

(

n

)

−

y

^

(

n

)

)

2

]

log(posterior(\beta; X, y)) = C -\frac{1}{2\tau^{2}}\left\| \beta \right\|_{2}^{2} - \frac{1}{2\sigma^{2}}[(y^{(1)} - \widehat{y}^{(1)})^{2} + ... + (y^{(n)} - \widehat{y}^{(n)})^{2}]

l o g ( p o s t e r i o r ( β ; X , y ) ) = C − 2 τ 2 1 ∥ β ∥ 2 2 − 2 σ 2 1 [ ( y ( 1 ) − y

( 1 ) ) 2 + . . . + ( y ( n ) − y

( n ) ) 2 ]

最大化后验似然等价于最小化:

[

(

y

(

1

)

−

y

^

(

1

)

)

2

+

.

.

.

+

(

y

(

n

)

−

y

^

(

n

)

)

2

]

+

σ

2

τ

2

∥

β

∥

2

2

[(y^{(1)} - \widehat{y}^{(1)})^{2} + ... + (y^{(n)} - \widehat{y}^{(n)})^{2}] + \frac{\sigma^{2}}{\tau^{2}}\left\| \beta \right\|_{2}^{2}

[ ( y ( 1 ) − y

( 1 ) ) 2 + . . . + ( y ( n ) − y

( n ) ) 2 ] + τ 2 σ 2 ∥ β ∥ 2 2

取

λ

=

σ

2

τ

2

\lambda = \frac{\sigma^{2}}{\tau^{2}}

λ = τ 2 σ 2

类似地,Lasso 可以视作给参数一个拉普拉斯分布(Laplace Distribution)作为先验。

Q:为什么需要正则化?

Q:为什么

l

1

l_{1}

l 1

Q:

R

2

R^{2}

R 2

Q:共线性应该如何检测?