一、概念

逻辑斯蒂回归又称为“对数几率回归”,虽然名字有回归,但是实际上却是一种经典的分类方法,其主要思想是:根据现有数据对分类边界线(Decision Boundary)建立回归公式,以此进行分类。

二、特点

1. 优点:计算代价不高,具有可解释性,易于实现。。不仅预测出类别,而且可以得到近似概率预测,对许多需要利用概率辅助决策的任务很有用。

2. 缺点:容易欠拟合,分类精度可能不高。

3. 使用数据类型:数值型和标称型数据。

三、逻辑斯蒂分布

逻辑斯蒂分布的分布函数和密度函数如下:

其中,是位置参数,

为形状参数。

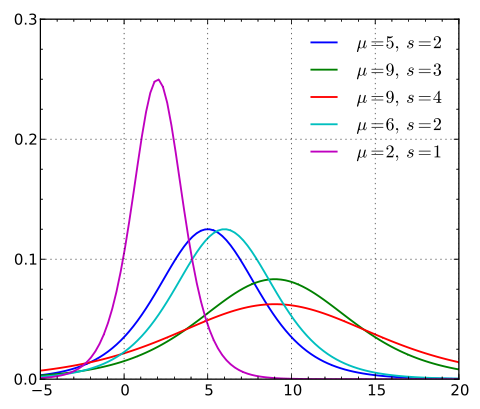

逻辑斯蒂分布在不同的和

的情况下,其概率密度函数

的图形:

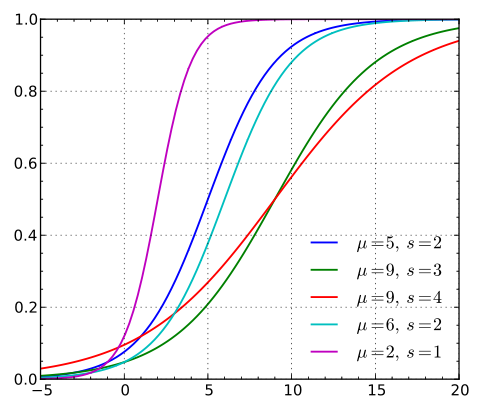

逻辑斯蒂分布在不同的和

的情况下,其概率分布函数

的图形:

逻辑斯蒂分布函数的图形是一条S形曲线(sigmoid curve),该曲线以点为中心对称,即满足:

曲线在中心附近增长速度较快,在两端增长速度较慢。形状参数的值越小,曲线为中心附近增长得越快。

当,

时,逻辑斯蒂概率分布函数就是我们逻辑斯蒂回归的sigmoid函数

。

四、逻辑斯蒂回归模型

对于分类问题,我们想要一个函数能够通过所有的输入预测出类别。

考虑较为简单的二分类情况,给定一个数据集,其中,

,

。

从线性回归模型产生的预测值是实值,为了分类,需要将

转换为0/1值。此时可以采用单位阶跃函数进行

到0/1的映射:

当预测值时,将其判为正例;当预测值

时,将其判为负例。

但该函数不连续,为了便于后续计算,我们希望得到一个连续可微的近似替代函数,因此我们选取了对数几率函数(logistic regression)作为替代函数,对数几率函数是一种sigmoid函数:

(1)

这样,就可以将任意输入映射到区间内,实现由值到概率的转换。

为便于讨论,使,其中

。此时,

就成为了

,

就成为了

,

就变成了

。将

代入(1)中得到:

(2)

(2)可以变换为:

(3)

若将视为样本

为正例的可能性,则

视为样本

为反例的可能性。两者的比值

称谓称为“几率(odds)”,,一个时间的几率就是指该事件发生的概率与该事件不发生的概率的比值,反映了

作为正例的相对可能性。对几率取对数得到对数几率

(log odds,亦称logit。)。即(2)实际上是用线性回归模型的预测结果去逼近真实标记的对数几率。

此时,若将(2)中的视为类后验概率

(就是说,对于样本点x,可以用sigmoid函数的结果来当做该点属于类别1的概率 ),则(3)可重写为:

(4)

显然可以得到我们希望学得的逻辑斯蒂模型:

(5)

(6)

令,则

。并将(5)、(6)整合称为一般形式,得到在已知参数

和数据

的情况下,预测值为

的条件概率:

(7)

将(7)连乘得到在已知参数和数据

的情况下,预测值为

的条件概率,这个条件概率在数值上等于,likelihood(w|x,y),也就是在已知现有数据的条件下,w是真正参数的概率,即似然函数(8):

(8)

由于乘法难解,通过对数可以将乘法转换为加法,简化计算。对数似然函数为:

(9)

似然函数表示样本成为真实的概率,似然函数越大越好,此时我们可以用梯度上升法求最大值,也可以引入一个负号转换为梯度下降法来求解。

代价函数为:

(10)

五、梯度下降法求参数

逻辑斯蒂回归学习中通常采用的方法时梯度下降法及拟牛顿法,下面介绍逻辑斯蒂回归中梯度下降法求参数。

求偏导:

(11)

因此,在使用梯度下降法求解时,每次迭代地更新公式为:

(12)

参考文献:

1. 《机器学习》第三章对数几率回归-周志华

2. 逻辑回归(logistic regression)的本质——极大似然估计

3. 逻辑回归推导