承接我的另一篇笔记:https://blog.csdn.net/uniqueyyc/article/details/81834947

此文包含进一步的实施细节和结果的消融研究,跨数据集实验,并与其他方法作比较。

此论文地址:http://deepcompletion.cs.princeton.edu/supp.pdf

1、Further Implementation Details

1.1. 网格重建和渲染

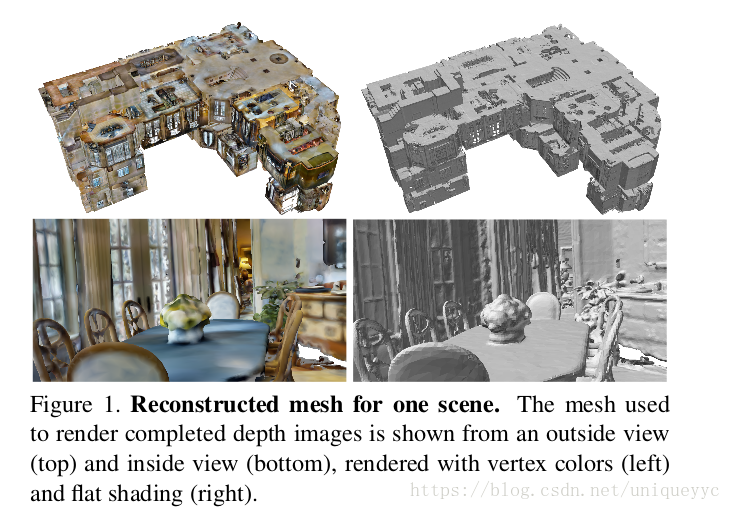

对于Matterport3D数据集中的每一个场景,网格被重构并渲染,使用以下过程提供“完成的深度图”

- 首先,每个房子都被人工划分成一些区域,这些区域与房间大致对应,使用一个交互式的平面绘制界面。

- 第二提取每个区域内包含RGB-D点(像素)的稠密点云,包括深度超过4米的像素(以避免重建网格中的噪声)。

- 第三,利用隐树深度11的泊松曲面重建【7】,从每个区域的点进行网格重建。然后对所有区域的网格进行合并,形成每个场景的最终重建网格M。原始的RGB-D视图通过使用OpenGL从该视图渲染M并读取深度缓冲。

图一显示了使用上述过程生成的网格的图像。顶部一行显示覆盖整个房子的外部视图。底部一行从内部视图显示网格的特写图像。

1.2. 网络架构

使用的网络是zhang et.all中提出的地表正太估计模型,并进行了修改。

【Y. Zhang, S. Song, E. Yumer, M. Savva, J.-Y. Lee, H. Jin, and T. Funkhouser. Physically-based rendering for indoor scene understanding using convolutional neural networks. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017. 1, 4】

Input

根据输入内容的不同,网络在第一个卷积层接受具有不同通道的数据。

- 颜色。颜色是一个三通道张量,每一个都有R G B 。强度值归一化为[-0.5, 0.5]. 如果需要的话使用双线性插值来调整彩色图像的大小。

- 深度。以米为单位的深度的绝对值作为输入,传感器没有深度信号的像素被赋值为0. 为了解决“缺失”和“零米”之间的模糊性,添加了一个二进制掩码来对传感器具有深度的像素进行标记,作为一个额外的通道。总的来说,深度输入总共包含两个通道(深度值以及二进制有效掩码)。为了消除不准确平滑,我们使用最近的邻近搜索来调整深度图像的大小。

- 颜色+深度。在这种情况下的输入是前面介绍的颜色和深度的连接。这就产生了一个5通道张量作为输入。

Output

对于绝对深度,表面法线,深度导数,网络分别输出1、 3和8个通道的结果。遮挡边界检测网络生成3个通道输出,代表每个像素属于“无边缘”、“深度折痕”和“遮挡边界”的概率。

Loss

深度、表面法线和导数作为回归任务进行预测。the smoothL1 loss用于训练深度和导数,the cosine embedding loss用于训练表面法线。将遮挡边界检测分解为分类任务,使用了交叉熵损失。最后两个批处理规范化层将被删除,因为这将在实践中获得更好的性能。

1.3. Training schema(训练模式)

在torch中实现了神经网络的训练和测试。对于所有的训练任务,使用RMSprop优化算法。momentum设置为0.9,batch设置为12。最初的学习率设置为0.001,并减少到每100k次迭代的一半。所有的模型300k迭代内收敛。

2. 进一步的实验结果

这部分提供了额外的实验结果,包含消融研究,跨数据集实验,并与其他深度补全方法进行比较。

2.1. Ablation Studies(消融研究)

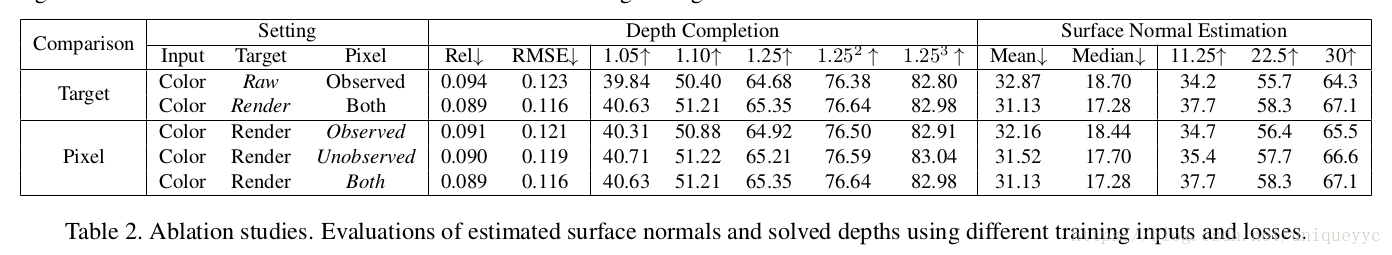

本文4.1节提供了消融研究的结果,旨在调查不同的测试输入、训练数据、损失函数、深度表示和优化方法如何影响我们的预测结果。

由不同设置训练的地表正态估计模型的定性结果。相比之下,通过我们的设置训练表面正态估计模型(即只使用彩色图像作为输入,所有可用的像素以渲染的深度作为监督,图中的第4列)达到了最好的预测质量,从而有利于深度补全的全局优化。

what kind of ground truth is better?(标定过的真实数据)

本实验研究了在对地面预报网络进行训练时,应采用何种法线来检测损失。使用原始深度图像计算的法线和从渲染网格计算的法线进行实验。结果显示,在表2的前两行(比较:target)中,基于渲染深度训练的模型比原始深度训练的模型表现更好。这种改进似乎部分来自于对未观测区域的训练像素,部分来自于更精确的深度(更少的深度)。

What loss should be used to train the network?

该测试研究了在对地面预测网络进行训练时,损失中应包含哪些像素。只使用未观察到的像素,只使用观察到的像素,以及两者都作为监督。这三个模型在我们的新数据集的训练分割被分别训练出来然后评估与测试集的呈现法线。定量结果的最后三行表2(比较像素)表明,模型训练同时监督从观察到的和未被注意的像素(底部行)略优于只使用未观察的像素和只使用观察到的像素。这表明,未观察到的像素确实提供了额外的信息。

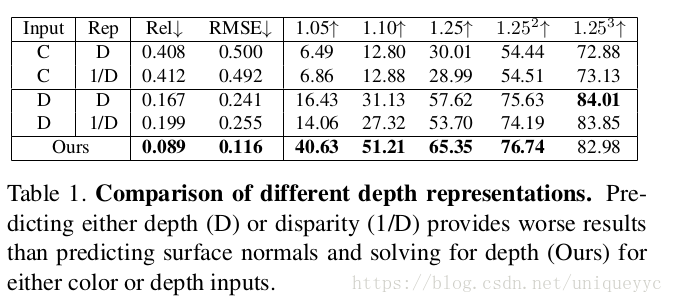

What kind of depth representation is best?

本文中考虑了几种深度表示(法线、导数、深度等)。本节提供了关于深度和视差的直接预测的进一步结果以增强/修复表2中的结果。实际上,表2的顶行(第二列的Rep是‘D’)被错误地描述为从颜色直接预测深度——实际上是从输入深度直接预测完全深度。正确的结果在表1的顶行(input-C,Rep-D)。结果非常相似:预测表面法线,然后求解深度比直接预测深度更好(Rel=0.089 vs 0.408)。

正如Chakrabarti等人以及其他文章的预测,我们还考虑了视差的预测而不是深度。我们训练模型分别从颜色和原始深度估计视差。结果如表1所示。我们发现,当给定颜色或深度作为深度补全应用程序的输入时,估计视差在性能上并不比估计深度更好。

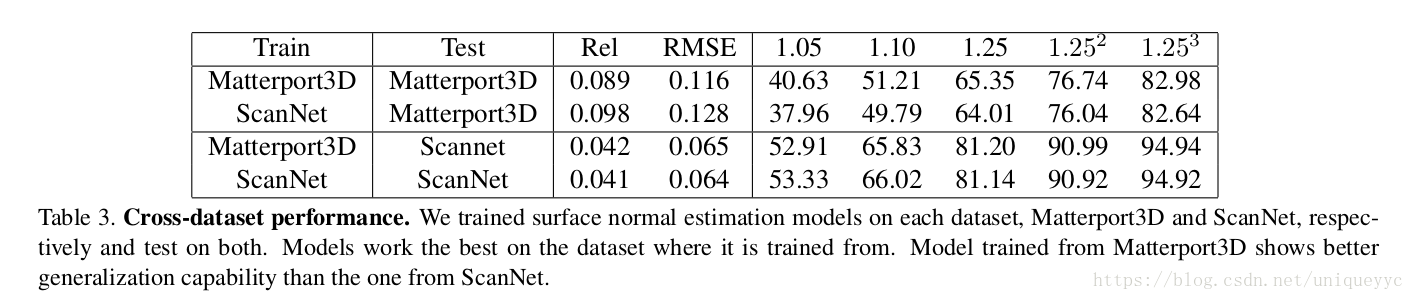

2.2. Cross-Dataset Experiments

这个测试考察是否有可能在一个训练集中训练我们的方法,并在另一个数据集中有效地使用它。

Matterport3D and ScanNet

我们首先在Matterport3D和ScanNet数据集之间进行实验。它们都有针对大型环境(每个大约1000个房间)的3D表面重建,因此为训练和测试我们的方法提供了合适的训练数据。我们分别在每个数据集上训练一个表面法向量估计模型,然后不用微调就可以对另一个测试集进行深度补全。

定量结果如表3所示。正如预期的那样,这些模型在与训练数据源匹配的测试数据集中工作的最好。实际上,与ScanNet的模型相比,Matterport3D训练的模型具有更好的泛化能力,这可能是因为Matterport3D数据集具有更加多样化的摄像机视点。然而,当在其他数据集上运行时,这两个模型仍然能够很好的工作(不进行微调操作)。我们推测这是因为我们的表面法向量预测模型上只训练在颜色输入上,这是相对相似的两个数据集。使用深度作为输入的替代方法可能也不会泛化,因为两个数据集的深度图像之间存在显著差异。

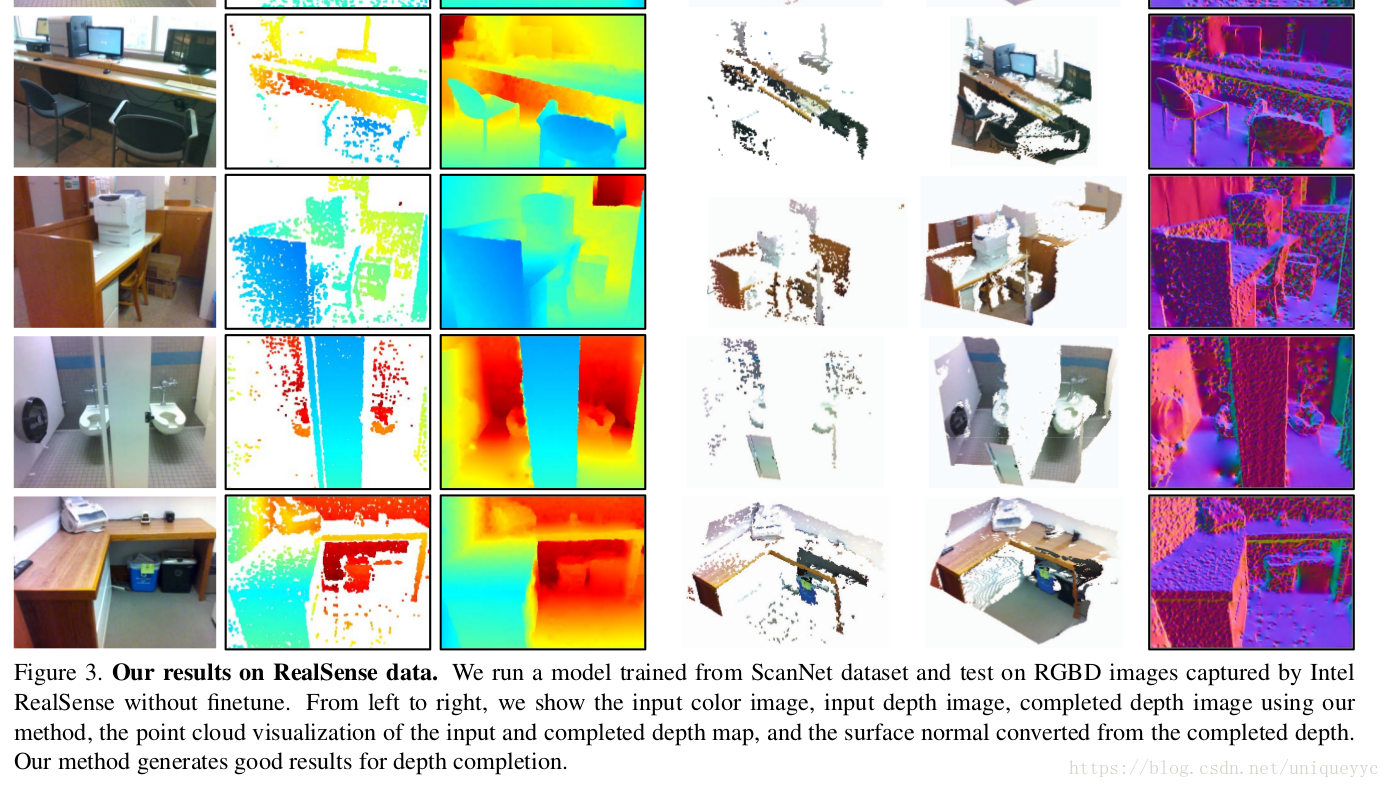

Intel RealSense Depth Sensor

来自Intel realsense的深度贴图在距离内质量较好,但包含的缺失区域比结构传感器多。对于远距离区域和表面有特殊的材料,深度信号可以完全丢失,也可以非常稀疏。我们从ScanNet数据库中训练一个表面法向量估计模型,并直接对从SUNRGBD数据集中Intel realsense采集到的RGBD图像进行了评估,没有任何精细计算。结果如图3所示。从左到右,展示了输入彩色图像,输入深度图像,完成深度图像,我们的方法,点云可视化的输入和完整的深度地图,表面法线转换成深度。可以看到,与Matterport3D与scannet相比,realsense的深度包含了更多的缺失区域。然而,我们的模式仍然产生了不错的结果。这再次表明,我们的方法可以有效地运行在不同深度传感器采集的RGBD图像上,深度模式明显不同。

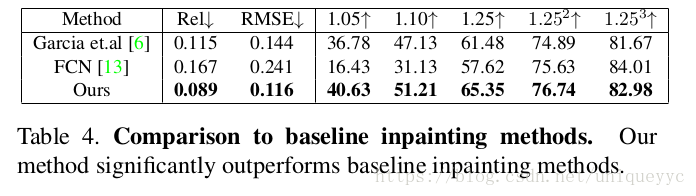

2.3. Comparisons to Depth Inpainting Methods

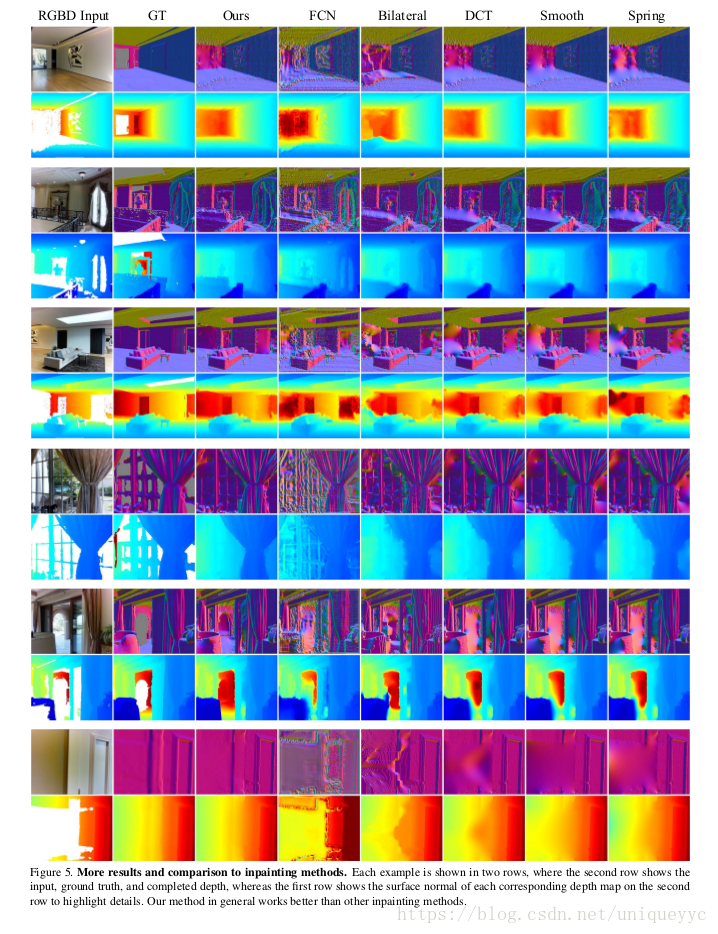

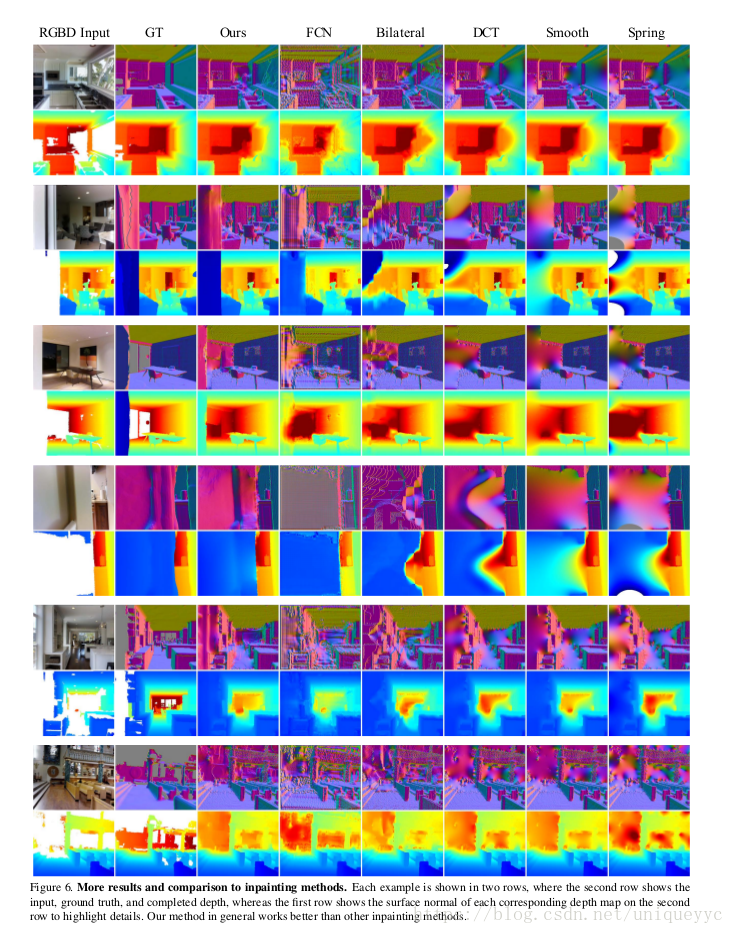

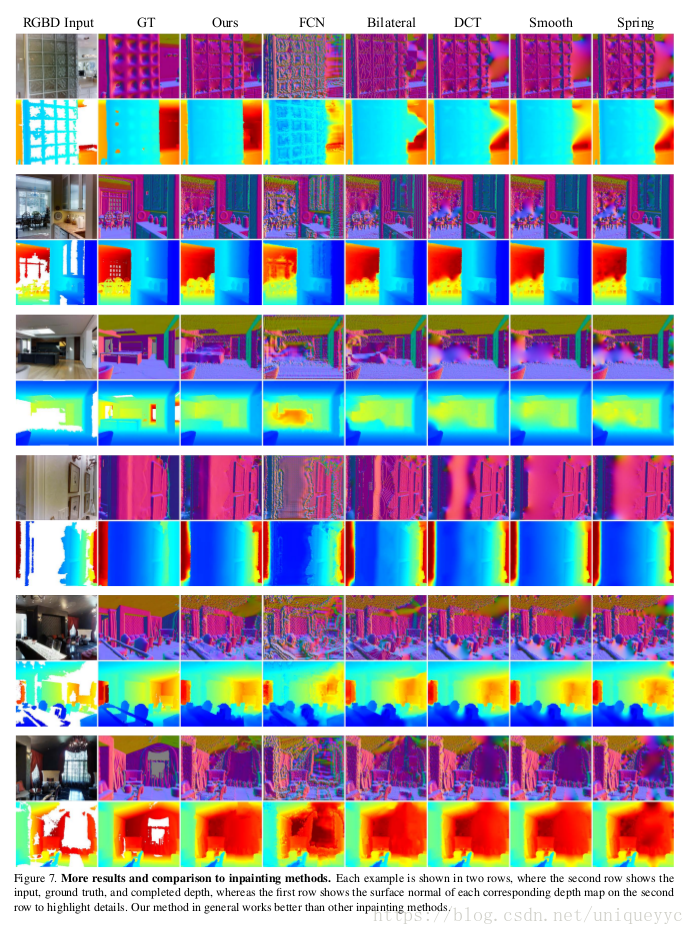

文章4.2节对不同的深度绘画方式进行了比较。本节提供了该类型的进一步结果。

我们比较了以下几种方法:

DCT:使用MATLAB中心的代码,通过使用离散余弦变换求解线性系统的惩罚最小二乘来填充缺失值。

FCN:训练一个具有对称快捷连接的FCN使用zhang等人的成果中的代码,以原始深度作为输入,生成完整的深度作为输出。

CE:训练Pathak等的上下文编码器,使用github的代码来绘制深度图像。

DCT的结果与本文提供的其他绘画比较结果相似。它们只要是插入孔。FCN和CE的结果表面,用于绘画色彩的方法在绘制深度上效果不明显。正如本文中已经描述的,使用FCN从深度学习深度的方向是懒惰的,只能学习复制和插值提供的深度。然而,由于深度数据有许多不同于颜色的特征,问题比这更微妙。首先,上下文编码器比我们的网络具有更浅的生成器和更低的分辨率。这样就产生了比我们更模糊的深度图像。更重要的是,标定过的真实数据可能有缺失值这一事实使鉴别器网络在上下文编码器(CE)中的训练复杂化——在一个朴素实现中,将训练生成器预测缺失值,以欺骗鉴别器。我们尝试了多种方法来克服这个问题,包括仅在未观察到的像素上传播梯度,填充缺失区域的平均深度值。这些方法都不如本文方法有效。

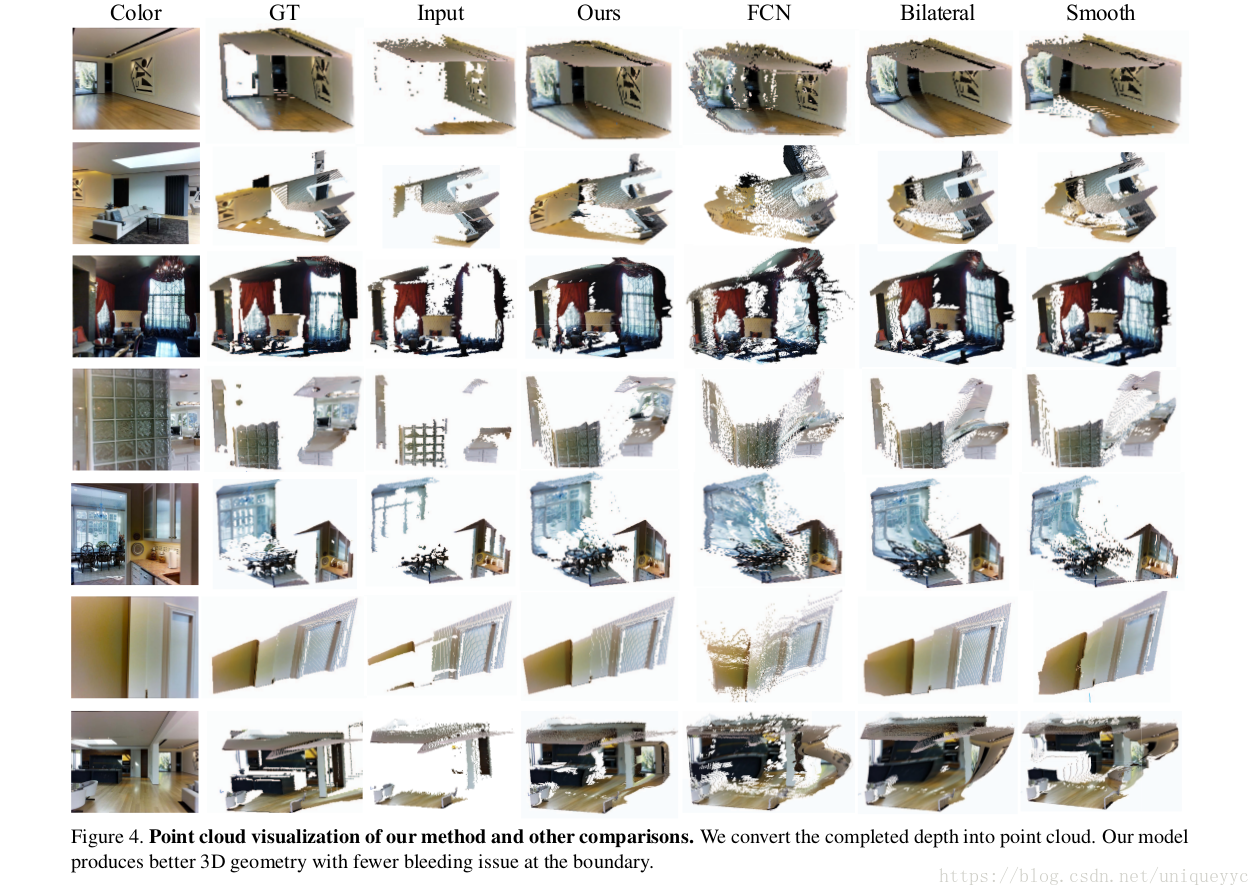

本文最后的图5,6,7给出了我们方法的结果以及其他绘画方法的比较。每两行显示一个示例,其中第二行显示不同方法的完整深度,第一行显示相应的表面法线,以突出细节和3D几何形状。对于每个示例,我们显示输入、标定过的真实数据(ground truth)、结果,后面是FCN的结果。联合双边过滤器,离散余弦变化,只有平滑的优化和PDE。由此可见,我们的方法生成了更好的大尺度平面几何和清晰的物体边界。

我们还将完整的深度图像转换为3D点云进行点云可视化和比较,如图4所示。利用Matterport3D数据集中提供的摄像三元技术,将深度图上的每一个像素投影到一个3D点上,并从彩色图像中复制颜色强度。每行显示一个带有彩色图像的示例。而点云则是由标定过的真实数据、输入深度(即包含大量缺失区域的传感器的原始深度)以及我们的方法FCN、联合双边滤波、绘制平滑的结果转换而成。与其他方法相比,我们的方法保持了更好的三维几何形状和在边界更少的溢出。