解读Depth Map Prediction from a Single Image using a Multi-Scale Deep Network (3)

上一次讨论了几点:

1,单目深度估计的CNN设计结构

2,两层网络的结构和作用,Global Coarse-Scale Network, Local Fine-Scale Network

3,训练的整体过程

今天主要是掌握CNN反向传播的过程,主要是借鉴一篇博客,可以和我一块学习,点击打开链接

激活函数Relu的作用:

1,f(x) = max(0,x)

2,比sigmoid计算小; 减轻梯度消失问题;

全连接网络的缺点:

1,参数数量太多

2,没有利用像素之间的相对信息

3,网络层数限制

相比全连接网路,卷积网络的优势:

1,局部连接

2,权值共享

3,下采样

PS:如果看到这里,你仍然一脸懵比,可以看(1)中的超链接,CNN讲解

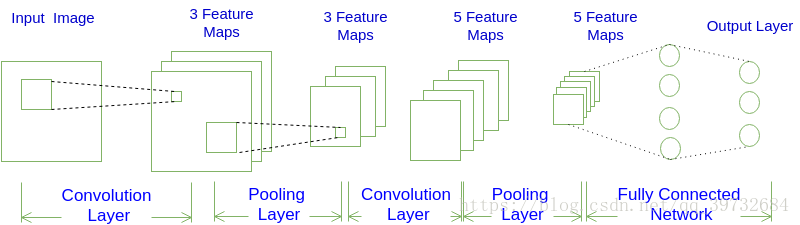

网络结构

它的常见构架模式为:

INPUT -> [ [CONV]*N -> POOL? ]*M -> [FC]*K

即N个卷积层叠加,然后可选叠加一个Pooling层,重复这个结构M次,最后叠加K个全连接层

上图可以写为:

INPUT -> [ [CONV]*1 -> POOL ]*2 -> [FC]*2

对上图更为精细的解释:

1,可以发现第一个卷积得到三个Feature Map,是因为该卷积层包含3个Filter,三套参数,Filter的数目是一个超

参数

2,Pooling层对三个Feature Map做了下采样得到三个更小的Feature Map_1

3,接着是第二个卷积层,它有5个Filter,每个Filter把之前的Feature Map_1卷积在一起,得到一个新的

Feature Map_2,这一共有5个

4,进行第二次Pooling,得到5个小的Feature Map,记为Feature Map_3

5,全连接层,第一个全连接层的每个神经元分别与上一层的5个Feature Map中每个神经元相连

举个例子:假设Feature Map_3是一个3×3的矩阵,那么第一个全连接层一共有

3×3×5 = 45 个神经元

6,第二个全连接层(输出层)与第一个全连接层一一相连,即也有45个

卷积层计算示例这里略去,但是推荐一看!可以学到一些东西:

1,卷积计算方式

2,stride的物理意义

3,计算Feature Map的尺寸大小公式

4,深度为D的卷积计算公式

5,Zero Padding的物理意义

6,简洁的卷积写法

从中的却可以体会到局部连接和权值共享的含义。

简单的计算:

对于两个3×3×3的filter卷积层来说,其参数数量仅有 (3×3×3+1)×2 = 56 个

Pooling层计算(比较简单)

基础打得比较稳了,下次看“卷积神经网络的训练”