版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/u012292754/article/details/82786722

1 离线计算

离线计算:批量获取数据、批量传输数据、周期性批量计算数据、数据展示

代表技术:Sqoop批量导入数据、HDFS批量存储数据、MapReduce批量计算数据、Hive批量计算数据

2 流式计算

流式计算:数据实时产生、数据实时传输、数据实时计算、实时展示

代表技术:Flume实时获取数据、Kafka/metaq实时数据存储、Storm/JStorm实时数据计算、Redis实时结果缓存、持久化存储(mysql)。

一句话总结:将源源不断产生的数据实时收集并实时计算,尽可能快的得到计算结果

3 两者区别

最大的区别:实时收集、实时计算、实时展示

4 Storm

Flume实时采集,低延迟

Kafka消息队列,低延迟

Storm实时计算,低延迟

Redis实时存储,低延迟

Storm用来实时处理数据,特点:低延迟、高可用、分布式、可扩展、数据不丢失。提供简单容易理解的接口,便于开发。数据类型很多,产生数据的终端很多,处理数据能力增强

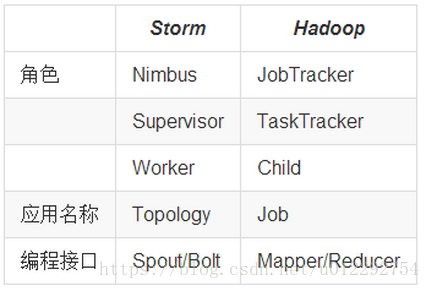

5 Storm 和 Hadoop 区别

- Storm用于实时计算,Hadoop用于离线计算。

- Storm处理的数据保存在内存中,源源不断;Hadoop处理的数据保存在文件系统中,一批一批。

- Storm的数据通过网络传输进来;Hadoop的数据保存在磁盘中。

- Storm与Hadoop的编程模型相似

Job:任务名称

JobTracker:项目经理

TaskTracker:开发组长、产品经理

Child:负责开发的人员

Mapper/Reduce:开发人员中的两种角色,一种是服务器开发、一种是客户端开发

Topology:任务名称

Nimbus:项目经理

Supervisor:开组长、产品经理

Worker:开人员

Spout/Bolt:开人员中的两种角色,一种是服务器开发、一种是客户端开发

6 Storm应用场景

Storm用来实时计算源源不断产生的数据,如同流水线生产。

6.1 场景

- 日志分析

从海量日志中分析出特定的数据,并将分析的结果存入外部存储器用来辅佐决策。 - 管道系统

将一个数据从一个系统传输到另外一个系统,比如将数据库同步到Hadoop - 消息转化器

将接受到的消息按照某种格式进行转化,存储到另外一个系统如消息中间件。

6.2 案例

- 一淘-实时分析系统:实时分析用户的属性,并反馈给搜索引擎

最初,用户属性分析是通过每天在云梯上定时运行的MR job来完成的。为了满足实时性的要求,希望能够实时分析用户的行为日志,将最新的用户属性反馈给搜索引擎,能够为用户展现最贴近其当前需求的结果。 - 携程-网站性能监控:实时分析系统监控携程网的网站性能

利用HTML5提供的performance标准获得可用的指标,并记录日志。Storm集群实时分析日志和入库。使用DRPC聚合成报表,通过历史数据对比等判断规则,触发预警事件。 - 阿里妈妈-用户画像:实时计算用户的兴趣数据

为了更加精准投放广告,阿里妈妈后台计算引擎需要维护每个用户的兴趣点(理想状态是,你对什么感兴趣,就向你投放哪类广告)。用户兴趣主要基于用户的历史行为、用户的实时查询、用户的实时点击、用户的地理信息而得,其中实时查询、实时点击等用户行为都是实时数据。考虑到系统的实时性,阿里妈妈使用Storm维护用户兴趣数据,并在此基础上进行受众定向的广告投放

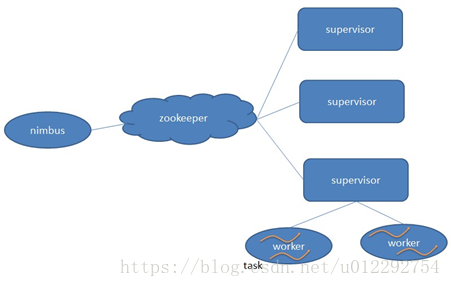

7 Storm 核心组件

- Nimbus:负责资源分配和任务调度

- Supervisor:负责接受nimbus分配的任务,启动和停止属于自己管理的worker进程。—通过配置文件设置当前supervisor上启动多少个worker。

- Worker:运行具体处理组件逻辑的进程。Worker运行的任务类型只有两种,一种是Spout任务,一种是Bolt任务。

- Task:worker中每一个spout/bolt的线程称为一个task. 在storm0.8之后,task不再与物理线程对应,不同spout/bolt的task可能会共享一个物理线程,该线程称为executor。Task=线程=executor。 一个Task属于一个Spout或者Bolt并发任务。

- Zookeeper:保存任务分配的信息、心跳信息、元数据信息。

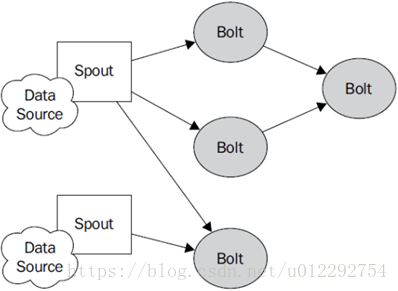

8 Storm编程模型

- Topology:Storm中运行的一个实时应用程序的名称

- Spout:接受外部数据源的组件,将外部数据源转化成Storm内部的数据,以Tuple为基本的传输单元下发给Bolt

- Bolt:接受Spout发送的数据,或上游的bolt的发送的数据。根据业务逻辑进行处理。发送给下一个Bolt或者是存储到某种介质上。介质可以是Redis可以是mysql,或者其他。

- Tuple:Storm内部中数据传输的基本单元,里面封装了一个List对象,用来保存数据。

- StreamGrouping:数据分组策略。7种:shuffleGrouping(Random函数),Non Grouping(Random函数),FieldGrouping(Hash取模)、Local or ShuffleGrouping 本地或随机,优先本地。

- 并发度,用户指定的一个任务,可以被多个线程执行,并发度的数量等于线程的数量。一个任务的多个线程,会被运行在多个Worker(JVM)上,有一种类似于平均算法的负载均衡策略。尽可能减少网络IO,和Hadoop中的MapReduce中的本地计算的道理一样。

8.1 worker与topology

- 一个worker只属于一个topology,每个worker中运行的task只能属于这个topology。 反之,一个topology包含多个worker,其实就是这个topology运行在多个worker上。

- 一个topology要求的worker数量如果不被满足,集群在任务分配时,根据现有的worker先运行topology。如果当前集群中worker数量为0,那么最新提交的topology将只会被标识active,不会运行,只有当集群有了空闲资源之后,才会被运行。

8.2 如何指定驱动类中每个组件的并发度数量

- 根据上游数据量设置 spout 的并发度。

- 根据业务复杂度和 execute 方法执行时间 设置 Bolt 并发度。

- 根据集群的可用资源来配置,一般情况70%的资源使用率。

- worker 数量根据程序并发度总的 Task 数量来均分,实际业务场景中,需要反复调整。

9 流式计算一般架构图

- flume用来获取数据。

- Kafka用来临时保存数据。

- Strom用来计算数据。

- Redis是个内存数据库,用来保存数据。