线性回归

什么是线性回归

如果我们能够建立了回归背后的数学模型,我们便可以根据输入变量来预测输出量。这个数学模型就是回归方程,里面的系数就是回归系数。求解这些回归系数的过程就是回归。

一元线性回归

一元回归的主要任务是从两个相关变量中的一个变量去估计另一个变量,被估计的变量,称因变量,可设为Y;估计出的变量,称自变量,设为X。回归分析就是要找出一个数学模型Y=f(X),使得从X估计Y可以用一个函数式去计算。当Y=f(X)的形式是一个直线方程时,称为一元线性回归。

这个方程一般可表示为Y=A+BX。根据最小平方法或其他方法,可以从样本数据确定常数项A与回归系数B的值。A、B确定后,有一个X的观测值,就可得到一个Y的估计值。

一元线性回归模型

式(1)就是总体的一元线性回归模型。其中  是常数。随机扰动项

是常数。随机扰动项 是无法直接观测的随机变量。为了进行回归分析,通常假定

是无法直接观测的随机变量。为了进行回归分析,通常假定

,即假定

,即假定 是零均值

是零均值  、同方差

、同方差 、相互独立

、相互独立  且服从正态分布的。

且服从正态分布的。

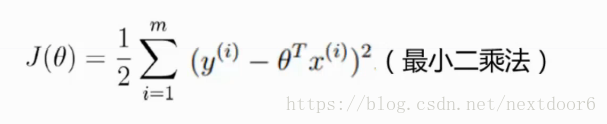

一元线性回归方程参数的估计模型-最小平方和法

人们总是希望寻求一定的规则和方法,使得所估计的样本回归方程是总体回归方程的最理想的代表。最理想的回归直线应该尽可能从整体来看最接近各实际观察点,即散点图中各点到回归直线的垂直距离,即因变量的实际值  与相应的回归估计值

与相应的回归估计值  的离差整体来说为最小。由于离差有正有负,正负会相互抵消,通常采用观测值与对应估计值之间的离差平方总和来衡量全部数据总的离差大小。因此,回归直线应满足的条件是:全部观测值与对应的回归估计值的离差平方的总和为最小,即:

的离差整体来说为最小。由于离差有正有负,正负会相互抵消,通常采用观测值与对应估计值之间的离差平方总和来衡量全部数据总的离差大小。因此,回归直线应满足的条件是:全部观测值与对应的回归估计值的离差平方的总和为最小,即:

等于最小值。

等于最小值。

根据以上公式准则估计回归方程系数a和b的方法称为最小平方法或最小二乘法。显然,在给定了X和Y的样本观察值之后,离差平方总和的大小依赖于a和b的取值,客观上总有一对a和b的数值能够使离差平方总和达到最小。

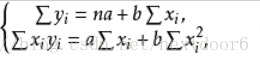

利用微分法求函数极值的原理,即可得到满足上式的两个正规方程:

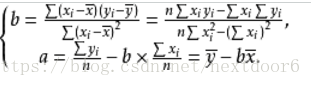

解上述方程可以求得a和b。通常将a和b的计算公式写为如下形式

多元线性模型

在回归分析中,如果有两个或两个以上的自变量,就称为多元回归。通常一种现象常常是与多个因素相联系的,由多个自变量的最优组合共同来预测或估计因变量,比只用一个自变量进行预测或估计更有效,更符合实际。因此多元线性回归比一元线性回归的实用意义更大。

多元线性回归模型

例如二元线性回归模型如下:

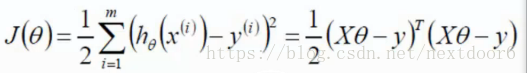

多元回归模型求回归系数-最小二乘法

普通最小二乘法(Ordinary Least Square, OLS)通过最小化误差的平方和寻找最佳函数。通过矩阵运算求解系数矩阵:

算法推导过程

一般,zhen真实值和预测值之间肯定是存在差异的,误差用表示。

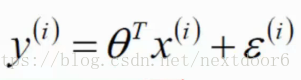

对于每个样本,预测值与误差公式

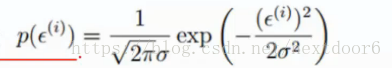

假设误差是独立bing并且具有相同的分布,并且服从均值为0,方差为的高斯分布。

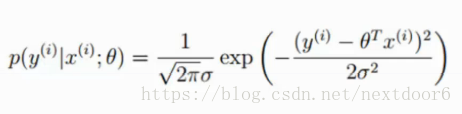

由于误差服从高斯分布,所以:

将预测值与误差公式带入等于:

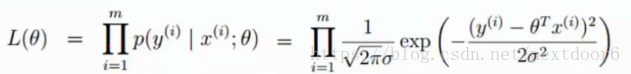

什么样的参数跟我们的数据组合后恰好是真实值,有一下似然函数:

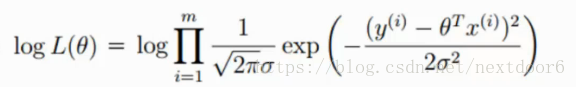

乘法很难求解,转化为加法,对数里面乘法可以转换为加法。

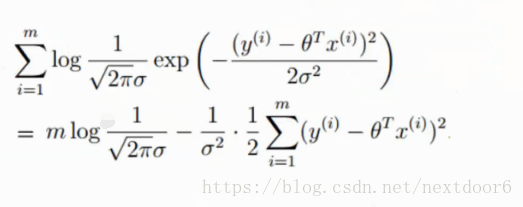

展开化简:

让似然函数越大越好,则得到目标函数

转换为矩阵形式为

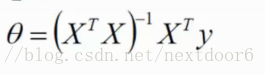

求偏导:

偏导等于0时最小二乘法表达式值最小,故得到回归系数的值。

多元回归模型求回归系统-梯度下降算法

最小二乘法和梯度下降的区别

最小二乘法:只能解决线性回归、正规方程,参数计算时要求xtx可逆,当特征量n小于1w时还可以接受,一次运算就能回归系数,

只适用于线性模型,不适合逻辑回归模型等其他模型。

梯度上升(下降)法是一个单纯的求极值方法,多个极小值时可能求得的不是最小值,适用与各种类型模型(最小二乘法问题线性和非线性都可以),需要多次的迭代,需要选择学习率,当特征量n大时也能较好的适用。

作用

预测

以及数据求预测值。

分析