最近开始学习《利用Python数据分析》和《机器学习实战》,本篇主要对《机器学习实战》中的k-邻近算法的整理和Python程序实现。

k-近邻算法kNN(可用于分类也可用于回归)

1.理论知识点

含义:采用测量不同特征值之间的距离方法进行分类。

优点:精度高、对异常值不敏感、无数据输入假定

缺点:计算复杂度高、空间复杂度高。

适用数据范围:数值型和标称型。

工作原理:存在一个样本数据集合,也称为训练样本集,并且样本集中每个数据都存在标签,即我们知道样

本集中每一数据与所属分类的对应关系。输入没有标签的新数据后,将新数据的每个特征与样本集中数据对

应的特征进行比较,然后算法提取样本集中特征最相似数据(最近邻)的分类标签。一般来说,我们只选择样

本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数。最后,选择k个最

相似数据中出现次数最多的分类,作为新数据的分类。

2.k-近邻算法的一般流程

(1)收集数据:可以使用任何方法

(2)准备数据:距离计算所需要的数值,最好是结构化的数据格式。

(3)分析数据:可以使用任何方法

(4)训练算法:此步骤不适用k-近邻算法

(5)测试算法:计算错误率

(6)使用算法:首先需要输入样本数据和结构化的输出结果,然后运行k-近邻算法判定输入数据分别属于哪个分类,最后应用对计算出的分类执行后续的处理。

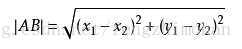

3.k-近邻算法距离计算

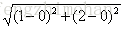

例如,点(0,0)与(1,2)之间的距离计算为:

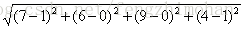

如果数据集存在4个特征值,则点(1,0,0,1)与(7,6,9,4)之间的距离计算为:

4.基于Python实现k邻近算法

使用Anaconda软件的Jupyter NoteBook实现程序开发。

首先,创建一个数据集

import numpy as np

def createDataSet():

group = np.array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])

labels = ['A','A','B','B']

return group,labelsgroup,labels = createDataSet()输入:group

array([[ 1. , 1.1],

[ 1. , 1. ],

[ 0. , 0. ],

[ 0. , 0.1]])输入:labels

['A', 'A', 'B', 'B']之后,编写测试算法

from numpy import *

import operator

def classify0(inX,dataSet,labels,k):

dataSetSize = dataSet.shape[0]

diffMat = tile(inX,(dataSetSize,1)) - dataSet

sqDiffMat = diffMat**2

sqDistances = sqDiffMat.sum(axis=1)

distances = sqDistances**0.5

sortedDistIndicies = distances.argsort()

classCount={}

for i in range(k):

voteIlabel = labels[sortedDistIndicies[i]]

classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1

sortedClassCount = sorted(classCount.items(),key=operator.itemgetter(1),reverse=True)

return sortedClassCount[0][0]最后,使用算法

输入:

classify0([0,0],group,labels,3)运行结果:

'B'总结:通过介绍k-近邻算法的理论知识点、算法流程和代码实现分类器的设计。k-近邻算法是分类数据最简单最有效的算法,是基于实例的学习,使用算法时要对数据集中的每个数据计算距离值,当数据集很大时,计算量将增大,计算比较耗时。