一、二分类评估

混淆矩阵(ConfusionMatrix)

TP:1的预测为1(正确的积极)正确判断

FP:0预测为1(错误的积极)错误判断

FN:1预测为0(正确的消极)漏判断的

TN:0预测为0(错误的消极)成功未判断的

准确率(score):预测对的值占预测总的概率(PR)

精准率(precision)=TP/(TP+FP)-----目标指标预测正确的的概率(预测股票的涨跌)precision_score

召回率:(recall)=TP/(TP+FN)------找到预测目标指标的概率(找病人)recall_score

F1-Score :平衡精准率和召回率=2*precision*recall/(precision+recall)

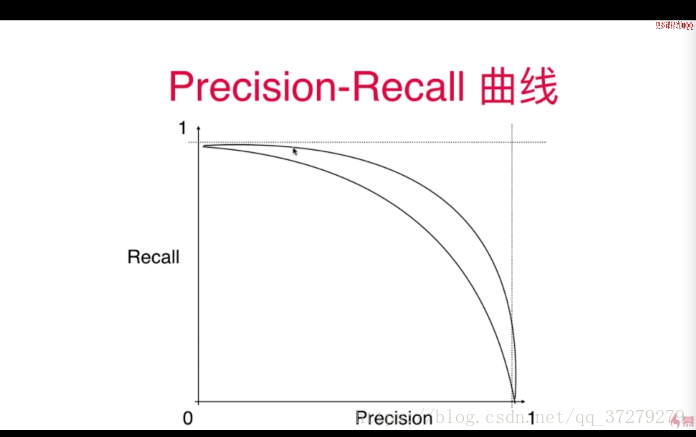

precision_recall相互平衡

决策边界--阈值:threshold

score:分数值

阈值(threshold):进行判断区分的值

循环获取每个threshold对应的精确率(precisions)和召回率(recalls)的值

precision_recall(RP曲线)曲线函数:

precision_recall_curve

获取每个阈值对应的精确率和召回率的值

ROC曲线(TPR和FPR之间的关系)

TPR=TP/(TP+FN)预测对的占目标值的比例(召回率recall:找到目标值的概率)Y

FPR=FP/(TN+FP)预测错了占不是目标值的比例(找非目标值为目标值的概率)X

AUC(ROC曲线的面积:最大为1):面积越大越好

应用场合:比较两个模型的优劣

P/R和ROC是两个不同的评价指标和计算方式,一般情况下,检索用前者,分类、识别等用后者。

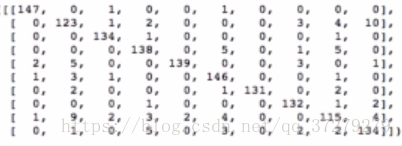

一、多分类评估

实际值(0-9)

预测值(0-9)

十分类混淆矩阵:

每个实际值对应预测值的个数(

对角线

为预测值=实际值:即预测正确)

评估 参数:

每一行的预测错误占该行总预测数的比例(err_matrix)

结论:将1预测为9,将8预测为1的比率大

个人有道云:http://note.youdao.com/noteshare?id=331519cb499e55f116c827516dead87b