版权声明:本文系博主原创,转载请标明出处

之前学习总是搞不懂正则化到底什么玩意儿,就知道它的公式,它能降低过拟合,但是,它到底为什么能降低过拟合呢,看了李航老师的《统计学习方法》有了些许体悟。以什么方式呈现呢,就以问答的方式吧,三省吾身,挺好的。

1 为什么数据量过小会导致过拟合,为什么正则化能够降低过拟合?

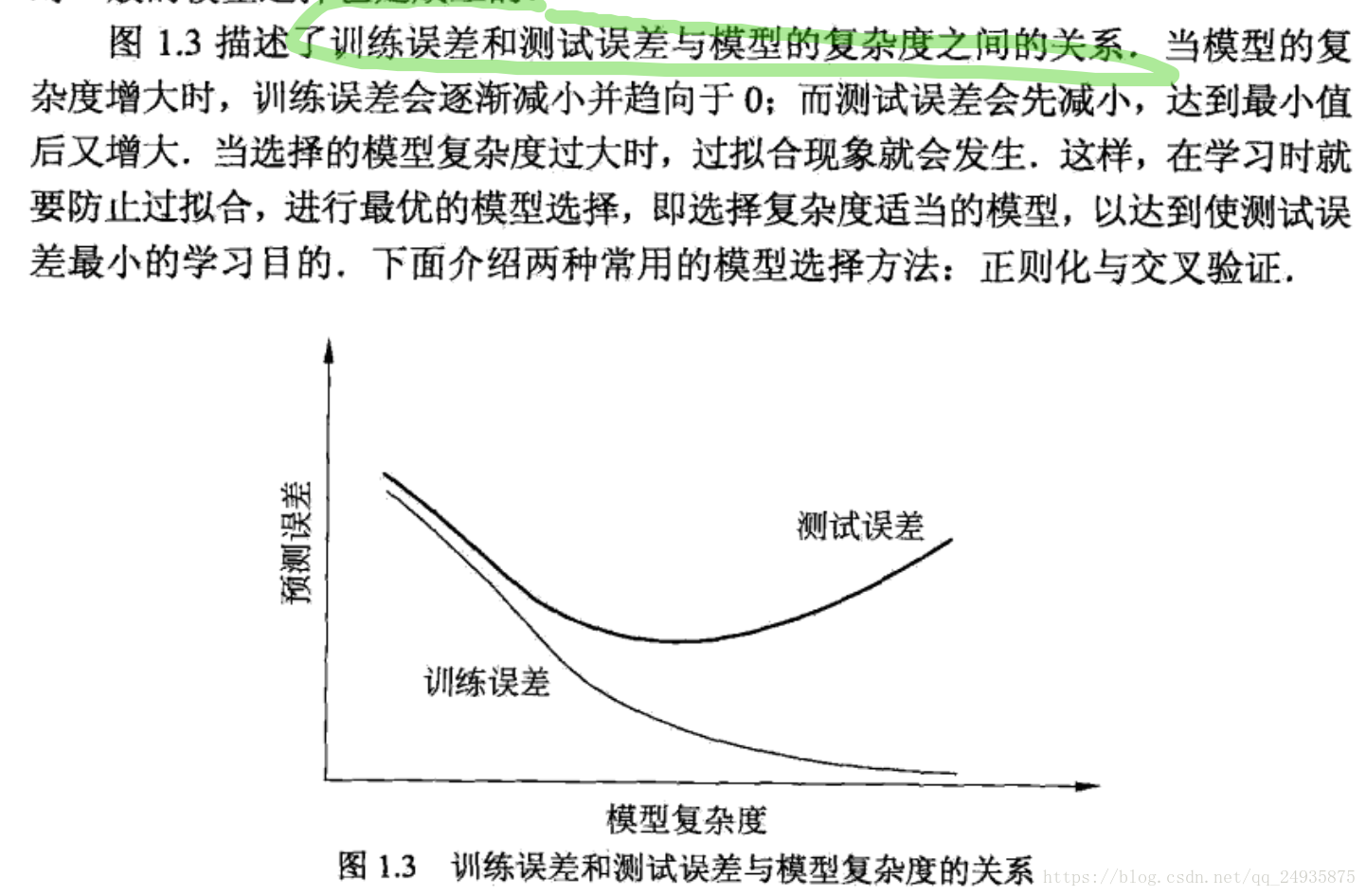

因为本质上来说我们选择模型的标注在于损失函数,我们往往将损失函数和我们真正使用的风险函数混淆了,损失函数描述的是一次预测错误的程度,而风险函数时整个批量的数据平均的错误程度,我们一般用风险函数来作为模型选择的标准,可是在计算风险函数的过程中,我们需要系统的联合分布,可是我们不知道系统的联合分布(正是学习的对象),故而采用的风险函数的近似经验风险函数,也就是深度学习中理解的损失函数,但是,根据大数理论,只有当数据量足够多的情况下,经验风险函数才能无限趋近与风险函数,所以当数据量过小时这个假设就无法成立了,自然无法得到好的模型,所以在有监督的学习中,一般存在经验风险最小和结构风险最小化,经验风险最小化我们之前介绍了,那结构风险最小化是啥?下面就直接截图了,李航第一章里面的。