0、Abstract

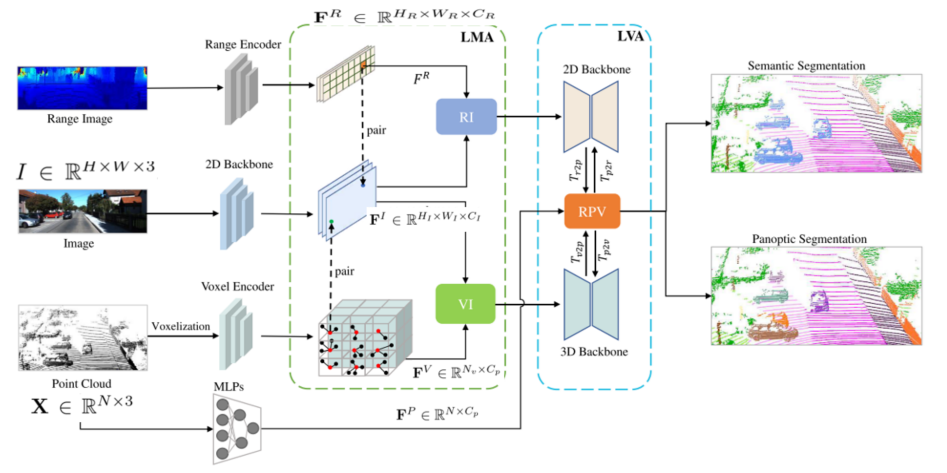

点视图、体素视图和距离视图是点云的三种典型形式。它们都有精确的3D测量,但缺乏颜色和纹理信息。RGB图像是这些点云视图的自然补充,充分利用它们的全面信息有利于更强的感知。本文提出了一种统一的多模态激光雷达图像分割网络,称为UniSeg,该网络利用RGB图像信息和三视点云信息,同时实现了语义分割和全景分割。具体而言,我们首先设计了可学习交叉模态关联Learnable cross-Modal Association(LMA)模块,将体素-视图和距离-视图特征与图像特征自动融合,充分利用了图像丰富的语义信息,对校准误差具有鲁棒性。然后,将增强的体素-视图和距离-视图特征转换到点空间,通过可学习交叉视图关联模块Learnable cross-View Association mod-

ule(LVA)自适应融合三种点云特征。值得注意的是,UniSeg在SemanticKITTI、nuScenes和Waymo Open Dataset (word)三个公共基准测试中都取得了很好的结果;在nuscenes的LiDAR语义分割挑战和semantickitti的全景分割挑战两项基准测试中均排名第一。此外,我们构建了OpenPCSeg代码库,这是目前最大、最全面的户外激光雷达分割代码库。它包含了大多数流行的户外激光雷达分割算法,并提供了可重现的实现。OpenPCSeg代码库将在https://github.com/PJLab-ADG/PCSeg公开提供。

1. Introduction

基于lidar的语义分割,其目标是为每个输入点分配一个语义标签,是自动驾驶、数字城市和服务机器人的重要组成部分[19,23,29,50]。随着深度学习的出现,大量的方法[55,92,44,43,27,75,12,79,8,7,31,30]被提出,并迅速占据了各种基准,如SemanticKITTI[3]和nuScenes[5, 18]。

点云和RGB图像是两种常用的成像方式。如图1 (a)所示,不同的模式各有优缺点。点云提供了可靠、准确的深度信息,可以在不同的视图中进行处理,如点视图、体素视图和距离视图。具体来说,点-视图表示保留了完整的点信息,但由于点位置的非结构化,在获取相邻点特征方面效率较低。体素视图方法将点云栅格化为体素细胞,这些体素细胞保留了规则的结构,但会遭受严重的体素化损失,特别是当体素尺寸较大时。距离视图表示是密集和紧凑的,可以通过高度优化的二维卷积有效地处理。然而,球面投影不可避免地破坏了原始的三维几何信息。对于RGB图像,它包含丰富的颜色和纹理信息,但不能提供精确的空间信息。

显然,来自点云的多模态和多视图的输入数据是相互补充的。因此,充分利用综合信息有助于增强感知的鲁棒性。然而,这种跨模态、跨视图的融合范式在LiDAR分割中并未得到充分的探索[17,38,75,79]。目前的多模态融合方法主要集中在RGB图像和距离图像的融合上[17,38,34]。其他表示,如体素和点视图的激光雷达点云,保持原始的数据结构和提供细粒度的空间信息,在以前的方法中被忽略。此外,它们通常通过标定矩阵对图像和点云进行硬关联融合,容易受到标定误差[35]的影响。

在本文中,为了解决上述问题,我们首次尝试动态融合四种不同形态的数据(点云和RGB图像的体素、距离和点视图),以获得更健壮和准确的感知。更正式地说,我们提出了一个可学习的交叉模态关联(LMA)和一个可学习的交叉视图关联模块(LVA)来有效地融合不同的模态输入。具体来说,我们首先通过LMA将图像特征与范围和体素视点特征融合在一个带有可变形交叉注意[89]操作的软关联模式中,并减轻校准误差。然后,将图像增强后的距离视图和体素视图特征转化为点视图特征,通过LVA模块对点云特征的三个视图进行自适应融合。

在LMA和LVA的辅助下,我们设计了一个统一的网络,称为UniSeg,用于各种语义场景的理解任务,即语义分割和全景分割。大量的实验结果验证了UniSeg在不同任务中的通用性。如图1 (b)所示,UniSeg在两个公开挑战中都排名第一。在SemanticKITTI中实现了75.2 mIoU(语义分割)和67.2 PQ(全景分割);nuScenes的语义分割为83.5 mIoU,全景分割为78.4 PQ。其良好的性能有力地证明了多模式融合框架的有效性。

此外,考虑到许多流行的户外LiDAR分割方法[12,75,27,41]要么没有正式实现,要么性能难以再现,我们构造了OpenPCSeg代码库,旨在提供可再现的统一实现。我们已经对14种有竞争力的激光雷达分割算法进行了基准测试,这些算法的再现性能都超过了报告值。

我们工作的贡献总结如下

•我们提出了一个统一的多模态融合网络用于LiDAR分割,利用RGB图像和三点云的信息,实现更精确和鲁棒的感知。

•我们的方法在SemanticKITTI和nuScenes两项挑战中排名第一,有力地证明了所提出的多模态网络的有效性。

•将发布最大、最全面的户外激光雷达分割代码库OpenPCSeg,以促进相关研究。

2. Related Work

2.1. LiDAR-Based Semantic Scene Understanding

语义分割[75,12,27,92,91,63,79,37,36,9,10,6,46,49,77,34]和panoptic segmentation[26, 41]是基于lidar的语义场景理解的两个基本任务。激光雷达语义分割的目的是为输入点云序列中的每个点分配一个类标签。LiDAR全景分割分别对物类和物类进行语义分割和实例分割。大多数激光雷达分割方法都以点云作为唯一的输入信号。例如,气缸3d[92,91,27]使用圆柱形分区对点云进行划分,并将这些圆柱形特征输入到基于unet的分割主干中。SPVCNN[63]引入点分支来补充原始体素分支,并基于融合的点-体素特征进行逐点分割。lidar多项网络[80]将LiDAR语义分割、全景分割和三维物体检测统一在一个网络中,实现了令人印象深刻的感知性能。之前的方法忽略了RGB图像中包含的丰富信息,导致性能不佳。相反,我们的UniSeg考虑了点云的所有模式和所有视图,并可以从所有输入信号的优点中受益。

2.2. Multi-Modal Sensor Fusion

由于单模态信号有其自身的缺点,近年来多模态融合越来越受到关注[93,17,38]。Zhuang等[93]将点云投影到透视视图中,通过基于残差的融合模块融合多模态特征。El Madawi等人[17]对距离图像和重投影RGB图像进行早期融合和中期融合。Krispel等人通过标定矩阵将图像特征整合到基于距离图像的主干中。上述方法只是进行一对一的多模态融合,不能充分利用RGB图像丰富的语义信息。当标定矩阵不准确时,这些方法的性能较差。相比之下,该方法可以实现更自适应的多模态特征融合,并利用所提出的可学习的交叉模态关联模块缓解点像元偏差。

[93]Perception-aware multi-sensor fusion for 3d lidar semantic segmentation

[17]Rgb and lidar fusion based 3d semantic segmentation for autonomous driving

[38]Fuseseg: Lidar point cloud segmentation fusing multi-modal data

3. The OpenPCSeg Codebase

在户外激光雷达分割领域,许多流行的语义分割算法[12,75,41,27]要么没有正式的实现,要么发布的代码难以再现报告的性能。目前,只有少数开源项目提供了LiDAR分割模型的实现,如著名的mmdetection3d项目[15]。但是,它只包含了一些经典的室内激光雷达分割算法。mmdetection3d和我们的OpenPCSeg的简单比较见表1。为了促进户外激光雷达分割领域的研究,我们构建了最大和最全面的OpenPCSeg代码库,其中包含了这些竞争性激光雷达分割模型的可重复实现。OpenPCSeg建立在著名的OpenPCDet[64]项目之上。考虑到原始论文中丢失了许多实现细节,构造这样一个代码库并非易事。我们花了大约一年的时间,通过大量的实验来确定超参数、数据增强、优化器、学习率调度、数据预处理和后处理策略等的最佳选择,从而构建代码库。到目前为止,我们已经成功复制了SalsaNext[16]、柱体3d[92]、RPVNet[75]、SPVCNN[47]等十多种有竞争力的户外LiDAR分割算法。这些算法的再现性能都超过了其原始出版物的报道值。所选择的数据集包括SemanticKITTI[3]和nuScenes[5,18]。所选任务包括激光雷达语义分割和全景分割。我们为这些算法提供了一套完整的训练和推理协议,以确保重现性。完整的性能比较和关于OpenPCSeg代码库的附加信息在附录中。

4. Methodology

4.1. Framework Overview

UniSeg以点云(voxel-、range-和point-views)和RGB图像为输入,在单个网络中进行语义分割和全景分割。其中,输入点云为,输入图像为

。N为点数,H和W分别为图像的高度和宽度。通过对点云进行球面投影,得到距离图像的表示。

(1)将距离图像馈送到基于距离视图的主干,提取距离图像特征。HR、WR、CR分别为距离图像特征的高度、宽度和通道数。

(2)通过一系列多层感知器(MLPs)提取点特征,其中Cp为点特征的通道数。

(3)体素特征是由对一个体素中的点特征进行最大池化的体素化过程产生的。Nv是非空体素的数量。

(4)输入图像被馈送到基于resnet的体系结构,以提取图像特征。HI、WI、CI分别为图像特征的高度、宽度和通道数。

我们的方法由两个模块组成,即可学习交叉模态关联(LMA)和可学习交叉视图关联(LVA)。LMA模块主要处理体素-图像融合和距离-图像融合,LVA模块主要处理距离-点-体素融合。接下来,我们将详细介绍LMA和LVA。

4.2. Learnable Cross-Modal Association(LMA)

Point-Image Calibration

我们通过相机标定矩阵建立点与RGB图像像素之间的对应关系。具体来说,对于每个点坐标(xi, yi, zi),对应的像素(ui, vi)是通过以下方法找到的:

其中T∈R4×4是由旋转矩阵和平移矩阵组成的摄像机外矩阵,S∈R3×4是摄像机内矩阵。在这里,我们表示这个像素(ui, vi)为校准像素pi,对应的图像特征为校准图像特征。

(这个公式1/z 的z到底是原始点云xyz的z,还是计算后的矩阵uvz的z,感觉不同的论文写法不一样,代码里应该是计算后的矩阵uvz的z,参考PMF,有没有懂得讲一下)

Voxel-Image Fusion

图3:体素-图像融合。对于每个体素特征,我们首先根据体素中心和标定矩阵计算标定后的图像特征

。然后,我们利用学习到的偏移量来采样L图像特征。将体素特征视为Query,将采样后的图像特征表示为Key和Value。将体素和采样的图像特征输入多头交叉注意模块,获得图像增强的体素特征。这些特征与原始特征连接在一起,形成最终的融合特征。

以往的多模态融合方法[17,38]严重依赖不完善的摄像机标定矩阵,这些矩阵容易受到标定误差的影响。受变形detr的启发[90],我们自适应地将体素特征与图像特征融合,以缓解标定误差。如图3所示,体素坐标为体素中心,通过式1计算校准后的图像像素。接下来,我们估计图像像素与校准后的图像像素之间的偏移量,然后将选择的图像特征与相应的体素特征进行融合,如下所示:

式中,为图像特征,

为采样后的图像特征,

为图像增强体素特征。

和

为可学习权值,m为注意头,M为自我注意头的个数,L为采样的图像特征总数。

和

分别表示第m个注意头中第l个采样图像特征的采样偏移量和注意权值。两者都是通过对体素特征FV i进行线性投影得到的。我们将图像增强的体素特征

与原始的体素特征连接起来,得到最终融合的体素特征

,其中

为体素特征的通道数。因此,体素特征会自动找到最相关的图像特征进行融合。注意,那些没有相应图像特征的体素特征将被附加为零向量。

(疑问:这里N应该是吧,另外

的特征向量不需要变化为

吗)

Range-Image Fusion

距离-图像融合与体素-图像融合的过程相同(式2),最终得到图像增强的距离视图特征。

4.3. Learnable Cross-View Association(LVA)

在可学习的交叉模态关联模块之后,我们获得了图像增强的体素和距离视图特征。对于距离、点、体素-视图特征融合,首先对距离、体素-视图特征分别进行距离-点变换和体素-点变换

,将其转化为点-视图。我们提出了一个可学习的交叉视图关联模块来动态整合这三种模式的特征,如图4所示。

图4:可学习的交叉视图关联(LVA)首先将体素和距离图像特征映射到点空间,通过t2p和Tr2p变换对点空间进行插值处理。给定体素、点视图和距离视图特征,LVA提取其全局表示和基于视图的自适应特征。通过残差连接得到交叉视图融合特征,通过Tp2v和Tp2r变换将交叉视图融合特征投影回原始体素和距离图像空间。

具体来说,在和

变换中,由于体素特征和范围图像特征的数量小于点的数量,直接将所有的零向量附加到体素特征和范围图像特征上,会产生次优性能。针对上述数量不匹配问题,我们采用三线性插值和双线性插值分别生成插值体素特征和伪距离图像特征。

经过这些变换,我们得到点体素特征,点距离图像特征

,点特征

。我们将它们连接起来,生成多视图特性

。然后利用可学习参数

对FM进行加权,通过LVA的前两层即

得到紧凑的全局点特征,如下所示:

其中通过这种交叉视图聚合,多视图特征融合成一个总括表示。然后,由全局增强特征

生成视图适配特征,并将残差连接得到的不同视图的原始特征添加到该特征中,如下所示:

其中表示视图i点空间中的原始特征。一方面,

向

提供全局适应特征,以便更好地表示三种不同的视图。另一方面,残差风格将多视角知识的好处与其优势相结合,进一步鼓励了跨视角交互。最后的交叉视图特征

分别通过

和

变换投影回原始体素和距离图。

(疑问:1、可学习的从哪里获得的 2、最后的特征变化回去感觉也没啥用呢)

4.4. Task-Specific Heads

将LMA和LVA模块获得的融合特征反馈给分类器,产生语义分割预测。将语义预测传递到全景图头部,估计对象类的实例中心位置和偏移量,生成全景图分割结果。详细的全景分割实现在补充材料中描述。

4.5. Overall Objective

总体损失函数由四项组成,即交叉熵损失、Lovasz-softmax损失[4]、MSE损失的heatmap回归、L1损失的偏移映射回归,即

其中,α、β和γ为损耗系数,用以平衡各损耗项的影响。

5. Experiments

Datasets

根据流行的LiDAR分割模型[92,26,27]的实践,我们在三个流行的基准上进行了实验,即nuScenes[5,18]、SemanticKITTI[3]和waymo Open[61]。对于nuScenes,它由1000个驾驶场景组成,其中选取850个场景进行训练和验证,剩下的150个场景作为测试分割。在合并相似类和剔除不常见类后,利用16个类进行LiDAR语义分割。SemanticKITTI有22个点云序列。序列00 ~ 10、08和11 ~ 21分别用于训练、验证和测试。合并移动状态明显的类,丢弃分数较低的类,选择19个类进行训练和评估。Waymo开放数据集(word)分别有798、202和150个序列用于训练、验证和测试。每个序列的持续时间为20秒,帧率为10hz。然而,对于三维语义分割任务,并不是所有的帧都提供了三维分割标注。具体来说,只有固定数量帧的最后一帧被标注。用于训练和验证的标注帧数分别为23691和5976。类的总数是23个,包括一个被忽略的和22个有效的语义类别。注意,点云的第一次返回和第二次返回都需要分割。

Evaluation Metrics

按照[27,92]的实践,我们采用各类的交叉并集(Intersection-over-Union, IoU)和各类的mIoU作为评价指标。i类IoU的计算方法是IoUi = TPi TPi+FPi+FNi,其中TPi、FPi、FNi分别表示i类的真正、假正、假负。对于全景分割,我们采用全景质量(PQ)作为主要度量。

Implementation Details

对于点云分支,我们首先基于Minkowski-UNet34[13]构建点体素骨干。然后,我们在点-体素网络中加入距离-图像分支SalsaNext[16],并在四个层次上进行点-体素-范围融合。训练epoch数设为36,初始学习速率设为0.12。我们使用SGD作为优化器。我们使用1 epoch来预热网络,并对其余epoch采用余弦学习速率计划。动量设置为0.9,权重衰减设置为0.0001。SemanticKITTI和WOD的体素大小设置为0.05,nuScenes的体素大小设置为0.1。梯度范数剪辑设置为10,以稳定训练过程。α, β, γ分别设为1,100,10。在点云分支的数据增强方面,我们采用了随机翻转、随机缩放、随机平移以及LaserMix[37]和PolarMix[73]来增加训练样本的多样性。对于RGB图像分支,我们使用imagenet预处理ResNet-34作为特征提取器。图像分支中的参数是可训练的。更多的细节在附录中。

Multi-Modal Fusion Baselines

我们以经典早期融合、PointPainting[68]和pointaug[69]作为多模态融合基线。早期融合进行输入级融合,我们选择两种早期融合变体,即输入信号的添加和拼接。PointPainting将语义分割分数附加在点云上,pointaugmentering将点云与分割分支的图像特征融合在一起。

5.1. Comparative Study

Quantitative Results

我们在表2-6中总结了UniSeg和最先进的LiDAR分割方法的性能。对于LiDAR语义分割,我们的UniSeg比竞争对手2DPASS[79]的分割效果好2.3 mIoU。对于自行车、摩托车和其他车辆类别,UniSeg比2DPASS至少高出8个IoU[79]。在panoptic segmentation方面,UniSeg达到了67.2 PQ,比竞争对手panoptic - phnet[41]多2.6 PQ。在nuScenes基准上,UniSeg在LiDAR语义分割任务上获得83.5 mIoU,比第二名lidar多项网络[80]高出2.1 mIoU。在全景分割方面,我们的UniSeg达到了78.4 PQ,与SPVCNN++等竞争对手的全景分割算法相当。令人鼓舞的结果也观察到在word值集。UniSeg得到69.6 mIoU,比SPVCNN高2.2 mIoU[63]。实验结果有力地证明了所提出的多模态融合网络的有效性。

Comparisons of Efficiency and Accuracy

我们提供了如表7所示的效率和精度的比较,我们的UniSeg 0.2×在参数和延迟可与其他方法相比较的情况下,获得了最好的精度。注意,UniSeg 0.2×是由原始UniSeg模型通过对每一层修剪80%的通道而得到的。此外,随着参数的增加,精度进一步提高(UniSeg)。所有型号都在NVIDIA A100 GPU上进行测试。

Is the Implementation Optimal?

我们希望表明,在尝试和错误之后,实现实现了最好的性能。具体来说,对于LMA模块:考虑激光雷达与摄像机之间的标定矩阵不完美所造成的标定误差。为了缓解这一问题,我们做了几次尝试(表8)。首先,我们直接添加或拼接图像点特征,分别得到+0.4 mIoU和-0.3 mIoU。其次,我们采用PointPainting[68]和pointaugmenten[69]对特征进行融合,改进幅度分别为0.7 mIoU和0.8 mIoU,但这两种融合方法对标定误差比较敏感。第三,我们尝试了自我注意手术。然而,全局注意力计算带来了较高的计算成本。最后,由于该方法的有效性和有效性,我们在方法中采用了可变形交叉注意。如表8所示,LMA模块改进了1.6 mIoU,并在mIoU中比add、concatenate、PointPainting和PointAugmenting分别提高了1.2、1.9、0.9和0.8。

对于LVA模块:我们将探索如何利用不同模式数据的优势。首先,我们采用基线方法,即将所有的模态数据转移到点视图中,然后将它们直接相加或串接,性能分别为70.4 mIoU和70.5 mIoU。其次,我们尝试用自注意的方法进行特征融合,但没有得到改善。最后,我们设计了LVA模块,根据学习到的注意力权重自适应融合不同的模态数据。如表11所示,与直接添加连接相比,改进0.9 mIoU。

5.2. Ablation Study

我们进行消融研究,以验证每种模态/视图和不同的交叉视图融合变体对最终性能的影响。下面的实验是在SemanticKITTI验证集中进行的。

Effect of Each Modality

我们在表9中总结了每种模式及其组合对最终性能的影响。从前三行中,我们可以看到体素分支比其他两种表示表现出更好的性能,显示了体素表示的不可或缺的作用。将点云的三个视图与图像融合,可以得到最佳的分割效果,说明了每个单一模态对分割结果的价值。此外,我们的UniSeg在不同距离下也优于单模态基线(图5)。显然,由于稀疏性更强,基线在较长的距离下会退化。UniSeg的表现始终优于单模态基线,有力地证明了多模态表征的价值。

Fusion Strategies

我们将我们提出的LMA模块与其他融合策略进行了比较,如表8所示,它比其他方法有更大的改进,比基线有1.2 mIoU。值得注意的是,当我们使用UniSeg 0.2×来比较LMA模块和PointPainting时,LMA模块比PointPainting高1.5 mIoU,这直接说明了LMA模块的优点。在LVA模块的帮助下,与其他融合方法相比,point-、voxel-和rangeview特征的融合更加有效,如表11所示。

Robustness to calibration error

我们在校正矩阵中加入高斯噪声来评估其鲁棒性。如表10所示,UniSeg下降0.3 mIoU,而加法运算下降1.6 mIoU,说明LMA模块对校准噪声的容错性更强。

5.3. Qualitative Results

我们通过图6中的误差图对SPVCNN[62]和PolarNet[88]进行了定性比较。在检查结果时,很明显,我们的方法展示了优越的性能,同时保持最小的分割误差在每个采样帧。

6. Conclusion

我们提出了一个统一的多模态激光雷达分割网络,称为UniSeg,首次尝试以RGB图像和点云的三个视图作为输入,并同时进行语义和全景分割。为了充分利用不同模式数据的信息,我们提出了交叉模态关联模块(LMA)和可学习交叉视图关联模块(LVA)。配备LMA和LVA, UniSeg在三个流行的LiDAR分割基准中实现了令人瞩目的性能,并在两个开放挑战中排名第一。

Appendix

在这个文件中,我们补充了额外的材料来支持我们的发现、观察和实验结果。

第7节提供了关于OpenPCSeg代码库的附加信息,并总结了复制和报告的性能。

第8节详细阐述了提出的方法和实验的附加实现细节。

第9节补充了额外的定量结果,包括我们的比较研究和消融研究中基于类别的IoU分数和PQ分数。第10节附加了额外的定性结果。

7. Additional Information of OpenPCSeg

OpenPCSeg代码库支持LiDAR语义分割和LiDAR全景分割任务。它包括基于距离图像、基于体素、基于融合、基于点和基于bev的算法,以及最新的3D数据增强技术。基于距离图像的方法包括SqueezeSeg[71]、SqueezeSegV2[72]、RangeNet++[52]、FIDNet[86]、CENet[11]和SalsaNext[16]。基于体素的算法有MinkowskiNet[13]、气缸3d[92]和DS-Net[26]。基于融合的算法包括RPVNet[75]和SPVCNN[63]。基于点的算法包括PointTransformer[85]。基于bev的算法包括PolarNet[84]和PanopticPolarNet[88]。我们也有三种有用的数据增强算法,LaserMix [37], PolarMix [73], Mix3D[53]。表12总结了受支持的特性与现有代码库的比较。与其他代码库相比,OpenPCSeg支持更多的数据集和更多的特性。表13总结了不同算法的再现和报告性能的详细比较。此外,我们提供的MinkowskiNet[13]和SPVCNN[62]变体如表14所示。更流行的LiDAR分割算法,如Panoptic-PHNet[41]和lidar多项网络[80],将在未来添加到这个代码库。

下面我们将详细介绍基准测试模型、技术和数据集的更多细节。

7.1. Supported LiDAR Segmentation Model

7.2. Supported Data Augmentation Technique

7.3. Supported LiDAR Segmentation Dataset

8. Additional Implementation Details

Network Structure

对于图像分支,输入图像大小是SemanticKITTI[3]数据集上的376×1241。对于nuScenes[5,18]和Waymo Open[61]数据集的多相机图像,图像大小分别为900×1600和640×960。对于range分支,SemanticKITTI, nuScenes和Waymo Open数据集上的输入range图像大小分别是64×2048, 32×1920和64×2688。为了构建稳健的点云分支点-体素范围融合网络,我们首先基于Minkowski-UNet34[13]构建点-体素骨干。然后,我们在点-体素网络中加入距离-图像分支SalsaNext[16],通过Learnable cross-View Association模块(LVA)进行点-体素-范围融合。范围和体素分支是类似于unet的架构,有四个下采样阶段和四个上采样阶段。这九个阶段的尺寸分别为32、32、64、128、256、256、128、96和96,点分支包括4个mlp,通道尺寸分别为32、256、128和96。另外,为了增加模型容量,SemanticKITTI、nuScenes和Waymo Open数据集的信道扩展比分别设置为1.75、1.6、1.6。我们使用imagenet预训练ResNet-34[24]作为图像主干的特征提取器。图像骨干可以从现成的网络中灵活选择。

Data Augmentation and Test-Time Augmentation

我们对点云分支和图像分支采取了不同的数据增强策略。对于图像分支,我们不执行数据扩充。对于点云分支,我们沿着X轴、Y轴和XY轴进行随机翻转(τ翻转),在正态分布[0,0.1]以及LaserMix[37]和PolarMix[73]范围内进行随机平移(τtrans)。采用了全局标度(τ尺度)和全局旋转(τrot)方法。在[0.9,1.1]和[0,2 π]范围内随机选择缩放因子和旋转角度,进行随机缩放和随机旋转。为了进一步提高我们的模型在在线排行榜上的性能,我们在SemanticKITTI和nuScenes数据集上分别使用余弦退火计划[48]对训练集和验证集进行了12或24个时期的调整,并采用了新的测试时间扩充策略(TTA),如[40]。具体来说,给定坐标为(px, py, pz)的LiDAR点云中的输入LiDAR扫描p∈RN×3。我们将上述四种数据的增长变换复合应用于τcomp(p) = τtrans(τflip(τscal(p rot) p))))。将输入扫描扩增为{p, pcomp,i}的集合,其中i是集合中扩增样本的索引。然后,对输入的LiDAR扫描p的多个增广后的预测输出求和,并执行argmax运算,在推理阶段生成最终的预测。注意测试时间内偏航旋转的旋转角度为{0,±π 8,±π 4,±3π 4,±7π 8, π}。

Panoptic Head

我们按照[88]中的实例头设计来预测每个BEV像素的实例中心和偏移量。在训练阶段,我们对每个实例的质量中心进行二维高斯分布编码,并创建一个偏移量映射,其中偏移量测量到相应实例的质量中心的距离。中心图和偏移量图的大小为480×360。语义分割预测被用来创建前台掩码以形成实例组。然后,通过预测xy平面上每个点的中心热图和偏移量,进行二维类无关实例分组。最后,通过多数投票为每个实例组分配一个唯一的标签,以创建最终的全景分割。对于nuScenes全景分割,我们遵循[80],通过预测的输血检测器[2]的边界框来细化实例分割结果。对于全景分割的评估,我们评估的预测实例的最小值为30,和50作为一个有效的实例在nuScenes和SemanticKITTI数据集上,分别。

9. Additional Quantitative Result

我们提供了UniSeg和有竞争力的LiDAR细分网络之间更全面的比较。表15显示了不同LiDAR语义分割方法在SemanticKITTI[3]测试集上的分类IoU得分。在所有的LiDAR分割算法中,UniSeg算法取得了令人瞩目的效果。表16给出了不同LiDAR全景分割方法在SemanticKITTI[3]测试集上的PQ、RQ、SQ、mIoU得分。我们可以观察到UniSeg相对于其他解决方案的明显优势。表17显示了不同LiDAR语义分割方法在nuScenes测试集上的分类IoU得分[18,5]。UniSeg的mIoU得分高于lidar多项网的SoTA解决方案[80],这再次证明了UniSeg的优势。此外,我们还提供了表18中Waymo Open [61] val集的详细性能。结果表明,UniSeg具有较高的疗效。

10. Additional Qualitative Result

图7、图8和图9分别在SemanticKITTI[3]、nuScenes[18、5]和Waymo Open[61]的验证集上提供了更多UniSeg与基线算法(单模态)的视觉比较。为了突出误差图中的差异,正确/不正确的预测分别用灰色/红色表示。对于地面真理来说,不同的颜色代表不同的阶层。从图7、图8和图9中可以看出,单模态基线比我们的UniSeg有更高的预测误差,特别是对于小目标,如行人。例如,在图7中,基线错误地预测了人和围栏,在道路边界上的预测误差更高。相比之下,UniSeg可以更好地预测人和围栏,以及道路边界,这归功于摄像机图像和点云的所有视图提供的全面信息。简而言之,UniSeg可以比基线做出更精确的点预测,无论距离和点密度的变化。

自己总结

看起来是集大成者,包含了四种模式的输入,效果很好,不知道这个实现起来对计算资源消耗如何。