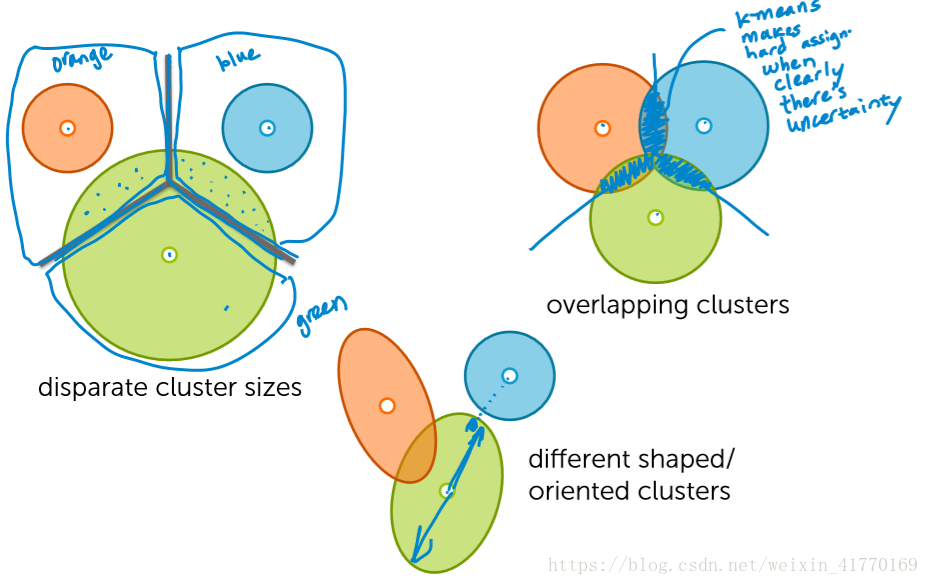

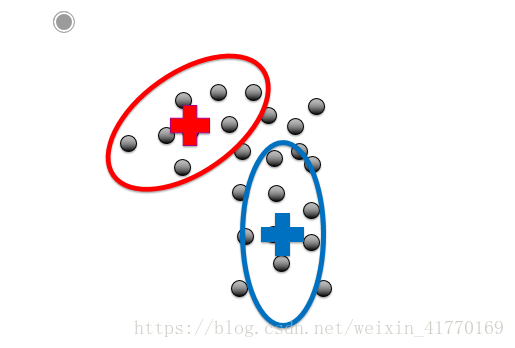

1、k-means缺点

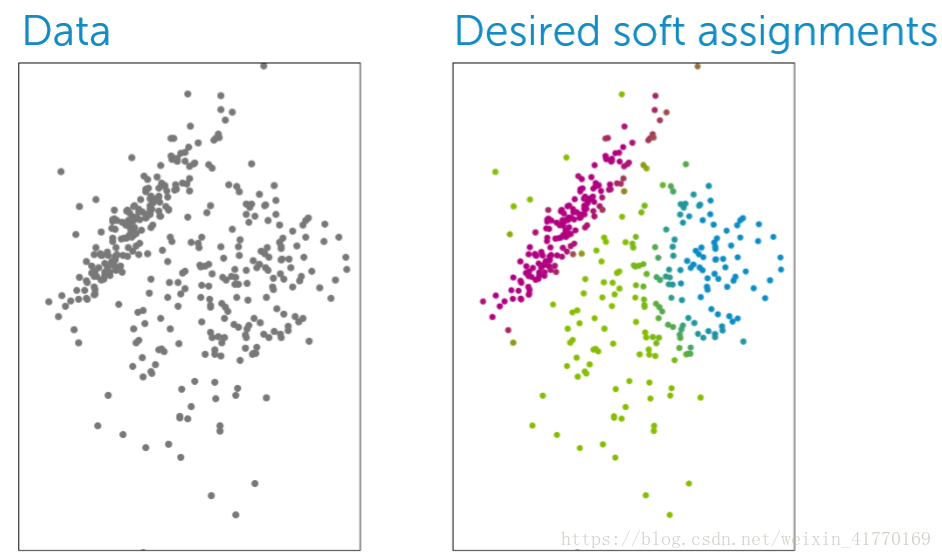

聚类的不确定性:有些模糊地带

因为是求点到中心的距离,所以k-means针对的是圆形的形状

但是对如下这些形状,做不到聚类:

2、提出基于概率的聚类模型

优点:

(1)软分配,给出各个类的概率,而不是像k-means一样硬分配

(2)考虑聚类的形状

(3)考虑数据权重

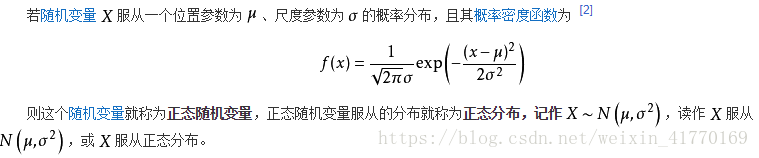

3、高斯分布

正态分布,又叫高斯分布。基本格式为:

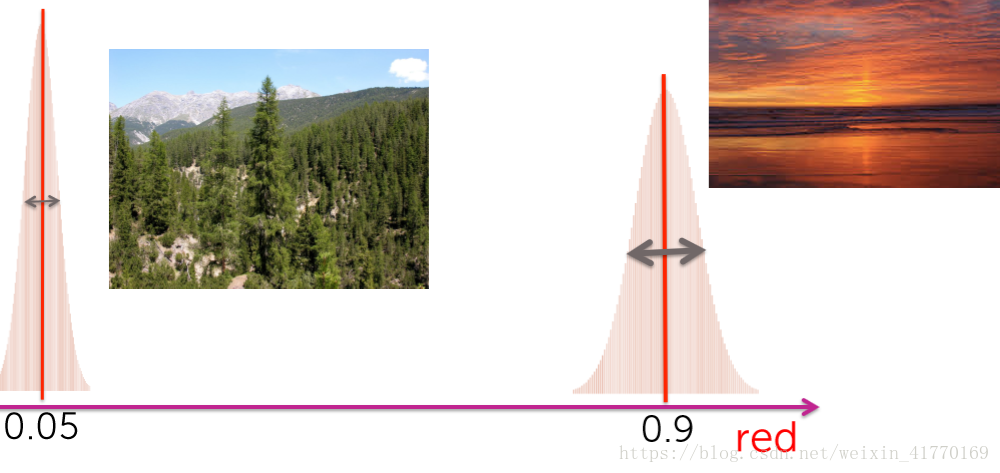

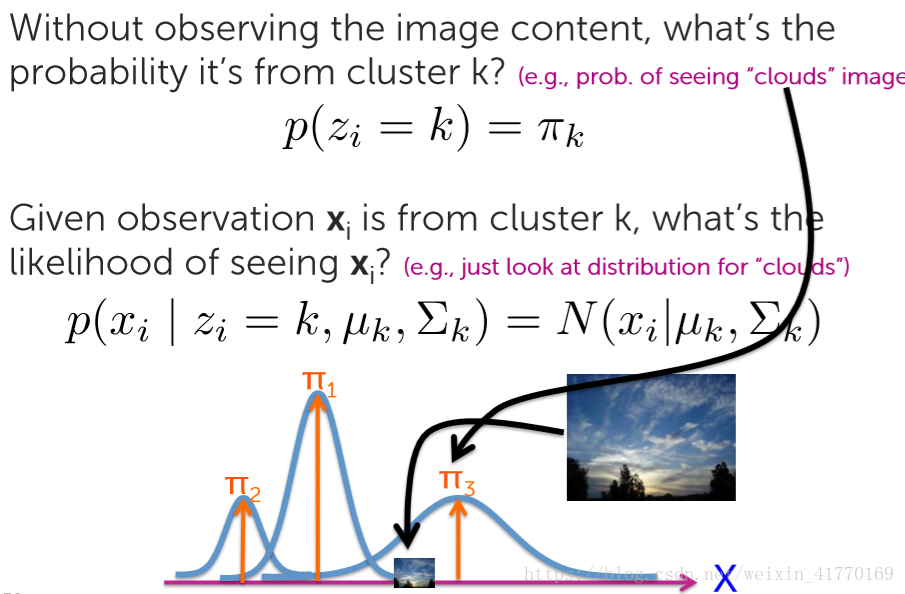

每一幅彩色图像都可以看做RGB3种色彩下的高斯分布的叠加。

(1)1维高斯分布

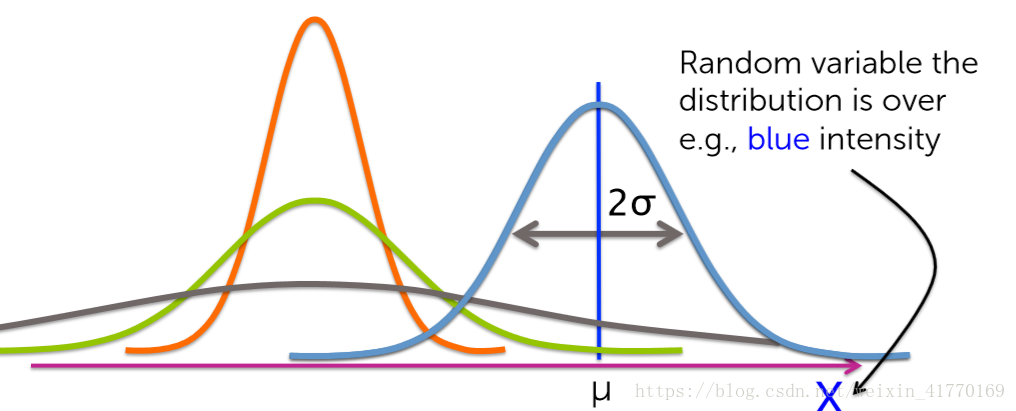

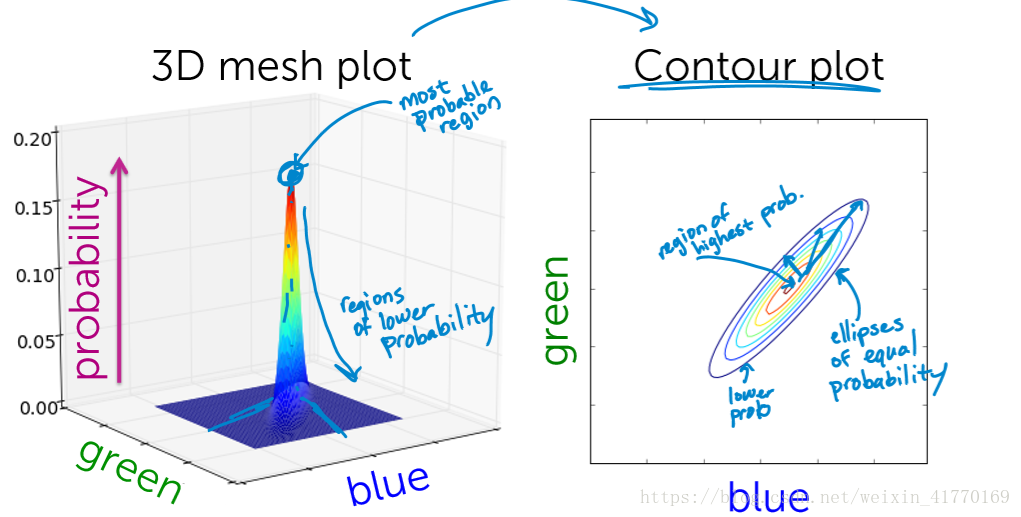

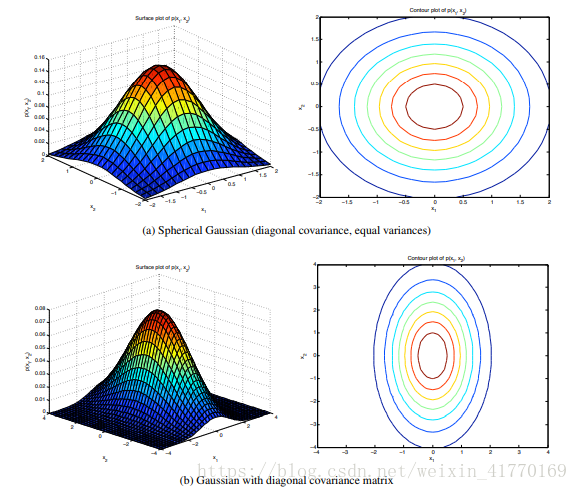

(2)二维高斯分布

看下不同协方差下,高斯模型的形状:

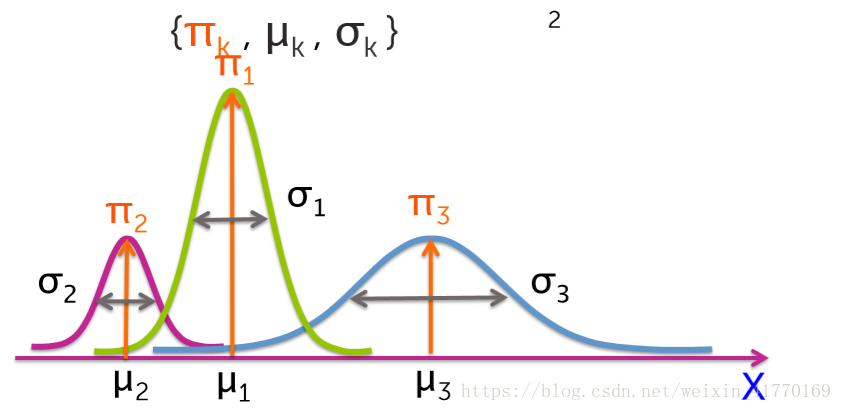

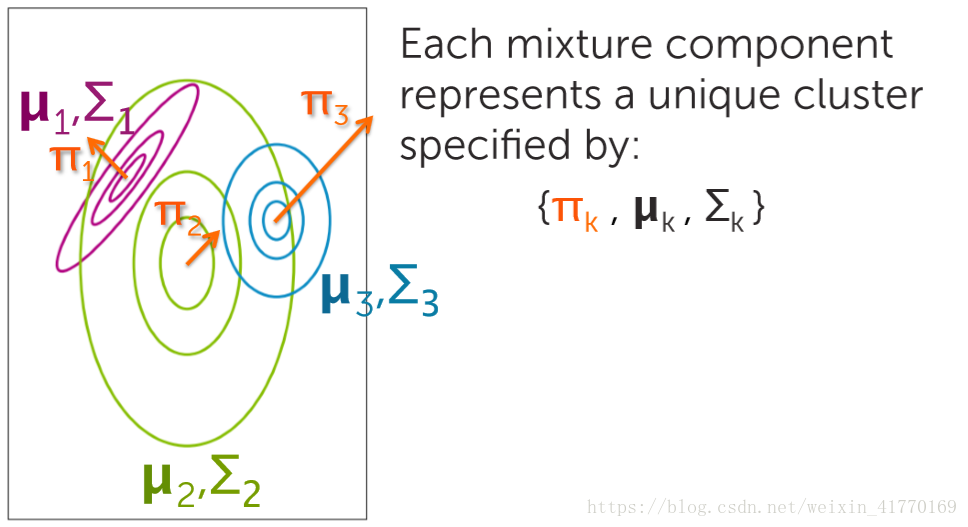

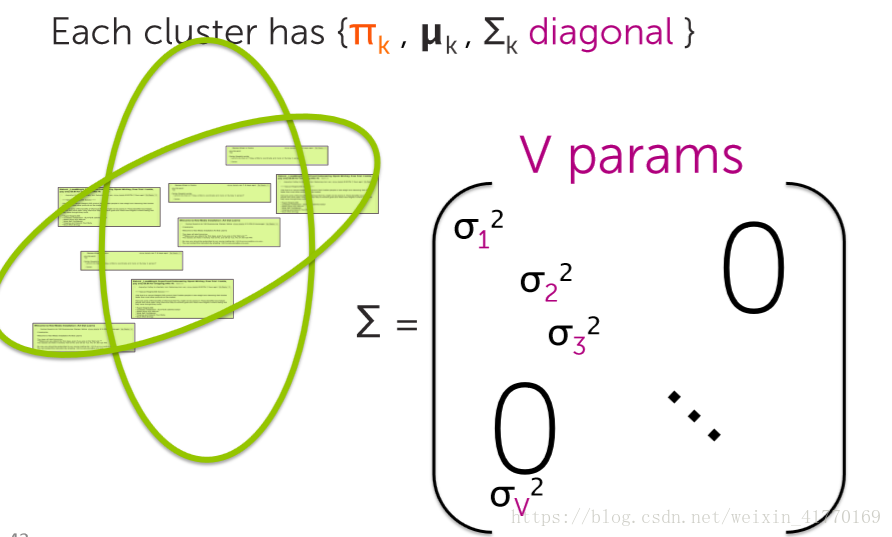

4、高斯混合模型

5、文档聚类

6、用EM期望最大化来解决软分配问题

中间绿色是渐变色,是两类的过渡。

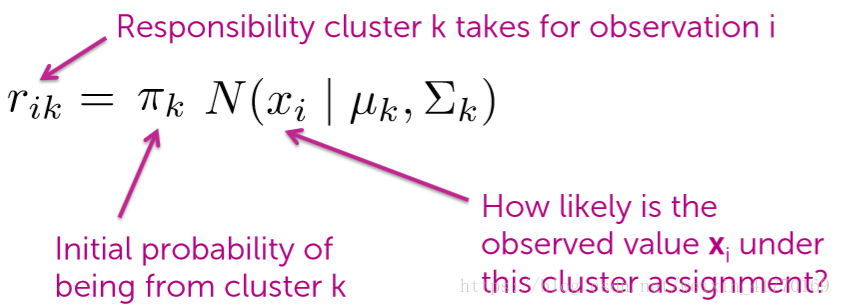

6.1 如果我们知道cluster参数

或者,根据贝叶斯求rik

如果已知参数,概率rik很好求,但是这些参数我们是不知道的。

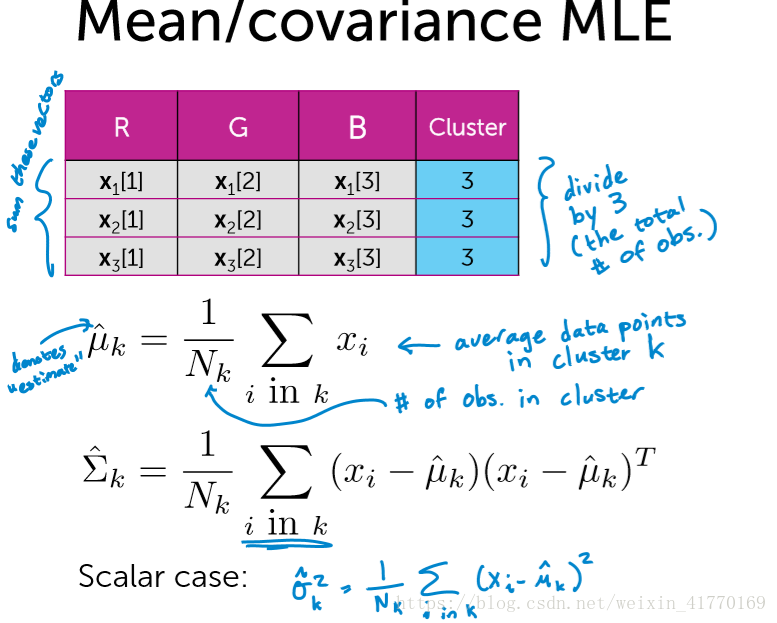

6.2 假如我们已经知道聚类的分布zi,怎么求聚类高斯模型的参数

我们可以用MLE最大概率估计来求聚类的参数。但一开始聚类的分布zi,我们也是不知道的。

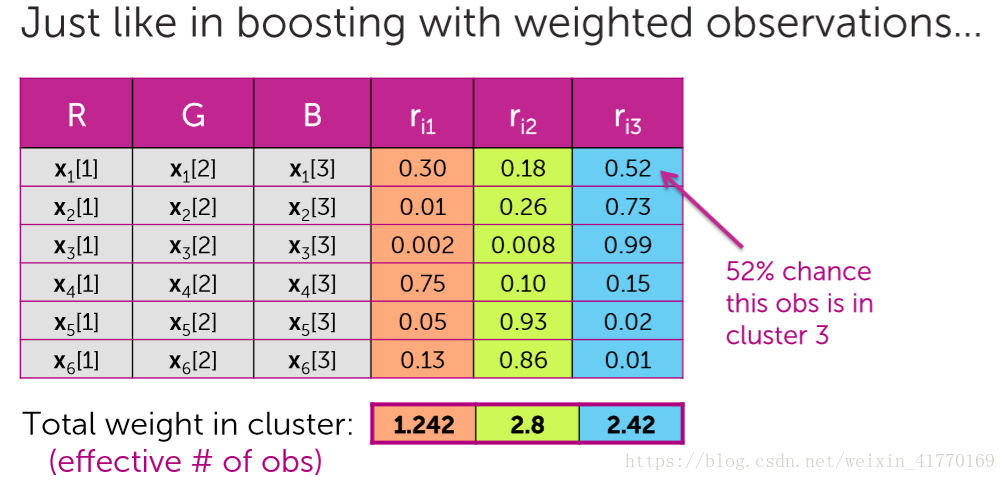

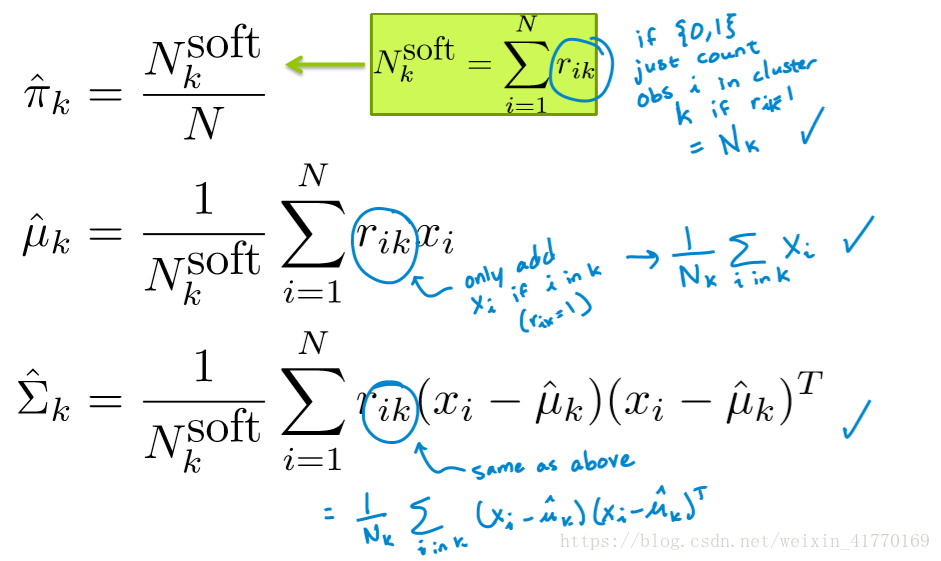

6.3 如果我们只有软分布rij,我们能做什么?

用MLE最大似然估计来求

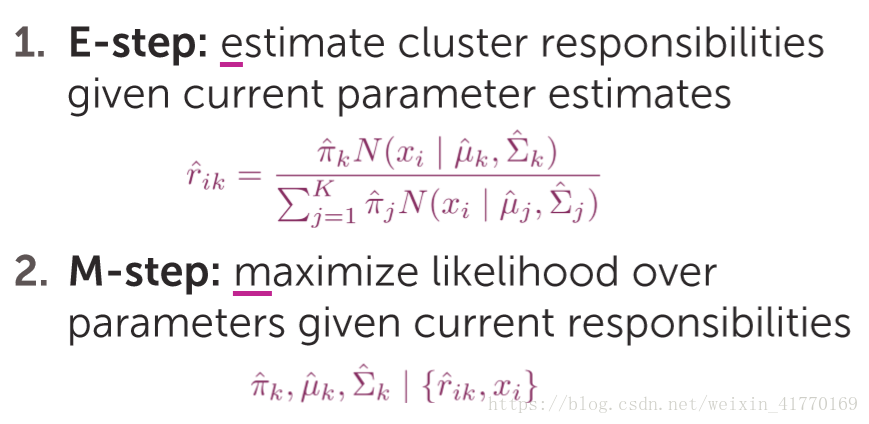

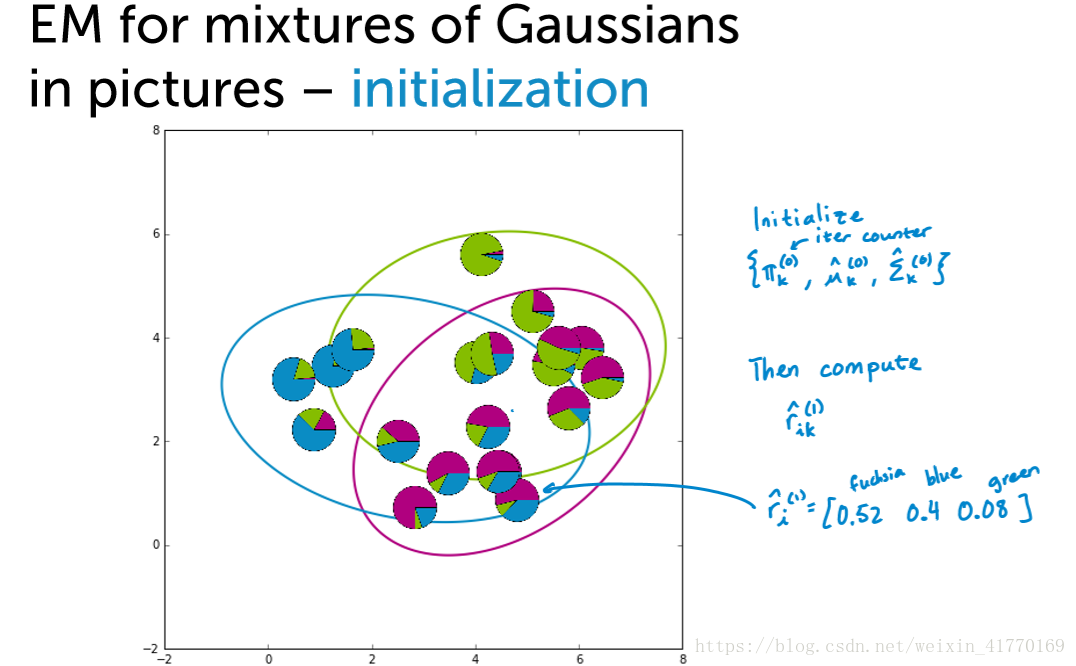

7、EM

一开始先随机高斯分布的参数,然后不断迭代步骤1和2,直到算法收敛。

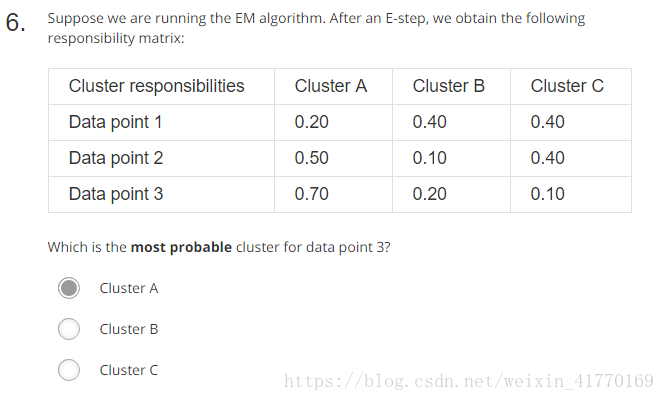

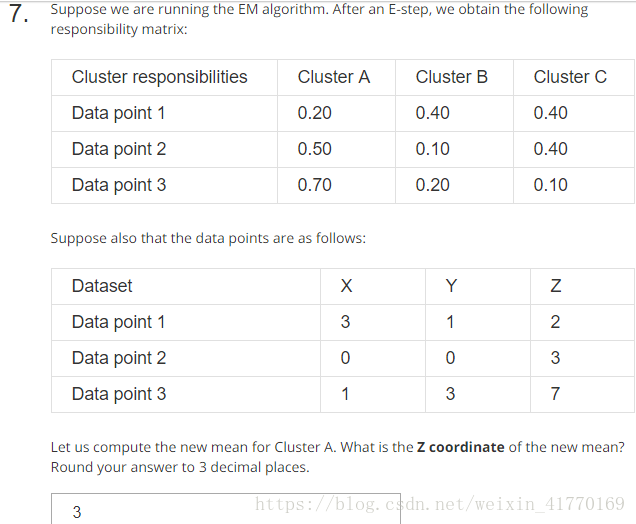

(1)

(2)

(3)

(4)

EM算法是一种坐标下降算法

8、MoG与k-means关系

9、测试

正确答案:最后一个,10个cluster

1、2、3、4、5不对

1、2、3不对

1、2、3、4不对

1、2、3、5不对

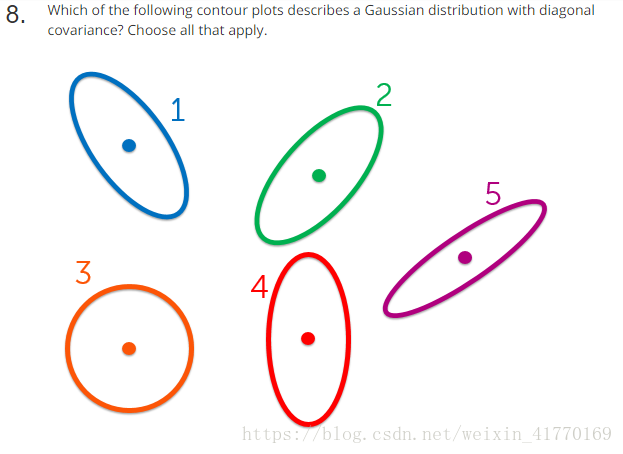

(3)和(4)