PfAAM注意力机制

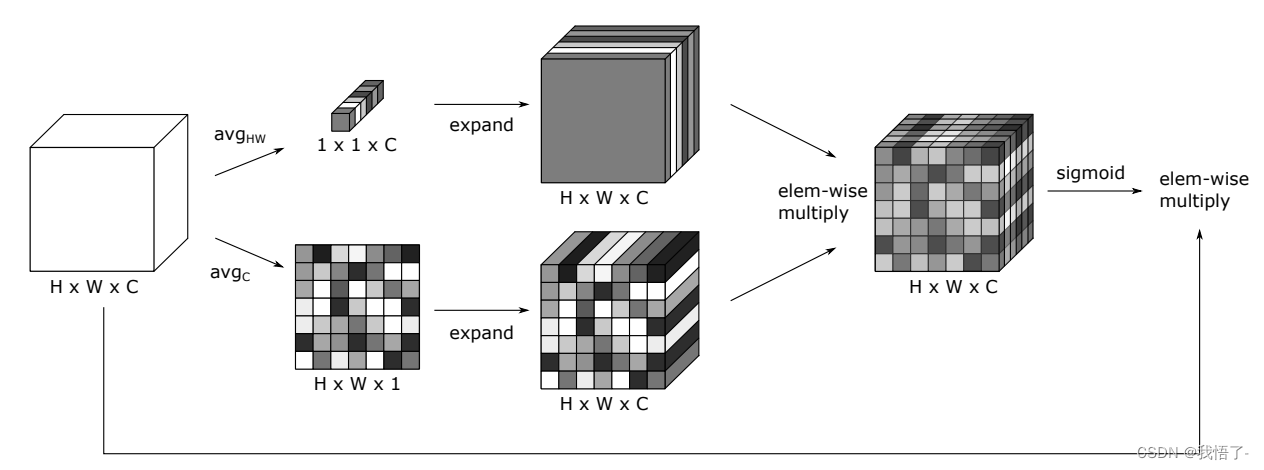

PfAAM注意力机制是2022年提出的一种无参注意力机制,能够实现即插即用,结合通道注意力和空间注意力。

论文地址:https://arxiv.org/abs/2210.07828

代码如下:

import torch

from torch import nn

class PfAAMLayer(nn.Module):

def __init__(self, c1, c2, ratio=16):

super(PfAAMLayer, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

b, c, _, _ = x.size()

y = self.avg_pool(x).view(b, c, 1, 1).expand_as(x)

z = torch.mean(x, dim=1, keepdim=True).expand_as(x)

return x * self.sigmoid(y*z)