本文提出了一种新颖的协作混合分配训练方案,即 Co-DETR,从多种标签分配方式中学习更高效、更有效的基于 DETR 的检测器。在 COCO test-dev 上创下了66.0 AP的新记录,是COCO test-dev 上第一个超过 66.0 AP 的模型。

论文链接:https://arxiv.org/pdf/2211.12860.pdf

源码链接:https://github.com/Sense-X/Co-DETR

目标检测是计算机视觉中一项基础任务,它要求对目标进行定位和分类。RCNN家族和一系列变体(ATSS、RetinaNet、FCOS等)导致目标检测任务的重大突破。一对多标签分配时它们核心方案,其中每个GT框被分配到检测器输出中的多个坐标,作为与建议框、锚框或窗口中心合作的监督目标。尽管这些检测器具有良好的性能,但它们很大程度上依赖于许多人工设计的组件,如NMS或锚框生成。为了实现更灵活的端到端检测器,提出了DETR,将目标检测视作为集合预测问题,并引入了基于Transformer编码器-解码器架构的一对一集合匹配方法。以这种方式,每个GT框将金杯分配给一个特定查询,并不需要对先验知识进行编码的多个人工设计的组件。这系列方法引入了一个灵活地检测框架,并鼓励许多DETR变体进一步改进。然而,普通的端到端检测器性能仍然不如具有一对多标签分配的传统检测器。

这一观察结果促使提出一种简单但有效的方法,即写作混合任务训练架构(Collaborative Hybrid Assignment Training,Co-DETR)。Co-DETR关键简介是使用通用的一对多标签分配提高编码器训练效率和解码器训练效率和有效性。更具体的,将辅助头与Transformer编码器输出集成在一起。这些头可以通过多功能的一对多标签分配进行监督(如ATSS、FCOS和Faster RCNN)。不同标签分配丰富了对编码器输出的监督,这迫使它具有足够的鉴别能力,以支持这些头部训练收敛。为了进一步提高解码器训练效率,精心编码了这些辅助头中正样本坐标,包括锚框和正建议框。它们呗作为多组正查询传入解码器,以预测预先分配的类别和边界框。每个辅助头中正坐标作为一个独立的组,与其他组隔离。通用的一对多标签分配可以引入大量(正查询、GT)对,以提高解码器的训练效率。另外在推理期间仅使用原始解码器,因此所提出的训练方案尽在训练期间引入额外计算开销。

这一观察结果促使提出一种简单但有效的方法,即写作混合任务训练架构(Collaborative Hybrid Assignment Training,Co-DETR)。Co-DETR关键简介是使用通用的一对多标签分配提高编码器训练效率和解码器训练效率和有效性。更具体的,将辅助头与Transformer编码器输出集成在一起。这些头可以通过多功能的一对多标签分配进行监督(如ATSS、FCOS和Faster RCNN)。不同标签分配丰富了对编码器输出的监督,这迫使它具有足够的鉴别能力,以支持这些头部训练收敛。为了进一步提高解码器训练效率,精心编码了这些辅助头中正样本坐标,包括锚框和正建议框。它们呗作为多组正查询传入解码器,以预测预先分配的类别和边界框。每个辅助头中正坐标作为一个独立的组,与其他组隔离。通用的一对多标签分配可以引入大量(正查询、GT)对,以提高解码器的训练效率。另外在推理期间仅使用原始解码器,因此所提出的训练方案尽在训练期间引入额外计算开销。

本文方法

协作混合任务训练 自定义正查询生成

自定义正查询生成 Co-DETR性能提升原因

Co-DETR性能提升原因

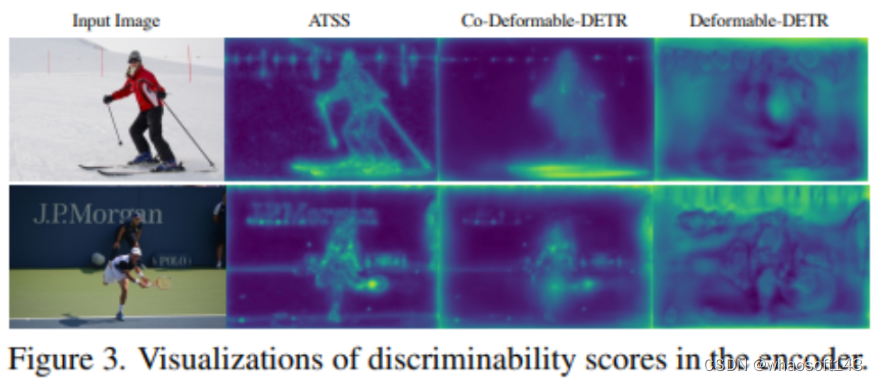

Co-DETR可以获得与DETR相比明显提升。在下文中,我们试图定性和定量地研究其有效性。

丰富编码器监督

与前景重叠面积(IoF)可以描述为:

与前景重叠面积(IoF)可以描述为:

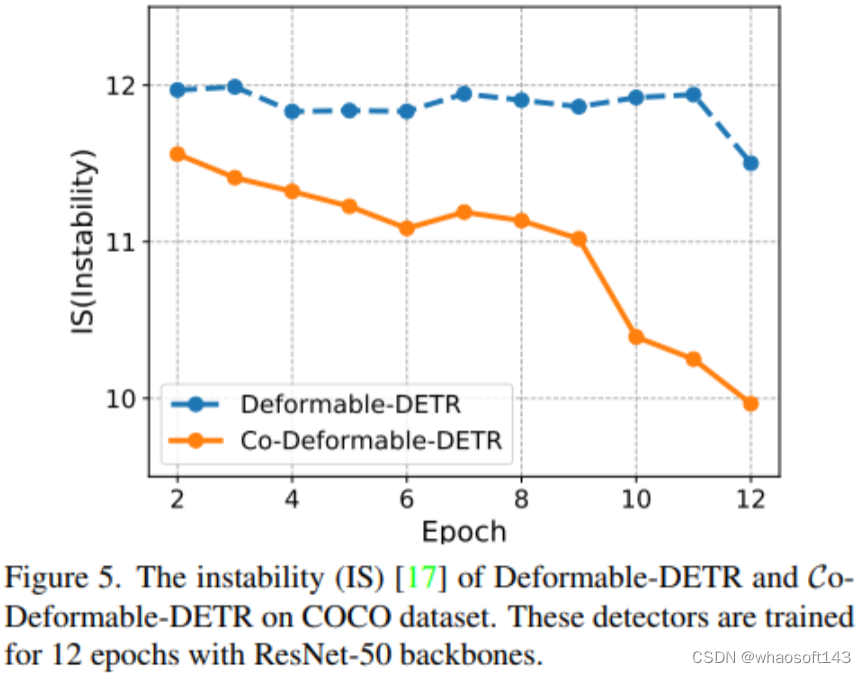

通过减少匈牙利匹配不稳定性提升交叉注意力学习

匈牙利匹配是一对一集合匹配和核心方案。交叉注意力帮助正查询编码丰富目标信息的重要操作。该过程需要足够的训练实现。观察到匈牙利匹配算法引入了不可控的不稳定性,因为训练过程中,分配给同一图像中特定查询的GT正在发生变化。图5中给出了不稳定的比较,发现本文方法有助于实现更稳定匹配过程

实验

表2给出了本文方法与DETR系列方法的实验结果比较。首先将协作混合任务应用于具有C5特征的单尺度DETR。Conditional-DETR和DAB-DETR在长训练周期基础上都获得了2.4%和2.3%AP增益。对于具有多尺度特征的Deformable-DETR,检测性能从37.1%显著提高到42.9%。当训练周期增加到36周期时,总体改进仍然有效。whaosoft aiot http://143ai.com 基于Deformable DETR++,本文进一步将backbone容量从ResNet-50扩展到Swin Transformer。表3所示本文方法实现了56.9%AP,并且与Swin-L相比以很大优势超过了baseline(+1.7%AP)。

基于Deformable DETR++,本文进一步将backbone容量从ResNet-50扩展到Swin Transformer。表3所示本文方法实现了56.9%AP,并且与Swin-L相比以很大优势超过了baseline(+1.7%AP)。  表4给出了将K=2的方法应用于Deformable DETR++与SOTA方法性能比较。与比较的方法相比,本文方法收敛地更快。例如,当仅使用具有ResNet-50 backbone的12周期时,Co-DINO-Deformable-DETR容易地实现51.2%AP。使用Swin-L的DINO-Deformable-DETR性能仍然可以从58.5%提升到59.5%AP。更重要的是,本文的最佳模型Co-DINO-Deformable-DETR++在36周期训练下,使用ResNet-50实现了54.0%的AP,使用Swin-L实现了60.0%的AP,比所有现有的具有相同主干的检测器都有很大的优势

表4给出了将K=2的方法应用于Deformable DETR++与SOTA方法性能比较。与比较的方法相比,本文方法收敛地更快。例如,当仅使用具有ResNet-50 backbone的12周期时,Co-DINO-Deformable-DETR容易地实现51.2%AP。使用Swin-L的DINO-Deformable-DETR性能仍然可以从58.5%提升到59.5%AP。更重要的是,本文的最佳模型Co-DINO-Deformable-DETR++在36周期训练下,使用ResNet-50实现了54.0%的AP,使用Swin-L实现了60.0%的AP,比所有现有的具有相同主干的检测器都有很大的优势