今天读的是发表于CVPR2023的文章,作者全部来自于华中科技大学。

文章链接:Iterative Geometry Encoding Volume for Stereo Matching

项目地址:GitHub

Abstract

Recurrent All-Pairs Field Transforms(RAFT)在匹配任务中显示出巨大的潜力。 然而,all-pairs correlations缺乏非局部几何知识,并且难以解决不适定区域中的局部模糊性。 本文提出了迭代几何编码体(IGEV-Stereo),这是一种用于立体匹配的新深度网络架构。 所提出的 IGEV-Stereo 构建了一个组合的几何编码体,该体对几何和上下文信息以及局部匹配细节进行编码,并对其进行迭代索引以更新视差图。 为了加速收敛,利用 GEV 来回归 ConvGRU 迭代的准确起点。IGEV-Stereo 在 KITTI 2015 和 2012 (Reflective) 上所有已发布的方法中排名第一,并且是前 10 名方法中最快的。 此外,IGEV-Stereo具有很强的跨数据集泛化能力以及较高的推理效率。 我们还将 IGEV 扩展到MVS,即 IGEV-MVS,它在 DTU 基准上实现了有竞争力的精度。

1 Introduction

介绍了stereo和mvs相关的内容。

2 Related Work

介绍了以代价体为基础的方法,比如GCNet、ACVNet、GwcNet;介绍了迭代优化的方法,比如RAFT-Stereo。

3 Method

3.1 Feature Extractor

构造了2个特征提取器,一个是提取多尺度特征用于构建代价体,并指导代价体聚合,一个是上下文网络提取语境特征,用于ConvGRU里hidden state的初始化和更新。

3.2 Combined Geometry Encoding Volume

给定左右特征,创建一个group-wise correlation volume,把特征沿着channel维度分为8组,计算correlation maps。

只是基于feature correlations的代价体 C c o r r C_{corr} Ccorr缺乏捕捉全局几何结构的能力,为了解决这个问题,进一步使用3D正则化网络得到几何编码代价体 C G C_{G} CG。这个正则化网络是基于轻量3D UNet的,包含3个下采样模块和3个上采样模块。进一步,为了增大感受野,把视差pool得到一个两层的 C G C_{G} CG金字塔和all- pairs correlation volume C A C_{A} CA将 C G C_{G} CG和 C A C_{A} CA结合起来得到combined geometry encoding volume。

3.3 ConvGRU-based Update Operator

使用soft argmin来regress C G ( d ) C_{G}(d) CG(d)得到最初的视差 d 0 d_{0} d0,其中d是1/4分辨率时一组预定的视差indices。然后从 d 0 d_{0} d0,我们可以使用三层ConvGRU来迭代视差。

这一个部分和RAFT-Stereo类似。

3.4 Spatial Upsampling

通过 1/4 分辨率下预测视差 d k d_{k} dk 的加权组合输出全分辨率视差图。 与 RAFT-Stereo 以 1/4 分辨率从隐藏状态 h k h_{k} hk 预测权重不同,我们利用更高分辨率的上下文特征来获得权重。 我们对隐藏状态进行卷积以生成特征,然后将它们上采样到 1/2 分辨率。 上采样的特征与左图像中的 f l , 2 f_{l,2} fl,2 连接以产生权重 W ∈ R H × W × 9 W ∈ \mathbb{R}^{H×W×9} W∈RH×W×9。 我们通过粗分辨率邻居的加权组合输出全分辨率视差。

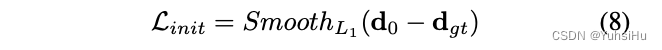

3.4 Loss Function

其中 γ = 0.9 \gamma=0.9 γ=0.9。

4 Experiment

4.1 Implementation Details

使用Adam W优化器,在3090显卡上训练了200k次,batchsize=8,在KITTI 2012和2015上finetune,并使用了crop和数据增强。

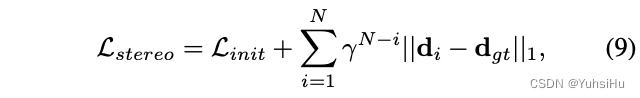

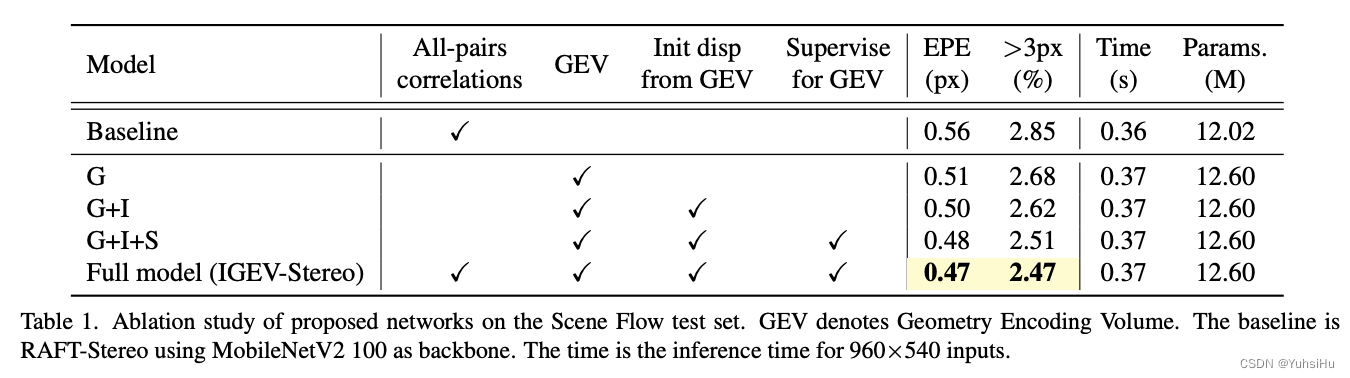

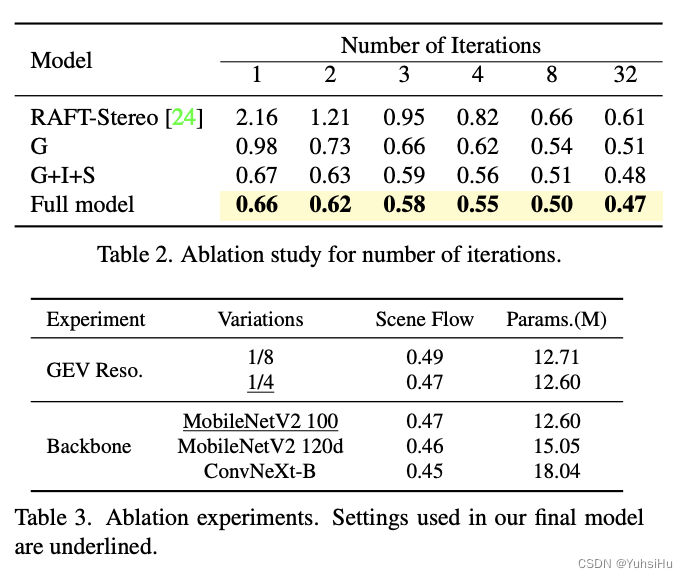

4.2 Ablation Study

做了一些消融实验。

4.3 Comparisons

和SOTA方法做对比并且表现最好。

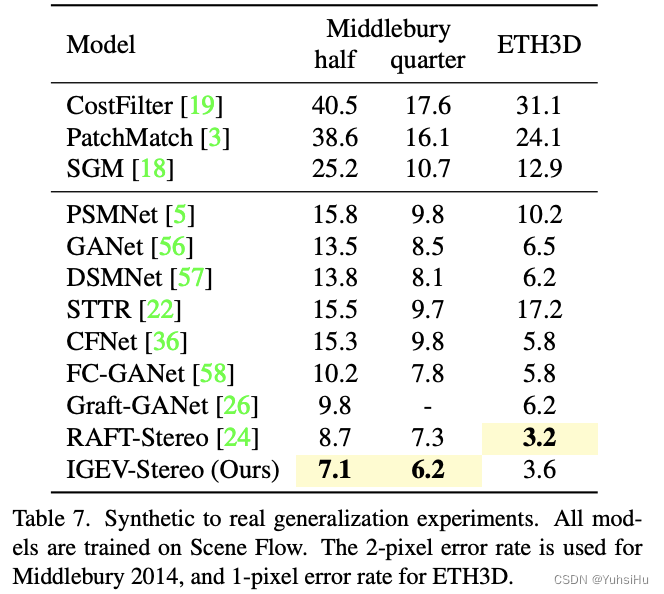

4.4 Zero-shot Generalization

因为大型的真实世界数据集很难获得,所以泛化能力就显得尤为关键了。直接在Middlebury 2014和ETH3D上进行测试,也获得了很好的效果。

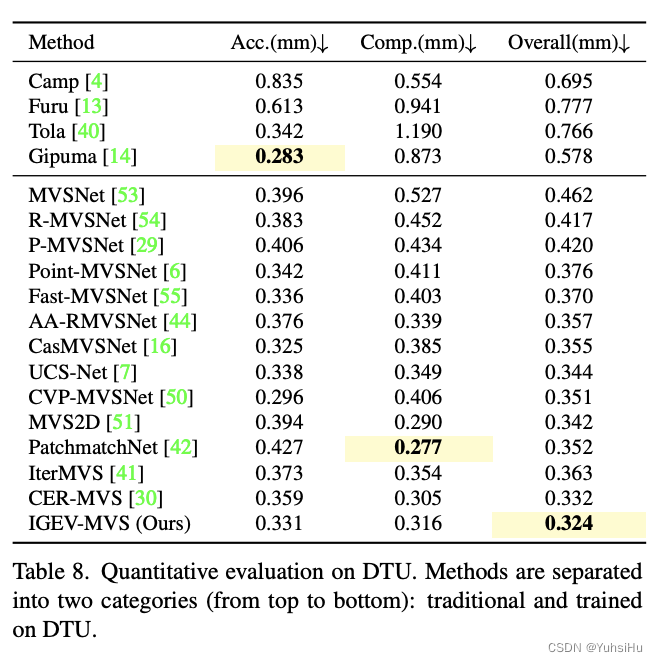

4.5 Extension to MVS

在DTU上重新训练32个epoch,mvs版本相比起stereo版本移除了context network,这意味着ConvGRUs不会接触context stream。在DTU上获得了还行的效果,其实远不是SOTA,文章没有和最新的方法比。

5 Conclusion and Future Work

总结不说了,重点是未来工作。

使用轻量级 3D CNN 来过滤成本量并获得 GEV。 然而,当处理表现出较大视差范围的高分辨率图像时,使用 3D CNN 处理由此产生的大尺寸成本量仍然会导致较高的计算和内存成本。 未来的工作包括设计一个更轻量级的正则化网络。 此外,我们还将探索级联成本量的利用,使我们的方法适用于高分辨率图像。