原文介绍了一种基于深度学习的密集匹配方法MC-NET,是第一篇将深度学习引入密集匹配方面的文章。

原文链接如下MC=NET

**********************************************************手动分割线****************************************************************************

标题:基于卷积神经网络的图像立体匹配

摘要:我们展示了一种从纠正后的立体像对中提取出深度信息的方法。我们的方法关注于大多数立体匹配方法的第一个步骤:匹配代价计算。我们通过使用卷积神经网络学习小图像块上的相似性度量来解决该问题。通过构建具有相似和不相似的像对的示例的二元分类数据集,以监督的方式执行训练。我们测试了两个不同的网络结构:一个为了计算速度做了调整,一个为了计算精度做了调整。卷积神经网络的输出被用来作为立体匹配代价的初值。紧接着是一系列的后处理步骤:基于交叉的成本聚合(这个地方不知道翻译正确没有),半全局匹配,左右一致性检验,亚像素增强,中值滤波器,和双边滤波器。我们在KITTI2012,KITTI2015和Middubury三个数据集上对我们的方法进行了测试,结果显示该方法在三个数据集上的表现都优于其他的算法。

关键词:立体,匹配代价,相似度学习,监督学习,卷积神经网络

1、简介

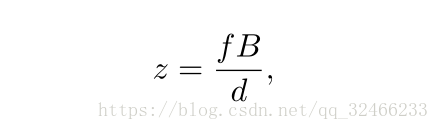

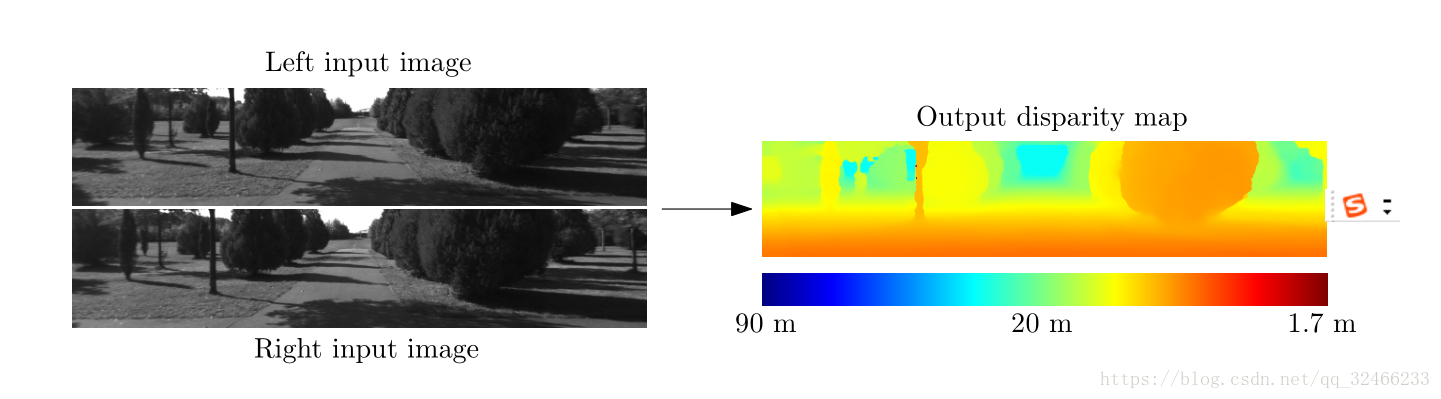

考虑这样的问题:通过获得的两张相机拍摄的在不同的水平方向位置的影像,我们希望能够计算左影像上的每个像素的视差。视差是指一个物体在左右影像上的水平位置的差异(这里的影像已经经过了核线纠正),例如,一个物体在左影像上的位置是(x,y),那么这个物体在右影像上的位置就是(x-d,y)。如果我们知道一个对象的视差,我们就可以计算这个对象的深度z通过如下的简单公式。

主要区别在于物体的水平位置(其他差异是由于

反射,遮挡和透视扭曲)。 请注意,物体更接近

相机比远处的物体有更大的差异。 输出是一个

右侧显示密集的视差图,较暖的颜色代表较大

视差值(和较小的深度值)。

其中,f是相机的焦距,B是相机中心之间基线的长度。所描述的立体匹配问题在诸如以下的许多领域中是重要的

自动驾驶,机器人,中间视图生成和3D场景重建。根据Scharstein和Szeliski(2002)的分类法,一种典型的立体算法

包括四个步骤:匹配成本计算,匹配成本聚合,优化和视差细化。继Hirschmüller和Scharstein(2009)之后,我们将典型的立体匹配算法的前两步统一为计算匹配代价,而后两个步骤称之为立体匹配方法。本文工作的重点就是计算出优良的匹配代价。

我们训练一个卷积神经网络在一系列的立体像对当中 (LeCun et al., 1998),这些立体像对的真实视差是已知的。(例如,通过LIDAR来获得真实的视差)。这个卷积神经网络的输出被用来初始化匹配成本。接下来,我们进行的一些列后处理步骤并不是新颖的方法,但是是为了得到好的结果的必要步骤。匹配成本在具有相似的相邻像素之间组合使用基于交叉的成本聚合的图像强度。平滑约束由半全局匹配强制执行,左右一致性检查用于检测和消除遮挡区域中的错误。我们执行子像素增强并应用中值滤波器和双边滤波器以获得最终视差图。

这篇论文的贡献主要是:

1、基于卷积神经网络的两种架构的描述,用于计算立体匹配成本;

2、一种方法,附有源代码,KITTI 2012,KITTI 2015和Middlebury立体声数据集的错误率最低;

3、实验分析数据集大小的重要性,与其他方法相比的错误率,以及超参数的不同设置的准确性和运行时间之间的权衡。

本文通过包括对新架构的描述,两个新数据集的结果,较低的错误率和更彻底的实验,扩展了我们之前的工作(Zbontar和LeCun,2015)。

2、相关的工作

在引入像KITTI和Middlebury这样的大型立体数据集之前,相对较少的立体算法使用地面实况信息来学习其模型的参数;在本节中,我们将回顾那些做过的事情。 有关立体算法的一般概述,请参阅Scharstein和Szeliski(2002)。

**************************************************未完待续************************************************************************************