01

论文

本文介绍 达摩院开放视觉团队 被机器学习顶级国际会议ICLR 2023接收的论文 “DamoFD: Digging into Backbone Design on Face Detection"

论文链接

https://openreview.net/pdf?id=NkJOhtNKX91

开源代码https://github.com/ly19965/EasyFace/tree/master/face_project/face_detection/DamoFD

02

背景

人脸检测

人脸检测算法是在一幅图片或者视频序列中检测出来人脸的位置,给出人脸的具体坐标,一般是矩形坐标,它是人脸关键点、属性、编辑、风格化、识别等模块的基础。

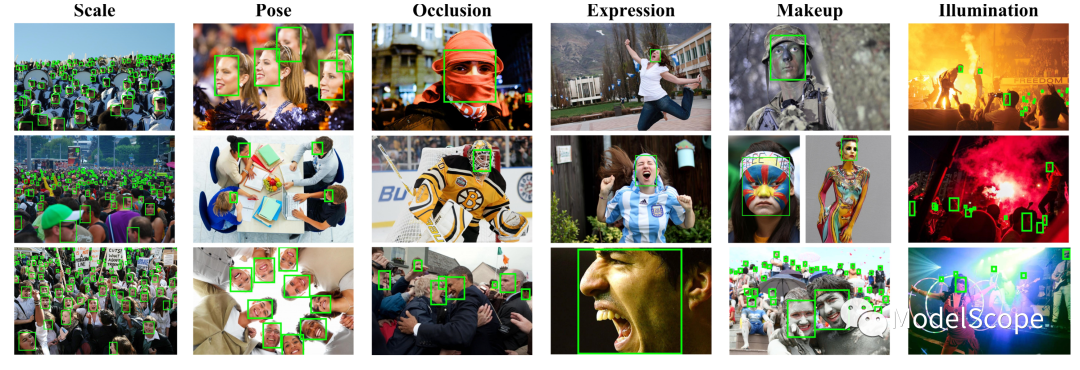

学术界用来衡量人脸检测器性能的benchmark是[WiderFace](http://shuoyang1213.me/WIDERFACE/WiderFace_Results.html),该数据集主要明确了人脸检测器面对的一些挑战,包括scale,pose,occlusion等。

本文的研究问题是如何自动搜索轻量级人脸检测器的backbone?

图片来自Wider Face 官网

轻量器人脸检测器发展历史

-

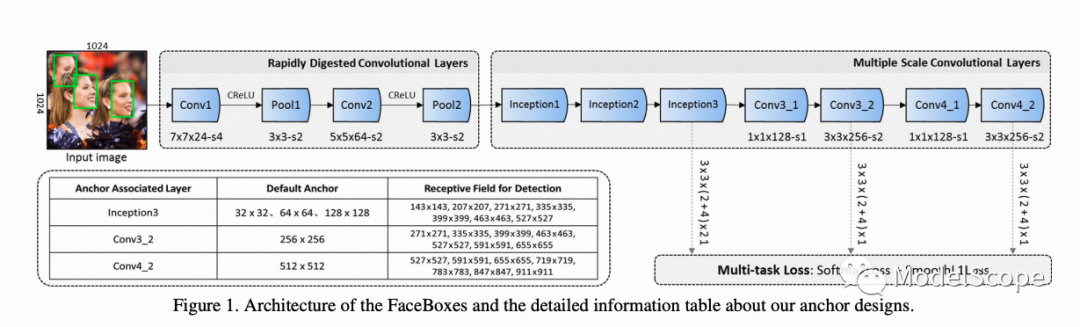

Manual 轻量级人脸检测器设计: 早期的轻量级人脸检测器(FaceBoxes & BlazeFace)均采用Single-stage目标检测器的结构(SSD),并替换为自己手工设计的backbone模块(e.g., Faceboxes引入了Crelu,BlazeFace 引入了DW Conv )。这些方法的共同弊端是无法随着算力约束的变化而自动调整人脸检测器结构,限制了其应用场景。

图片来自FaceBoxes 论文

-

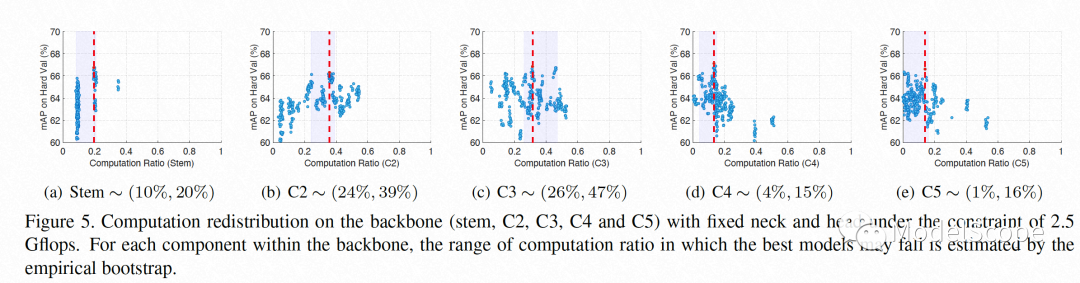

Nas-Based 轻量级人脸检测器: 随着Neural Architecture Search(NAS)技术的兴起,研究人员开始利用Nas来自动化设计人脸检测器的结构, e.g., SPNas in BFBox, DARTS in ASFD,RegNet in SCRFD。SCRFD借鉴了RegNet的思想确定了检测器的搜索空间,并打造了sota性能的轻量级人脸检测器。下图为SCRFD得到的在backbone上的最优算力分配区间

图片来自SCRFD论文

03

方法

Motivation

目前的Nas方法主要由两个模块组成,网络生成器和精度预测器。其中网络生成器用于生成候选的backbone结构,精度预测器用来对采样的backbone结构预测精度。

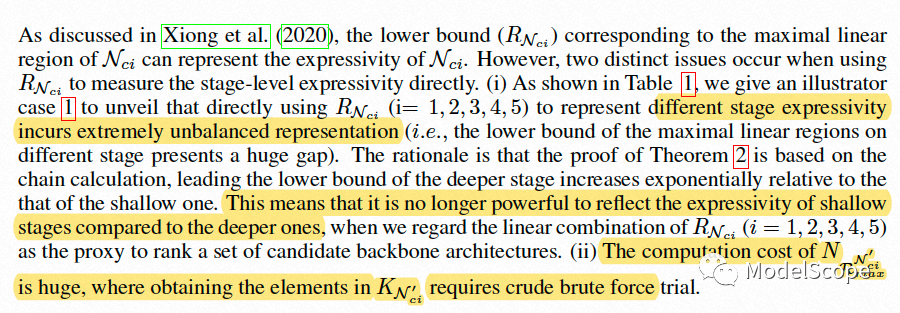

由于检测和分类的任务目标不一致,前者更重视backbone stage-level (c2-c5)的表征,而后者更重视high-level(c5)的表征,这就导致了用于分类任务上的精度预测器擅长预测high-level的表征能力而无法预测stage-level的表征能力。

因此,在人脸检测任务上,我们需要一个可以预测stage-level表征能力的精度预测器来更好的搜索face detection-friendly backbone。

Preliminaries

首先我们介绍下与我们方法相关的背景知识:

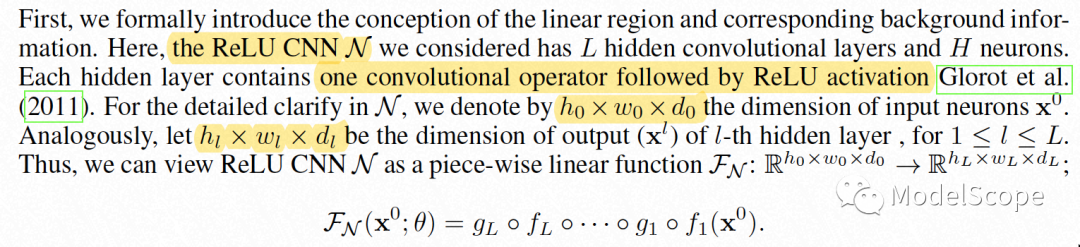

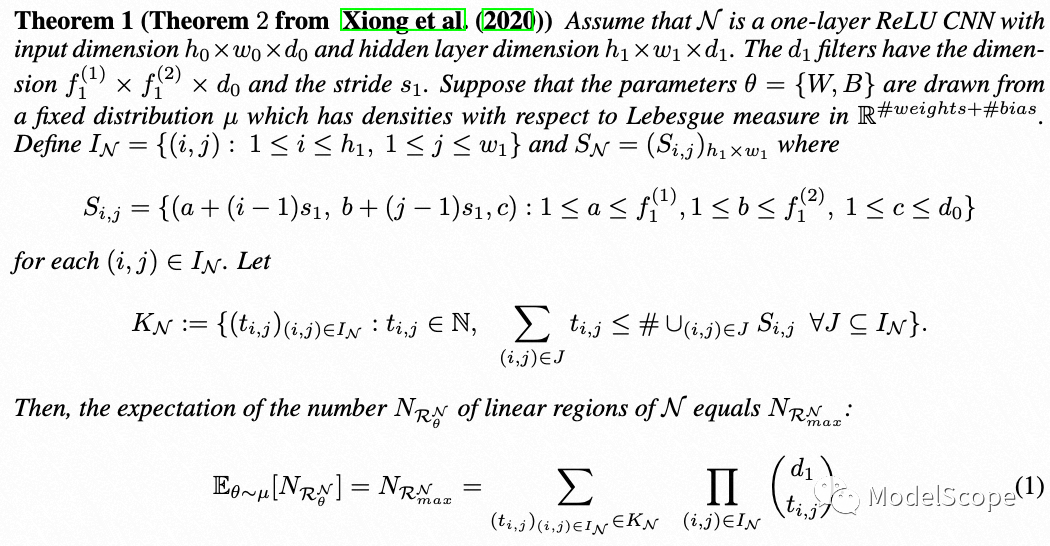

Relu CNN

Linear Region of

-

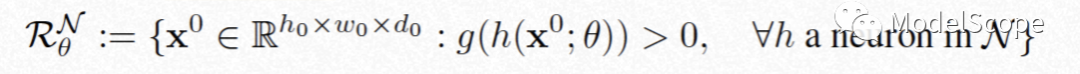

Region: 当用超平面对空间进行划分时,所划分出来的的connected component叫做region

Linear Region: 指的是piecewise lienear function 的linear region,代表该函数/超平面 (wx+b=0)将空间划分时得到的最大连通子集。

Linear Region of a Relu CNN at

:给定网络参数,所有超平面将输入空间所划分的region。

:给定网络参数,所有超平面将输入空间所划分的region。

-

-

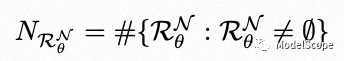

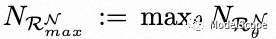

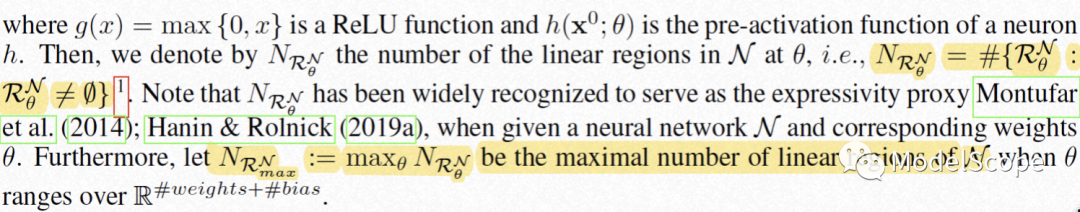

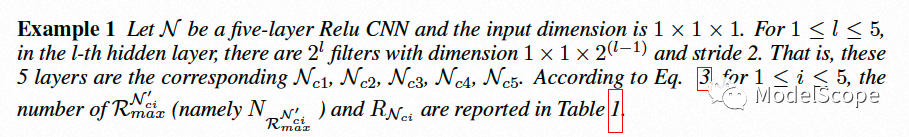

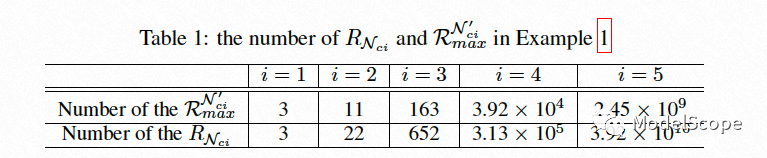

Number of Linear Region的数量at

:

:

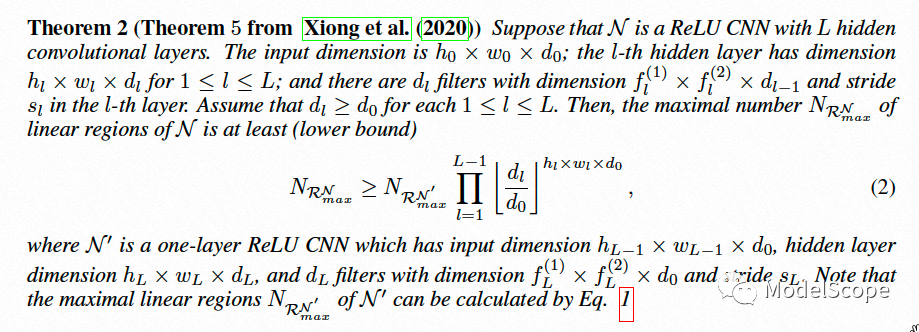

Maximal Number of Linear Region :

=> 用来刻画network expressivity。

=> 用来刻画network expressivity。

-

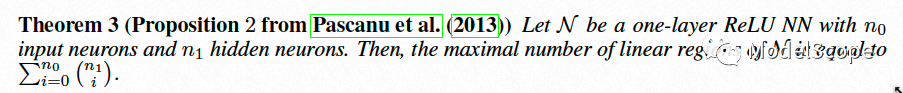

两个与linear region相关的定理

Method

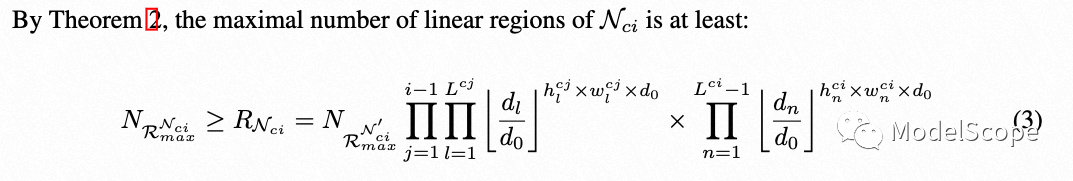

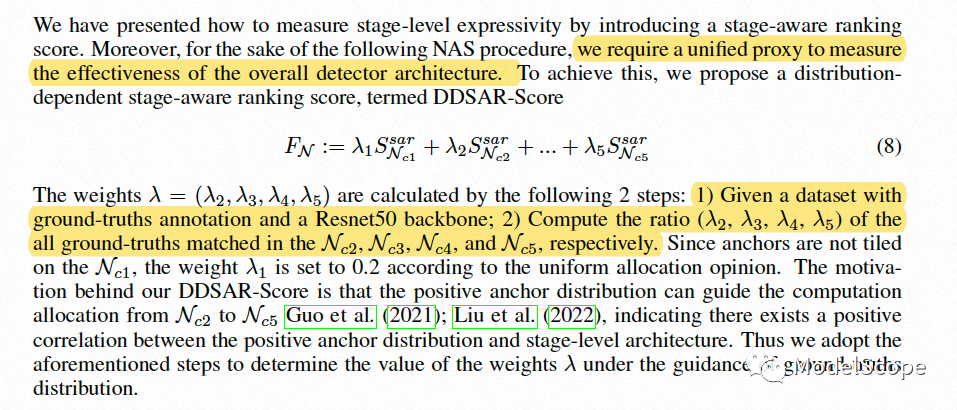

针对如何设计可以预测stage-level表征能力的精度预测器,我们从刻画network expressivity的角度出发,创新性地提出了SAR-score来无偏的刻画stage-wise network expressivity,同时基于数据集gt的先验分布,来确定不同stage的重要性,进一步提出了DDSAR-score 来刻画detection backbone的精度。

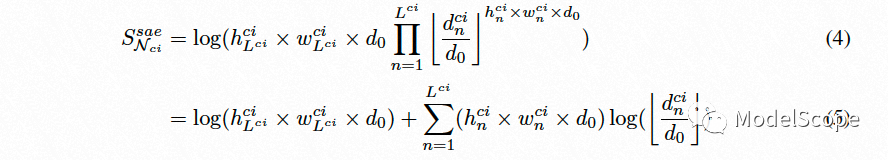

Adopt Theorem2 to charaterize stage-level network expressivity

Two issues ocuur

Stage-aware Expressivity Score

设计准则:

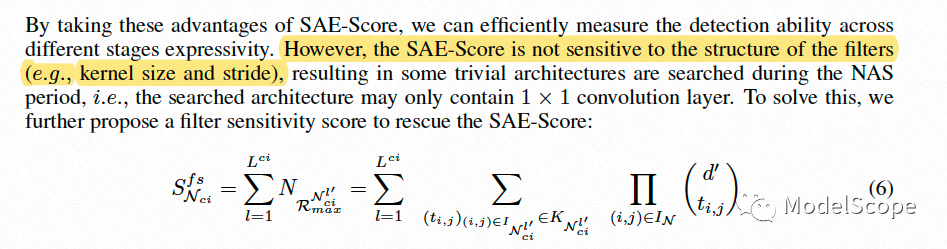

Filter Sensitivity Score

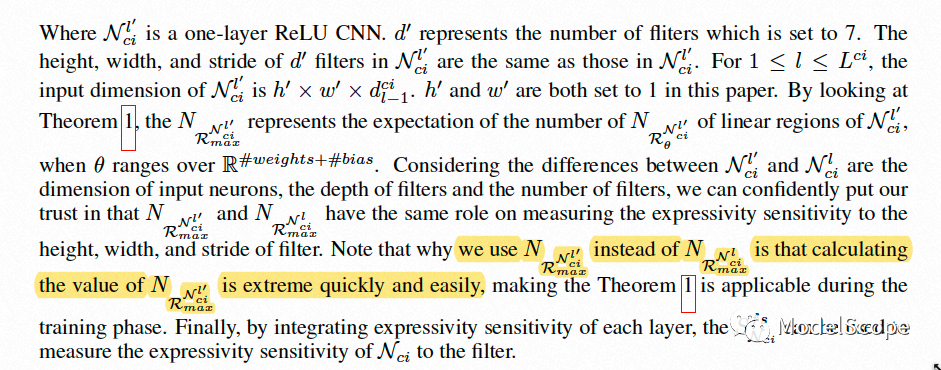

用一个易于计算的  来代替

来代替  来刻画不同卷积层对fiter size 的敏感性。

来刻画不同卷积层对fiter size 的敏感性。

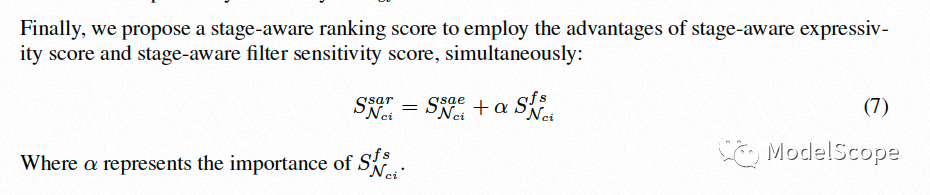

SAR-Score and DDSAR-Score

基于训练集GT的分布进一步确定每个stage的重要性

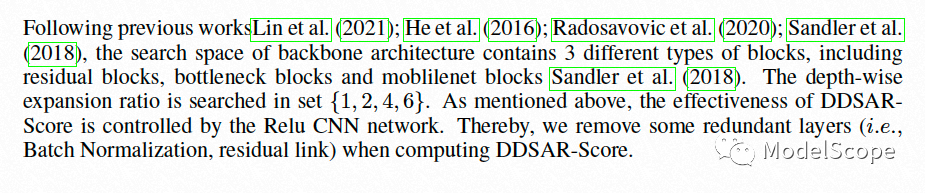

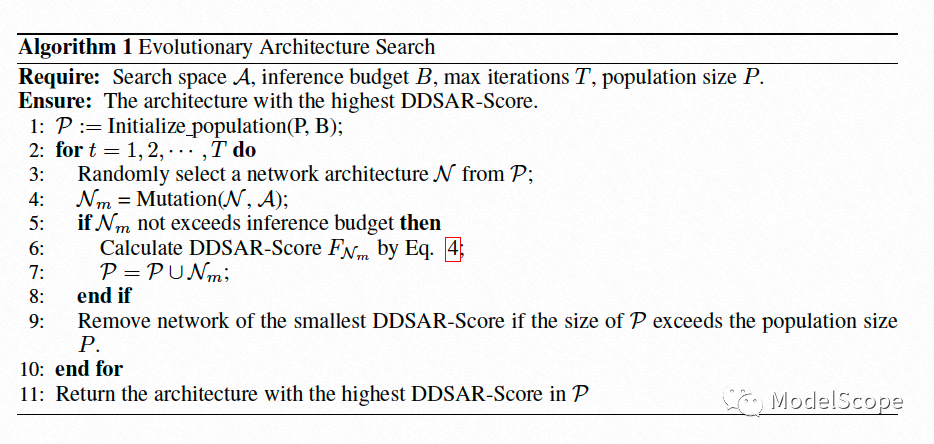

Serch Space and Evolutionary Architecture Search

04

结果

05

展望与应用

减少对超参敏感性

我们在实验的过程中发现DDSAR搜索轻量级(500m)的检测结构时对超参不太敏感,很快就会得到不错的结构,但是搜2.5G, 10G和34G Flops下的检测结构时对超参比较敏感,需要对\alpha以及搜索空间进行调整。可能原因是我们的filter sensitity score 为了加速计算过程,只能近似反应对filter size的敏感性,后续可以从其他角度优化下上述的暴力枚举过程。

增强方法在不同检测任务上的普适性

我们的DDSAR-score是用来刻画检测器表达能力的score,理论上应该在不同检测任务上都应该做的很好。我们目前只考虑了数据集gt的分布,但是不同检测数据集还有数据质量,数据集规模的差异,可以围绕data-centric的思想来对数据集的质量, 数据增强等维度来进一步建立数据集和精度预测器之间的关系,从而实现在不同检测任务上都很有效。

更精准的计算网络linear region的数量

通过linear region的数量来刻画网络的表达能力在ML领域发表了很多paper,可以尝试下更精准的bound或者exact number fo linear region。

最新CVPP 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看