HOW ATTENTIVE ARE GRAPH ATTENTION NETWORKS?

ICLR 2022论文

参考:CSDN

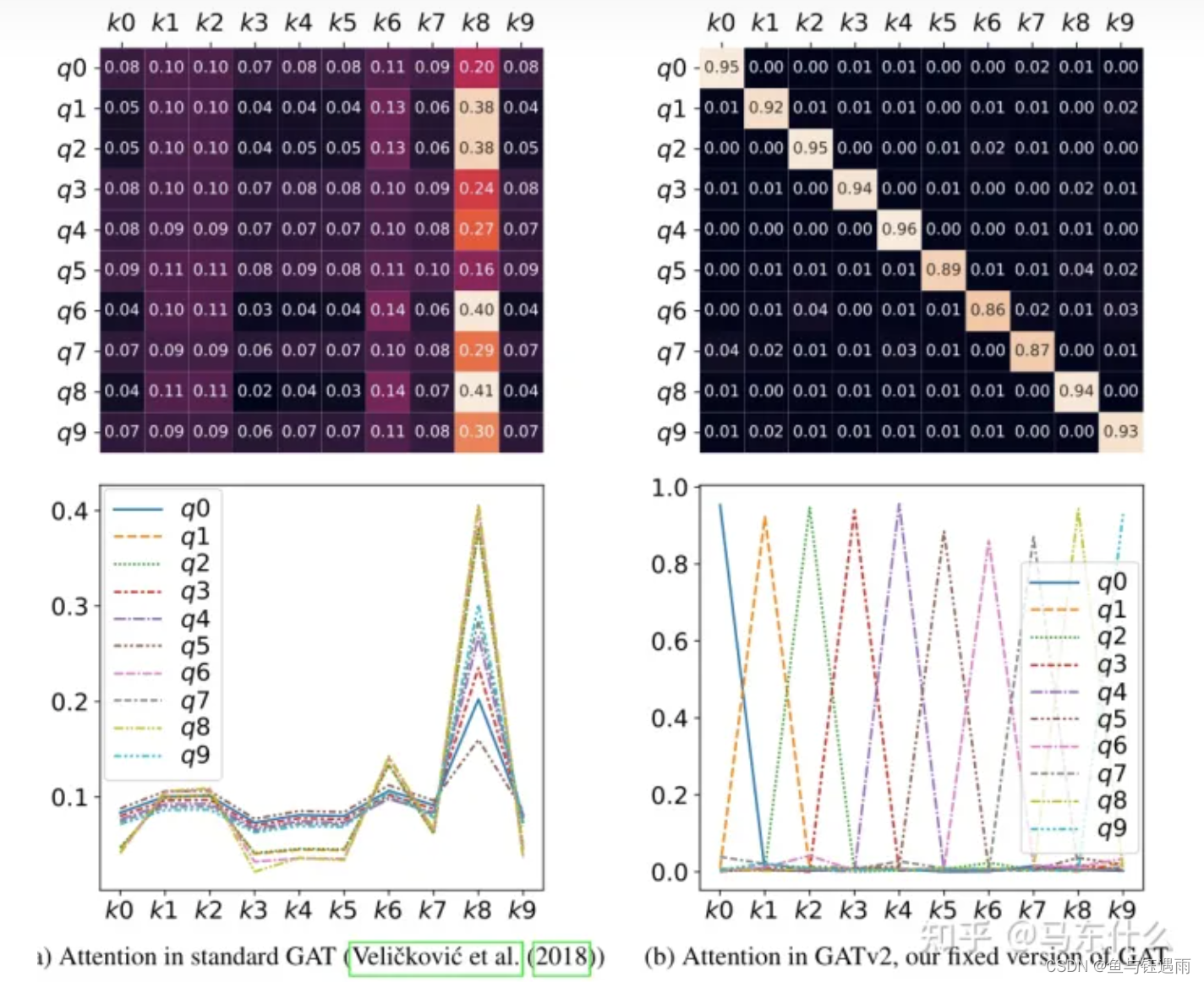

论文主要讨论了当前图注意力计算过程中,计算出的结果会导致,某一个结点对周围结点的注意力顺序是不变的,作者称之为静态注意力,并通过调整注意力公式将其修改为动态注意力。并通过证明,说明公式修改的正确性。也通过实验说明采用动态注意力的模型效果比静态更好。

参考:知乎

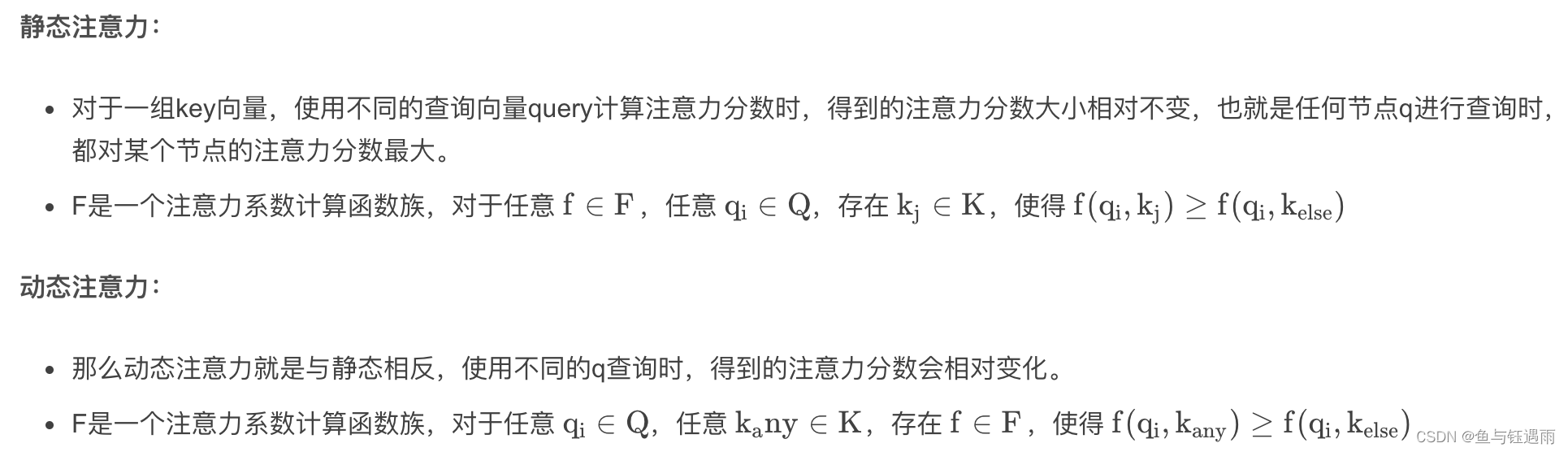

可以简单的理解就是:静态,无论是哪个q中心节点,它对邻居 k i k_{i} ki的注意力最大的 k k k(或者顺序)都是不变的。而对于动态注意力,不同的中心节点q,对应的会对任何一个邻居 k i k_{i} ki注意力最大。

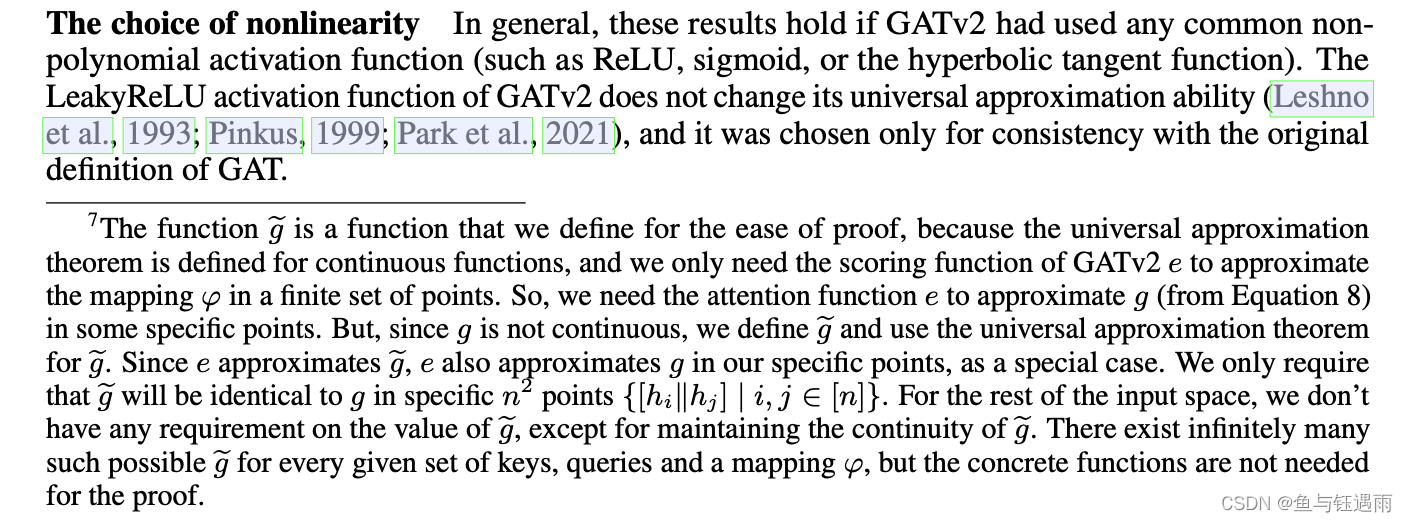

证明动态GAT的证明

该超链接证明为什么GAT是静态的,GATv2是动态的证明如下

1

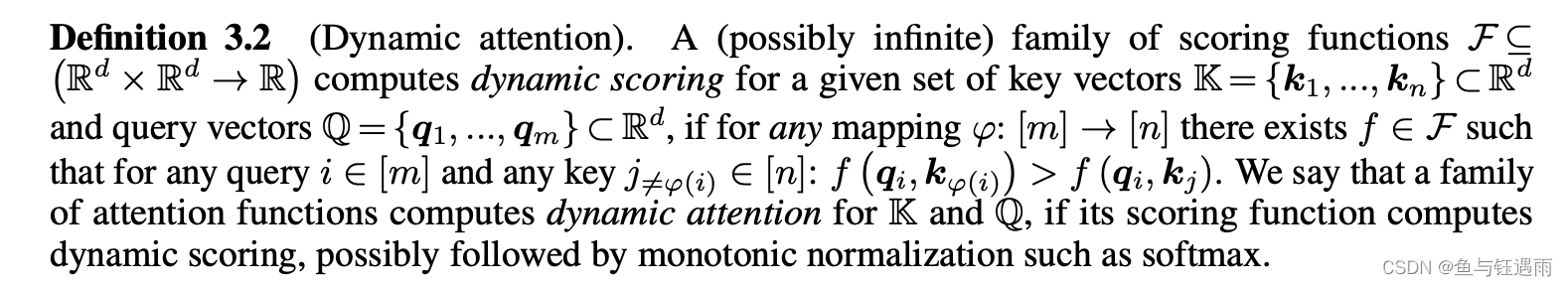

定义3.2:对于动态注意力,任何一个q到k的索引映射到的计算都打分结果可能是最大的。

我们说,如果一个注意力函数家族计算出了动态的注意力,对于K和Q来说,它的评分函数计算出了动态的评分,可能还会有单调的归一化,如softmax。

2

定理2. 一个GATv2层对任何一组节点表征K = Q = {h1, …, hn}都能计算动态注意力。

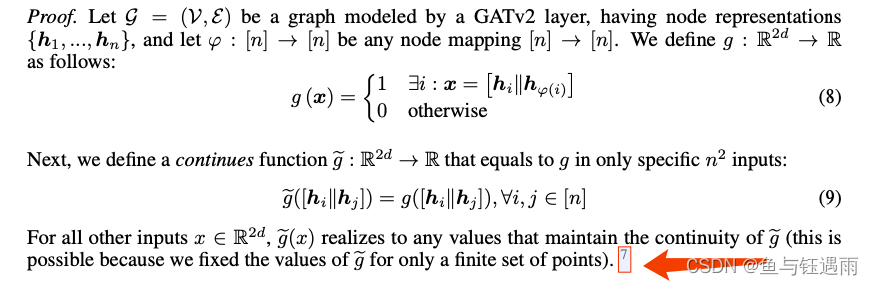

定理2 证明:让G = (V,E) 是一个由GATv2层建模的图,具有节点表示{h1,…,hn},