论文信息

dyngraph2vec: Capturing network dynamics using dynamic graph representation learning

原文地址:dyngraph2vec: Capturing network dynamics using dynamic graph representation learning:https://www.sciencedirect.com/science/article/pii/S0950705119302916

摘要

Learning graph representations is a fundamental task aimed at capturing various properties of graphs in vector space. The most recent methods learn such representations for static networks. However, real-world networks evolve over time and have varying dynamics. Capturing such evolution is key to predicting the properties of unseen networks. To understand how the network dynamics affect the prediction performance, we propose an embedding approach which learns the structure of evolution in dynamic graphs and can predict unseen links with higher precision. Our model, dyngraph2vec, learns the temporal transitions in the network using a deep architecture composed of dense and recurrent layers. We motivate the need for capturing dynamics for the prediction on a toy dataset created using stochastic block models. We then demonstrate the efficacy of dyngraph2vec over existing state-of-the-art methods on two real-world datasets. We observe that learning dynamics can improve the quality of embedding and yield better performance in link prediction.

学习图表示是一项基本任务,旨在捕获向量空间中图的各种属性。最新的方法学习静态网络的这种表示。然而,现实世界的网络随着时间的推移而发展,并具有不同的动态。捕捉这种演变是预测看不见的网络属性的关键。为了了解网络动力学如何影响预测性能,我们提出了一种嵌入方法,该方法可以学习动态图中的演变结构,并且可以更高精度地预测看不见的链接。我们的模型dyngraph2vec使用由密集层和循环层组成的深层架构来学习网络中的时间转换。我们激发了捕捉动态的需求,以便在使用随机块模型创建的数据集上进行预测。然后,我们在两个真实世界数据集上展示了dyngraph2vec相对于现有最新方法的功效。我们观察到学习动态可以提高嵌入的质量,并在链接预测中产生更好的性能。

Contributions

Dyngraph2VEC使用多个非线性层来学习每个网络中的结构模式。此外,它使用循环层来学习网络中的时间转换。循环层中的回溯参数控制学习的时间模式的长度。我们将实验重点放在链接预测任务上。我们将dyngraph2vec与最先进的动态图嵌入算法进行了比较,并展示了其在几个真实世界网络上的性能,包括协作网络和社交网络。我们的实验表明,使用具有循环层的深度模型可以捕获网络的时间动态,并且明显优于最先进的链路预测方法。我们强调我们的工作是针对链路预测而不是节点分类的。此外,我们的算法适用于聚合和快照时态图。

- 我们提出了dyngraph2vec,一个捕捉时间动态的动态图嵌入模型。

- 我们证明了捕获网络动态可以显著提高链路预测的性能。

- 我们展示了模型的变体,以显示关键的优势和差异。

- 我们发布了一个库 DynamicGEM,实现了我们的模型变体和最先进的动态嵌入方法。

Methodology

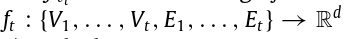

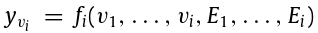

考虑一个加权图G(V,E),V和E分别作为顶点和边的集合。我们用 A 表示 G 的邻接矩阵,如果节点i,j之间有边相连,则Aij=1,否则Aij=0。演化图 G 表示为 G = {G1, …, GT},其中 Gt 表示图在时间 t 的状态。

我们定义我们的问题如下:给定图G,我们的目标是通过学习映射 和

和

在一系列低维向量空间中表示每个节点 V。换句话说,每个时间步的嵌入函数使用来自图演化的信息来捕获网络动态,从而可以更精确地预测链接。

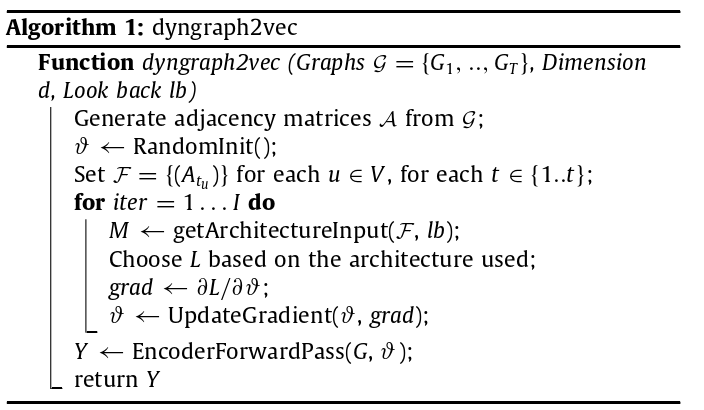

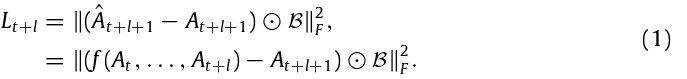

dyngraph2vec

Dyngraph2vec是一个深度学习模型,它以一组先前的图作为输入,在下一个时间步生成图作为输出,从而捕获每个时间步和跨多个时间步的顶点之间的高度非线性相互作用。由于嵌入值捕捉到了链接的时间演化,因此它允许我们预测下一个时间步的图链接。该模型通过优化以下损失函数,在时间步t学习网络嵌入:

这里我们通过在时间步t + 1上的嵌入来惩罚在时间t + l + 1上的错误重构。最小化该损失函数强制调整参数,使其能够捕获节点之间的演化模式关系,以预测未来时间步的边缘。t + d时刻的嵌入是t,t + 1,…,t + l时刻图的函数,其中l为时间回视。我们使用加权矩阵 对文献中传统使用的高于未观测链接的观测边的重构进行加权。

对文献中传统使用的高于未观测链接的观测边的重构进行加权。

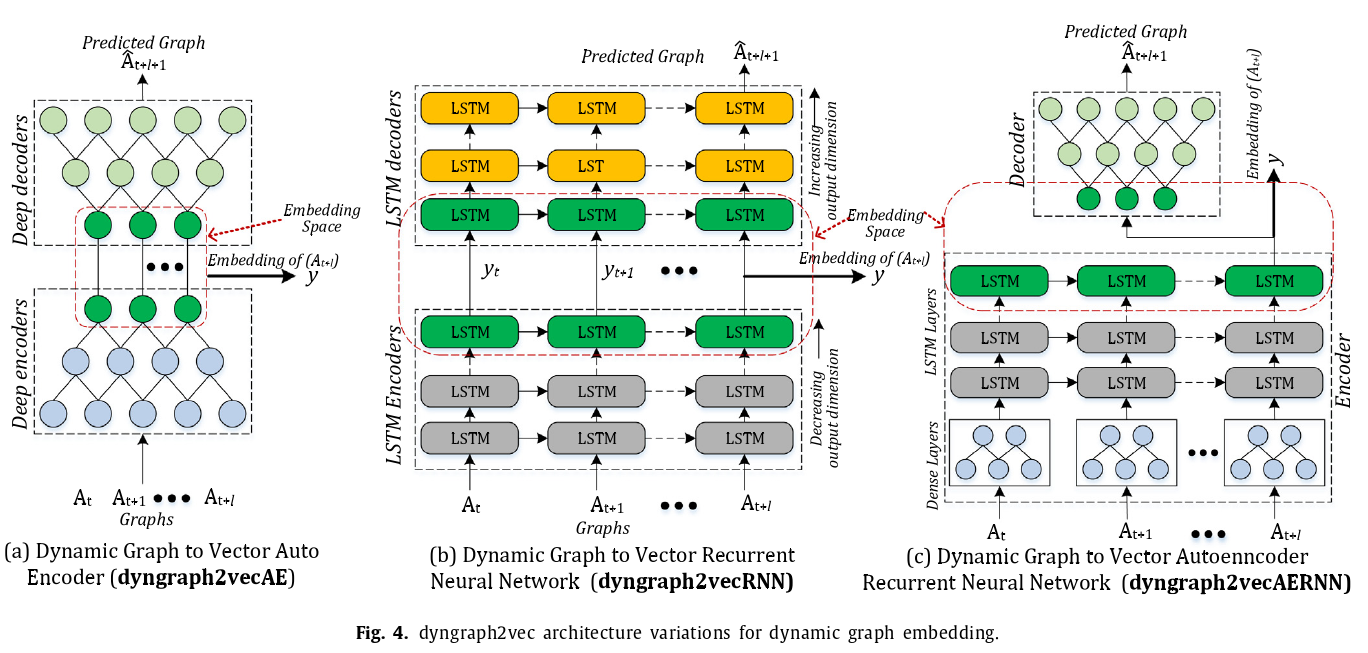

基于深度学习模型的架构,我们提出了我们模型的三个变体,如图所示:

(Ⅰ) dyngraph2vecAE ,(Ⅱ) dyngraph2vecRNN,(Ⅲ) dyngraph2vecAERNN。我们的三种方法在函数f ( . )的形式上有所不同。dyngraph2vecAE 将自动编码器直接扩展到动态设置。因此,我们通过新提出的dyngraph2vecRNN和dyngraph2vecAERNN克服了捕捉时间信息的局限性和模型参数量高的问题。

将传统上用于嵌入静态图的自编码器扩展到时序图的一个简单方法是将先前l个图的信息作为输入添加到自编码器中。因此,该模型( dyngraph2vecAE )使用多个全连接层来建模节点在跨时间和跨时间内的互连。具体来说,对于节点u具有邻域向量集 ,第一层的隐表示学习为

,第一层的隐表示学习为 ,其中

,其中 是激活函数。WAE,d,n和l分别表示第一层学习到的表示的维度,图中节点的数量,以及时间步。第k层的表征定义为:

是激活函数。WAE,d,n和l分别表示第一层学习到的表示的维度,图中节点的数量,以及时间步。第k层的表征定义为:

注意到Dyngraph2Vecae有O ( Nld(1))个参数。由于大多数真实世界的图是稀疏的,因此学习参数是有挑战性的。

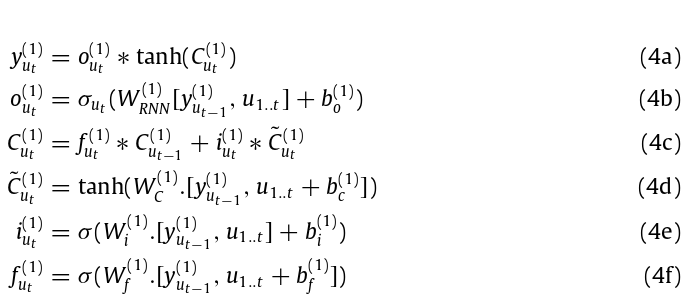

为了减少模型参数量,实现更高效的时序学习,我们提出了dyngraph2vecRNN和dyngraph2vecAERNN。在dyngraph2vecRNN中,我们使用稀疏连接的长短期记忆( Long Short Term Memory,LSTM )网络来学习嵌入。LSTM是一种能够处理长期依赖问题的循环神经网络( Recurrent Neural Network,RNN )。在动态图中,可能存在全连接自动编码器无法捕获的长期依赖关系。单个LSTM网络的隐状态表示定义为:

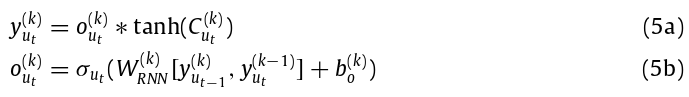

其中Cut表示LSTM的单元状态,fut表示触发遗忘门的值,out表示触发输出门的值,iut表示触发LSTM的更新门的值,˜ Cut表示新估计的候选状态,b表示偏差。第一层可以有l个LSTM网络连接,其中细胞状态和隐藏表示在从t - l到t个LSTM网络的链中传递。然后给出第k层的表示如下:

将节点u的稀疏邻域向量u1…t = [ aut , … , a~ut + l~]传递给LSTM网络的问题是需要学习低维表示的LSTM模型参数( (如存储单元数、输入单元数、输出单元数等)变大。相反,如果将稀疏的邻域向量降维为低维表示,LSTM网络可能能够更好地学习时间表示。为了实现这一点,我们提出了dyngraph2vec的变种模型dyngraph2vecAERNN。在dyngraph2vecAERNN中,我们不传递稀疏邻域向量,而是使用一个全连接编码器来初步获得低维的隐藏表示,具体如下:

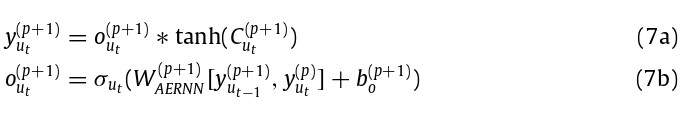

其中p表示全连接编码器的输出层。然后将该表示传递给LSTM网络。

然后将LSTM网络生成的隐藏表示传递给全连接解码器。

Optimization

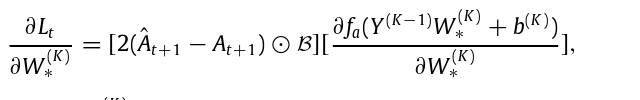

我们对上面定义的损失函数进行优化,得到最优的模型参数。通过在上式中施加关于解码器权重的梯度,我们得到:

其中, 是所有三个模型的倒数第二层的权重矩阵。对于每一个单独的模型,我们基于神经单元来反向传播梯度,以获得之前所有层的导数。对于基于LSTM的dyngraph2vec模型,通过时间反向传播来更新LSTM网络的权重。

是所有三个模型的倒数第二层的权重矩阵。对于每一个单独的模型,我们基于神经单元来反向传播梯度,以获得之前所有层的导数。对于基于LSTM的dyngraph2vec模型,通过时间反向传播来更新LSTM网络的权重。

在得到导数后,我们使用随机梯度下降( SGD )和自适应矩估计( Adam )对模型进行优化。具体算法见算法1。