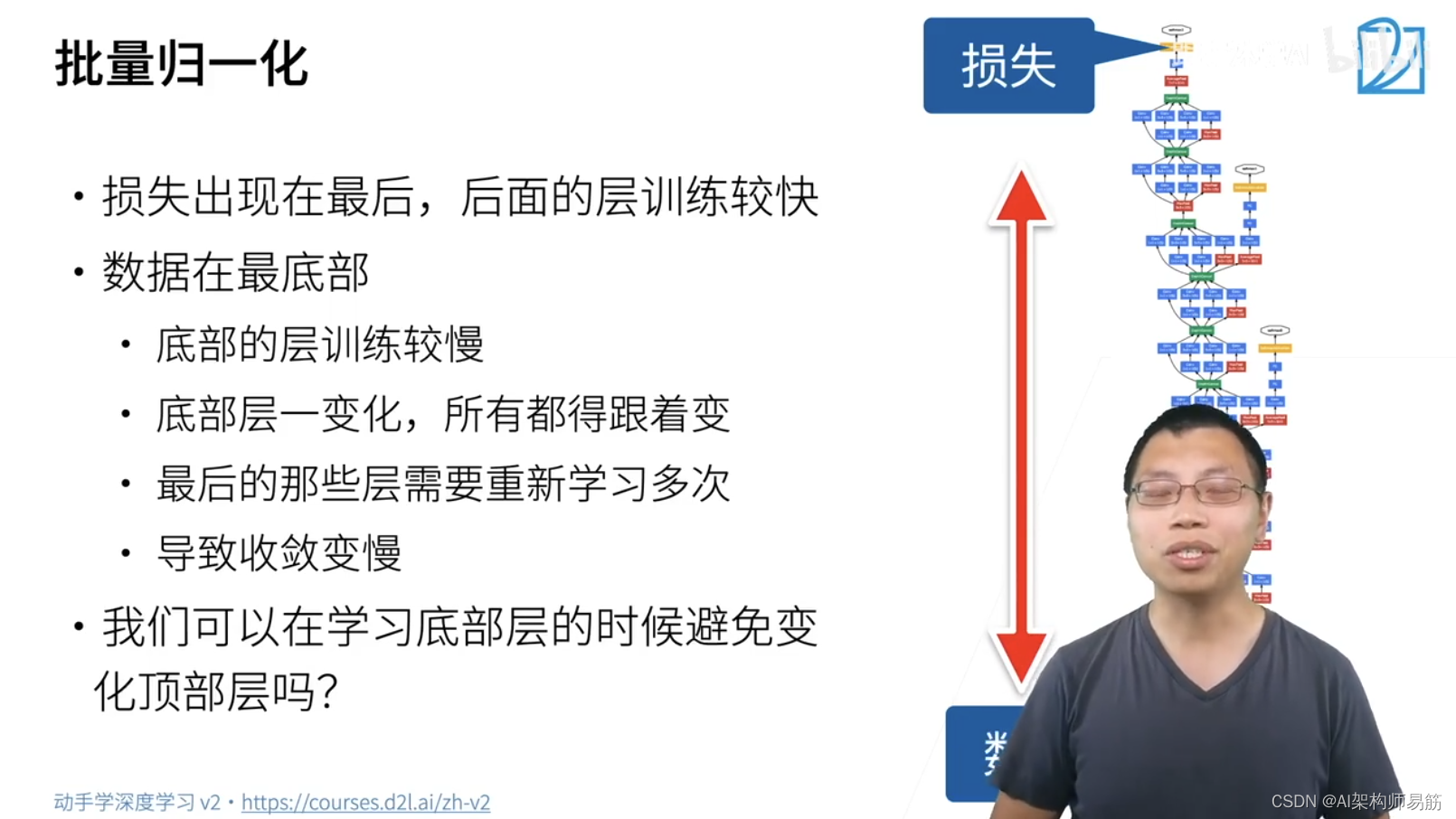

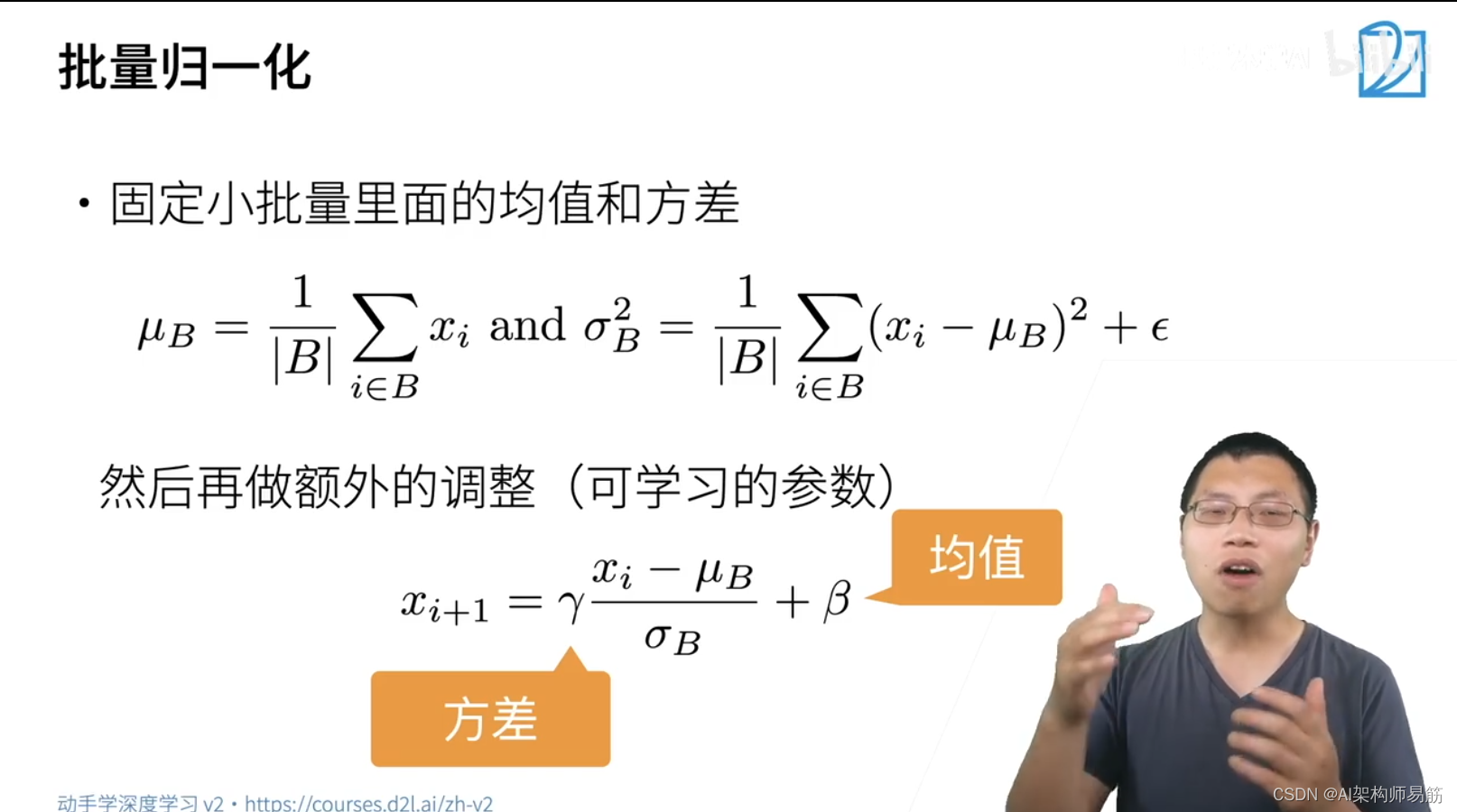

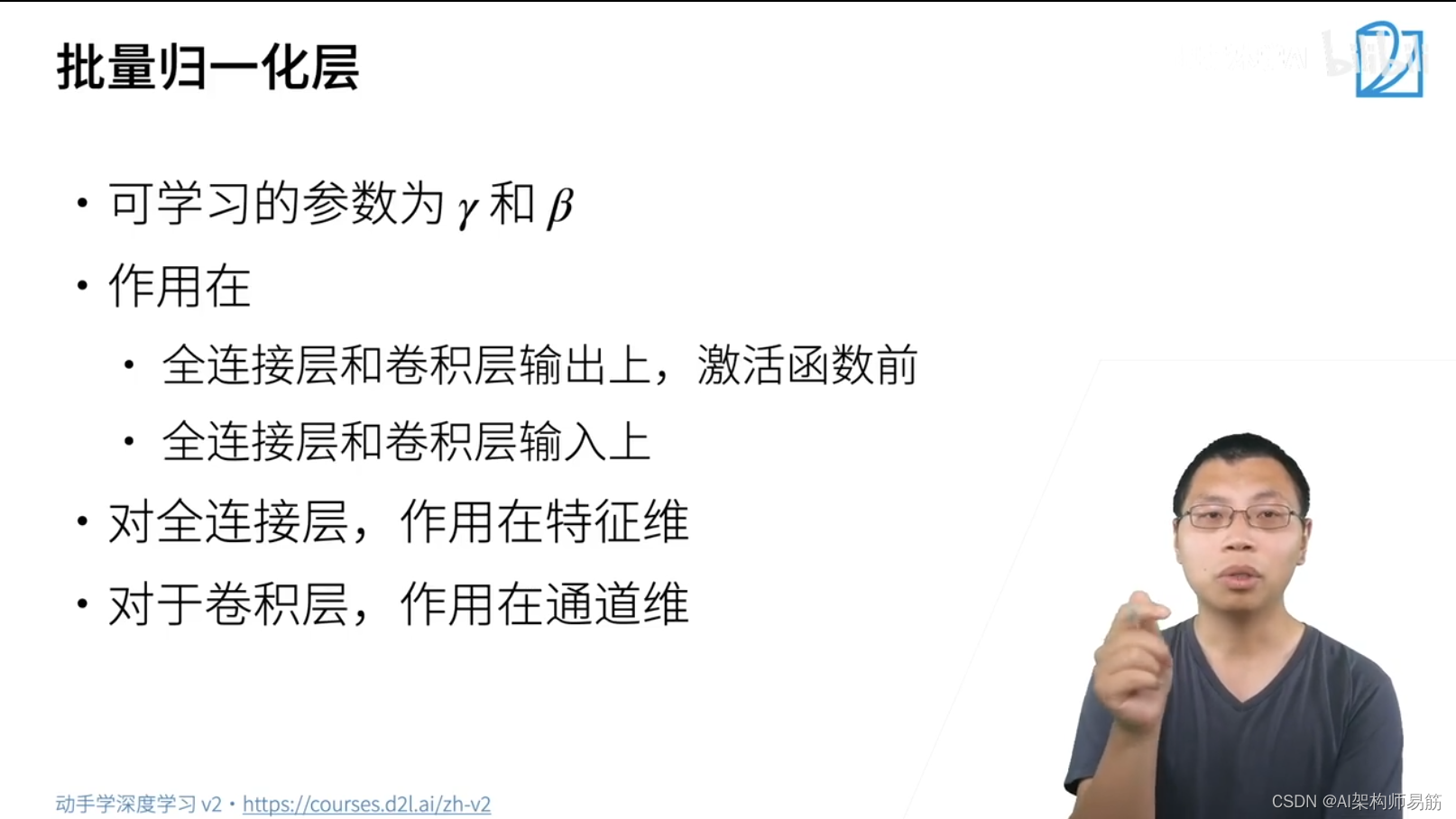

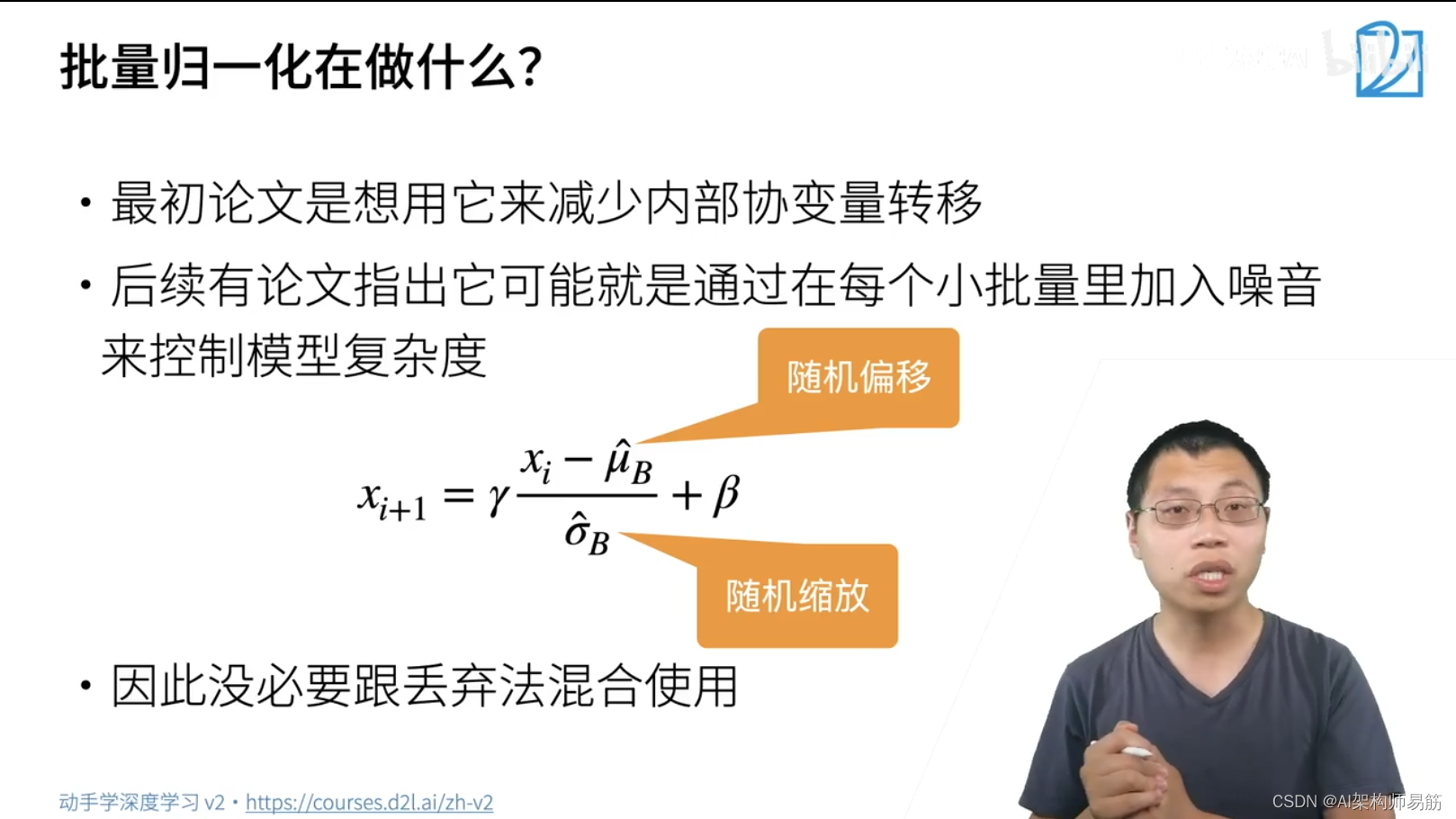

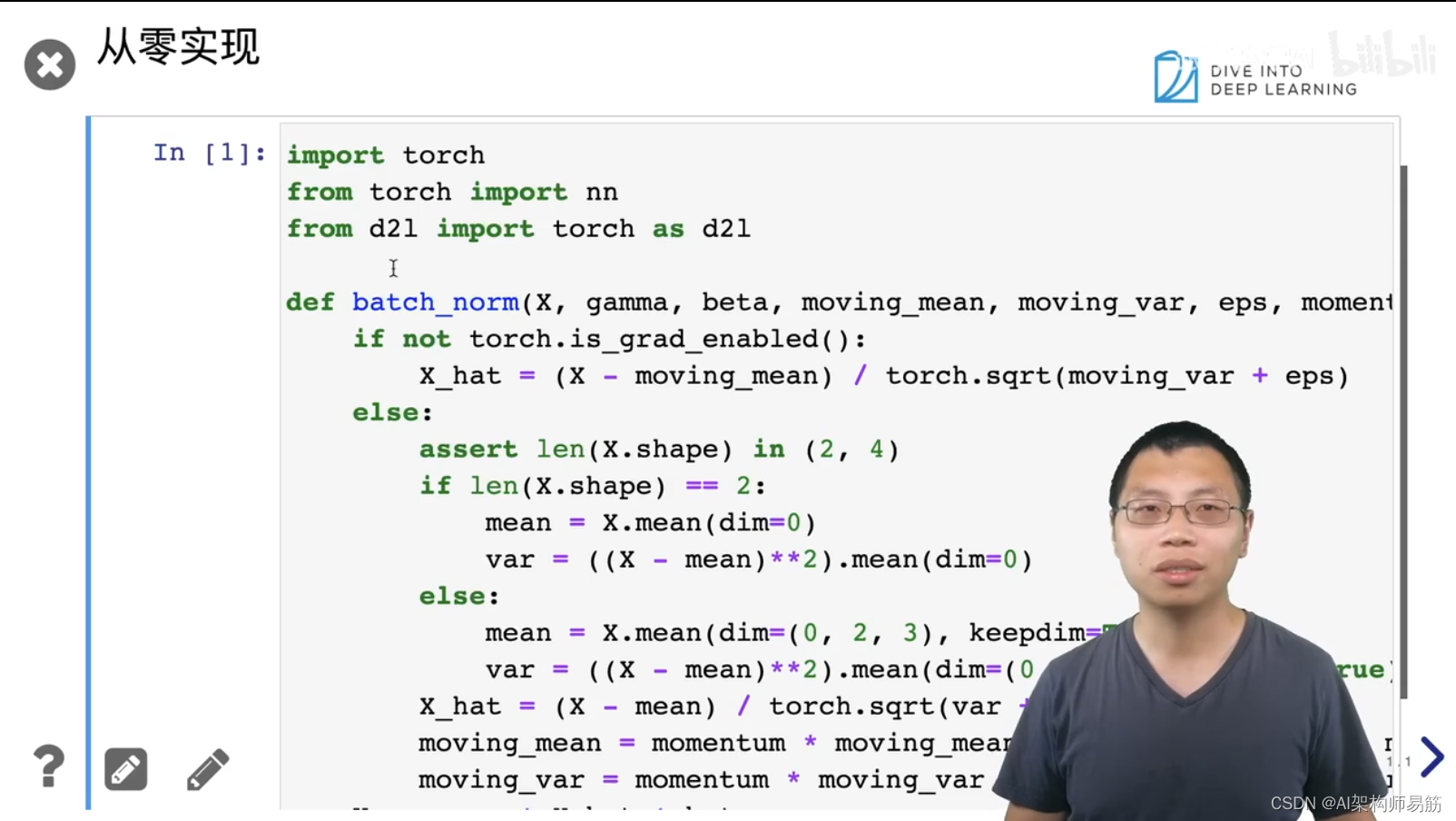

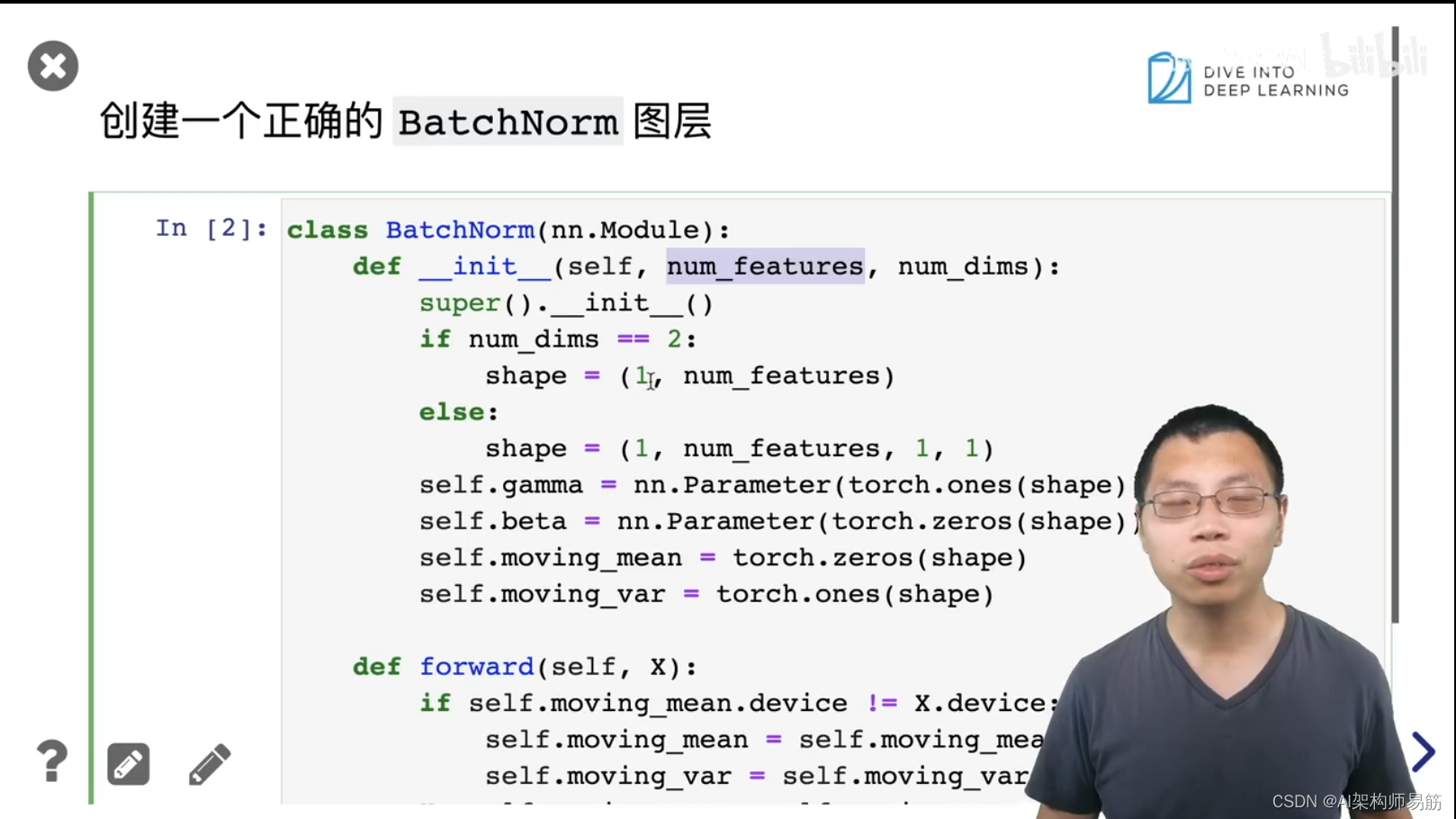

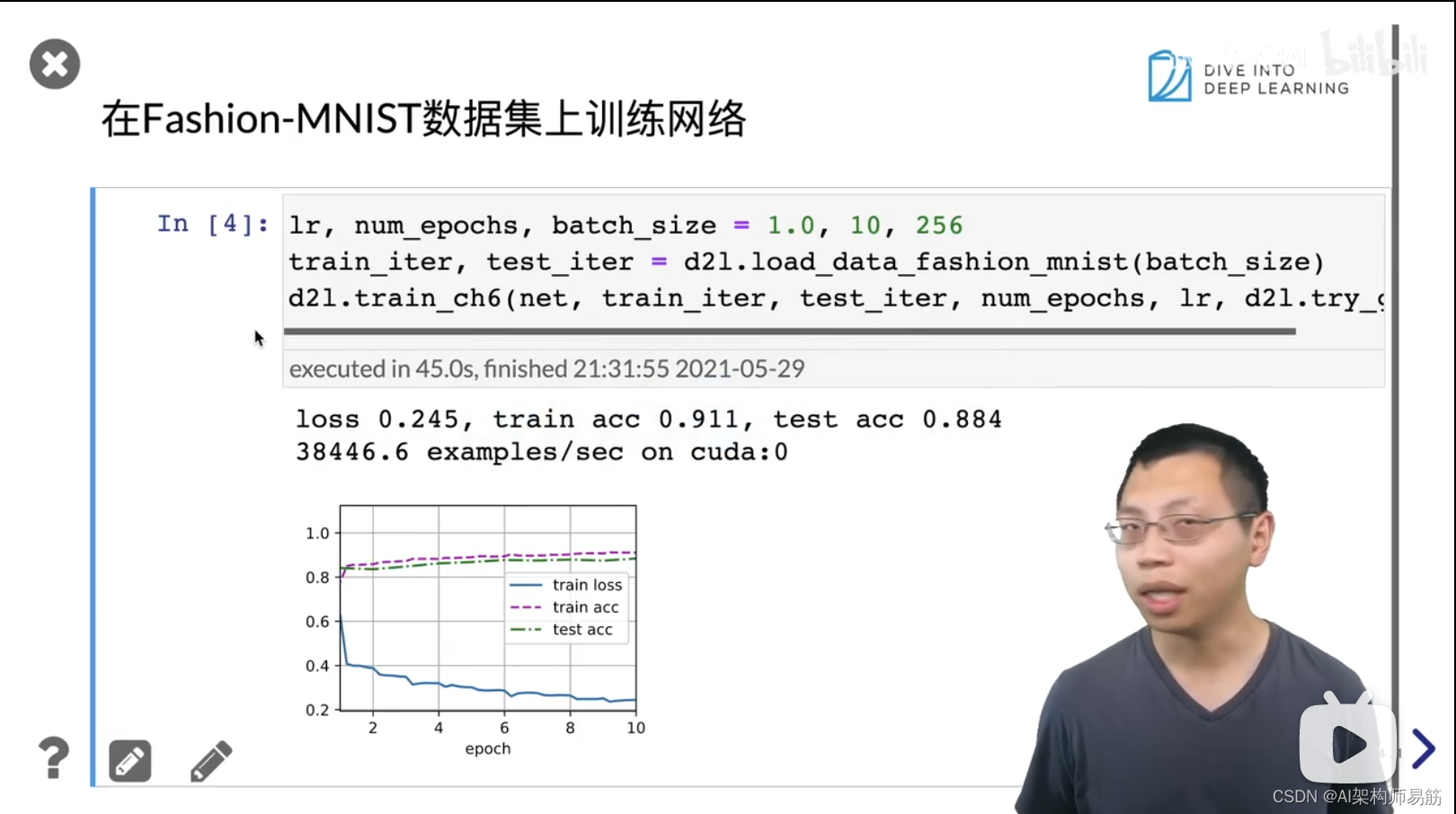

批量归一化Batch Normalization 动手学深度学习v2

猜你喜欢

转载自blog.csdn.net/zgpeace/article/details/124186290

今日推荐

周排行