SCRDet++: Detecting Small, Cluttered and Rotated Objects via Instance-Level Feature Denoising and Rotation Loss Smoothing

SCRDet++:通过实例级特征去噪和旋转损失平滑检测小的、杂乱的和旋转的物体

摘要

在现实世界中,小而杂乱的物体是常见的,这对检测具有挑战性。当物体被旋转时,难度更加明显,因为传统的探测器通常在水平边界框中定位物体,这样感兴趣的区域就会被背景或附近交错的物体污染。本文首先创新地将去噪思想引入到目标检测中。对特征图进行实例级去噪,增强对小目标和杂目标的检测。为了处理旋转变化,我们还在 smooth L1损失中加入了一个新的IoU常数因子,以解决长期存在的边界问题,据我们分析,这主要是由角度的周期性(PoA)和边缘的可交换性(EoE)造成的。通过结合这两个特性,我们提出的检测器被称为SCRDet++。本文在大型航空图像公共数据集DOTA、DIOR、UCAS-AOD以及自然图像数据集COCO、场景文本数据集ICDAR2015、小交通灯数据集BSTLD和我们新发布的S2TLD上进行了大量的实验。结果表明了该方法的有效性。项目页面登录 SCRDet++

小结:

- 将去噪思想引入到目标检测中。对特征图进行实例级去噪,增强对小目标和杂目标的检测。

- 角度的周期性(PoA)和边缘的可交换性(EoE):为了处理旋转变化,在 smooth L1损失中加入了一个新的IoU常数因子,以解决长期存在的边界问题。

关键词:目标检测,特征去噪,旋转检测,边界问题,航空图像。

1 介绍

视觉目标检测是计算机视觉的基本任务之一,基于卷积神经网络的各种通用检测器[1]、[2]、[3]、[4]、[5]、[6]、[7]已经被设计出来。在MS COCO[8]和VOC2007[9]等公共基准测试中取得了可喜的结果。然而,大多数现有的检测器并没有特别注意到一些常见的问题:体积小、排列杂乱、方向任意。这些挑战在空中图像[10],[11],[12],[13]中尤其明显,因为它的各种民用应用,如资源检测,环境监测和城市规划,已经成为一个重要的实践检测领域。

在遥感的背景下,我们进一步提出了一些具体的讨论来推动本文,如图1所示。需要注意的是,以下三个方面在自然图像、场景文本等其他来源中也普遍存在。

1) 小对象。航空图像通常包含被复杂的周围场景淹没的小物体。

2) 杂乱排列。航空图像中的车辆、船舶等物体往往排列密集,导致类间特征耦合和类内特征边界模糊。

3) 任意方向。航空图像中的物体可以以不同的方向出现。旋转检测是必要的,特别是考虑到大长宽比的问题:旋转的物体的水平边框比对齐的旋转的物体更松散,这样盒子包含了大量的背景或附近的杂乱物体作为干扰。非最大值抑制对其影响较大,如图1(a)所示。

小结:

- 小对象:复杂背景

- 杂乱排列:排列密集、类间特征耦合、类内特征边界模糊

- 方向任意:旋转检测、大长宽比、水平框(背景、杂乱物体)、旋转框、非极大抑制

图1所示。复杂场景下的小物体、杂乱物体和旋转物体,其中旋转检测起着重要的作用。

红框表示被非最大抑制(non-maximum suppression, NMS)抑制的缺失检测。

如上所述,小/杂乱的对象问题可以与旋转变换交织在一起。在这篇论文中,我们的目标是解决第一个挑战,寻求一种新的方法来消除来自背景和其他前景对象的噪声干扰。而对于旋转对准,则设计了一个新的旋转损失。我们的两种技术都可以作为现有检测器[7],[14],[15],[16],[17],[18]的插件,以开箱即用的方式。我们作进一步说明如下。

对于小而杂乱的目标检测,我们设计了一个去噪模块,而在目标检测中去噪的研究实际上还没有进行。我们观察到两种相互正交的常见噪声类型: i) 图像级噪声,这是对象不可知的,和 ii) 实例级噪声,特别是经常以对象之间的相互干扰和背景干扰的形式出现。这些噪音无处不在,在遥感的航拍图像中可以明显地看到。事实上,去噪在图像处理中一直是一个长期存在的任务[19],[20],[21],[22],而它们很少被指定用于目标检测,最终对原始图像进行去噪是为了图像增强而不是下游语义任务,特别是端到端的方式。

在本文中,我们探索了执行实例级去噪(InLD)的方法,特别是在特征图(即通过cnn的潜在层输出)中,以实现鲁棒检测。希望减少类间特征耦合和类内干扰,同时阻断背景干扰。为此,指定了一个新的InLD组件来将不同对象类别的特性大致解耦到它们各自的通道中。同时,在空间域,对目标和背景的特征分别进行增强和弱化。值得注意的是,上述想法在概念上类似于最近的工作[20],[22]图像级特征地图去噪(ImLD),这是作为一种方法来增强图像识别模型的抗攻击的鲁棒性,而不是位置敏感的目标检测。读者可以参考表5进行快速验证,我们的InLD在水平和旋转情况下都能比ImLD更有效地改进检测。

另一方面,如前所述,作为小/杂波目标检测的一个紧密交织问题,通过设计一种新的IoU-Smooth L1 loss来解决精确的旋转估计问题。这是出于这一事实现有最先进的回归旋转检测方法如5个参数回归[18],[23],[24],[25]遭受不连续边界的问题,这是固有的周期性造成的角边(PoA)和可交换性(EoE) [26] Sec.3.3.2(见细节)。

小结:

需要解决的两大问题:小/杂乱的对象问题 旋转对准问题一:小/杂乱的对象问题:

- 目的:消除来自背景和其他前景对象的噪声干扰。

- 分析原因:我们观察到两种相互正交的常见噪声类型: i) 图像级噪声,这是对象不可知的,和 ii) 实例级噪声,特别是经常以对象之间的相互干扰和背景干扰的形式出现。(问题的普遍性以及长期性:这些噪音无处不在,在遥感的航拍图像中可以明显地看到。事实上,去噪在图像处理中一直是一个长期存在的任务....)

- 解决方案:设计了一个去噪模块。

- 相关研究不足分析:去噪在图像处理中一直是一个长期存在的任务[19],[20],[21],[22]

很少被指定用于目标检测;

最终对原始图像进行去噪是为了图像增强而不是下游语义任务,特别是端到端的方式。- 因此不仅仅单纯当做图像增强而是服务于下游语义任务(服务最终任务)。

- 方法的详细说明:

实例级去噪(InLD)(新,应用在在特征图(即通过cnn的潜在层输出)中):

1)将不同对象类别的特性大致解耦到它们各自的通道中。

2)在空间域,对目标和背景的特征分别进行增强和弱化。

目的:以实现鲁棒检测。希望减少类间特征耦合和类内干扰,同时阻断背景干扰。

灵感来源:在概念上类似于最近的工作[20],[22]图像级特征地图去噪(ImLD),增强图像识别模型的抗攻击的鲁棒性,而不是位置敏感的目标检测。

结果对比:表5:根据ImLD、InLD及其组合在不同数据集和不同检测任务上的准确率(%)进行消融研究

(括号中的数字表示相对于单独使用InLD的相对改进)。

问题二:旋转

解决方案:新的IoU-Smooth L1 loss

目的:解决精确的旋转估计问题。

原因:遭受不连续边界的问题,这是固有的周期性造成的角边(PoA)和可交换性(EoE)

我们进行广泛的消融研究和实验在多个数据集包括航拍图像从DOTA[10],DIOR[11],UCAS-AOD[27],以及自然图像数据集可可[8],场景文本数据集ICDAR2015[28],小红绿灯数据集BSTLD[29]和我们新发布S2TLD说明的有前途的影响我们的技术。

本文的初步内容已经部分出现在讨论(conference)版本[30]中,其中的探测器名为SCRDet (Small, Cluttered, and rotation Object detector)。在这个日志版本中,我们扩展了我们改进的名为SCRDet++的检测器。总的贡献是:

- 据我们所知,我们首先提出了实例级噪声的概念(至少在目标检测的背景下),并在特征地图中设计了一个新的实例级去噪(InLD)模块。这是通过监督分割来实现的,监督分割的ground truth是通过目标检测中的bounding box近似获得的。该模型有效地解决了检测尺寸小、方向任意、分布密集目标时计算量小、参数增加少的问题。

- 为提高对任意旋转物体的鲁棒处理,设计了一种改进的smooth L1损失,通过添加IoU常数因子来解决旋转包围盒回归的边界问题。

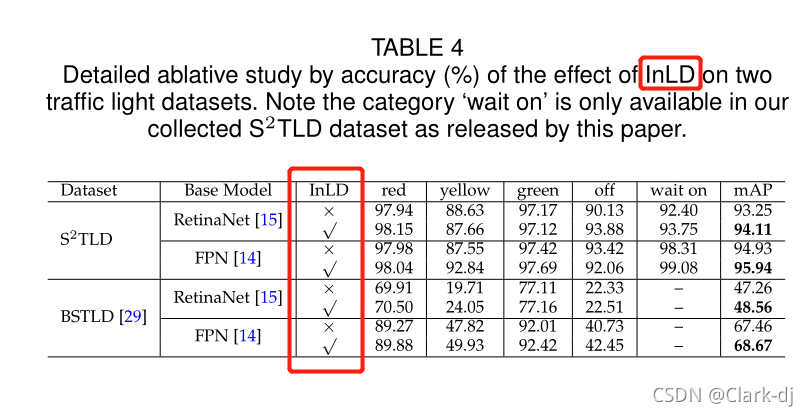

- 我们创建并发布一个真实世界的交通灯数据集:S2TLD。它包含5786张图片,14130个交通灯实例,分为五个类别:红、绿、黄、关和等待。它进一步验证了InLD的有效性,它可以在 https://github.com/Thinklab-SJTU/S2TLD.

- 我们的方法在公共数据集上实现了最先进的性能,用于复杂场景(如航空图像)的旋转检测。实验还表明,我们的InLD模块可以很容易地插入到现有的体系结构中,可以显著提高对不同任务的检测。

2 相关工作

我们首先讨论了基于水平边界盒的检测和基于旋转检测的现有检测器。然后介绍了在图像去噪和小目标检测方面的一些代表性工作。

2.1 水平区域目标检测

基于深度网络的目标检测技术正在兴起。R-CNN[1]开创了基于cnn的检测(pipeline)管道。随后,提出了基于区域的Fast R-CNN[3]、Faster R-CNN[7]和R-FCN[6]模型,实现了更低成本的检测。SSD[4]、YOLO[5]和RetinaNet[15]是具有代表性的单级方法,其单级结构进一步提高了检测速度。除了基于锚的方法,许多无锚方法近年来也变得流行起来。FCOS[31]、CornerNet[32]、CenterNet[33]和ExtremeNet[34]试图预测物体的一些关键点,如角或极值点,然后将这些关键点分组到包围盒中,这些检测器也被应用于遥感领域[35]、[36]。R-P-Faster R-CNN[37]在小数据集实现了令人满意的性能。该方法结合了可变形卷积层[39]和基于区域的全卷积网络(R-FCN),进一步提高了检测精度。论文[40]采用自顶向下和跳跃连接来产生一个高分辨率的单一高级特征映射,提高了可变形的Faster R-CNN模型的性能。IoUAdaptive R-CNN[41]通过一种新的 IoU-guided 检测网络减少了小目标信息的丢失。FMSSD[42]在多个比例尺和相同比例尺的特征映射中聚合上下文信息。然而,航空图像中体积小、杂波分布和任意旋转的目标仍然具有挑战性,尤其是对于水平区域检测方法。

小结:

双阶段 R-CNN[1]开创了基于cnn的检测(pipeline)管道。提出了基于区域的Fast R-CNN[3]、Faster R-CNN[7]和R-FCN[6]模型,实现了更低成本的检测。 单阶段 SSD[4]、YOLO[5]和RetinaNet[15]是具有代表性的单级方法,其单级结构进一步提高了检测速度。 无锚框 FCOS[31]、CornerNet[32]、CenterNet[33]和ExtremeNet[34]试图预测物体的一些关键点,如角或极值点,然后将这些关键点分组到包围盒中,这些检测器也被应用于遥感领域[35]、[36]。 可变形区域全卷机

R-P-Faster R-CNN[37]在小数据集实现了令人满意的性能。该方法结合了可变形卷积层[39]和基于区域的全卷积网络(R-FCN),进一步提高了检测精度。 跳跃连接 论文[40]采用自顶向下和跳跃连接来产生一个高分辨率的单一高级特征映射,提高了可变形的Faster R-CNN模型的性能。 小目标信息 IoUAdaptive R-CNN[41]通过一种新的 IoU-guided 检测网络减少了小目标信息的丢失。 特征映射 FMSSD[42]在多个比例尺和相同比例尺的特征映射中聚合上下文信息。 航空图像中体积小、杂波分布和任意旋转的目标仍然具有挑战性,尤其是对于水平区域检测方法。

2.2 定向任意对象检测

对旋转检测的需求最近一直在增加,如航空图像和场景文本。最近的进展主要是由于采用旋转的 bounding boxes 或四边形来表示多面向对象。对于场景文本检测,RRPN[16]使用旋转的RPN生成旋转的建议,并进一步执行旋转的 bounding boxes。TextBoxes++[43]采用顶点回归SSD。RRD[44]进一步改进了TextBoxes++,分别对旋转不变量和旋转敏感特征进行解耦分类和边界框回归。EAST[45]直接在完整图像中预测任意方向和四边形的单词或文本行,通过单个神经网络消除不必要的中间步骤。最近的文本识别方法,如FOTS[46],表明同时训练文本检测和识别可以大大提高检测性能。相比之下,航空图像目标检测更具挑战性:首先,多类别目标检测需要探测器的泛化。其次,航拍图像中的小物体通常密集分布在大尺度上。第三,由于噪声的多样性,航空图像检测需要一种更鲁棒的算法。许多航空图像旋转检测算法都是针对不同的问题而设计的。ICN[23]、ROI Transformer[24]和SCRDet[30]是代表性的两级航空图像旋转检测器,主要从特征提取的角度进行设计。实验结果表明,该方法在小密度目标检测方面取得了较好的效果。与以往的检测方法相比,R3Det[18]和RSDet[47]采用单级检测方法,更注重精度和速度的权衡。Gliding V ertex[48]和RSDet[47]通过四边形回归预测实现更精确的目标检测。Axis Learning[36]和![]() [35]结合最新流行的无锚思想,克服基于锚点的检测方法中锚点过多的问题。

[35]结合最新流行的无锚思想,克服基于锚点的检测方法中锚点过多的问题。

小结:

场景文本检测

问题:解耦就是分开的意思吗?

旋转的RPN

旋转的 bounding boxes

RRPN[16]使用旋转的RPN生成旋转的建议,并进一步执行旋转的 bounding boxes。 顶点回归SSD TextBoxes++[43]采用顶点回归SSD。 解耦分类和边界框回归 RRD[44]进一步改进了TextBoxes++,分别对旋转不变量和旋转敏感特征进行解耦分类和边界框回归。 直接完整图像中预测 EAST[45]直接在完整图像中预测任意方向和四边形的单词或文本行,通过单个神经网络消除不必要的中间步骤。 同时训练检测和识别 FOTS[46],表明同时训练文本检测和识别可以大大提高检测性能

航空图像目标检测

挑战:

泛化 多类别目标检测需要探测器的泛化。 小、密集、大尺度 航拍图像中的小物体通常密集分布在大尺度上。 噪声的多样性 更鲁棒的算法。许多航空图像旋转检测算法都是针对不同的问题而设计的。 想法:需要明确自己要解决的问题。

两级

特征提取

ICN[23]、ROI Transformer[24]和SCRDet[30]是代表性的两级航空图像旋转检测器,主要从特征提取的角度进行设计。 单级 R3Det[18]和RSDet[47]采用单级检测方法,更注重精度和速度的权衡。 四边形回归 Gliding V ertex[48]和RSDet[47]通过四边形回归预测实现更精确的目标检测。

无锚 Axis Learning[36]和

[35]结合最新流行的无锚思想,克服基于锚点的检测方法中锚点过多的问题。

2.3 图像去噪

深度学习在图像去噪中得到了广泛的关注。调查[19]将使用cnn的图像去噪分为四种类型(见其中的参考文献):1)加性白噪声图像(additive white noisy images);2)真实噪声图像( real noisy images);3)盲去噪(blind denoising)和4)混合噪声图像(hybrid noisy images),即噪声、模糊和低分辨率图像的组合。此外,图像去噪还有助于提高其他计算机视觉任务的性能,如图像分类[20],目标检测[21],语义分割[22]等。在目标检测领域中,除了图像噪声外,还存在实例噪声。实例噪声描述对象感知的噪声,它在对象检测中比对象不可知的图像噪声更广泛。在本文中,我们将探讨图像级去噪和实例级去噪技术在复杂场景中的目标检测中的应用。

小结:

四种图像噪声

- 加性白噪声图像(additive white noisy images)

- 真实噪声图像( real noisy images)

- 盲去噪(blind denoising)

- 混合噪声图像(hybrid noisy images),即噪声、模糊和低分辨率图像的组合

实例噪声

实例噪声描述对象感知的噪声,它在对象检测中比对象不可知的图像噪声更广泛。

2.4 小目标检测

小目标检测仍然是一个未解决的挑战。常见的小目标解决方案包括数据增强[49]、多尺度特征融合[14]、[50]、定制抽样策略[30]、[51]、[52]、生成对抗网络[53]和多尺度训练[54]等。在本文中,我们证明去噪也是提高小目标检测性能的有效手段。在复杂场景中,小物体的特征信息常常被背景区域所淹没,背景区域通常包含大量的相似物体。与普通图像级去噪不同,我们将使用实例级去噪来提高小目标的检测能力,这是一个新的视角。

本文主要考虑设计一个通用实例级特征去噪模块,以提高在挑战性航空图像、自然图像和场景文本中水平检测和旋转检测的性能。此外,我们还设计了IoU-Smooth L1 loss来解决任意方向目标检测的边界问题,以获得更准确的旋转估计。

小结:

小物体、背景复杂:除去注意力机制,可以考虑实例级去噪。

3 提出的方法

3.1 方法概述

图2显示了提出的SCRDet++的管道。主要由四个模块组成:

- 通过CNN提取特征,它可以从现有的检测器中提取不同形式的CNN[1],[4]。

- 图像级别去噪(ImLD)模块,删除常见图像噪音,这是可选的,它的效应可以衬托随后本文设计的InLD;

- 实例级去噪(InLD)模块,用于抑制实例噪声(即类间特征耦合和类内与背景之间的干扰);

- 类和box分支,用于预测分数和(旋转)bounding box。

具体来说,我们首先在第3.2节描述了我们的主要技术,即实例级去噪模块(InLD),其中进一步包含了与图像级去噪模块(ImLD)的比较。最后,我们在第3.3节详细介绍了网络学习,其中涉及到一个特别设计的旋转估计平滑损失。注意,在实验中,我们证明了InLD可以取代ImLD,并在检测中发挥更有效的作用,使ImLD成为我们管道中不可或缺的组件。

图2所示。我们方法的管道(使用RetinaNet[15]作为实施例)。我们的SCRDet++主要由四个模块组成:特征提取的基本实施例,去除常见图像噪声的图像级去噪,抑制实例噪声(即类间特征耦合和类内与背景之间的干扰)的实例级去噪模块,预测分类分数和边界框位置的“类+框”分支。“C”和“A”分别表示每个特征点的对象类别数量和锚点数量。

3.2 实例级特征映射去噪

在本小节中,我们介绍了我们设计的实例级特征地图去噪方法。为了强调实例级操作的重要性,我们进一步将其与feature map中的图像级去噪进行了比较,后者也被用于[20]中的鲁棒图像识别模型学习。据我们所知,我们的方法是第一个使用(实例级)特征地图去噪用于目标检测的方法。该去噪模块可与其他模块端到端学习,针对目标检测任务进行优化。

3.2.1 实例级噪声

实例级噪声一般指物体之间的相互干扰,也指来自背景的干扰。我们从以下几个方面来讨论它的性质。特别是如图3所示,对目标检测的影响在需要去噪特征空间的feature map中尤其明显,而不是在原始输入图像上

- 具有类物类形状的非物类在feature map中有较高的响应,尤其是对于小物体(见图3的上一行)。

- 杂乱物体排列密集,容易出现类间特征耦合和类内特征边界模糊的问题(见图3中间行)。

- 物体的响应被背景包围的不够突出(见图3底部一行)。

图3所示。在实例级去噪操作之前(中)和之后(右)的图像(左)及其特征映射。

第一行:具有物体形状的非物体。第二行:类间特征耦合与类内特征边界模糊。第三行:弱特征响应。

表达

3.2.2 实例级去噪数学建模

为了消除实例级噪声,人们通常可以参考注意机制的思想,作为一种重新加权卷积响应图的常用方法,以突出重要的部分,并抑制无信息的部分,如空间注意[55]和通道明智的注意[56]。我们表明,现有的航空图像旋转检测器,包括FADet[27]、SCRDet[30]和CAD-Det[25],通常使用简单的注意机制对输出进行重赋权,可以简化为以下一般形式:

其中

为输入图像的两个特征映射。注意功能

是指某个注意模块(如[55],[56])输出的提案。注意

是基于元素的产品。

和

表示空间权重和通道权重。

指示第i个信道的权重。在本文中,

是指沿着特征图的通道连接张量的拼接操作。

然而,eq .1只是简单地在空间域中区分物体和背景之间的特征响应,而![]() 仅用于测量每个通道的重要性。换句话说,不考虑类内对象和类间对象之间的交互,这对于复杂场景中的检测是很重要的。我们的目标是设计一种新的网络,不仅可以区分物体和背景,同时也削弱物体之间的相互干扰。具体来说,我们建议在卷积网络的中间层增加实例级去噪(InLD)模块。关键是将不同类别物体的特征解耦到它们各自的信道中,同时在空间域对物体和背景的特征分别进行增强和弱化。

仅用于测量每个通道的重要性。换句话说,不考虑类内对象和类间对象之间的交互,这对于复杂场景中的检测是很重要的。我们的目标是设计一种新的网络,不仅可以区分物体和背景,同时也削弱物体之间的相互干扰。具体来说,我们建议在卷积网络的中间层增加实例级去噪(InLD)模块。关键是将不同类别物体的特征解耦到它们各自的信道中,同时在空间域对物体和背景的特征分别进行增强和弱化。

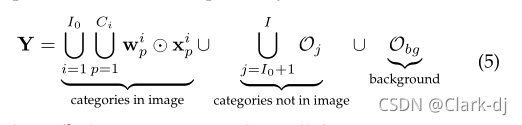

因此,我们的新公式如下,它考虑了对象类别的总数量和一个额外的类别作为背景:

对比

其中

是一个分级权值。

和

代表对应第i类的权值和特征响应,其信道数用Ci表示,对于

和

分别表示第i个类别沿第j个通道的权重和特征。

从等式1和等式2可以看出,![]() 可以近似为multiple

可以近似为multiple![]() 的组合,表示类别 i 的注意功能。因此我们有:

的组合,表示类别 i 的注意功能。因此我们有:

在不丧失一般性的前提下,考虑一个包含第一个![]() 类别的对象的图像。在本文中,我们的目标是将上述公式解耦为三个部分,并将其相互连接(如图5所示):

类别的对象的图像。在本文中,我们的目标是将上述公式解耦为三个部分,并将其相互连接(如图5所示):

对于背景和图像中不可见的类别,理想情况下,我们设计的去噪模块会过滤响应,使其尽可能小。从这个角度出发,等式4可以进一步解释为:

其中,![]() 表示目标为小特征响应1的张量,对于每个类别

表示目标为小特征响应1的张量,对于每个类别![]() 和背景

和背景![]() 。在下面的小节中,我们将展示如何实现上述类别间的解耦特征学习。

。在下面的小节中,我们将展示如何实现上述类别间的解耦特征学习。

3.2.3 实例级去噪的实现

在此基础上,我们设计了一个实用的神经网络实现。我们的分析从最简单的情况开始,即每个类别的权重![]() 在Eq.2(即

在Eq.2(即![]() )只有一个通道。在这种设置下,学习到的权值

)只有一个通道。在这种设置下,学习到的权值![]() 可以看作是对特定类别的图像进行语义分割的结果(三维 one-hot 向量)。这样就可以通过语义分割在

可以看作是对特定类别的图像进行语义分割的结果(三维 one-hot 向量)。这样就可以通过语义分割在 ![]() 引导更多的权重

引导更多的权重![]() 通道,如图2和图5所示。在语义切分任务中,输出层上各类别的特征响应在通道维上趋向分离,前景和背景在空间维上的特征响应也趋向极化。因此,对于等式5中的操作,可以采用语义分割网络。持这种语义分割观点的另一个优点是它可以以端到端监督的方式进行,其学习到的去噪权值可以比基于自我注意的替代方案[55],[56]更可靠和有效。

通道,如图2和图5所示。在语义切分任务中,输出层上各类别的特征响应在通道维上趋向分离,前景和背景在空间维上的特征响应也趋向极化。因此,对于等式5中的操作,可以采用语义分割网络。持这种语义分割观点的另一个优点是它可以以端到端监督的方式进行,其学习到的去噪权值可以比基于自我注意的替代方案[55],[56]更可靠和有效。

在图2中,我们给出了具体的实现如下。输入特征映射首先通过n个膨胀卷积[57]和1×1卷积层扩展接受域。例如,N的值分别是P3到P7金字塔层上{1,1,1,1}的个数,与我们实验中设置的值一致。然后,特征映射被两个平行1x1卷积层处理,以获得两个重要的输出。使用一个输出(三维one-hot 向量)进行粗多类分割,检测任务中标注的边界框可以作为近似地真值。希望这个输出将引导其他输出到去噪特征图中。

图2所示。我们方法的管道(使用RetinaNet[15]作为实施例)。我们的SCRDet++主要由四个模块组成:特征提取的基本实施例,去除常见图像噪声的图像级去噪,抑制实例噪声(即类间特征耦合和类内与背景之间的干扰)的实例级去噪模块,预测分类分数和边界框位置的“类+框”分支。“C”和“A”分别表示每个特征点的对象类别数量和锚点数量。

如图5所示,将去噪后的特征图与原特征图进行组合(点运算),得到最终解耦的特征图。其目的是双重的

- 沿着通道维度,不同对象类别(不包括背景)的类间特征响应基本上解耦到各自的通道中;

- 在空间维度上,由于目标区域的特征响应增强和背景弱化,类内特征边界被锐化。

因此,本小节开始时提出的三个问题得到了缓解。

图5所示。特征映射与解耦的类别特定的特征信号沿通道。

缩写“HA”、“SP”、“SH”和“SV”分别表示“Harbor”、“Swimming pool”、“Ship”和“Small vehicle”。“其他”包括图片中没有出现的背景和未见类别。

将不同类别的特征解耦到各自的通道中(顶部和中间),在空间域对目标和背景的特征分别进行增强和抑制(底部)

几个单词学习:

coarse 粗糙的

semantic 语义的

semantic segmentation 语义分割

approximate 近似

过程:

(实例级去噪:可以理解为通过图像分割指导后续的预测吗?)膨胀卷积、1x1卷积和并行1x1卷积

原图--------》带有标注bounding box的图片--------》粗糙图像分割--------》近似的分割ground truth----------》(有监督学习) 在这种设置下,学习到的权值

可以看作是对特定类别的图像进行语义分割的结果(三维 one-hot 向量)。这样就可以通过语义分割在

引导更多的权重

通道,如图2和图5所示。

这个图需要好好理解。

如图2右上角所示,将分类模型分解为目标性和类别分类两项,分别为:

这个概率mapP(对象)与每个特征点的锚是否是一个对象有关。而上述解耦特性直接用于对象分类![]() (以及将在第3.3节讨论的旋转回归)。

(以及将在第3.3节讨论的旋转回归)。

在训练过程中,将概率图![]() 作为回归损失的权重(见等式10),使那些模糊的正样本得到较小的权重,使高质量的正样本得到更多的关注。我们在实验中发现引入概率图可以加快模型的收敛速度,提高检测结果,如表2所示。

作为回归损失的权重(见等式10),使那些模糊的正样本得到较小的权重,使高质量的正样本得到更多的关注。我们在实验中发现引入概率图可以加快模型的收敛速度,提高检测结果,如表2所示。

表2:对于InLD在DOTA OBB任务上的速度和准确性的研究,二进制掩码和多掩码分别指二进制和多类语义分割。

余积(翻译有问题)表示在等式6中对P(object)进行乘法运算。

翻译的不对直接半猜

图像去噪是图像处理中的一个基本任务,它可能会对图像识别产生显著的影响,正如最近在[20]中研究和验证的那样。具体来说,工作[20]表明由网络层执行的转换加剧了扰动,并且幻觉激活可以超过由于真实信号的激活,这导致更糟糕的预测。

这里我们也在航空图像的背景下研究这个问题,虽然我们直接借用图像级别去噪模型[20]。如图4所示,我们在原始航拍图像上添加高斯噪声,并与干净图像进行对比。在对干净图像进行训练的同一检测网络中,从res3块的同一通道中提取的干净图像和噪声图像上的相同特征映射被可视化。虽然噪声影响不大,肉眼很难分辨。然而,在feature map中,这一点变得更加明显,物体逐渐被淹没在背景中,或者物体之间的边界趋于模糊。

图4所示。特征映射对应于干净的图像(上)和有噪声的版本(下)。

噪声由一个均值为0,方差为0.005的高斯函数随机产生。

第一和第三列:图像;其余专栏:特性映射。

干净图像的feature map中前景和背景的对比度更明显(第二列),稠密物体之间的边界更清晰(第四列)。

(这里的图像需要好好看看)及时可视化特征图找问题是一个值得学习的点,更加直观。

由于卷积运算和传统去噪滤波器高度相关,我们采用了一个潜在的解决方案[20],它使用卷积层来模拟不同类型的差分滤波器,如非局部均值、双边滤波、均值滤波和中值滤波。受这些操作在对抗性攻击[20]中成功的启发,本文将这些差分操作迁移和扩展到目标检测中。我们在图2中展示了ImLD的一般形式。它通过去噪操作处理输入特征,如非局部方法或其他变量。消噪后的表示先由一个1x1卷积层处理,然后通过残差连接添加到模块输入中。ImLD仿真表达式如下:

思考:

上面这段话需要一些数学基础,再想想。

![]() 是某个过滤器的输出。

是某个过滤器的输出。![]()

![]() 代表输入图像的整个特征映射。施加去噪模块的效果如表1所示。接下来,我们进一步展示了InLD模块更显著的检测改进,其效果可以很好地覆盖图像级别。

代表输入图像的整个特征映射。施加去噪模块的效果如表1所示。接下来,我们进一步展示了InLD模块更显著的检测改进,其效果可以很好地覆盖图像级别。

在DOTA数据集的OBB任务中,消融研究了[20]中使用的五种图像级别去噪设置。

3.3 损失函数设计与学习

3.3.1 水平目标检测

(略)

只记录一些关键点。

对于水平检测,使用多任务损失,定义如下:

3.3.2 旋转目标检测

相反,旋转检测需要仔细处理边界问题。其中,角回归存在边界问题,如图7(a)所示。这表明这是一种理想的回归形式(蓝框逆时针旋转到红框),但由于角度的周期性(PoA)和边缘的可交换性(EoE),这种情况的损失非常大。因此,需要对模型进行如图7(b)所示的其他复杂形式的回归(如蓝盒顺时针旋转时,缩放w和h),增加了回归的难度,如图8(a)所示。

实际情况step1 过后,宽高互换了吧?

图7所示。角度回归的边界不连续性。蓝色、绿色和红色的包围框分别表示锚/建议、ground-truth 和预测框

检测结果由两个损失。对于这种密集排列的情况,角度估计误差也会使分类更加困难。

公式11,我们在传统的平滑L1损耗中引入IoU 常数因子  完美解决这个问题,这种新的损耗函数被称为IoU-smooth L1损耗。可以看出,在边界情况下,损失函数近似等于|−log(IoU)|≈0,消除了

完美解决这个问题,这种新的损耗函数被称为IoU-smooth L1损耗。可以看出,在边界情况下,损失函数近似等于|−log(IoU)|≈0,消除了![]() 引起的损失突然增加。新的回归损失可以分为两部分:

引起的损失突然增加。新的回归损失可以分为两部分: 确定梯度传播的方向,

确定梯度传播的方向,![]() 表示梯度的大小。此外,利用IoU优化定位精度与IoU主导度量一致,比坐标回归更直接有效。

表示梯度的大小。此外,利用IoU优化定位精度与IoU主导度量一致,比坐标回归更直接有效。

4 实验

实验在使用GeForce RTX 2080ti和11G内存的服务器上进行。首先给出数据集的描述,然后利用这些数据集验证所提方法的优点。源代码是可用的https://github.com/SJTU-Thinklab-Det/DOTA-DOAI.

4.1 数据集与协议

我们从航空图像、自然图像和场景文本中选择各种各样的公共数据集进行评估。具体情况如下。

DOTA(略)

DIOR(略)

UCAS-AOD(略)

BSTLD(略)

S2TLD(略)

除上述数据集外,我们还使用自然图像数据集COCO[8]和场景文本数据集ICDAR2015[28]进行进一步评估。

除非另有说明,实验默认由ResNet50[60]初始化。所有实验的重量衰减和动量分别设为0.0001和0.9。我们在8个gpu上使用MomentumOptimizer,每个迷你批处理总共有8张图片。我们遵循COCO的标准评估协议,而对于其他数据集,基于retinanet方法的锚点在从P3到P7的金字塔级别上的面积分别为322至522。在每个金字塔级别,我们使用7个纵横比{1、1/2、2、1/3、3、5、1/5}和3个尺度![]() 的锚。对于基于锚的旋转方法(RetinaNet-R),角度是由一个算术级数从−90◦至−15◦间隔15度。

的锚。对于基于锚的旋转方法(RetinaNet-R),角度是由一个算术级数从−90◦至−15◦间隔15度。

4.2 消融研究

消融研究详细评价了图像水平去噪(ImLD)和实例水平去噪(InLD)的效果,以及它们的组合

图像级去噪的效果。我们在DOTA数据集上试验了[20]中引入的5个去噪模块。我们使用我们以前的工作R3Det[18],最先进的DOTA方法之一,作为基线。从表1可以看出,除了均值过滤外,大多数方法都是可行的。其中,非局部高斯分布是最有效的(高出1.95%)。

在DOTA数据集的OBB任务中,研究了[20]中使用的五种图像级别去噪设置。

实例级去噪的效果。设计InLD的目的是使不同类别的特征在通道维上解耦,而在空间维上分别增强和弱化物体和非物体的特征。我们设计了一些验证测试,并获得了表2所示的积极结果。我们首先探讨了二值语义分割弱化非目标噪声的效用,检测mAP从65.73%提高到68.12%。多类别语义分割的结果进一步证明了目标之间确实存在干扰,检测mAP增加了1.31%(达到69.43%)。通过以上两个实验,我们可以初步推测非目标区域的干扰是影响探测器性能的主要原因。

对于InLD在DOTA OBB任务上的速度和准确性的研究,二进制掩码和多掩码分别指二进制和多类语义分割。

余积表示在等式6中对对象项(对象)进行乘法运算。

令人惊讶的是,共同生成对象性预测得分(Eq.6中的seeP(object))可以进一步提高性能,提高训练速度,最终准确率为69.81%。表6实验表明,InLD极大地提高了R3Det对BR、SV、LV、SH、SP、HC等小物体的性能,分别提高了3.94%、0.84%、4.32%、8.48%、10.15%和9.41%。在精度得到很大提高的同时,模型的检测速度仅降低了1fps (13fps)。

除了DOTA数据集,我们还使用了更多的数据集来验证其通用性,如DIOR、ICDAR、COCO和S2TLD。根据表5和图10显示的使用InLD前后的可视化结果,InLD在四个数据集上分别得到了1.44%、1.55%、1.4%和0.86%的改善。

为了研究InLD带来的性能提升是由于额外的计算(扩张卷积)还是监督学习(LInLD),我们通过控制扩张卷积和监督信号的数量来进行消融实验。表3显示,监督学习是InLD的主要贡献,而不是更多的卷积层。

69.81-69.07=0.74 监督学习是InLD的主要贡献,而不是更多的卷积层。

65.52-65.40=0.12

值得学习

特别地,我们对SJTU新发布的交通检测数据集S2TLD (Small Traffic Light Dataset)进行了详细的研究。与BSTLD相比,S2TLD有更多可用的类别。另外,S2TLD包含了两个不同相机拍摄的不同分辨率的图像,可以用于更有挑战性的检测任务。表4显示了InLD对这两个交通灯数据集的有效性。

ImLD与InLD联用效果观察。一个很自然的想法是我们是否可以将这两种去噪结构结合起来,如图2所示。为了更全面的研究,我们在不同的数据集和不同的检测任务上进行了详细的消融实验。实验结果如表5所示,我们倾向于得到以下几点:

- 大部分数据集比较干净,所以ImLD并没有在所有数据集上得到显著的增长。

- 采用InLD的探测器性能提高非常显著且稳定,优于ImLD。

- ImLD和InLD组合的增益不大,主要是因为它们的效果有一定的重叠:InLD减弱了非物体区域的特征响应,同时减弱了图像噪声的干扰。

因此,根据数据集和计算环境,ImLD是一个可选模块。除非另有说明,我们不会在后续实验中使用ImLD。

IoU-Smooth L1损耗的影响。IoU-Smooth L1 loss3消除了角度的边界效应,使模型更容易回归到物体坐标。由表7可知,新的损耗使三种探测器的精度分别提高到69.83%、68.65%和76.20%。

数据增强和骨干网的作用。使用ResNet101作为主干和数据增强(随机水平、垂直翻转、随机灰度、随机旋转),我们观察到合理的改进,如表6所示(69.81%→72.98%)。使用ResNet152作为骨干,将模型的最终性能从72.98%提高到74.41%。由于数据集中类别的极度不平衡,这为数据增强提供了巨大的优势,但我们发现,这并不影响InLD在这些升沉设置下的功能,从72.81%到74.41%。所有实验都是在DOTA上的OBB任务上进行的,最终基于R3Det的模型也命名为R3Det++。

4.3 与最先进方法的比较

在DOTA[10]和DIOR[11]两个数据集上,我们将我们提出的InLD与最先进的算法进行了比较。我们的模型优于所有其他模型。

Results on DOTA.我们将我们的结果与DOTA的最高水平结果进行了比较,如表8所示。这里报告的DOTA结果是通过将我们的预测提交给DOTA官方评估服务器5获得的。在OBB任务中,我们将提出的InLD模块添加到单级检测方法(R3Det++)和两级检测方法(FPN-InLD)中。我们的方法取得了最好的性能,分别为76.56%和76.81%。为了进行公平的比较,我们没有使用各种技巧的叠加,超大的骨干和模型集合,而这些通常是在DOTA的排行榜方法中使用的。在HBB任务中,我们也进行了同样的实验,获得了竞争检测mAP,分别为74.37%和76.24%。通过多尺度训练和测试,模型性能可进一步提高到79.35%。值得注意的是,FADet[27]、SCRDet[30]和CAD-Det[25]使用的是Eq.1中描述的简单的注意力机制,但我们的性能远远优于所有这些机制。图11为部分航拍子图像,图12为大场景航拍图像。

图11所示。用该方法对OBB任务中不同目标的DOTA进行检测实例

图12所示。我们提出的方法在大场景下检测DOT A数据集的例子。

我们的方法既可以有效地处理高密度(顶部图形带有白色边框),也可以有效地处理旋转(底部图形带有红色边框)情况。

Results on DIOR and UCAS-AOD.DIOR是一个新的大型航空图像数据集,比DOTA拥有更多的类别。除了官方的基线,我们还在表9中给出了最终的检测结果。应该注意的是,我们复现的基线比官方的高。最后,基于FPN和基于RetinaNet的方法分别得到77.80%和75.11%的mAP。表10显示了UCAS-AOD数据集的性能比较。正如我们所看到的,我们的方法在OBB任务中达到了96.95%,是所有已经发布的方法中最好的。

5 结论

我们在特征图中提出了一种实例级去噪技术,以改进检测,特别是对于小的和密集排列的物体,如航空图像。InLD的核心思想是通过不同的通道对不同类别的特征进行解耦,在空间中分别增强和弱化物体和非物体的特征。同时,在平滑L1损失中加入IoU常数因子,解决旋转检测中的边界问题,使旋转估计更加准确。我们在DOTA、DIOR、UCAS-AOD、小交通灯数据集BSTLD和我们发布的S2TLD等多个航空图像数据集上进行了广泛的消融研究和比较实验,证明我们的方法实现了最先进的检测精度。利用自然图像数据集COCO和场景文本数据集ICDAR2015验证了该方法的有效性。