文章目录

1.问题解答

Lasso回归与岭回归都是对线性回归进行正则化。

线性回归的损失函数为:

R S S = J ( w ) = ∑ i = 1 N ( y i − w 0 − ∑ j = 1 p w j x i j ) 2 RSS=J(w) = \sum\limits_{i=1}^{N}(y_i-w_0-\sum\limits_{j=1}^{p}w_jx_{ij})^2 RSS=J(w)=i=1∑N(yi−w0−j=1∑pwjxij)2

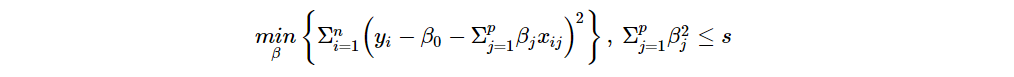

岭回归的损失函数为:

J ( w ) = ∑ i = 1 N ( y i − w 0 − ∑ j = 1 p w j x i j ) 2 + λ ∑ j = 1 p w j 2 = R S S + λ ∑ j = 1 p w j 2 , 其 中 , λ ≥ 0 J(w) = \sum\limits_{i=1}^{N}(y_i-w_0-\sum\limits_{j=1}^{p}w_jx_{ij})^2 + \lambda\sum\limits_{j=1}^{p}w_j^2=RSS+\lambda\sum\limits_{j=1}^{p}w_j^2,\;\;其中,\lambda \ge 0 J(w)=i=1∑N(yi−w0−j=1∑pwjxij)2+λj=1∑pwj2=RSS+λj=1∑pwj2,其中,λ≥0

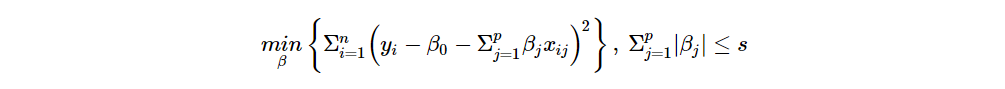

Lasso回归的损失函数为:

J ( w ) = ∑ i = 1 N ( y i − w 0 − ∑ j = 1 p w j x i j ) 2 + λ ∑ j = 1 p ∣ w j ∣ = R S S + λ ∑ j = 1 p ∣ w j ∣ , 其 中 , λ ≥ 0 J(w) = \sum\limits_{i=1}^{N}(y_i-w_0-\sum\limits_{j=1}^{p}w_jx_{ij})^2 + \lambda\sum\limits_{j=1}^{p}|w_j|=RSS+\lambda\sum\limits_{j=1}^{p}|w_j|,\;\;其中,\lambda \ge 0 J(w)=i=1∑N(yi−w0−j=1∑pwjxij)2+λj=1∑p∣wj∣=RSS+λj=1∑p∣wj∣,其中,λ≥0

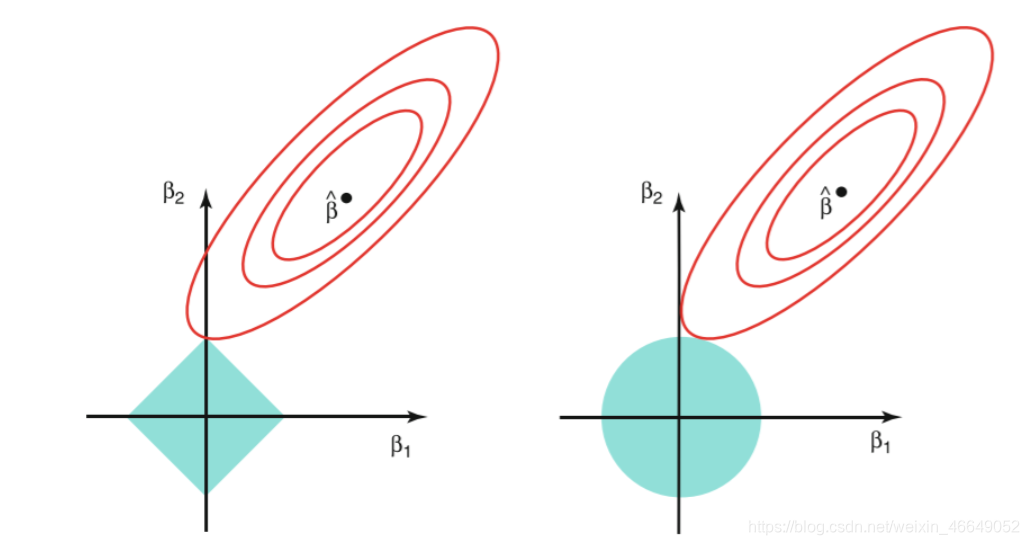

当p=2时,lasso的参数估计是所有满足|β1|+|β2|≤s的β1和β2取值中最小化RSS的。ridge是估计所有满足β21+β22≤s的参数取值中最小化RSS的。从图上来看,

p=3或者其他大于1的数字,改变的只是特征空间

椭圆形曲线为RSS等高线,菱形和圆形区域分别代表了L1和L2约束,Lsaao回归和岭回归都是在约束下的回归,因此最优的参数为椭圆形曲线与菱形和圆形区域相切的点。但是Lasso回归的约束在每个坐标轴上都有拐角,因此当RSS曲线与坐标轴相交时恰好回归系数中的某一个为0,这样就实现了特征提取。反观岭回归的约束是一个圆域,没有尖点,因此与RSS曲线相交的地方一般不会出现在坐标轴上,因此无法让某个特征的系数为0,因此无法做到特征提取。Lsaao回归可以让某些回归系数为0,对应的特征变量就没有被挑选。岭回归只能让回归系数趋近于0但永不为0.虽然可以使损失函数变小,但起不到特征挑选的作用。

从图像上比较好理解,理论上L1正则化实现了参数稀疏,即可使某些回归系数为0.

参考:

为什么Lasso有变量选择作用?