有关两种回归的实现参考:Python实现.

古典回归模型的四个假定

- 线性假定:假定因变量和自变量之间存在线性关系

- 严格外生性——>回归系数无偏且一致

- 无完全多重共线性——>保证参数可估计

- 球型扰动项

岭回归

惩罚函数

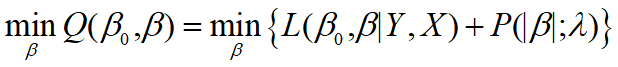

惩罚函数法和最小二乘法或者最大似然估计类似,也是求解优化问题。假设自变量为

∈

,因变量记为

,回归系数记为

,截距项为

。目标函数的一般形式为

其中

是损失函数,不同模型的损失函数形式不同,通常有最小二乘函数、似然函数的负向变换。

第二部分

叫惩罚函数,是惩罚变量选择方法的核心部分。该函数是关于

和

都递增的非负函数,

为调整参数。

平衡式两部分的值数,

越大,目标函数中第二部分所占比重越高,这样不利于

总体达到最小,因此必须压缩

的值以降低

所占比重,实现总目标函数最小化。由此可知当

大到一定程度时,回归系数可能被压缩为0,就出现了变量选择的结果。而当

接近0时,惩罚函数

所占比例很小,估计值会接近于损失函数

的最小解(比如OLS)。

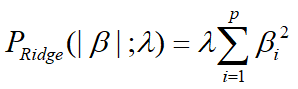

在岭回归中,惩罚函数如下:

λ的选择

岭迹法:

1)各回归系数的岭估计值基本稳定;

2)岭估计值的符号要合理;

VIF(方差膨胀因子)法:

不断增加λ使得所有β的估计值的VIF<10

交叉验证

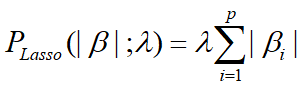

Lasso回归

与岭回归不同的是,Lasso回归在惩罚函数上做了修改,可以将不重要的回归系数压缩为零,岭回归只能压缩至无限接近于0.

总结

我们首先使用最一般的OLS对数据进行回归,然后计算方差膨胀因子

VIF,如果VIF>10则说明存在多重共线性的问题,此时我们需要对变量进

行筛选。

在第七讲时我们提到可以使用逐步回归法来筛选自变量,让回归中仅

留下显著的自变量来抵消多重共线性的影响,学完本讲后,大家完全可以

把lasso回归视为逐步回归法的进阶版,我们可以使用lasso回归来帮我们筛

选出不重要的变量,步骤如下:

(1)判断自变量的量纲是否一样,如果不一样则首先进行标准化的预处理;

(2)对变量使用lasso回归,记录下lasso回归结果表中回归系数不为0的变量,这些变量就是最终我们要留下来的重要变量,其余未出现在表中的变量可视为引起多重共线性的不重要变量。在得到了重要变量后,我们实际上就完成了变量筛选,此时我们只将这些重要变量视为自变量,然后进行回归,并分析回归结果即可。(注意:此时的变量可以是标准化前的,也可以是标准化后的,因为lasso只起到变量筛选的目的)