Lecture 7:the VC Dimension VC维

7-1 VC维定义

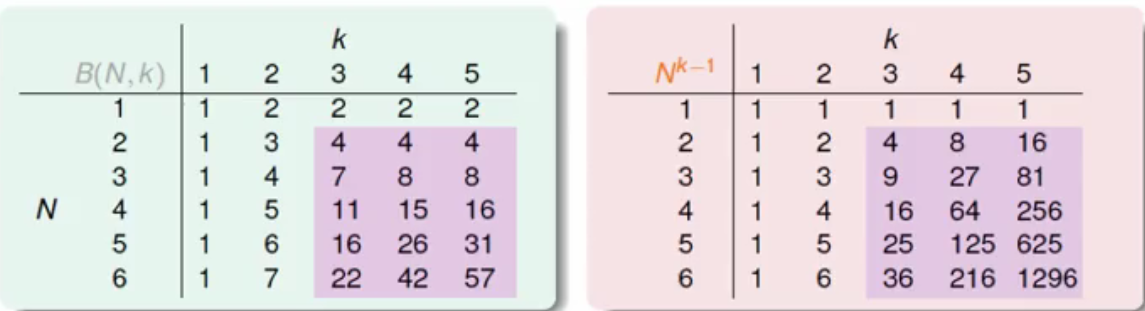

衔接第6课,当N和K都不算小的时候,可以得到:

成长函数m会比N^(k-1)小。

其中6-4的式子取等号的时候,是当成长函数的上限直接取为N^(k-1)时。

那VC维是什么呢?

是上节课所说的没有达到break point时的最大情况。

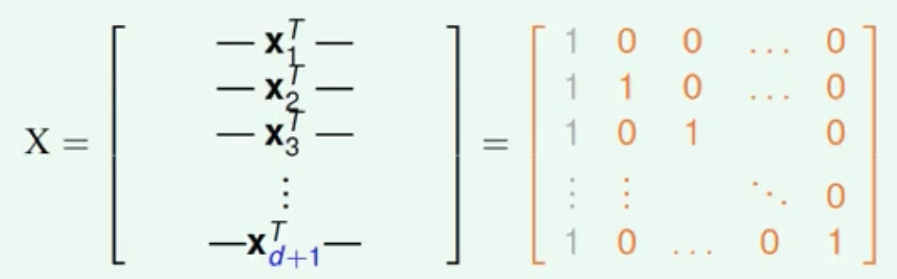

这是什么意思?在VC维时,假说可以shatter掉某N个点,当超过VC维后,就达到了break point。

当minimum break point不存在时,我们就可以说此时的VC维无限大。

所以:

当N比VC维小时,有可能被shatter;

当N比VC维大时,一定不可能被shatter。

所以VC维值=k-1 当m=N^a,则VC维此时很大可能值为a,因为成长函数的上限取做N^(k-1)

什么是好的假说?答:有有限VC维的假说。此时,Ein和Eout是接近的,而且和算法A无关,和data的分布P无关,和目标函数f也无关。

7-2 Perceptrons(感知器)的VC维

当线性可分时——>可用PLA(多轮迭代后,Ein=0);

而7-1告诉我们,在有限的VC维和足够大的数据量时,Ein和Eout是接近的;

通过以上两点,可以得出:Eout约为0。

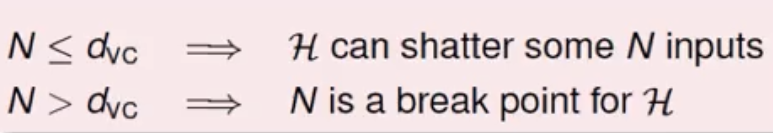

那么当多维data的情况呢?

1D:dVC(dimension)=2 2D:dVC=3,那么推断dVC>=d+1或是<=d+1呢?

这里是通过矩阵的证明,用的是这样的矩阵:

证明过程不贴了,还蛮有意思的......圈圈叉叉。

最终可以证明dVC<=d+1。

7-3 VC维的物理描述

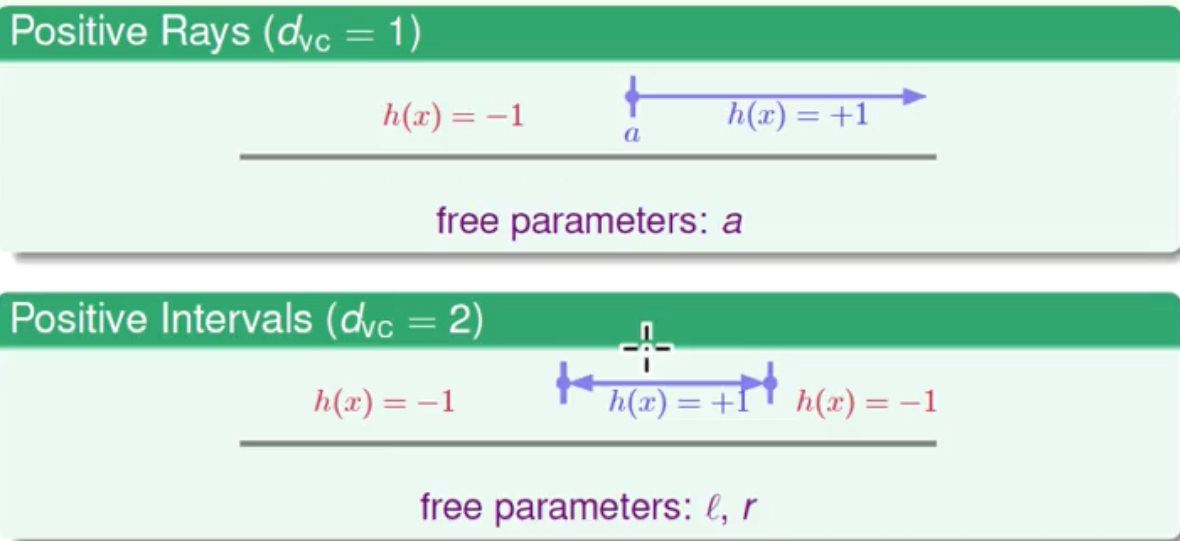

VC dimension 中的dimension是怎么解释的呢?7-2说了,dVC<=d+1,这个值刚好是感知器的维度,所以这两个概念产生了联系。

物理意义:二元分类时有多少的自由度。(有多少个可以调的旋钮)

比如上图,Positive Rays有一个可以左右移动的旋钮,Positive Intervals有两个可以左右移动的旋钮。旋钮的比喻不总是对的,但大部分的情况下可以用它来判断。

回到第五课,我们想要1.Ein和Eout接近 2.Ein足够小,当时的衡量标准是想得到一个小的2*M*exp()中的M。

当我们有了dVC这个工具后,我们可以用(2N)^dVC替代M

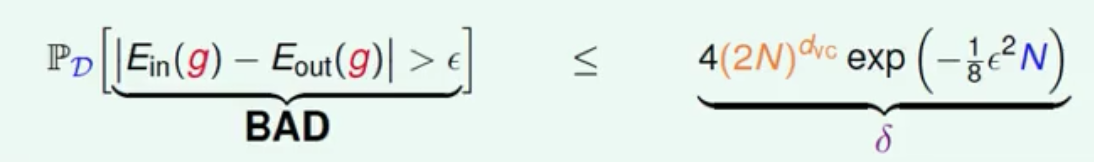

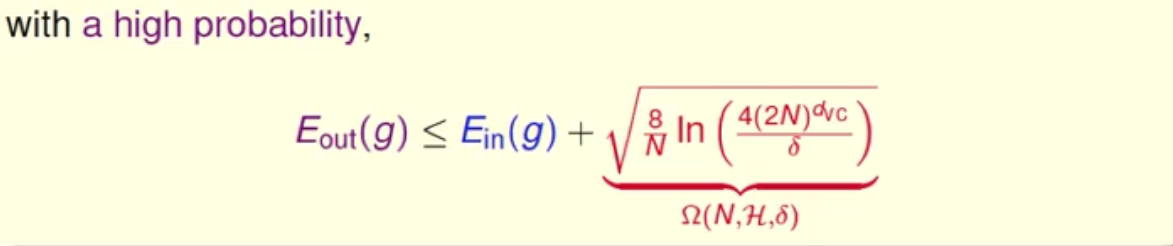

更改之后的VC bound的公式:

整理公式之后可得:

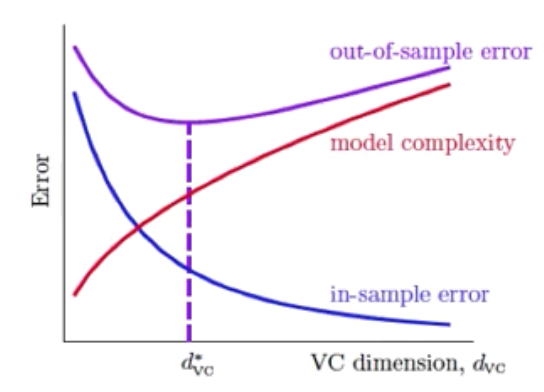

画出的图为:

想让Eout越小越好,所以并不是花所有精力让Ein越小越好,而是应当选择一个合适的dVC。

在实际运用中,通常10倍的dVC的数据就够用了。

这时是比较宽松的条件,怎么宽松?

答:用Hoeffding代替未知的Eout(任何分布和目标),用成长函数代替H(任何数据),用N^dVC代替成长函数,使用union bound。