在https://blog.csdn.net/qq_42871249/article/details/105044174介绍了RNN,这里继续介绍LSTM网络。

背景介绍

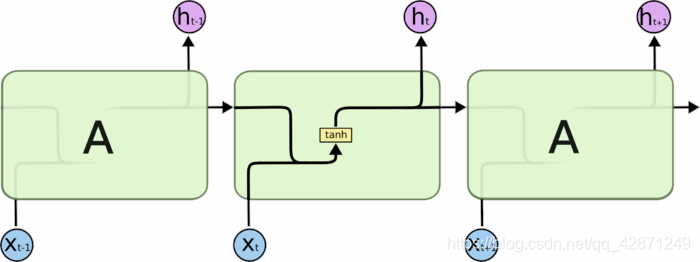

先回忆一下RNN循环神经网络

RNN 的关键点之一就是他们可以用来连接先前的信息到当前的任务上,例如使用过去的视频段来推测对当前段的理解。但是当相关信息和当前预测位置之间的间隔变得非常大,RNN 会丧失学习到连接如此远的信息的能力。我们仅仅需要明白的是利用BPTT算法训练出来的普通循环神经网络很难学习长期依赖(例如,距离很远的两步之间的依赖),原因就在于梯度消失/发散问题。但是RNN 绝对可以处理这样的长期依赖问题,人们可以仔细挑选参数来解决这类问题中的最初级形式,但在实践中,RNN 肯定不能够成功学习到这些知识。训练和参数设计十分复杂。LSTM就是专门设计出来解决这个问题的。

LSTM网络

https://blog.csdn.net/weixin_44162104/article/details/88660003这篇讲的比较细致

https://www.cnblogs.com/zuotongbin/p/10698843.html这篇更加浅显易懂

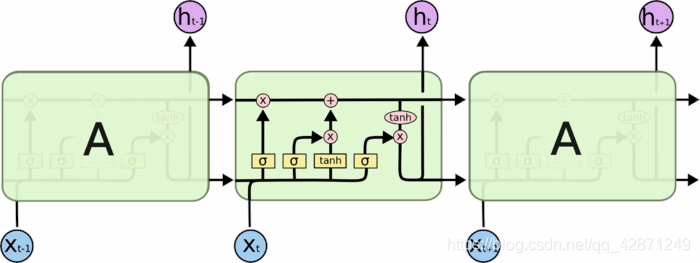

结构+三个门的介绍

总结

跟RNN相比,LSTM多了一个表示cell记忆的值。也就是我们不仅要更新当前cell的输出,我们还要思考,哪些东西可以记在我们的cell里呢,记忆的话,记多少又如何确定呢?既然有了记忆,那么我们的输入不仅仅有上一时刻的输出,此刻的输入,还有cell本身存储的那部分信息。所以LSTM的构造看起来很复杂,其实是围绕着记忆做操作的。

这部分就是: