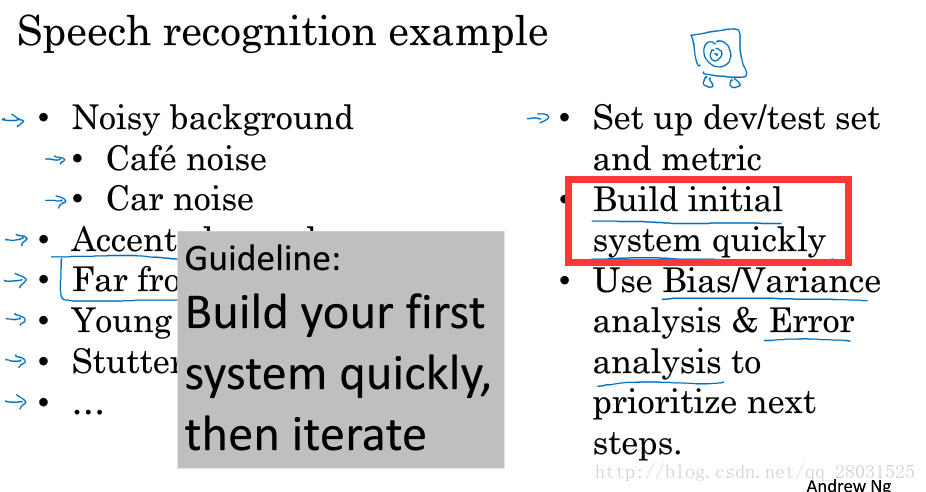

误差分析

观察错误标记的例子,统计数量,并归纳出产生误差的类型,针对不同类型的问题和优先级进行分别处理。

Incorrectly labeled examples. DL algorithm are quite robust to random errors in the training set.

深度学习对于训练集中随机误差具有较好的鲁棒性,但是不包括系统性的错误等。

首先搭建自己的系统,分析偏差和方差,然后进行人工分析并指定优化的方向,更迭系统。

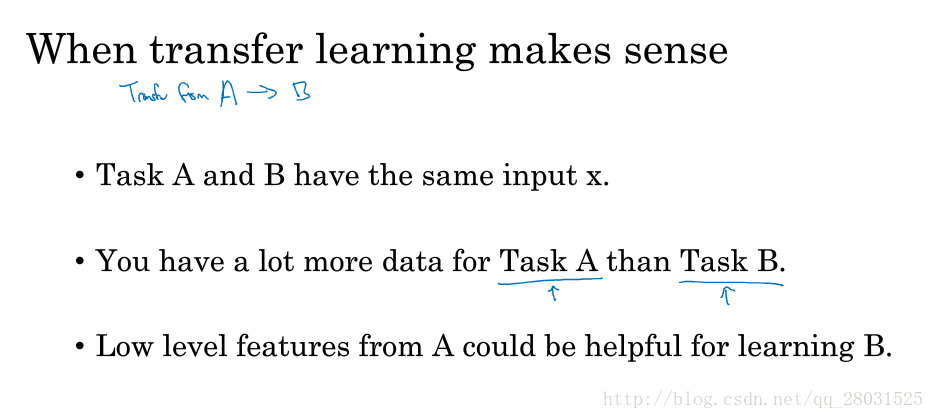

迁移学习

神经网络可以从一个任务中习得知识,并将这些知识应用到另一个独立的任务中(串行学习过程)。特别针对于当迁移目标问题的数据量较少时,利用拥有较大数据量的相似问题预训练的结果改善迁移目标问题的表现。

迁移学习的应用场景(从任务A迁移到任务B,迁移问题A有许多数据,而迁移目标问题B没有那么多数据):

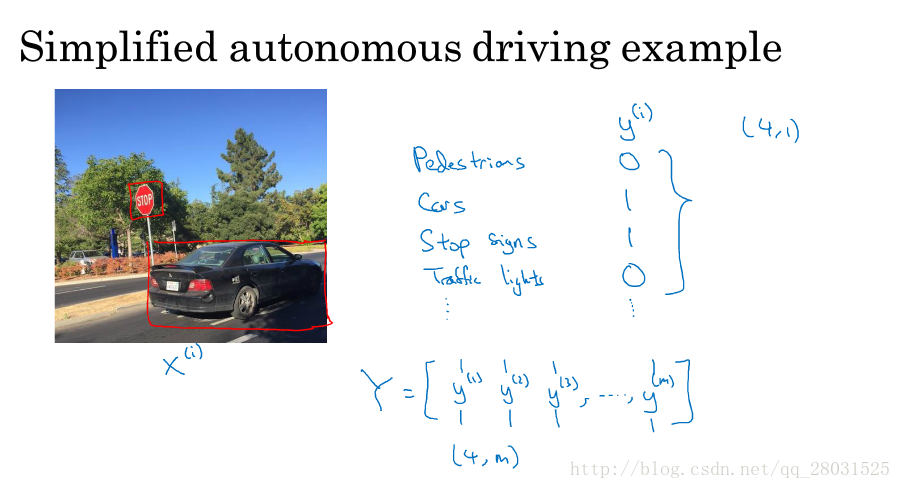

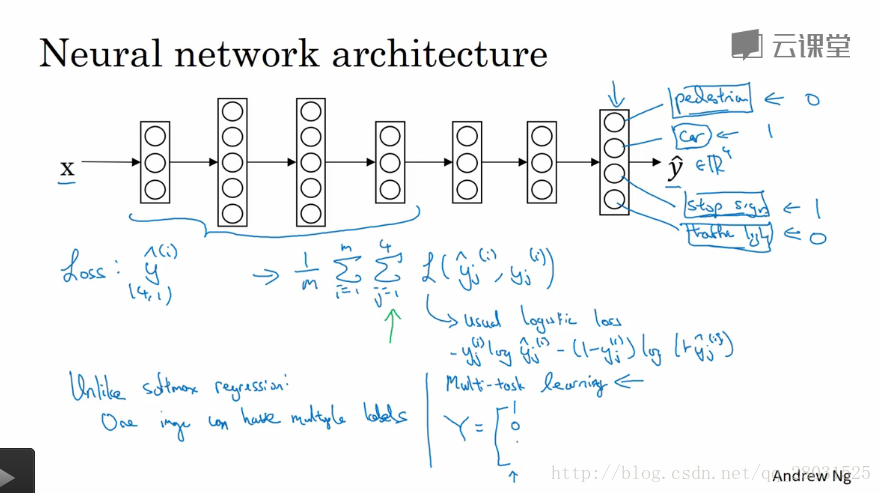

多任务学习

迁移学习中,学习的过程是串行的过程,而多任务学习则是并行学习的过程,训练一个神经网络同时处理多个任务(如分类中样本有多个标签)。在实际应用中,多任务学习使用的情况要远比迁移学习少,因为很难找到很多相似且数据量对等的任务来进行多任务学习,但是在计算机视觉中,多任务学习的效果要比迁移学习好。

多任务学习也可以处理样本只有部分被标记的情况,在训练算法的时候可以只对其中有标签的数据进行计算,计算损失函数的时候只对带标签的数据进行求和,对于没有标签的数据就忽略了。

与softmax的区别

- softmax中每个标签分配给单个样本,而多任务学习中的样本有多个标签,如在上图中的场景中,图片中有“停用牌”、“汽车”,没有“交通灯”。

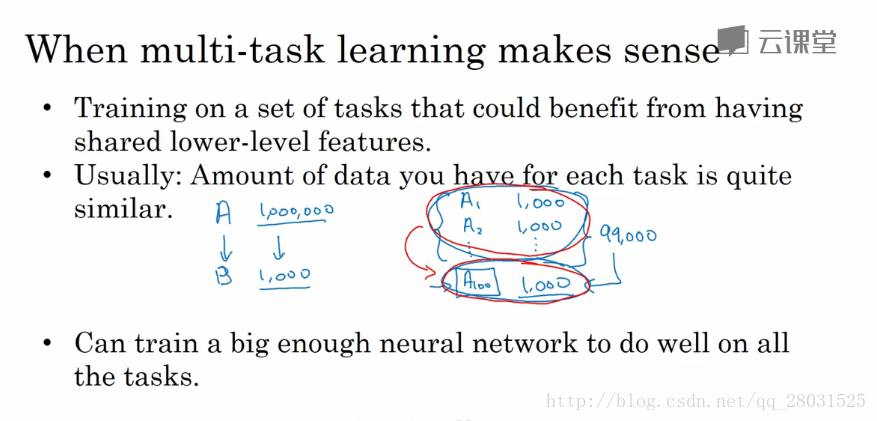

多任务学习的应用场景

- 可以共用底层次的特征,如无人驾驶中,同时识别出汽车、行人和交通灯都是可行的,因为他们具有类似的特征;

- (经验)对于任务而言,由于数据量不大且相似,因此利用其他任务的数据可以增强任务的效果;

- 一般而言,神经网络足够大时,多任务的效果要比单个任务的表现好。