前言

本文用了两个目前多目标跟踪领域最常用的信息:iou信息以及reid外观特征。在此基础上,又引入了一个潜在的可能引起身份转换的遮挡目标switcher来参与亲和计算,从而提高了模型对于身份转换的鲁棒性。

贡献

- 提出了一个有效的多目标跟踪框架,学习捕获长期和短期线索,并做出自适应决策,进行鲁棒跟踪。

- 提出了一个具有switcher感知的分类器,在数据关联时,提升了对于身份转换的多目标跟踪鲁棒性。

跟踪流程

- 初始化跟踪列表以及视频帧数

t=0。

- 在

t帧时,对于目标

X,利用单目标跟踪器子网络寻找目标

X的模板

EX在下一帧

It+1的位置。单目标跟踪子网络输出

EX在

It+1最有可能的位置

Dtrack。

- 对于在

It+1帧的检测结果

Ddet,它对应的检测图像区域

It+1,Ddet以及目标的历史图像区域{

ItiX},

i=1,2,3,...,K被输入到ReID网络中获取长期ReID特征。

- 目标的预测位置

Dtrack、检测结果

Ddet以及步骤3中的长期特征被结合为目标的匹配特征。

- 找到目标的潜在switcher,既可能会引起目标发生身份转换的另一个目标,获取他在当前帧的预测位置以及历史ReID特征,并结合为匹配特征。

- 一个switcher感知的分类器利用switcher和目标的匹配特征生成目标和检测之间的匹配分数,标志着这个检测结果是否应该与跟踪目标相匹配。对

It+1帧的所有检测都进行上述步骤,计算出其与目标之间的匹配分数。更换目标,计算出所有检测和跟踪之间的匹配分数。

- 利用目标和检测之间的匹配分数建立一个二部图,使用最小成本网络流算法找到匹配结果。

- 对于匹配的目标,利用匹配的检测更新其跟踪位置。对于未匹配的目标,利用预测结果更新其位置。终止掉那些被认为是丢失或者被遮挡的目标跟踪。对于独立的检测如果其置信分数满足新跟踪的条件,则将其添加到跟踪列表中。

- 对每一帧重复步骤2-步骤8。

短期线索

如图所示:

- 跟踪预测采用SiamRPN单目标跟踪器实现。

- 当前帧目标

X的模板

EX,调整尺寸为

127×127。

- 根据目标

X的位置,从

It+1帧上裁取搜索区域的图像,将其尺寸调整为

255×255,其缩放尺度与模板

EX的缩放尺度相同。

- 模板和搜索区域图像分别输入到一个共享权重的CNN网络中,得到CNN特征。将得到的CNN特征输入两个分支,一个分支生成锚点图的得分映射,一个分支生成锚点的边界框回归。

- 模板

EX的位置是搜索区域的得分映射中具有最高得分的位置

Dtrack。

- 对于检测的边界框位置

Ddet,用以下公式计算短期特征:

fs(Dtrack,Ddet)=IoU(Dtrack,Ddet)

- 对于目标

X,跟踪质量

qX如下计算:

qX,t+1=⎩⎨⎧2qX,t+IoU(Dtrack,Ddet).pqX,t.decay.pk,ifmatched,otherwise其中

decay,k是超参数。如果目标跟踪的

qX低于阈值,则终止掉该不可靠跟踪。

长期线索

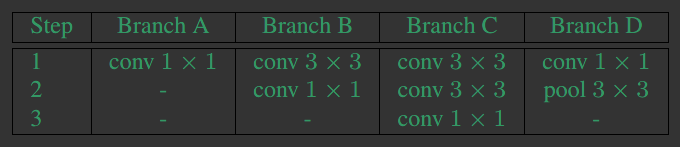

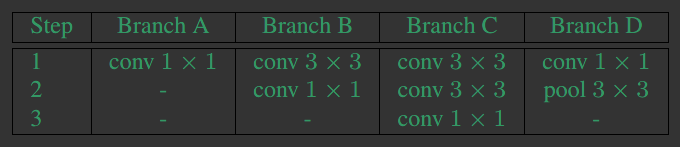

- 使用一个结构如图的GoogLeNet inception-V4的修改版本作为ReID子网络的backbone。ReID特征由分类之前的FC层获取。

- 使用下面的公式获取目标

X的

K帧历史图像:

ti=t−iδ<t

<t−(i−1)δargminQ(It

X,i=1,2,3,...,K)其中

Q是一个由Resnet-18实现的输出的质量分数的网络。

δ是一个决定选择时间间隔的超参数。

- 将所选择的目标历史图像和检测输入到ReID网络中得到他们的ReID特征,利用得到的检测特征按照如下公式得到目标与检测的

K个长期特征:

FlX={fl(AtiXAdet)∣i=1,...,K}

其中

fl(AtiXAdet)=∣AtiX∣∣Adet∣AtiXT.Adet

AtiX是值在

t帧得到的目标

X的第

i个历史图像的ReID特征,

Adet是被匹配的检测提取的ReID特征。

switcher感知的分类器

- 通过以下公式找到当前目标

X的潜在switcher:

Λ=Y∈S s.t.Y=XargmaxIoU(Xt,Yt)其中

S为目标集合

- 将

SOT和ReID子网络作为一个特征提取操作

ϕ,将这两个子网络的输入,既目标

X和检测结果

D表示为

ΓX,D,则得到的检测

D对于目标

X的匹配特征为:

ϕ(ΓX,D)={fs(Dtrack,Ddet)}∪FlX 其中

ϕ(ΓX,T)的维度为

K+1,switcher与检测

D之间的匹配特征为

ϕ(ΓΛ,D)也是如此计算。然后将switcher以及目标

X对于检测

D的匹配特征拼接起来作为分类器的输入。

- 采用正则化牛顿增强决策树作为分类器。分类步骤时,由分类器得到输出

y,如果大于阈值

ζm,则将对应的边赋值

1−y添加二部图中。

个人感悟

这篇文章最大的创新就是在计算亲和力时引入了一个switcher来增强模型对于遮挡的鲁棒性,有效减少了IDS的数量。其次,采用跟踪全局质量分数决定目标跟踪的终止,相比直接在连续

N帧的丢失后把跟踪终止,考虑到了每个丢失跟踪的丢失程度,更准确的选择该终止的跟踪,一定程度上抑制了IDS和FP。然后,采用一个质量过滤器选择目标的历史图像,相比在前

N中的固定帧数选择历史图像,能够得到与目标更相似的外观特征。

作者在MOT16和MOT17上评估了模型,都取得了SOTA的结果。可惜就是没开源,看不到具体的实现。