Word embeding

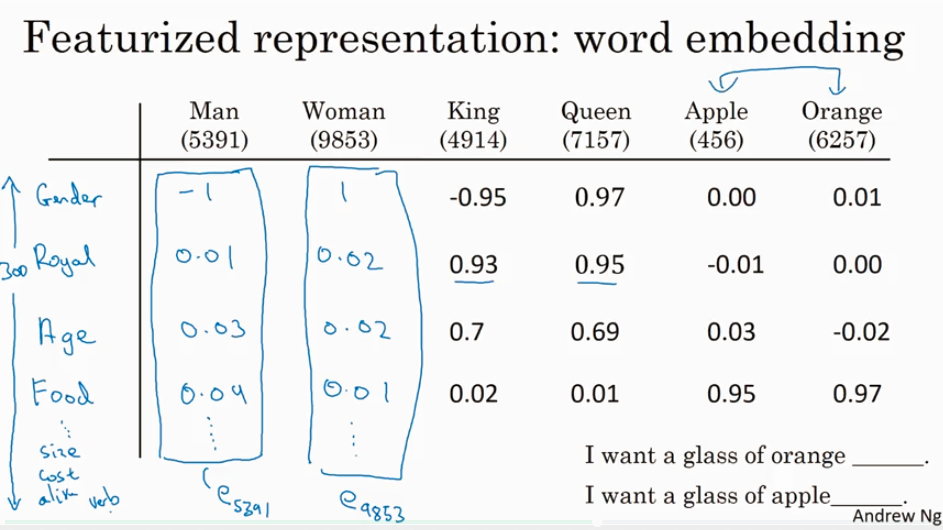

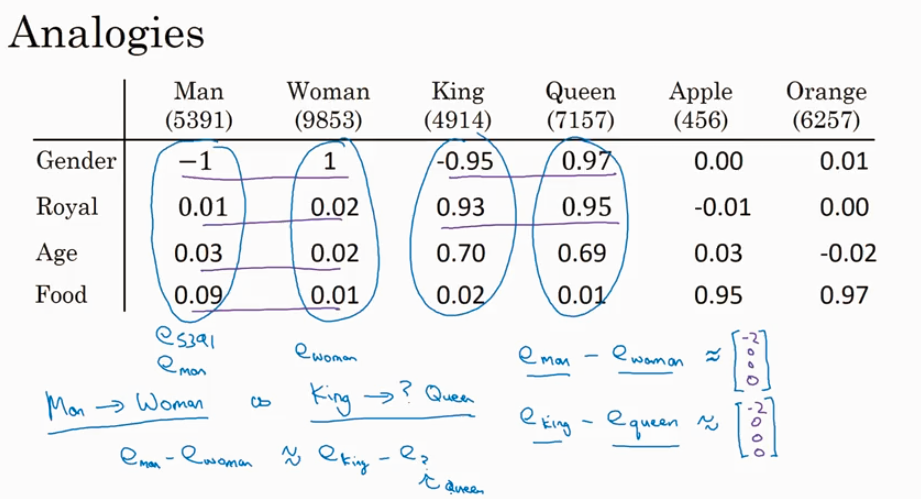

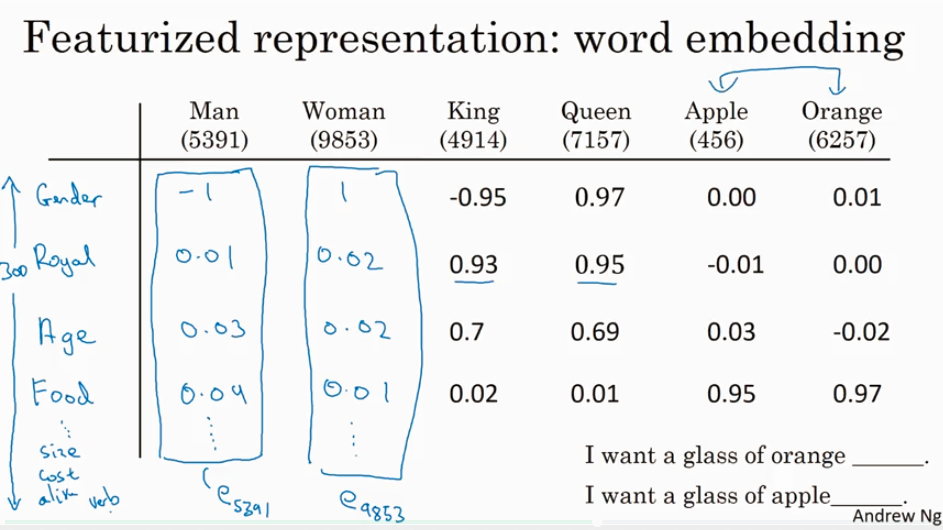

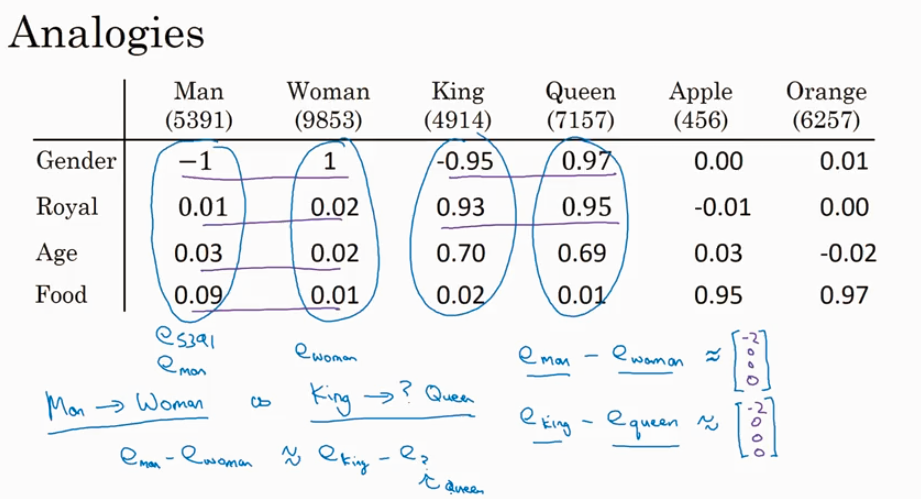

给word 加feature,用来区分word 之间的不同,或者识别word之间的相似性.

因为t-SNE 做了non-liner 的转化,所以在原来的3000维空间的平行的向量在转化过后的2D空间里基本上不会再平行.

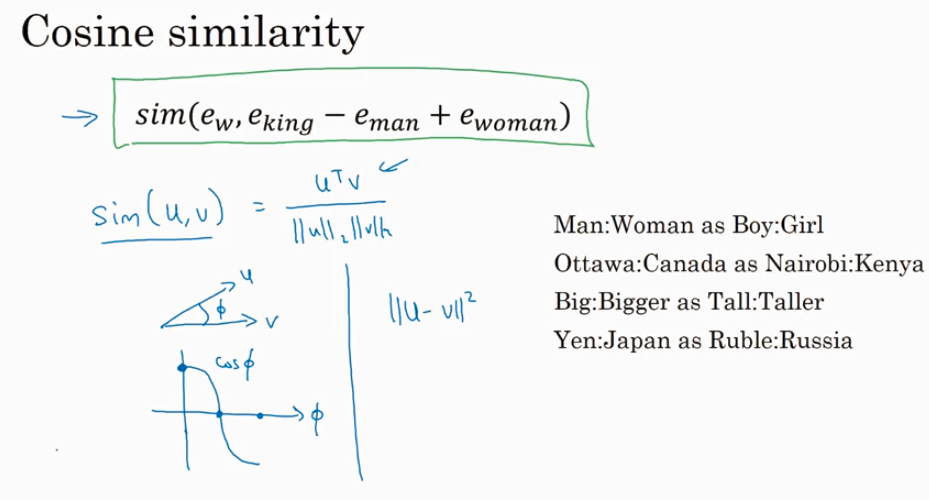

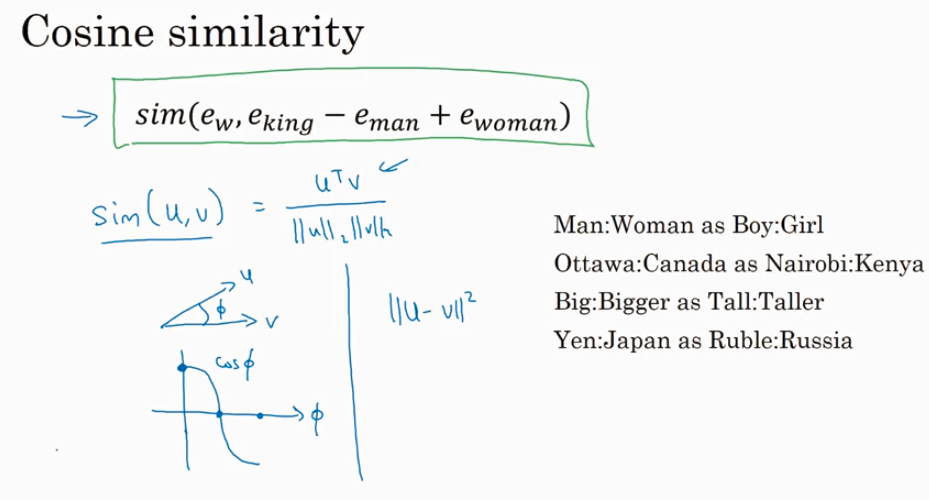

看两个向量的相似性,可以用cosine similarity.

给word 加feature,用来区分word 之间的不同,或者识别word之间的相似性.

因为t-SNE 做了non-liner 的转化,所以在原来的3000维空间的平行的向量在转化过后的2D空间里基本上不会再平行.

看两个向量的相似性,可以用cosine similarity.