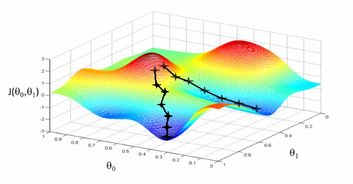

梯度下降是迭代法的一种,可以用于求解最小二乘问题(线性和非线性都可以)。在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降(Gradient Descent)是最常采用的方法之一,另一种常用的方法是最小二乘法。在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。反过来,如果我们需要求解损失函数的最大值,这时就需要用梯度上升法来迭代了。在机器学习中,基于基本的梯度下降法发展了两种梯度下降方法,分别为随机梯度下降法和批量梯度下降法。

程序化实现梯度下降法:

import random

import matplotlib.pyplot as plt

_xs=list(range(1,11))

_ys=[5*x+3 for x in _xs]

w=random.random()

b=random.random()

for _ in range(100):

for x, y in zip(_xs, _ys):

o = w * x + b

e = (o - y)

loss = e ** 2

dw = -2 * e * x

db = -2 * e

w = w + 0.01 * dw

b = b + 0.01 * db

print(w, b)

plt.scatter(_xs, _ys, c="red")

plt.plot(_xs, _ys)

plt.show()

运行结果:

转载或引用请注明来源!