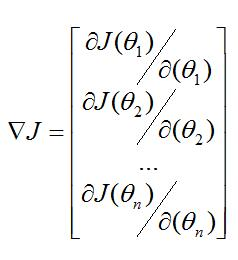

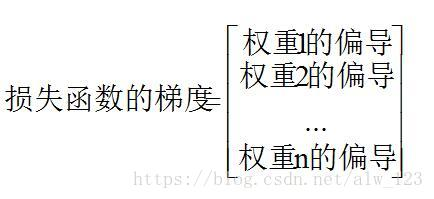

1. 梯度:对于一元函数,梯度是导数/斜率;对于多元函数,梯度是由偏导数组成的向量

梯度的方向:是函数在给定点上升最快的方向

梯度的反方向:是函数在给定点下降最快的方向

多元函数的梯度:(偏导)

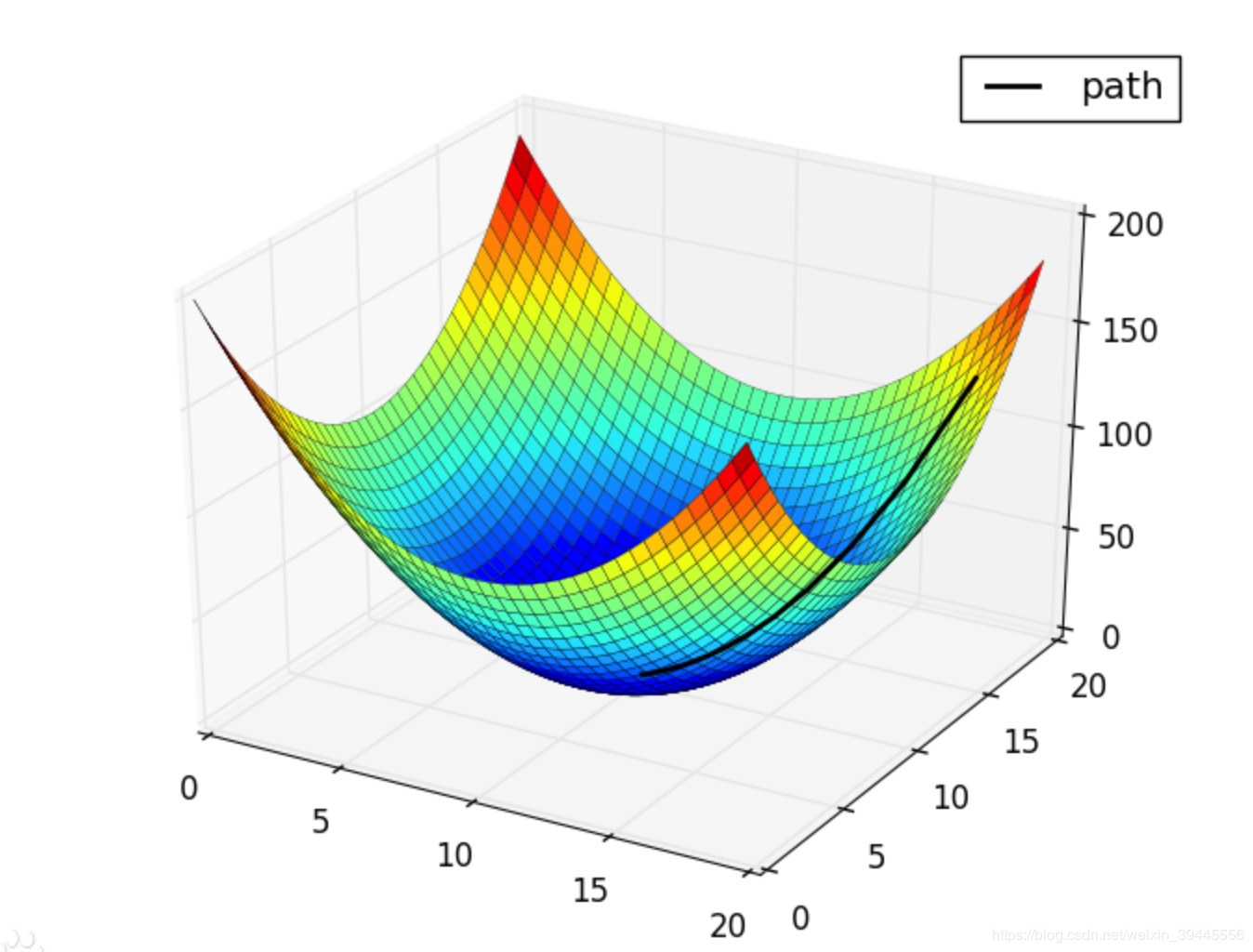

2. 梯度下降:函数在某一点处沿着梯度的反方向逐步迭代,求出函数的局部最小值的过程。我们的最终目的是找到最小值点x(参数),而非最小值(函数值)。

通过梯度下降,一直寻找损失函数的局部最小值,最后得到一个最小值点。无论采取哪一种损失函数,损失函数都与

真实标签Y和其他标签Y_ j的分数有关,而分数都与函数f(W, b , xi)有关,因此而权值矩阵W是损失函数的影响因素之一。而梯度下降就是为了寻找损失函数最小值所对应的权

值矩阵W,就是要找到使得损失值最小的权值矩阵W。也就是,我们想知道参数W取何值时,损失值才能最小。梯度下降是让梯度中所有偏导函数都下降到最低点的过程。

在求解损失函数的最小值时,可以通过梯度下降法来一步步的迭代求解,得到最小化的损失函数和模型参数值。

梯度下降:逐步迭代,寻找最小值点的过程

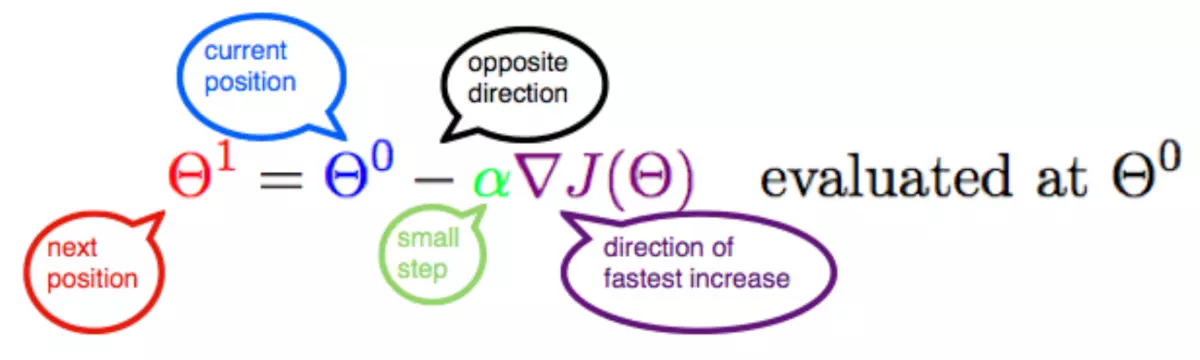

3. 梯度下降法的公式:

![]()

参数:下一个位置点、当前位置点、学习率(步长)、函数

为什么用负号?因为是梯度下降,沿着梯度的反方向进行的