• Task06:批量归一化和残差网络;凸优化;梯度下降

批量归一化

批量归一化是优化深度神经网络常用地有效手段,可以加快了深度模型的训练时间;利用小批量上的均值和标准差,不断调整神经网络中间输出,从而使整个神经网络在各层的中间输出的数值更稳定。如果所有层都批量归一化处理会增加模型地开销,我们可以根据需要灵活选择对某一部分进行处理如下:

1.对全连接层做批量归一化

位置:全连接层中的仿射变换和激活函数之间。

全连接:

批量归一化:

这⾥ϵ > 0是个很小的常数,保证分母大于0

引入可学习参数:拉伸参数γ和偏移参数β。若 和 ,批量归一化无效。

2.对卷积层做批量归⼀化

位置:卷积计算之后、应⽤激活函数之前。

如果卷积计算输出多个通道,我们需要对这些通道的输出分别做批量归一化,且每个通道都拥有独立的拉伸和偏移参数。

计算:对单通道,batchsize=m,卷积计算输出=pxq

对该通道中m×p×q个元素同时做批量归一化,使用相同的均值和方差。

3.预测时的批量归⼀化

训练:以batch为单位,对每个batch计算均值和方差。

预测:用移动平均估算整个训练数据集的样本均值和方差。

残差网络(ResNet)

深度CNN网络达到一定深度后再一味地增加层数并不能带来进一步地分类性能提高,反而会招致网络收敛变得更慢,准确率也变得更差。

残差块(Residual Block)

恒等映射:

左边:f(x)=x

右边:f(x)-x=0 (易于捕捉恒等映射的细微波动)

在残差块中,输⼊可通过跨层的数据线路更快 地向前传播。

ResNet模型

卷积(64,7x7,3)

批量一体化

最大池化(3x3,2)

残差块x4 (通过步幅为2的残差块在每个模块之间减小高和宽)

全局平均池化

全连接

凸优化

凸优化一般是指目标函数为凸函数且由约束条件得到的域为凸集的优化问题。

深度学习目标:测试集损失函数值(泛化性)

优化方法目标:训练集损失函数值

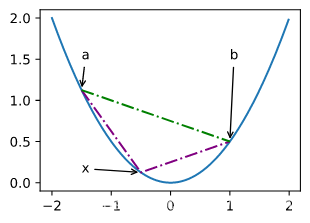

凸函数与二阶导数

是凸函数

必要性 ( ):

对于凸函数:

故:

充分性 ( ):

令 为 上的三个点,由拉格朗日中值定理:

根据单调性,有 , 故:

def f(x):

return 0.5 * x**2

x = np.arange(-2, 2, 0.01)

axb, ab = np.array([-1.5, -0.5, 1]), np.array([-1.5, 1])

d2l.set_figsize((3.5, 2.5))

fig_x, = d2l.plt.plot(x, f(x))

fig_axb, = d2l.plt.plot(axb, f(axb), ‘-.’,color=“purple”)

fig_ab, = d2l.plt.plot(ab, f(ab),‘g-.’)

fig_x.axes.annotate(‘a’, (-1.5, f(-1.5)), (-1.5, 1.5),arrowprops=dict(arrowstyle=’->’))

fig_x.axes.annotate(‘b’, (1, f(1)), (1, 1.5),arrowprops=dict(arrowstyle=’->’))

fig_x.axes.annotate(‘x’, (-0.5, f(-0.5)), (-1.5, f(-0.5)),arrowprops=dict(arrowstyle=’->’))

梯度下降

梯度下降、随机梯度下降和小批量梯度下降的原理及实现。

随机梯度下降

对于有 个样本对训练数据集,设 是第 个样本的损失函数, 则目标函数为:

其梯度为:

使用该梯度的一次更新的时间复杂度为

随机梯度下降更新公式 :

且有:

小批量随机梯度下降

def get_data_ch7(): # 本函数已保存在d2lzh_pytorch包中方便以后使用

data = np.genfromtxt(’/home/kesci/input/airfoil4755/airfoil_self_noise.dat’, delimiter=’\t’)

data = (data - data.mean(axis=0)) / data.std(axis=0) # 标准化

return torch.tensor(data[:1500, :-1], dtype=torch.float32),

torch.tensor(data[:1500, -1], dtype=torch.float32) # 前1500个样本(每个样本5个特征)

features, labels = get_data_ch7()

features.shape

import pandas as pd

df = pd.read_csv(’/home/kesci/input/airfoil4755/airfoil_self_noise.dat’, delimiter=’\t’, header=None)

df.head()

0 1 2 3 4 5

0 800 0.0 0.3048 71.3 0.002663 126.201

1 1000 0.0 0.3048 71.3 0.002663 125.201

2 1250 0.0 0.3048 71.3 0.002663 125.951

3 1600 0.0 0.3048 71.3 0.002663 127.591

4 2000 0.0 0.3048 71.3 0.002663 127.461

5 2500 0.0 0.3048 71.3 0.002663 125.571

6 3150 0.0 0.3048 71.3 0.002663 125.201

7 4000 0.0 0.3048 71.3 0.002663 123.061

8 5000 0.0 0.3048 71.3 0.002663 121.301

9 6300 0.0 0.3048 71.3 0.002663 119.541

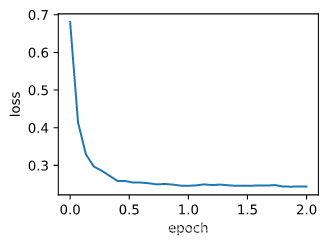

optimizer_fn=torch.optim.SGD, optimizer_hyperparams={“lr”: 0.05}

def train_pytorch_ch7(optimizer_fn, optimizer_hyperparams, features, labels,

batch_size=10, num_epochs=2):

# 初始化模型

net = nn.Sequential(

nn.Linear(features.shape[-1], 1)

)

loss = nn.MSELoss()

optimizer = optimizer_fn(net.parameters(), **optimizer_hyperparams)

def eval_loss():

return loss(net(features).view(-1), labels).item() / 2

ls = [eval_loss()]

data_iter = torch.utils.data.DataLoader(

torch.utils.data.TensorDataset(features, labels), batch_size, shuffle=True)

for _ in range(num_epochs):

start = time.time()

for batch_i, (X, y) in enumerate(data_iter):

# 除以2是为了和train_ch7保持一致, 因为squared_loss中除了2

l = loss(net(X).view(-1), y) / 2

optimizer.zero_grad()

l.backward()

optimizer.step()

if (batch_i + 1) * batch_size % 100 == 0:

ls.append(eval_loss())

# 打印结果和作图

print('loss: %f, %f sec per epoch' % (ls[-1], time.time() - start))

d2l.set_figsize()

d2l.plt.plot(np.linspace(0, num_epochs, len(ls)), ls)

d2l.plt.xlabel('epoch')

d2l.plt.ylabel('loss')

train_pytorch_ch7(optim.SGD, {“lr”: 0.05}, features, labels, 10)