Task09 目标检测基础;图像风格迁移;图像分类案例1、2

目标检测基础

目标检测也叫目标提取,是一种基于目标几何和统计特征的图像分割,它将目标的分割和识别合二为一,其准确性和实时性是整个系统的一项重要能力。

锚框、边界框

小结

以每个像素为中心,生成多个大小和宽高比不同的锚框。

交并比是两个边界框相交面积与相并面积之比。

在训练集中,为每个锚框标注两类标签:一是锚框所含目标的类别;二是真实边界框相对锚框的偏移量。

预测时,可以使用非极大值抑制来移除相似的预测边界框,从而令结果简洁。

图像风格迁移

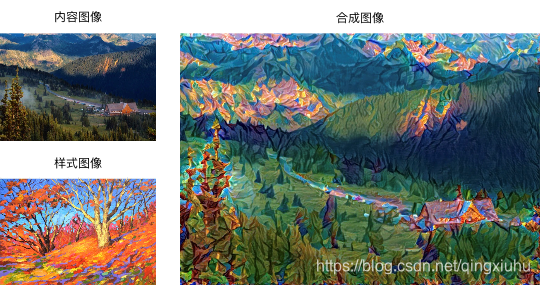

如何使用卷积神经网络自动将某图像中的样式应用在另一图像之上,即样式迁移(style transfer)[1]。这里我们需要两张输入图像,一张是内容图像,另一张是样式图像,我们将使用神经网络修改内容图像使其在样式上接近样式图像。图9.12中的内容图像为本书作者在西雅图郊区的雷尼尔山国家公园(Mount Rainier National Park)拍摄的风景照,而样式图像则是一副主题为秋天橡树的油画。最终输出的合成图像在保留了内容图像中物体主体形状的情况下应用了样式图像的油画笔触,同时也让整体颜色更加鲜艳。

[1] Gatys, L. A., Ecker, A. S., & Bethge, M. (2016). Image style transfer using convolutional neural networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 2414-2423).

方法

下图用一个例子来阐述基于卷积神经网络的样式迁移方法。首先,我们初始化合成图像,例如将其初始化成内容图像。该合成图像是样式迁移过程中唯一需要更新的变量,即样式迁移所需迭代的模型参数。然后,我们选择一个预训练的卷积神经网络来抽取图像的特征,其中的模型参数在训练中无须更新。深度卷积神经网络凭借多个层逐级抽取图像的特征。我们可以选择其中某些层的输出作为内容特征或样式特征。以图9.13为例,这里选取的预训练的神经网络含有3个卷积层,其中第二层输出图像的内容特征,而第一层和第三层的输出被作为图像的样式特征。接下来,我们通过正向传播(实线箭头方向)计算样式迁移的损失函数,并通过反向传播(虚线箭头方向)迭代模型参数,即不断更新合成图像。样式迁移常用的损失函数由3部分组成:内容损失(content loss)使合成图像与内容图像在内容特征上接近,样式损失(style loss)令合成图像与样式图像在样式特征上接近,而总变差损失(total variation loss)则有助于减少合成图像中的噪点。最后,当模型训练结束时,我们输出样式迁移的模型参数,即得到最终的合成图像。

图像分类案例1

图像分类中有几个部分对我有启发,比如图像增强可以增加更多样本,

图像增强

transform_train = transforms.Compose([

# 随机对图像裁剪出面积为原图像面积0.081倍、且高和宽之比在3/44/3的图像,再放缩为高和宽均为224像素的新图像

transforms.RandomResizedCrop(224, scale=(0.08, 1.0),

ratio=(3.0/4.0, 4.0/3.0)),

# 以0.5的概率随机水平翻转

transforms.RandomHorizontalFlip(),

# 随机更改亮度、对比度和饱和度

transforms.ColorJitter(brightness=0.4, contrast=0.4, saturation=0.4),

transforms.ToTensor(),

# 对各个通道做标准化,(0.485, 0.456, 0.406)和(0.229, 0.224, 0.225)是在ImageNet上计算得的各通道均值与方差

transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225]) # ImageNet上的均值和方差

])

#在测试集上的图像增强只做确定性的操作

transform_test = transforms.Compose([

transforms.Resize(256),

# 将图像中央的高和宽均为224的正方形区域裁剪出来

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])

定义模型

使用与训练的ResNet-34模型,直接复用预训练模型在输出层的输入,即抽取的特征,然后我们重新定义输出层,本次我们仅对重定义的输出层的参数进行训练,而对于用于抽取特征的部分,我们保留预训练模型的参数。

def get_net(device):

finetune_net = models.resnet34(pretrained=False) # 预训练的resnet34网络

finetune_net.load_state_dict(torch.load(’/home/kesci/input/resnet347742/resnet34-333f7ec4.pth’))

for param in finetune_net.parameters(): # 冻结参数

param.requires_grad = False

# 原finetune_net.fc是一个输入单元数为512,输出单元数为1000的全连接层

# 替换掉原finetune_net.fc,新finetuen_net.fc中的模型参数会记录梯度

finetune_net.fc = nn.Sequential(

nn.Linear(in_features=512, out_features=256),

nn.ReLU(),

nn.Linear(in_features=256, out_features=120) # 120是输出类别数

)

return finetune_net

定义训练函数

def evaluate_loss_acc(data_iter, net, device):

# 计算data_iter上的平均损失与准确率

loss = nn.CrossEntropyLoss()

is_training = net.training # Bool net是否处于train模式

net.eval()

l_sum, acc_sum, n = 0, 0, 0

with torch.no_grad():

for X, y in data_iter:

X, y = X.to(device), y.to(device)

y_hat = net(X)

l = loss(y_hat, y)

l_sum += l.item() * y.shape[0]

acc_sum += (y_hat.argmax(dim=1) == y).sum().item()

n += y.shape[0]

net.train(is_training) # 恢复net的train/eval状态

return l_sum / n, acc_sum / n

def train(net, train_iter, valid_iter, num_epochs, lr, wd, device, lr_period,

lr_decay):

loss = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.fc.parameters(), lr=lr, momentum=0.9, weight_decay=wd)

net = net.to(device)

for epoch in range(num_epochs):

train_l_sum, n, start = 0.0, 0, time.time()

if epoch > 0 and epoch % lr_period == 0: # 每lr_period个epoch,学习率衰减一次

lr = lr * lr_decay

for param_group in optimizer.param_groups:

param_group[‘lr’] = lr

for X, y in train_iter:

X, y = X.to(device), y.to(device)

optimizer.zero_grad()

y_hat = net(X)

l = loss(y_hat, y)

l.backward()

optimizer.step()

train_l_sum += l.item() * y.shape[0]

n += y.shape[0]

time_s = “time %.2f sec” % (time.time() - start)

if valid_iter is not None:

valid_loss, valid_acc = evaluate_loss_acc(valid_iter, net, device)

epoch_s = ("epoch %d, train loss %f, valid loss %f, valid acc %f, "

% (epoch + 1, train_l_sum / n, valid_loss, valid_acc))

else:

epoch_s = ("epoch %d, train loss %f, "

% (epoch + 1, train_l_sum / n))

print(epoch_s + time_s + ', lr ’ + str(lr))

调参

num_epochs, lr_period, lr_decay = 20, 10, 0.1

lr, wd = 0.03, 1e-4

device = torch.device(‘cuda’ if torch.cuda.is_available() else ‘cpu’)

使用上面的参数设置,在完整数据集上训练模型大致需要40-50分钟的时间

net = get_net(device)

train(net, train_valid_iter, None, num_epochs, lr, wd, device, lr_period, lr_decay)

对测试集分类并提交结果

#用训练好的模型对测试数据进行预测。比赛要求对测试集中的每张图片,都要预测其属于各个类别的概率。

preds = []

for X, _ in test_iter:

X = X.to(device)

output = net(X)

output = torch.softmax(output, dim=1)

preds += output.tolist()

ids = sorted(os.listdir(os.path.join(new_data_dir, ‘test/unknown’)))

with open(‘submission.csv’, ‘w’) as f:

f.write(‘id,’ + ‘,’.join(train_valid_ds.classes) + ‘\n’)

for i, output in zip(ids, preds):

f.write(i.split(’.’)[0] + ‘,’ + ‘,’.join(

[str(num) for num in output]) + ‘\n’)