朴素贝叶斯(naive Bayes) 法是基于贝叶斯定理与特征条件独立假设的分类方法。对于给定的训练数据集, 首先基于特征条件独立假设学习输入/输出的联合概率分布; 然后基于此模型, 对给定的输入x, 利用贝叶斯定理求出后验概率最大的输出y。 朴素贝叶斯法实现简单, 学习与预测的效率都很高, 是一种常用的方法。

1. 朴素贝叶斯法的学习与分类

基本方法

训练数据集:![]()

由X和Y的联合概率分布P(X,Y)独立同分布产生

朴素贝叶斯通过训练数据集学习联合概率分布P(X,Y) ,

即先验概率分布:![]()

及条件概率分布:![]()

注意: 条件概率为指数级别的参数:![]()

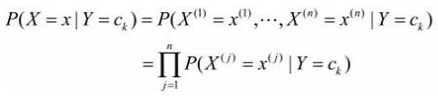

条件独立性假设:

“朴素” 贝叶斯名字由来, 牺牲分类准确性。

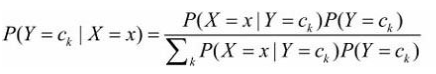

贝叶斯定理:

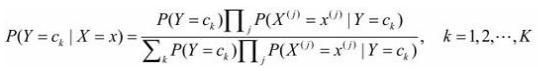

代入上式:

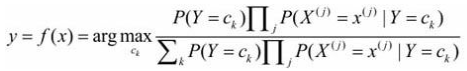

这是朴素贝叶斯法分类的基本公式。 于是, 朴素贝叶斯分类器可表示为

分母对所有ck都相同:![]()

后验概率最大化的含义

朴素贝叶斯法将实例分到后验概率最大的类中, 等价于期望风险最小化,

假设选择0-1损失函数: f(X)为决策函数

![]()

期望风险函数:![]()

取条件期望:![]()

只需对X=x逐个极小化, 得:

推导出后验概率最大化准则:![]()

2. 朴素贝叶斯法的参数估计

应用极大似然估计法估计相应的概率,先验概率P(Y=ck)的极大似然估计是:

设第j个特征x(j)可能取值的集合为:![]()

条件概率的极大似然估计:

学习与分类算法Naïve Bayes Algorithm:

输入:

训练数据集:![]() ,其中

,其中![]()

![]() 第i个样本的第j个特征,

第i个样本的第j个特征,![]() ,

,

是第j个特征可能取的第l个值,j=1,2,…,n, l=1,2,…,Sj, yi∊{c1, c2,…,cK}。

是第j个特征可能取的第l个值,j=1,2,…,n, l=1,2,…,Sj, yi∊{c1, c2,…,cK}。

输出:

x的分类

步骤:

(1) 计算先验概率及条件概率

(2) 对于给定的实例x=(x(1),x(2),…,x(n))T, 计算

![]()

![]()

(3) 确定实例x的类