NIN(Network in Network)是第一篇探索1 * 1卷积核的论文,这篇论文通过在卷积层中使用MLP替代传统线性的卷积核,使单层卷积层内具有非线性映射的能力,也因其网络结构中嵌套MLP子网络而得名NIN。NIN对不同通道的特征整合到MLP子网络中,让不同通道的特征能够交互整合,使通道之间的信息得以流通,其中的MLP子网络恰恰可以用1 * 1的卷积进行代替。

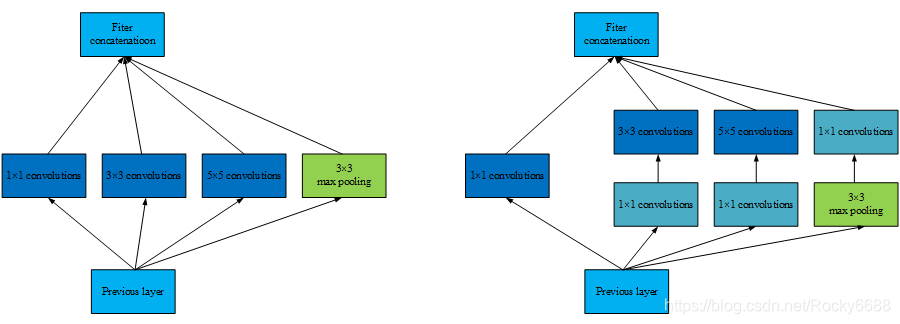

GoogLeNet则采用1 * 1卷积核来减少模型的参数量。在原始版本的Inception模块中,由于每一层网络采用了更多的卷积核,大大增加了模型的参数量。此时在每一个较大卷积核的卷积层前引入1 * 1卷积,可以通过分离通道与宽高卷积来减少模型参数量。

如上图所示,在不考虑参数偏置项的情况下,若输入和输出的通道数为C1 =16,则左半边网络模块所需的参数为(1 * 1 + 3 * 3 + 5 * 5 + 0)* C1 * C1 =8960;假定右半边网络模块采用的1 * 1卷积通道数为C2 =8(满足C1 > C2),则右半部分的网络结构所需参数量为(1 * 1 * (3C2 + C1)+ 3 * 3 * C2 + 5 * 5 * C2) * C1 = 5248。

所以1 * 1卷积可以在不改变模型表达能力的前提下大大减少所使用的参数量。

1 * 1卷积的作用主要为以下两点:

- 实现信息的跨通道交互和整合。

- 对卷积核通道数进行降维和升维,减少参数量。