1*1卷积的主要作用有以下几点:

1、降维( dimension reductionality )。比如,一张500 * 500且厚度depth为100 的图片在20个filter上做1*1的卷积,那么结果的大小为500*500*20。

2、加入非线性。卷积层之后经过激励层,1*1的卷积在前一层的学习表示上添加了非线性激励( non-linear activation ),提升网络的表达能力;

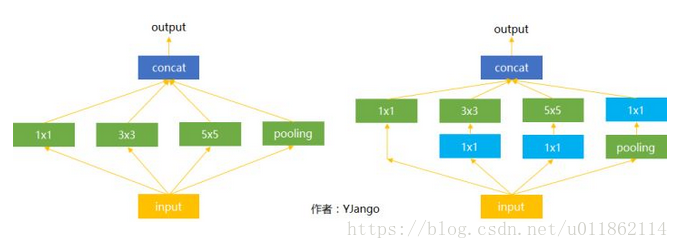

下图是Inception模块,为了消除尺寸对于识别结果的影响,一次性使用多个不同filter size来抓取多个范围不同的概念,让网络能够自己选择需要的特征。可以看到在Inception模块中,每个分支都加上一个1*1卷积的部分,这里1*1卷积的作用是让网络根据需要能够更灵活地控制数据的depth(即通道数),通过1*1卷积,可以将不同分支的feature map通道数调整到一直,便于后续操作(相加或concat)。这里的1*1卷积不止能降维,也可以升维,这完全取决与1*1卷积的通道数。

3、跨通道信息交互(channal 的变换)

如:使用1*1卷积核,实现降维和升维的操作其实就是channel间信息的线性组合变化,3*3,64channels的卷积核前面添加一个1*1,28channels的卷积核,就变成了3*3,28channels的卷积核,原来的64个channels就可以理解为跨通道线性组合变成了28channels,这就是通道间的信息交互。

参考链接: https://blog.csdn.net/u011862114/article/details/80530963?utm_source=blogxgwz2

1*1卷积的主要作用有以下几点:

1、降维( dimension reductionality )。比如,一张500 * 500且厚度depth为100 的图片在20个filter上做1*1的卷积,那么结果的大小为500*500*20。

2、加入非线性。卷积层之后经过激励层,1*1的卷积在前一层的学习表示上添加了非线性激励( non-linear activation ),提升网络的表达能力;

下图是Inception模块,为了消除尺寸对于识别结果的影响,一次性使用多个不同filter size来抓取多个范围不同的概念,让网络能够自己选择需要的特征。可以看到在Inception模块中,每个分支都加上一个1*1卷积的部分,这里1*1卷积的作用是让网络根据需要能够更灵活地控制数据的depth(即通道数),通过1*1卷积,可以将不同分支的feature map通道数调整到一直,便于后续操作(相加或concat)。这里的1*1卷积不止能降维,也可以升维,这完全取决与1*1卷积的通道数。

3、跨通道信息交互(channal 的变换)

如:使用1*1卷积核,实现降维和升维的操作其实就是channel间信息的线性组合变化,3*3,64channels的卷积核前面添加一个1*1,28channels的卷积核,就变成了3*3,28channels的卷积核,原来的64个channels就可以理解为跨通道线性组合变成了28channels,这就是通道间的信息交互。