本篇是迁移学习专栏介绍的第八篇论文,2012年发表在CVPR,GFK作为子空间变换方面是最为经典的迁移学习方法,它建立在2011年发表在ICCV上的另一篇开创性质的文章(SGF)。

Abstract

在视觉识别的实际应用中,许多因素,如姿态、光照或图像质量,都可能导致训练分类器的源域与应用分类器的目标域之间的严重不匹配。因此,分类器在目标域中的性能通常很差。Domain Adaption技术旨在纠正这种不匹配。现有的方法侧重于学习跨域不变的特性表示,它们通常不直接利用许多视觉数据集固有的低维结构。

在本文中,我们提出了一种新的基于核的方法来利用这种结构。我们的测地线流内核Geodesic flow kernel通过集成无穷多个子空间来模拟域的移动,这些子空间描述了从源到目标域的几何和统计特性的变化。我们的方法在计算上是有利的,自动推断重要的算法参数,而不需要广泛的交叉验证或来自任何领域的标记数据。我们还引入了一个可靠的度量方法来度量一对源域和目标域之间的适应性。对于给定的目标域和多个源域,可以使用该度量自动选择最优的源域,以适应和避免不太理想的源域。对标准数据集的实证研究表明,我们的方法优于竞争的方法。

1. Introduction

假设我们要部署一个Android应用程序来识别用手机摄像头捕获的图像中的对象。我们是否可以使用Flickr照片训练分类器,因为它们已经被收集和注释了,并且希望分类器在移动相机图像上仍然可以很好地工作?

我们的直觉是否定的。我们怀疑Flickr和手机图片之间的强烈区别会削弱这些分类器。事实上,一系列研究表明,当在训练数据集之外评估图像分类器时,性能会显著下降[27,9,24]。除了图像识别,不匹配的训练和测试条件也很丰富:在其他计算机视觉任务中[10,28,19,11],语音和语言处理[21,4,5]等。所

有这些模式识别任务都涉及两种不同类型的数据集,一种来自源域,另一种来自目标域。源域包含大量标记数据,可以可靠地构建分类器。目标域泛指假定具有与源域不同特征的数据集。其主要目标是将在源域上训练的分类器与目标域相适应,以获得较好的分类性能。请注意,我们假设跨域的一组可能的标签是相同的。

在Domain Adaption、协变量移位和转移学习的名称下,研究了解决这一挑战的技术。有两种设置:目标域完全未标记的无监督Domain Adaption和目标域包含少量标记数据的半监督Domain Adaption。通常仅标记目标数据不足以构造一个好的分类器。因此,如何有效地利用未标记的目标数据是Domain Adaption的关键。

在不需要标记目标数据的情况下,一个非常富有成效的工作重点是获得新的特征表示,以促进Domain Adaption[7,2,5,4,22,14]。目标是识别一个新的特征空间,使源域和目标域表现出共同的特征。直观地说,如果它们是不可分辨的,那么为源域构造的分类器也可以用于目标域。

定义和量化共有的特征需要仔细检查我们的直觉,即什么样的表征有助于适应。例如,在词性词性任务(词性词性任务)中,将单词标注到不同的句法类别[5]中,其思想是从辅助分类任务中提取共享模式,这些辅助分类任务预测主特征,即表示这些类别的频繁单词本身。虽然对语言处理任务很敏感,特殊来说,基于直方图的低层视觉描述符特征一般不喜欢主视觉词,从特定的直方图库中提取单个特征维数不足以区分视觉类别。

另一方面,许多可视化数据被假定位于低维子空间中。给定来自两个域的数据,我们如何利用这些数据集中的子空间来揭示域之间的潜在差异和共性?

此外,给定多个源域和一个目标域,如何选择要与目标域匹配的源域?为了将Domain Adaption应用于实际问题,这是一个需要解决的特别重要的问题。例如,在对象识别上下文中,我们可以从多个数据集中选择作为源域:ImageNet、Caltech-101/256、PASCAL VOC等。能够选择一种(或有限的几种)可能很好地适应目标领域的方法(而不是尝试每一种方法)要划算得多。

为了解决第一个挑战,我们提出了一种基于内核的Domain Adaption方法。提出的大地测量流核是在源域和目标域的子空间上计算得到的。它集成了无穷多个子空间,这些子空间位于从源子空间到目标子空间的测地线流上。流表示两个域之间几何和统计属性的增量变化。考虑到所有这些变化,我们的学习算法提取出那些真正的域不变的子空间方向。图1概述了主要思想。

我们基于测地线流核的Domain Adaption方法的主要思想(最好以彩色显示)。我们将源数据集和目标数据集嵌入到格拉斯曼流形中。然后,我们构造一个测地线两点之间的流动和整合子空间的无限流Φ(t)。具体地说,将原始特征投影到这些子空间中,形成无限维特征向量zh。这些特征向量之间的内积定义了一个可以在原始特征空间上以闭形式计算的核函数。内核封装了子空间之间的增量变化,这些变化是两个域之间区别和共同点的基础。因此,学习算法使用该内核派生出对域不变的低维表示。

为了解决第二个挑战,我们引入了一个称为域秩(ROD)的度量,它可以根据源域对Domain Adaption的适合程度对源域列表进行排序。该度量集成了两部分信息:源和目标域的子空间重叠的程度,以及目标和源数据在子空间中的分布有多相似。在我们的实验中,杆与适应性能有很好的相关性。

我们证明了所提方法对目标识别基准任务的有效性。所提出的方法在Domain Adaption方面明显优于最先进的方法。此外,作为这些方法的一个新应用,我们研究了最近在[27]中研究的数据集偏置问题。通过他们的分析,作者发现了一些具有高市场价值的数据集,这表明这些数据集不那么有偏见,更能代表真实世界的对象。我们用新的视角重新审视这些数据集:这些高价值的数据集在提高目标域的性能方面真的有用吗?我们的分析表明,在评估数据集的价值时,考虑适应性的易用性也是有益的。

Contributions.

总之,我们的主要贡献是

- 一种基于内核的Domain Adaption方法,它利用数据集中固有的低维结构(第3.3节);该方法易于实现,不需要交叉验证参数(第3.4和4.4节);

- 无需使用标记的目标数据(第3.5和4.5节),就可以预测哪个源域更适合于适应目标域的度量;

- 验证我们的方法相对于基准数据集现有方法的优势的实证研究(第4.2和4.3节)

- 从使用Domain Adaption应重新检查跨数据集泛化的新视角(第4.6节)。

2. Related Work

Domain Adaption在许多领域都得到了广泛的研究,包括统计学和机器学习[26,18,2,23],语音和语言处理[7,5,21],以及最近的计算机视觉[3,14,25,20]。

与我们的工作特别相关的是学习领域不变的新特性表示,从而支持将分类器从源领域转移到目标领域[2,5,4,7,22]。由于不需要标记目标数据,这些方法对无监督Domain Adaption特别有吸引力。其他非监督Domain Adaption的方法已经被探索过,例如,使用转导SVMs[3]或迭代重新标记(目标域)[6]。注意,后一种方法在很大程度上依赖于调优几个参数,这需要对许多支持向量机进行大量的计算。

Gopalan等人的工作是最接近我们的精神[14]。他们还探索了使用测地线流来推导源域和目标域之间插入的中间子空间的想法。这项工作与我们的工作的一个重要区别是,他们对有限数量的子空间进行采样,并将这些子空间叠加成一个非常高维的投影矩阵。我们的内核方法在概念上和计算上都更简单,并且不需要调优Gopalan等人的方法中需要的许多参数。在第3节描述了这两种方法之后,我们将回到比较。

3. Proposed Approach

我们的方法背后的主要思想是显式地构造一个无限大的特征空间H,它集合了源域DS、目标域DT和在这两者之间插入的虚域上的信息。H的内积产生一个核函数,该核函数可以用闭形式有效地计算。因此,这种大地测量流核(GFK)可以很容易地用于构造任何内核化的分类器。

我们首先回顾格拉斯曼流形的基本概念;源域和目标域数据的子空间表示为一个流形上的两个点。然后,我们讨论了以前的方法,其中多个子空间采样从流形派生新的特征表示。然后在3.3节中,我们详细描述了我们的方法,并与前面的方法进行了对比。

子空间的维数是一个重要的参数。在第3.4节中,我们提出了一个子空间不一致测度(SDM),用于在不交叉验证的情况下自动选择该参数。最后,在第3.5节中,我们描述了一个域(ROD)度量的秩,它计算两个域之间的兼容性,以便进行适应性调整。

3.1. Background

在统计建模中,我们通常假设数据可以嵌入到低维线性子空间中。例如,主成分分析(PCA)确定嵌入数据方差最大的子空间。在大多数情况下,用它的基P R D D表示一个子空间是充分和方便的,其中D是数据的维数,D是子空间的维数。主成分分析的基是数据s协方差矩阵的d个特征向量。所有d维子空间的集合形成格拉斯曼G(d, d),这是一个光滑的黎曼流形,我们可以在上面定义几何、微分和概率结构。

作为格拉斯曼算法如何帮助我们解决Domain Adaption问题的一个直观例子,假设我们计算DS和DT域的数据集的子空间,并将它们映射到格拉斯曼算法上的两个点。直观地说,如果这两个点很接近,那么这两个域可能是相似的,例如,它们的特性可能是相似分布的。因此,一个训练有素的分类器很可能在DT上工作得很好。

然而,如果这两个域在流形上相距很远呢?我们简要描述了Gopalan等人的早期工作。我们的方法对它进行了扩展和改进。

3.2. Subspaces by sampling geodesic flow (SGF)

考虑两个在姿态上有很大差异的汽车数据集被放置在歧管上的很远的地方。关键思想是使用中间子空间来学习域不变的特性来适应[14]。具体来说,中间子空间将在源域和目标域之间插值的位姿下捕获汽车图像的统计信息。了解到所有这些来自同一类别的不同子空间后,学习算法可能能够提取对姿态变化不那么敏感的特征。

具体地说,采样大地测量流(SGF)[14]的方法包括以下步骤:

- 在格拉斯曼年上构造一条连接源域和目标域的大地测量流曲线

- 从该曲线中抽取固定数量的子空间作为样本

- 将原始特征向量投影到这些子空间中,并将其连接到特征超向量中

- 减少超向量的维数

- 将得到的表示作为新的特征向量构造分类器

尽管取得了令人鼓舞的结果,但SGF方法有几个局限性。目前还不清楚如何选择最佳的抽样策略。需要调整几个重要的参数:要采样的子空间的数量、子空间的维数以及如何处理新表示的高维性。关键的是,交叉验证所有这些调整旋钮在典型的Domain Adaption设置中是不切实际的,因为在这些设置中很少或没有标记的目标数据。

在下面的文章中,我们将展示如何在一个简单的基于内核的框架中解决这些限制。

3.3. Our approach: geodesic flow kernel (GFK)

我们的方法包括以下步骤:

- 确定要嵌入域的子空间的最优维数

- 构建测地线曲线

- 计算测地线流核

- 使用内核构造带标签数据的分类器。

我们将步骤i)的描述推迟到下一节,重点放在步骤ii)和步骤iii)上。对于步骤ii),我们只陈述主要的计算步骤。详细的推导可以在[14]及其参考文献中找到。为了简单起见,我们还省略了步骤iv),因为它与构造任何其他基于内核的分类器一样。

Construct geodesic flow 让表示源域和目标域的子空间的两组基。让

表示

正交补,即为

。利用黎曼流形的正则欧几里德度量,将测地线流参数化为

约束条件下

。对于其他的t,

其中是正交矩阵。它们由以下两对svd给出,

是 dxd大小的对角阵。对角线元素

和

,对于

。特别是,

称为

之间的角度

它们测量子空间“重叠”的程度。此外是对角矩阵的元素分别是

。

Compute geodesic flow kernel (GFK) 测地线流参数化源域如何平滑地变化到目标域。考虑到子空间,

,计算

:特征向量x在子空间中的投影。如果x来自源域,而t接近1,那么投影更有可能来自目标域,反之,对于t接近0。因此,使用投影来构建分类器将得到一个模型,该模型使用了两个领域的特征集。因此,这个分类器可能在目标域中执行得很好。

那么我们应该使用哪一组t呢?乍一看,我们的答案令人惊讶:全都是!直观地说,通过将原始特征与投影扩展到所有子空间,我们强制度量相似性(因为我们将使用内部积来构造分类器),该相似性度量对任何倾向于源或目标或两者之间的变化都是健壮的。换句话说,净效应是一种对两个域中的特性都不敏感的表示形式。然而,在计算上,我们不能显式地使用这种表示。然而,我们接下来要证明的是,实际上不需要计算、存储和操作无穷多个投影。

对于两个原始的d维特征向量和

,我们计算其投影到

连续t从0到1,连接所有的预测到无限维的特征向量

。它们之间的内积定义了我们的r geodesic-flow kernel:

其中是一个半正定矩阵。这正是“核技巧”,即核函数在无穷维特征之间引入内积。

矩阵G可由以前定义的矩阵计算为封闭形式·:

其中是对角矩阵,元素是

附录中给出了详细的推导。与以前的SGF方法相比,我们的方法在概念上和计算上都更简单。特别地,我们不需要调优任何参数,唯一的自由参数是子空间d的维数,下面我们将展示如何自动推断。

3.4. Subspace disagreement measure (SDM)

对于无监督域的自适应,我们必须能够自动选择最优的d,只有未标记的数据。我们通过提出一个子空间分歧度量(SDM)来解决这一挑战。

为了计算SDM,我们首先计算两个数据集的PCA子空间。我们还将数据集合并到一个数据集中,并计算其子空间PCAS+T。直观地说,如果这两个数据集是相似的,那么这三个子空间在格拉斯曼函数上应该不会相距太远。SDM捕捉了这一概念,并根据主角定义(cf. eq. (3)):

其中表示d-th主角在

之间,

在

之间,

称为minimum correlation distance[16]。

注意接近1。一个小的值表示两者都是

,尽管

都是对齐的(在第d维)。最大值这两个子空间有正交的方向在(如,

)。在这种情况下,Domain Adaption将变得困难,因为在一个子空间中捕获的方差将无法转移到另一个子空间。

为了确定最优d,我们采用贪心策略:

直观地说,最优d应该尽可能高(为了在源域中保持方差,以便构建良好的分类器),但不应该高到两个子空间开始有正交方向。

3.5. Rank of domain (ROD)

假设我们需要为目标域构建一个分类器来进行对象识别。我们有几个数据集,Caltech101、PASCAL VOC和ImageNet可供选择作为源域。没有实际运行我们的Domain Adaption算法和构建分类器,是否有可能确定哪个数据集在目标域上给我们最好的性能?

为了回答这个问题,我们引入了一个域(杆)度量的秩,它集成了两组信息:几何上,子空间之间的对齐,以及统计上,一旦数据分布被投影到子空间中,数据分布之间的KL差异。

我们大致的想法如下:详细的推导过程见附录。给定一对域,计算杆涉及三个步骤:i)确定子空间的最优维数d(如3.4节所示);ii)在每个维i d处,用两个一维高斯近似两个域的数据分布,然后计算它们之间的对称KL分歧;iii)计算主角的KL散度加权平均,即

为上述两种高斯分布;它们是由投影到主向量上的数据估计的(与第i个主角相关)。

值较小的一对域更有可能很好地适应:这两个领域都是几何对齐良好(小的主角)和相似的分布(小的KL分歧)。从经验上讲,当我们使用这个度量对各种数据集作为源域进行排序时,我们发现排序与它们在目标域上的相对性能改进密切相关。

4. Experiments

我们在对象识别上下文中评估我们的方法。我们首先将大地测量流核方法与基线和其他Domain Adaption方法进行比较[25,14]。然后,我们报告的结果验证了自动选择子空间最佳维数的过程(第3.4节)。接下来我们报告结果来展示我们的Rank of Domain (ROD)度量能够很好地预测出哪个源域更适合于定义Domain Adaption。最后,从“易适应性”的角度对[27]最近研究的数据集偏置问题进行了重新研究。

4.1. Setup

我们的实验使用了[25]中研究的三个数据集:Amazon(从在线商家下载的图像)、Webcam(通过网络摄像头下载的低分辨率图像)和DSLR(通过数字单反相机拍摄的高分辨率图像)。此外,为了在大范围的数据集上验证所提出的方法,我们添加了Caltech-256[15]作为第四个数据集。我们将每个数据集视为一个域。我们提取了所有四个数据集共有的10个类

BACKPACK, TOURING-BIKE, CALCULATOR, HEAD PHONES, COMPUTER-KEYBOARD, LAPTOP-101, COMPUTER-MONITOR, COMPUTER-MOUSE, COFFEEMUG, AND VIDEO-PROJECTOR.

每个类别每个域有8到151个样本,总共有2533幅图像。图2突出显示了这些域之间的差异,并给出了MONITOR类别中的示例图像。

我们在正文中报告了10个公共类的结果。此外,我们在附录中报告了亚马逊、Webcam和DSLR共有的31个类别的结果,以直接与已发表的结果进行比较[25,20,14]。我们对10个或31个公共类的结果都表明了相同的趋势,即建议的方法明显优于现有方法。

我们遵循了之前工作中使用的相似的特征提取和实验协议。简单地说,我们使用SURF特性[1]并用800-bin直方图对图像进行编码,并使用从Amazon图像子集训练而来的代码本。首先对直方图进行归一化,然后对z进行评分,使每个维度的均值和单位标准差为零。对于每一对源域和目标域,我们进行了20个随机试验。在每个试验中,我们随机抽取源域中的带标记数据作为训练示例,目标域中的无标记数据作为测试示例。在半监督Domain Adaption中,我们也从目标域抽取少量的图像样本来增强训练集。我们报告目标域的平均准确度和标准误差。

我们使用最近邻作为分类器,因为它不需要交叉验证参数。对于我们的算法,子空间的维数根据3.4节的准则进行选择。对于我们比较的方法,我们使用的是在已出版的著作中推荐的方法。

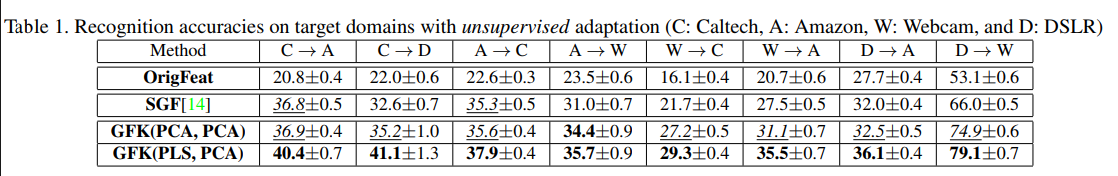

4.2. Results on unsupervised adaptation

我们的基线是OrigFeat,在这里我们使用原始特性,而没有学习适应的新表现形式。其他类型的基线报告在Suppl中。方法中使用两种类型的子空间源数据:PCA是PCA子空间,PLS是偏最小二乘子空间。PLS与PCA相似,只是它考虑了标签信息,因此可以看作是监督降维[17]的一种形式。对于目标域,我们只使用PCA,因为没有标签。因此,我们基于内核的方法有两种变体:GFK(PCA, PCA)和GFK(PLS, PCA)。我们还实现了3.2节[14]中描述的方法。我们称之为SGF。正如该方法的作者所建议的,我们对这两个域都使用PCA子空间。

我们还使用了[14]中报告的参数设置。

表1总结了上述方法对源域和目标域不同配对的分类精度和标准误差。我们报告了8对;其余的在补充中报告。每一列中最好的组(最多一个标准错误的差异)用粗体显示,第二好的组(最多一个标准错误的差异)用斜体和下划线显示。

所有的Domain Adaption方法都能提高基线起始精度。此外,我们基于GFK的方法总体上优于SGF。此外,GFK(PLS, PCA)表现最好。两个关键因素可能有助于我们的方法的优势:i)内核集成了沿着流的所有子空间,因此能够更好地建模源和目标之间的域转移;该方法利用源域中的一个子空间(PLS)来包含标签信息。这样做的好处是避免了投影方向包含噪声和很少有用的辨别信息,尽管使源域和目标域看起来很相似。另一方面,PCA并不总是生成包含区分信息的子空间。因此,我们的GFK(PLS, PCA)对SGF的所有改进在统计上都是显著的,存在一个以上的标准误差。

对于给定的目标域,有一个首选源域,可以使用OrigFeat或任何Domain Adaption方法获得最佳性能。例如,对于域Webcam,源域DSLR比域Amazon更好。这可能是由于数码单反和网络摄像头的相似性,如图2所示。我们将在4.5节中对此进行详细分析。

4.3. Results on semi-supervised adaptation

在半监督自适应中,我们的算法可以访问一小组标记的目标数据。因此,我们也比较了GFK(PLS, PLS)和基于度量学习的度量[25]方法,该方法利用源标记数据和目标标记数据之间的对应关系来学习一个马氏度规,将数据映射到一个新的特征空间。

表2显示了所有方法的结果。我们的GFK(PLS, PCA)仍然是最好的,其次是GFK(PCA, PCA)。注意,尽管GFK(PLS, PLS)包含了来自两个领域的鉴别信息,但它的性能不如GFK(PLS, PCA)。这可能是由于目标域中缺少足够的标记数据来给出PLS子空间的可靠估计。度量方法也不能很好地执行,原因可能是相同的。

如表1所示,对于给定的目标域,有一个pal源域可以最大程度地提高性能。此外,该pal与无监督Domain Adaption设置中的pal相同。因此,我们认为这种伙伴关系是数据集固有的;在4.5节中,我们将用杆度规分析它们。

4.4. Selecting the optimal dimensionality

能够为子空间选择最优维数是我们方法的一个重要特性。图3结果表明,第3.4节描述的子空间不一致测度(SDM)与目标域的识别精度有较好的相关性。在图中,水平轴是建议的维度(以对数尺度表示),而右侧垂直轴报告了无监督Domain Adaption和半监督Domain Adaption的准确性。左纵轴报告SDM的值。

绘图揭示了两种相互冲突的力量在起作用。随着维数的增加,SDM作为表征几何结构差异的指标迅速上升,最终达到最大值1。超过这一点,由于子空间具有正交方向,适应就变得困难。

然而,在达到最大值之前,几何差异被方差的增加所抵消,一个小的维数将捕获源域数据中非常小的方差,并将导致两个域的精度都很差。权衡发生在几何差异刚刚被最大化的地方,证明了我们在式(8)中的维数选择准则。

4.5. Characterizing datasets with ROD

给定一个目标域和几种选择的数据集作为源域,确定哪一个是最好的适应不仅有实用价值,也提供了新的见解如何数据集是相互关联的:易于适应函数作为晴雨表,表明两个数据集是否相似的几何和统计,并穿透每个数据集自身的特质。为此,我们检验了第3.5节中描述的定义域(杆)度量的秩是否与表1和表2中的实证结果相关。我们使用PCA子空间计算ROD,并报告表4中4个域之间的值。

一般来说,杆与目标域的识别精度有很好的相关性,能够可靠地识别出最适合的源域。例如,当Caltech是目标域(第一列)时,Amazon的值最小,Amazon在Caltech上的分类精度确实优于DSLR或Webcam。如果我们将Caltech和Amazon放在一个在线元分类中,将DSLR和Webcam放在另一个元分类办公室中,那么与类别相关的ROD值分布表明,具有相同元分类的域比跨类别的域对(如Caltech和DSLR)具有更强的相似性。因此,ROD还可以用作将数据集划分为集群的度量,其中相同集群中的数据集共享潜在属性,这些潜在属性的存在可能会让用户感到惊讶,但这些属性的存在可能不是设计出来的。

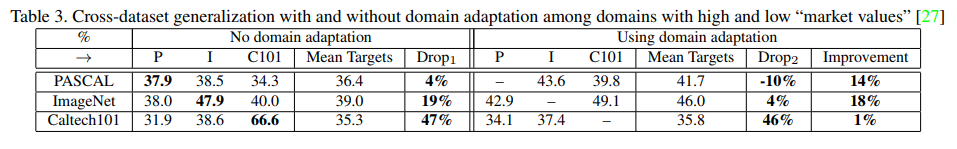

4.6. Easy to adapt: a new perspective on datasets?

Torralba和Efros研究了几种常用的对象识别[27]数据集偏差的来源。为了量化每个数据集的质量,他们设计了一个市场价值指标。具有较高值的数据集更加多样化,因此可能更好地反映现实世界对象的丰富性。他们特别指出PASCAL VOC 2007和ImageNet具有很高的价值。基于他们的研究结果,我们反过来研究:这些数据集在改善目标域的性能方面有多大价值?

表3总结了我们对[27]中使用的数据集子集的初步结果;PASCAL VOC 2007 [12], ImageNet [8], Caltech-101[13]。识别任务是识别人与车的类别。表的左侧显示了不使用自适应技术的交叉数据集泛化结果(如[27]);使用我们基于内核的方法的自适应结果在表的右边。

行是源域数据集,列是目标域。Drop列报告源和目标域上的平均精度(即平均目标列)之间的识别准确度下降的百分比。最右边的改进列是由于使用Domain Adaption而对目标域进行改进的百分比。显然,Domain Adaption能显著提高目标域的识别精度。加州理工101是一个例外,它的进步微乎其微(47%对46%)。这证实了[27]中分配给该数据集的低市场价值。

PASCAL VOC 2007在没有Domain Adaption的情况下下降最小,因此它似乎是比其他两个更好的数据集。一旦我们应用了Domain Adaption,我们观察到一个负下降,即目标域的性能比源域本身更好!但是,它的改进并不像ImageNet s那么高。

我们推测PASCAL VOC 2007中的数据可以分为两部分:一部分特别难以适应其他领域,另一部分特别难以适应其他领域相对容易。性能下降的相反情况表明,容易的部分可以通过Domain Adaption技术获得。然而,由于困难的部分,好处是有限的。另一方面,对于ImageNet来说,它的大部分数据可能是可以适应的。因此,它在适应后得到了较大的改善。

简而言之,虽然PASCAL VOC 2007和ImageNet在[27]中被赋予了相同的市场价值,但是它们对于构建可应用于其他领域的对象识别系统的有用性需要在适应的上下文中仔细研究。在评估数据集的过程中引入易适应性的概念可能是有益的,这是一个值得进一步探索和完善的概念。

5. Conclusion

提出了一种基于内核的Domain Adaption技术。该技术将数据集嵌入格拉斯曼流形中,并在流形之间构造测地线流,从而对域移动进行建模。提出的方法集成了无限个子空间来学习新的特征表示,这些特征表示对域的变化具有鲁棒性。在目标识别的标准基准测试任务中,我们的方法始终优于其他竞争算法。

在未来的工作中,我们计划利用线性子空间之外的潜在结构进行Domain Adaption。