-

Introduction

(1)除了有标签数据外,还有大量的无标签数据。(远多于标签数据)

(2)Transductive learning:直推学习,无标签数据是testing data

(3)Inductive Learning:归纳学习,无标签数据不是testing data -

为什么要半监督学习?

收集数据往往是很容易的,但是收集有标签的数据却是很难的;

我们的生活就是半监督学习的过程,每次我们都只是被告诉某类物品的部分样品的标签,但是我们自己对后面看到的物品进行学习 -

半监督学习方法一般都具有某些假设,半监督学习方法有没有作用,取决于这些假设的正确程度。

-

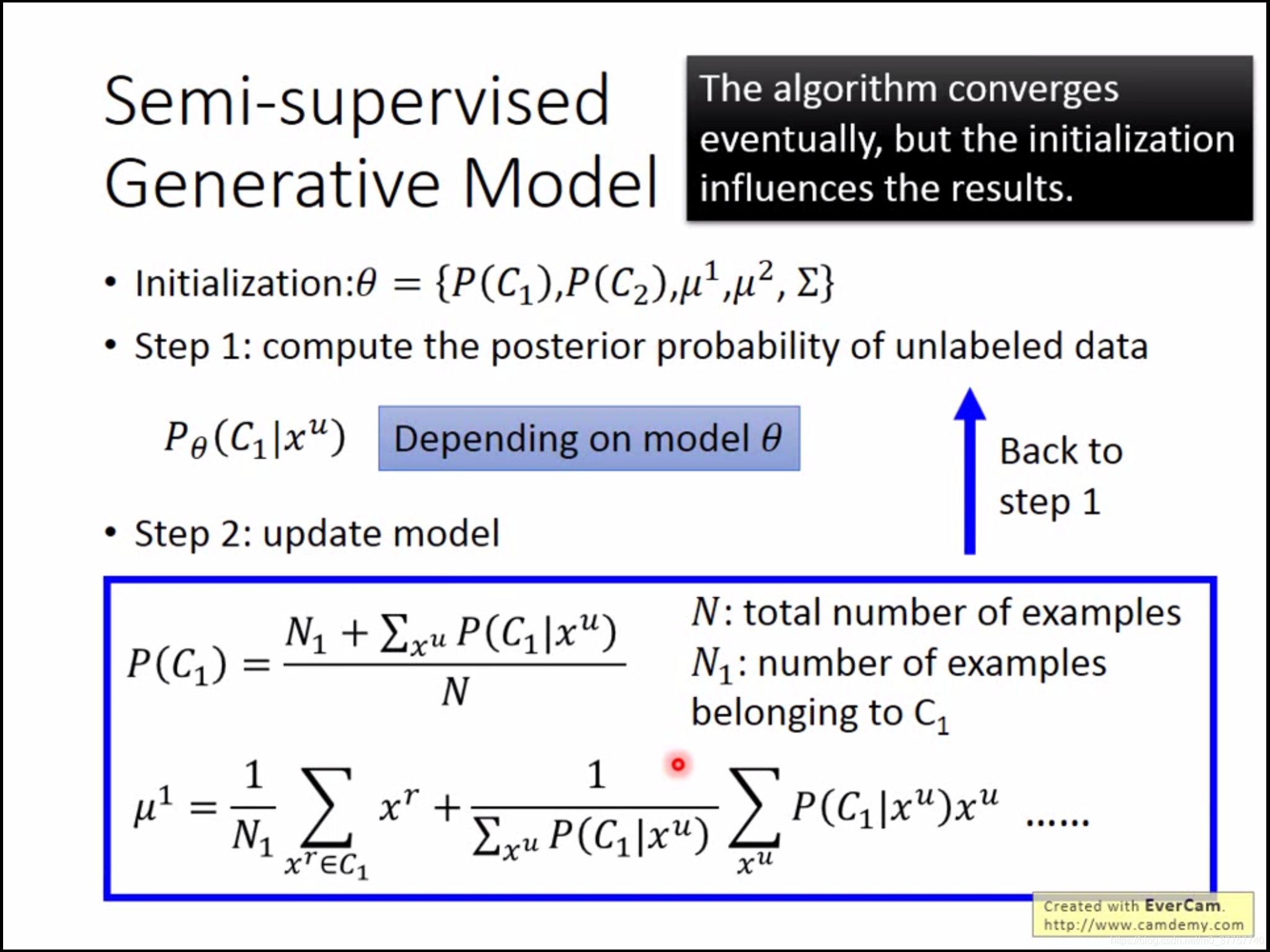

半监督学习的生成模型,一般可以分为三步:

(1) 随机初始化模型参数;

(2)计算无标签数据的分类概率;

(3)根据无标签数据的分类概率更新所有参数,重复步骤(2),(3);

-

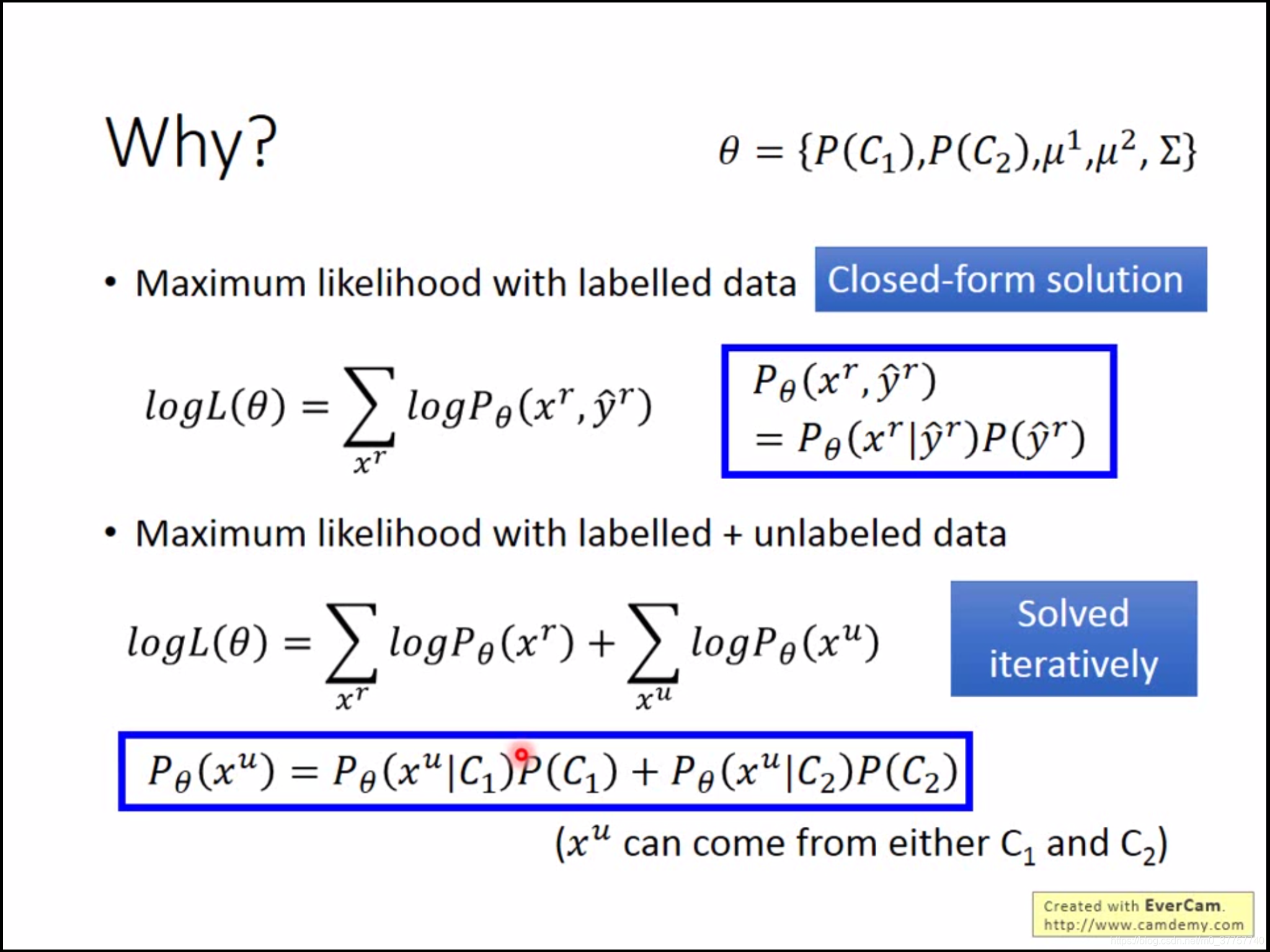

使用半监督方法的理论原因是:最大化该样本出现的原因,监督学习是可以得到最优解的,但是由于半监督方法中的优化函数不是凸函数,即不能得到最优解,所以只能迭代求解。

-

半监督学习基于两个重要的假设:

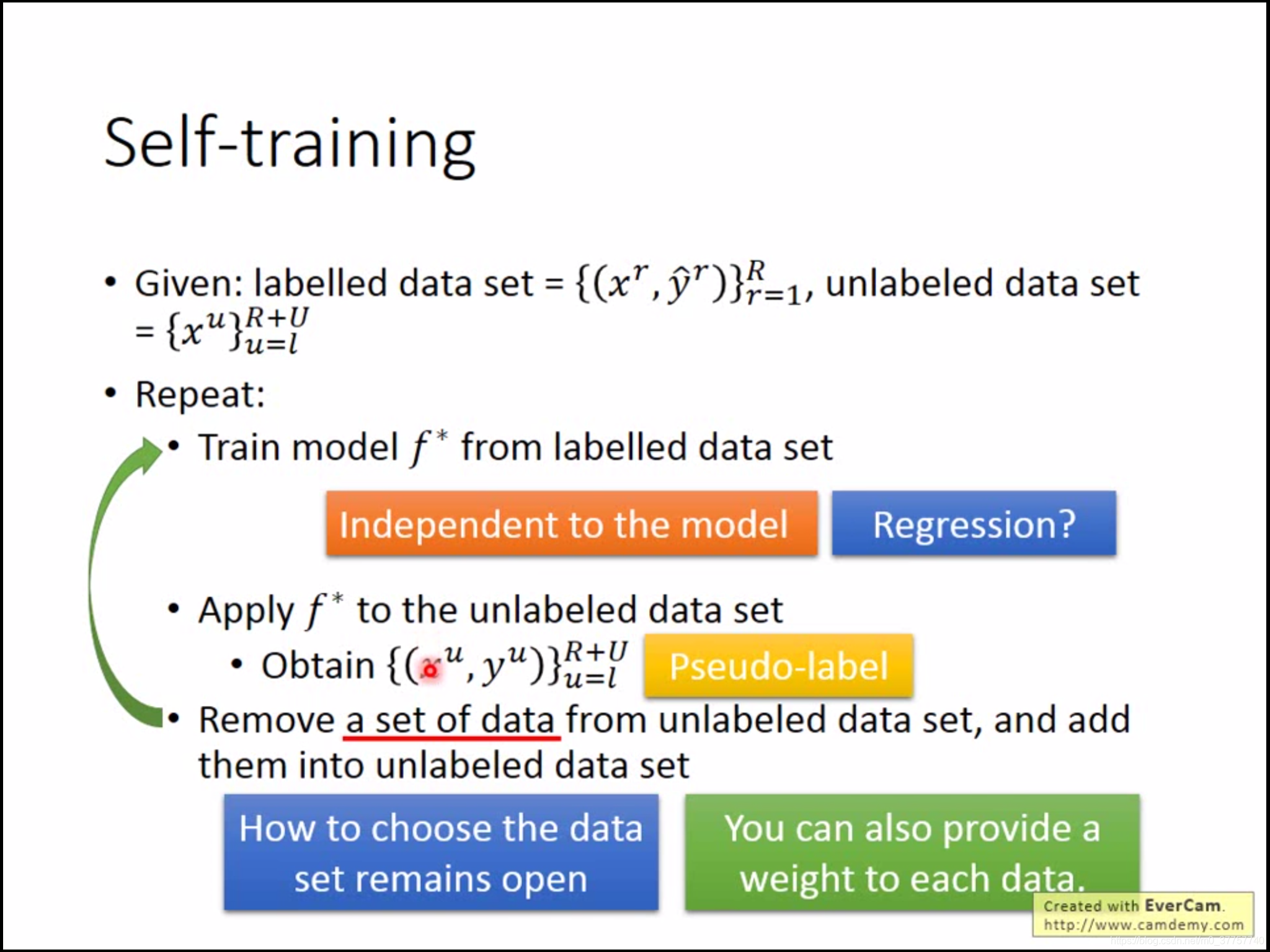

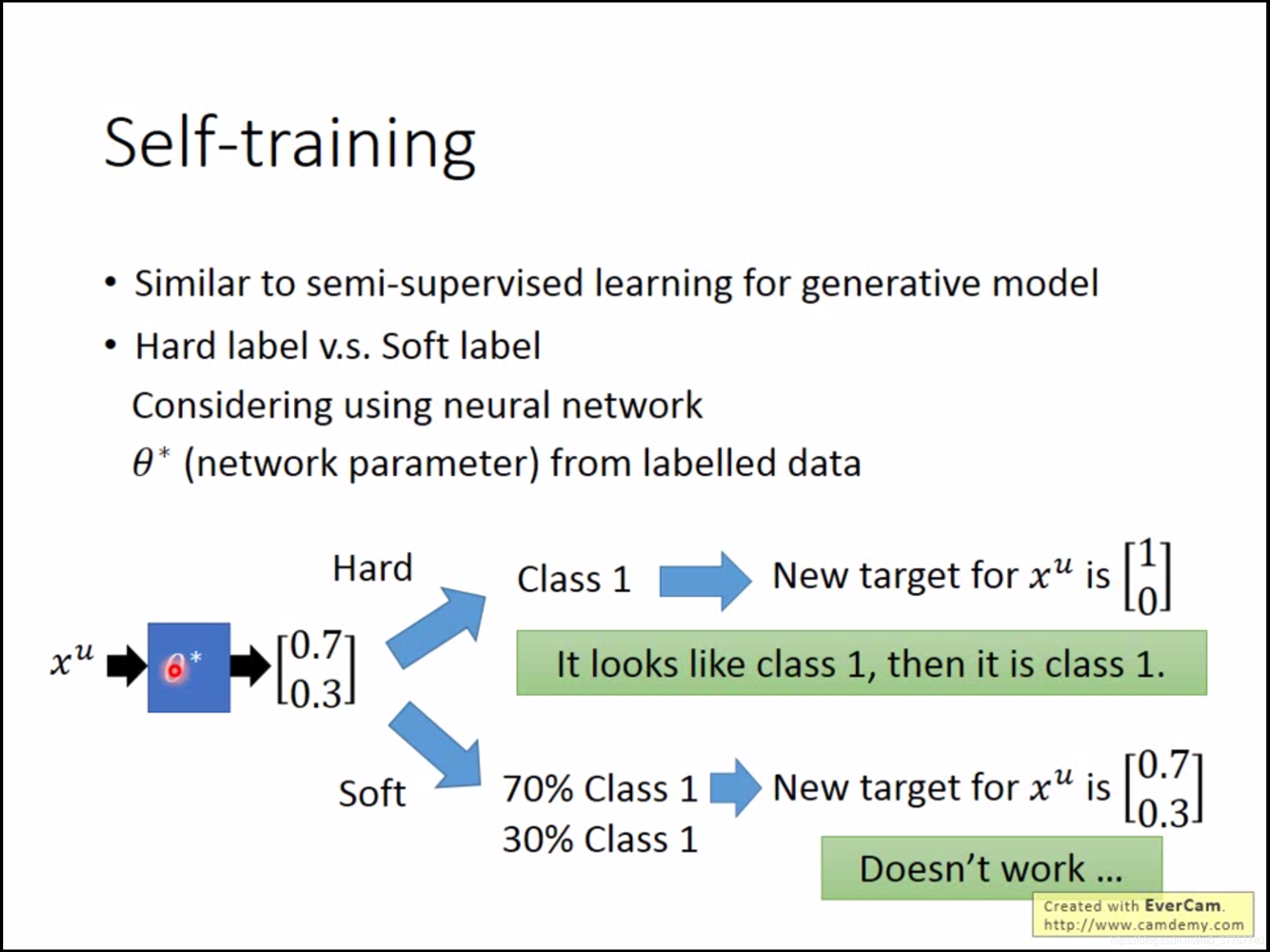

(1)整个世界是“非黑即白”的,即两个不同种类之间的界限明晰,即在交界处的样品密度较低——Low-density Separation。基于该假设的一种典型实现就是self-training。但是这种方式对regression是没有作用的,因为新得到的y^u不会改变模型参数

self-training与Generative model的差别是,前者使用的是hard label,后者使用的是soft label。如果使用neural network的话,应该使用hard label,这样它才会工作。

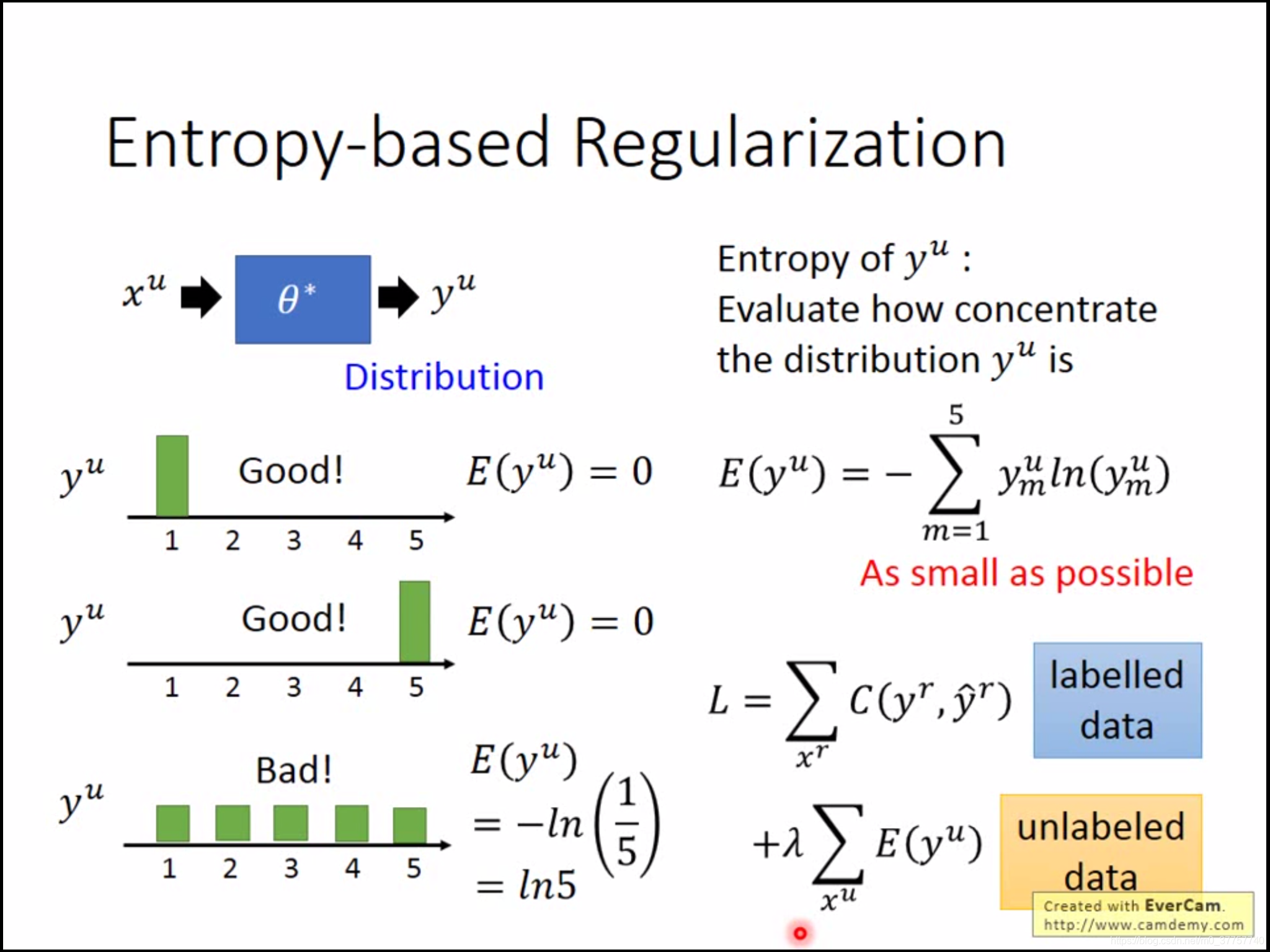

对于这个假设,还可以有另外一种实现方式,Entropy-based regularization,保证最终学到的无标签数据界限清晰,样本属于某一类的可能性最大。

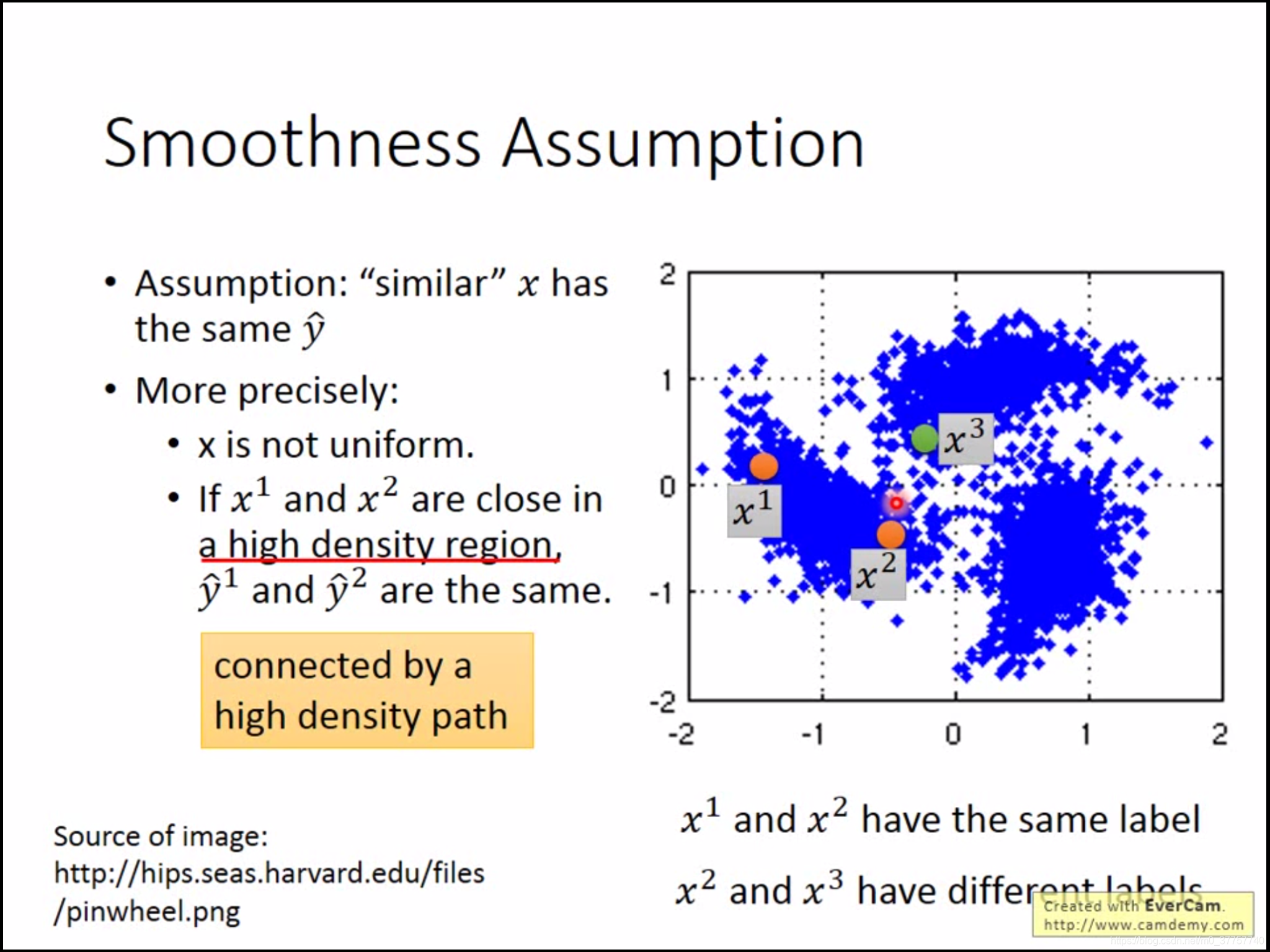

(2)“近朱者赤,近墨者黑”,相似的样本之间具有相同的label,且样本之间有个“high density region”,也就是说下图中x_1和x_2虽然距离较远,但是它们中间有个高密度的路径相连。

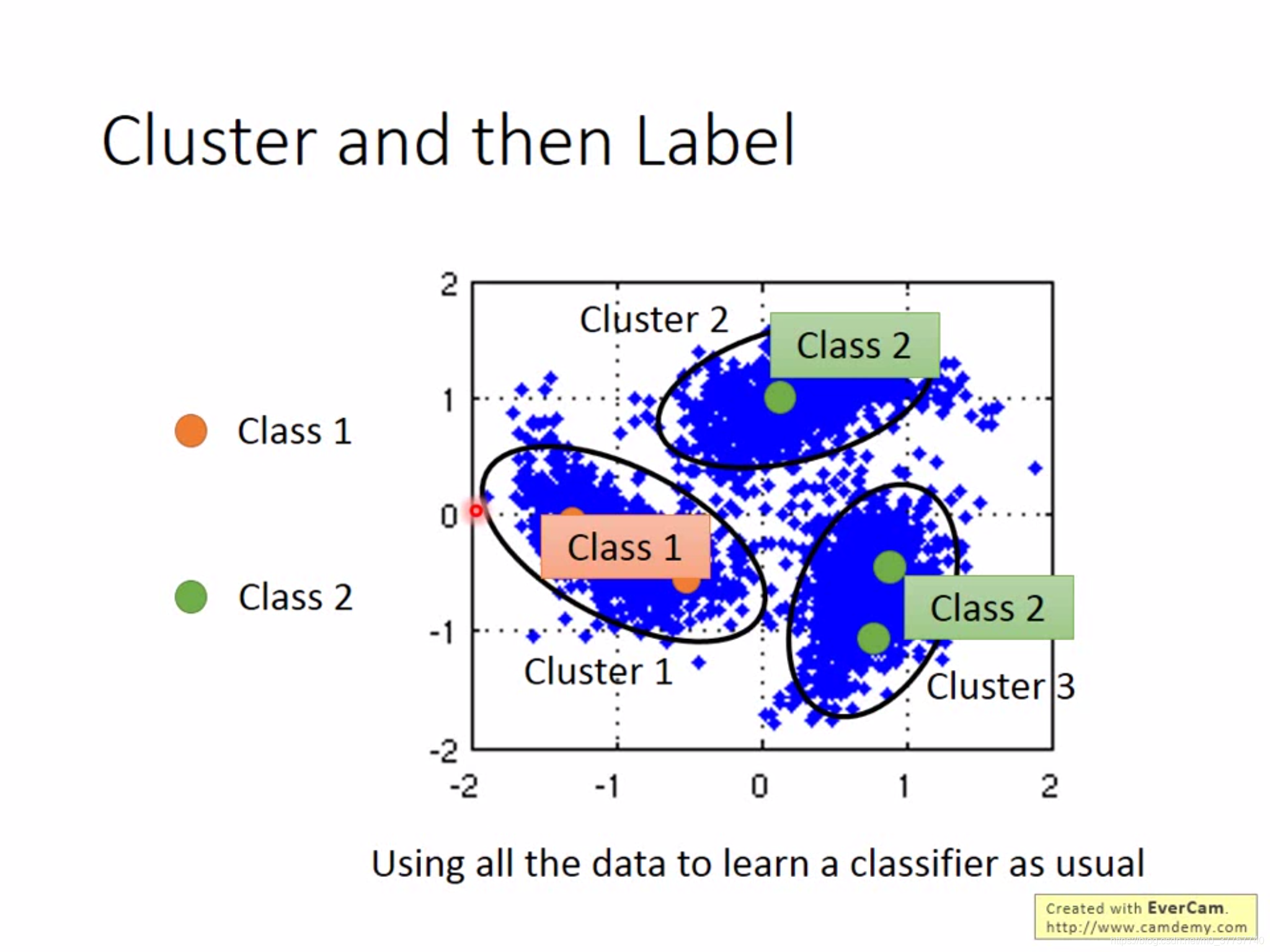

这种方法最简单的实现方式就是cluster then label,但是这种方法很依赖于cluster,因为在图像上做cluster是一件比较难的事情。

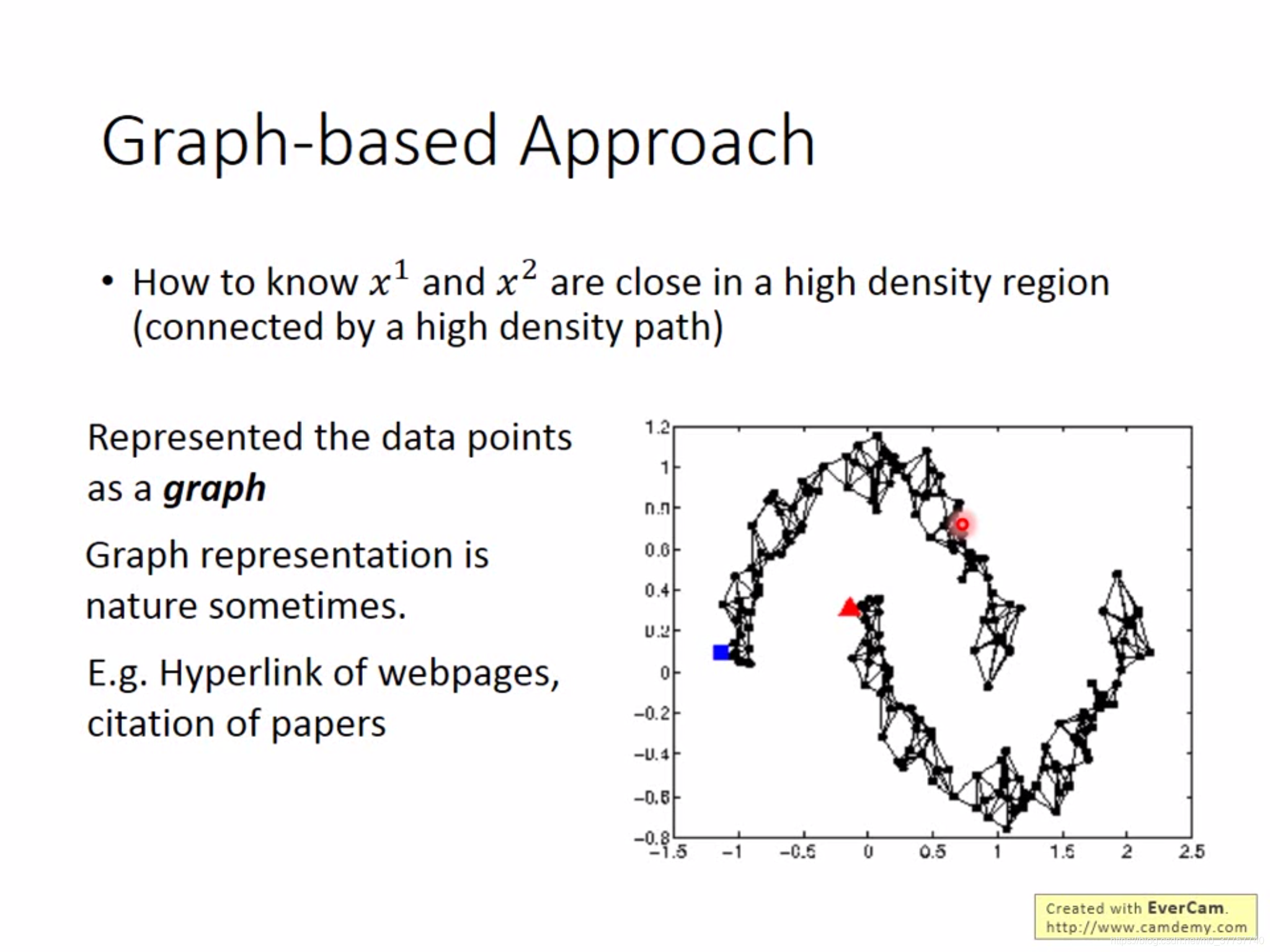

另外一种方法就是Graph-based approach,基于图的方法,是将样本之间的联系看成是两点之间具有相连的路径,有些两点之间连接的路径是很自然的,比如论文中的引用等待。

确定路径的方式有很多,可以用KNN,e-neighbor等方式来确定是否有路径连接(有点类似于hard label);或者用两者之间的 相似程度(soft label)来确定路径的权重,确定方式可以用Gaussian Radial Basis Function(径向基函数),可以让距离稍近的两个点比距离稍远点两个点的权重大很多,保证差异性。

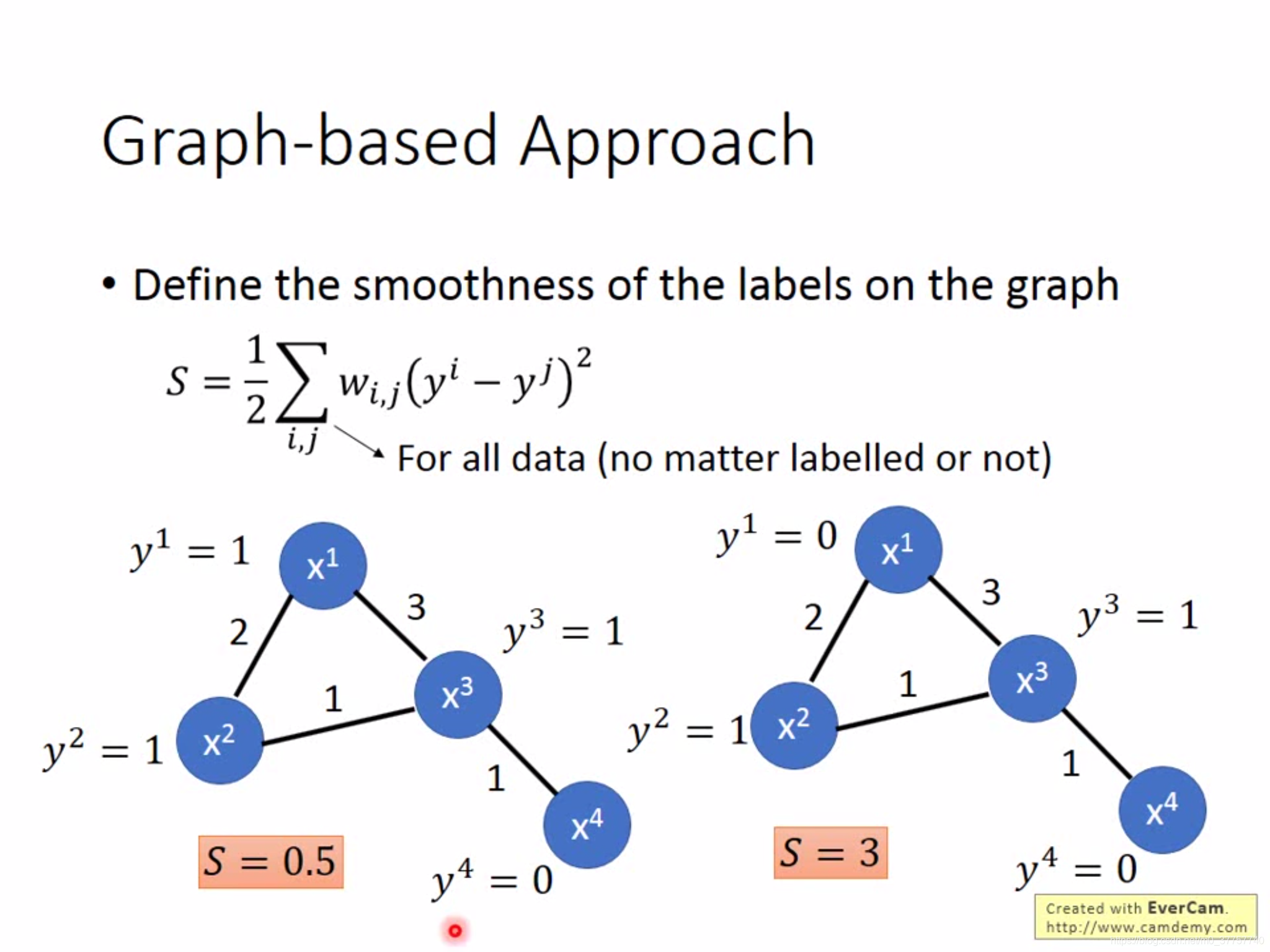

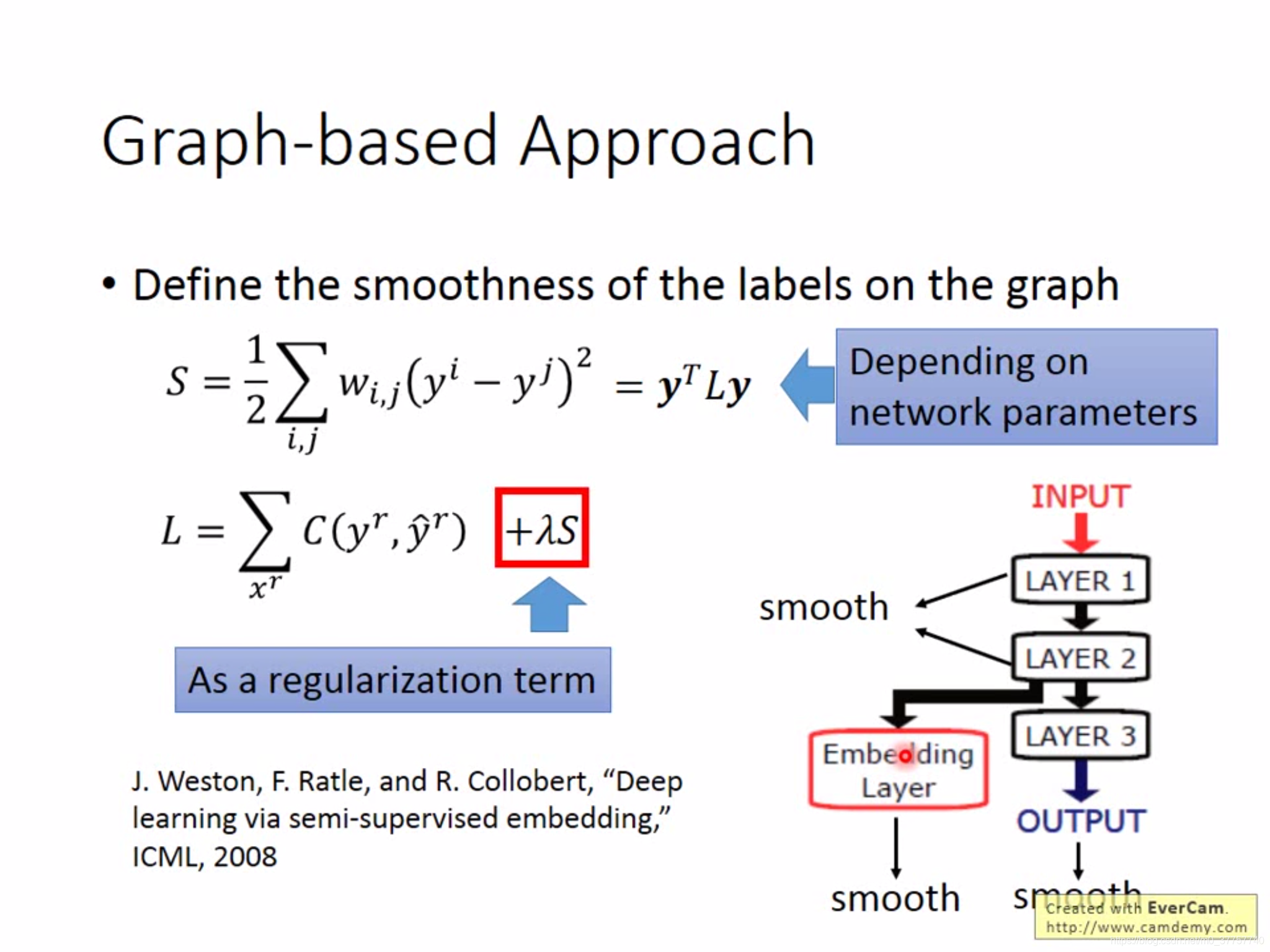

在graph-based 方法上定义smoothness of the label,对于所有的data,两样本之间的label之差的平方乘以权重求和,这个值越小表明越smoothness。

可以用拉普拉斯矩阵来表示这个function

最终在训练时,可以将监督学习的误差和smoothness of label的值结合起来表示,后者作为regularization term来调节,可以放在每一层中进行smooth,具体可由情景而定。

(3)Looking for better representation:找到表面观察背后的隐含特征,更好地表示这个物体。

李宏毅机器学习——学习笔记(11) Semi-supervised learning

猜你喜欢

转载自blog.csdn.net/m0_37757740/article/details/88977008

今日推荐

周排行