李宏毅ML lecture-14 unsupervised Learning--Word Embeddng

词嵌入(Word Embeddng),让计算机理解文章.

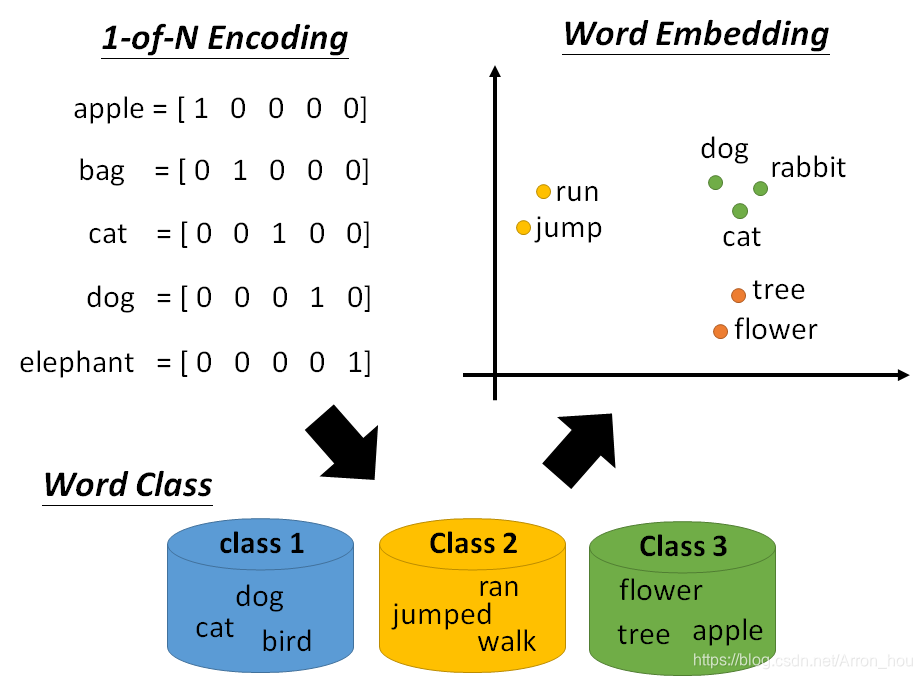

词与词之间是有相关含义.举例来说class1中的词是动物,class2中的词是行为,class3中的词是植物.

class1和class2又都是生物,class1具有的属性可以在class2中寻找.

词的分类,词的关联对于人类来说也是什么困难的,传统方法必须依靠语言学家与计算机学家的hard code才能完成,而且工作量十分巨大.而深度学习的出现,给计算机理解文章带来了方法.

首先把词转换为one-hot编码.这个词库就会相当的大,例如中文词库就会有10万维的数据.

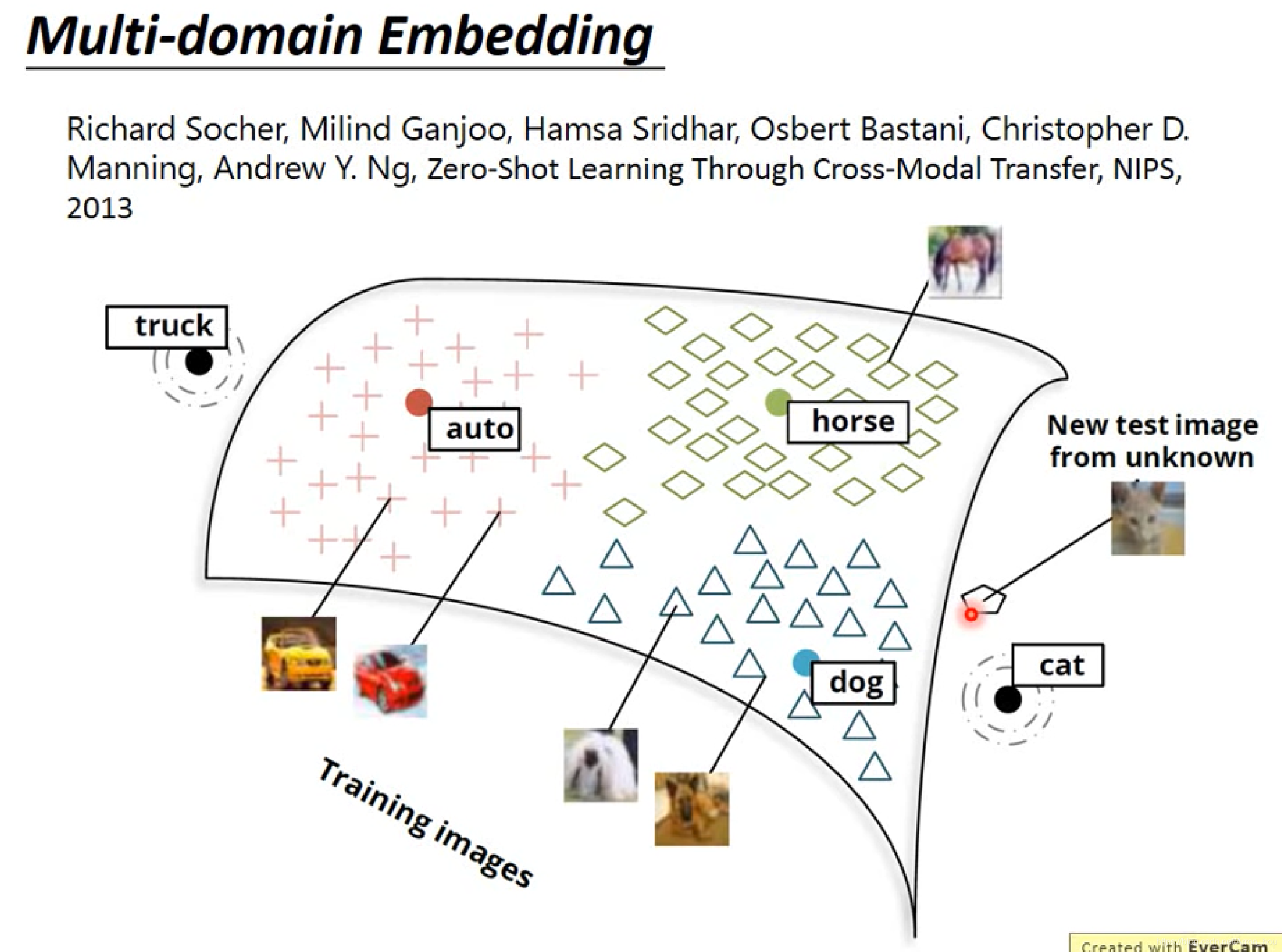

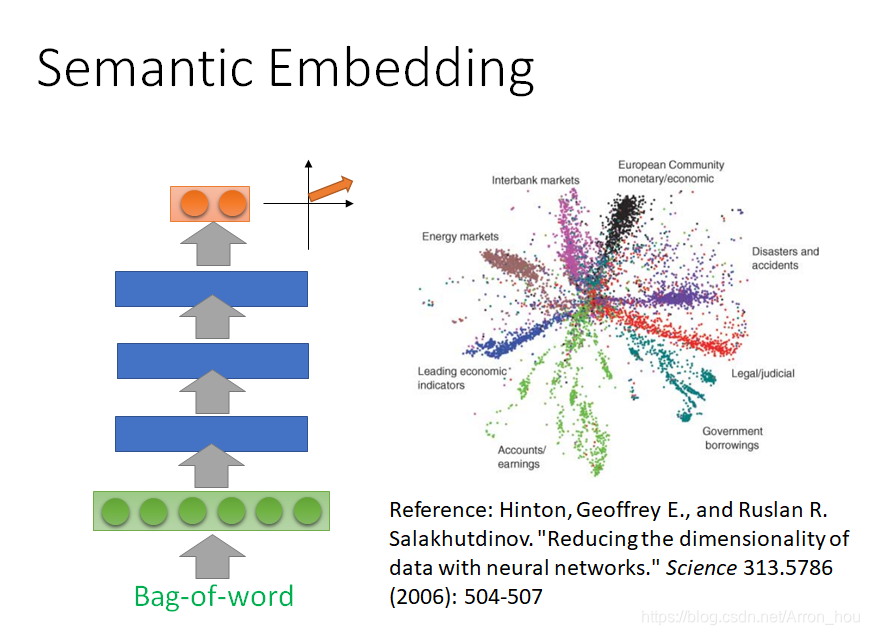

所以主要的目的在降维中理解词与词之间的关系.使用的方法就是Word Embeddng.

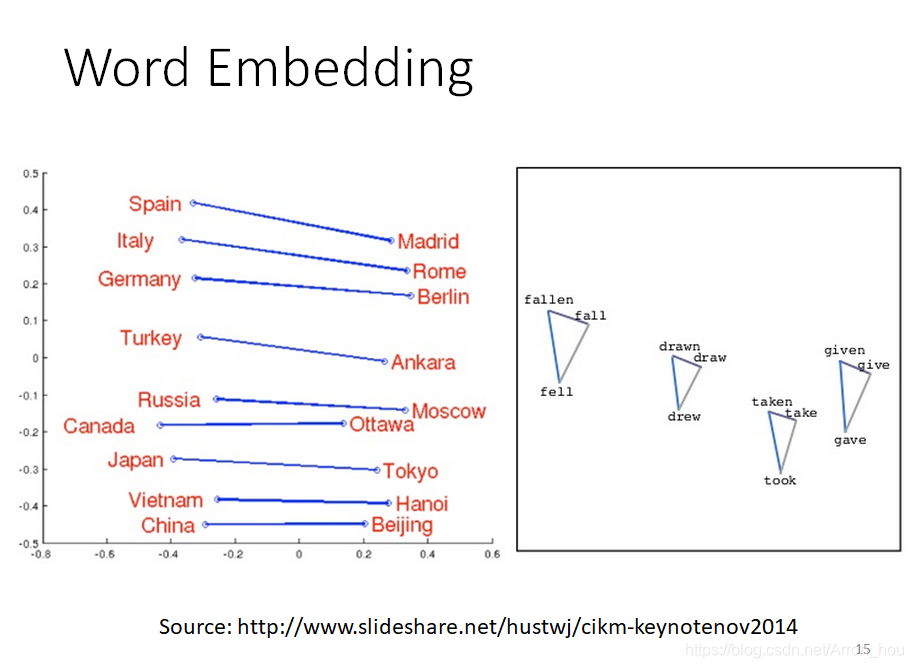

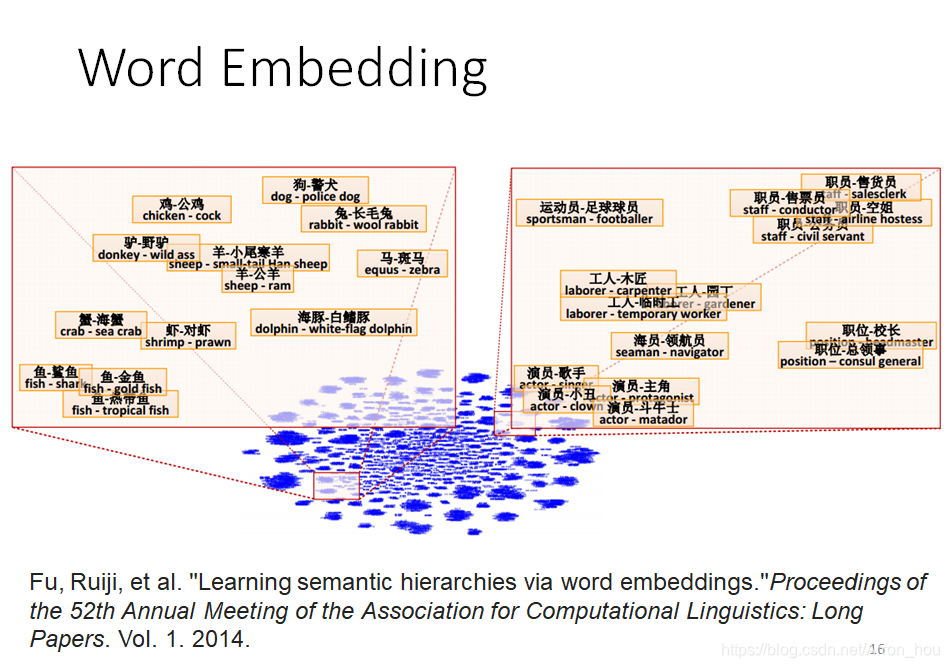

例如对class1,class2,class3中的词做完Word Embeddng之后,在某一个维度下,就是如下的一个坐标,距离的远近表示了相关性.

Word Embeddng是什么呢?

通过上面的描述,我们输入一个词的one-hot向量,输出就是一个Word Embeddng的向量.

我们用Word Embeddng直接的距离表示词与词之间的相关性.

而且,当词库不同时,每一个词对应的Word Embeddng也是不同,词库的规模不同时,Word Embeddng的size也是不同的.

所以做Word Embeddng是一个unsupervised Learning的方法.

如何做Word Embeddng?

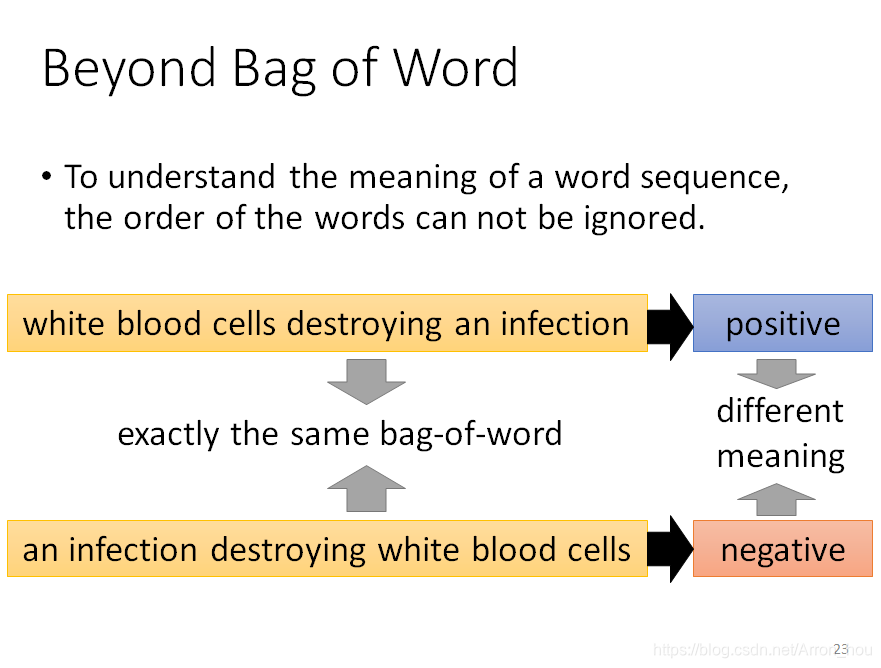

Word Embeddng的思想就是根据每一个词的上下文,判断一个词的含义.当若干个词的上下文相同时,认为他们属于一类.所以Word Embeddng类似于人类学习词汇,依赖于字典或文章中的例句理解含义.

实现方法有两种:

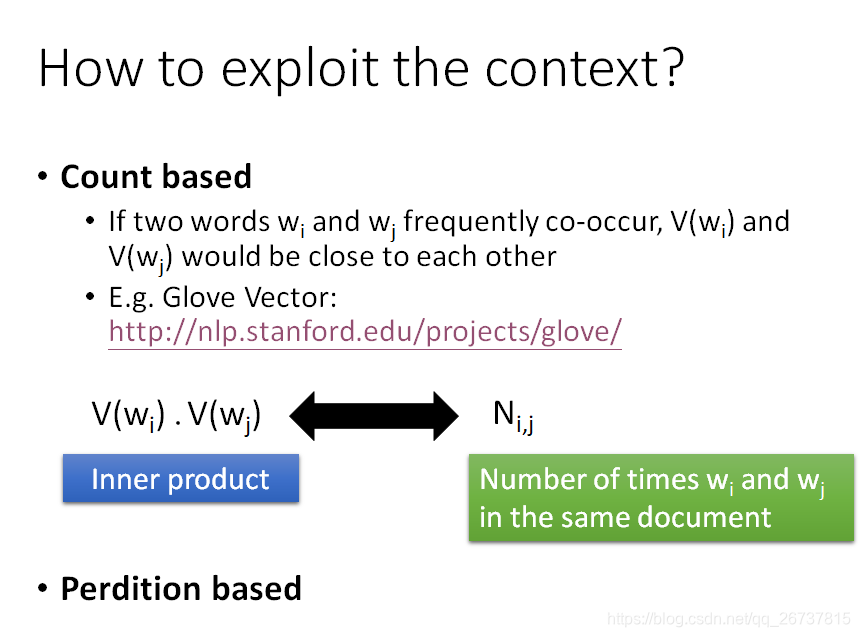

count based

两个词常常同时出现,他们的含义就十分接近.

所以设同时出现次数是

,目标就是找到两个vector表示两个词,让这两个词的内积接近

.

这两个vector就是词向量对应的

类似与矩阵分解中的LSA

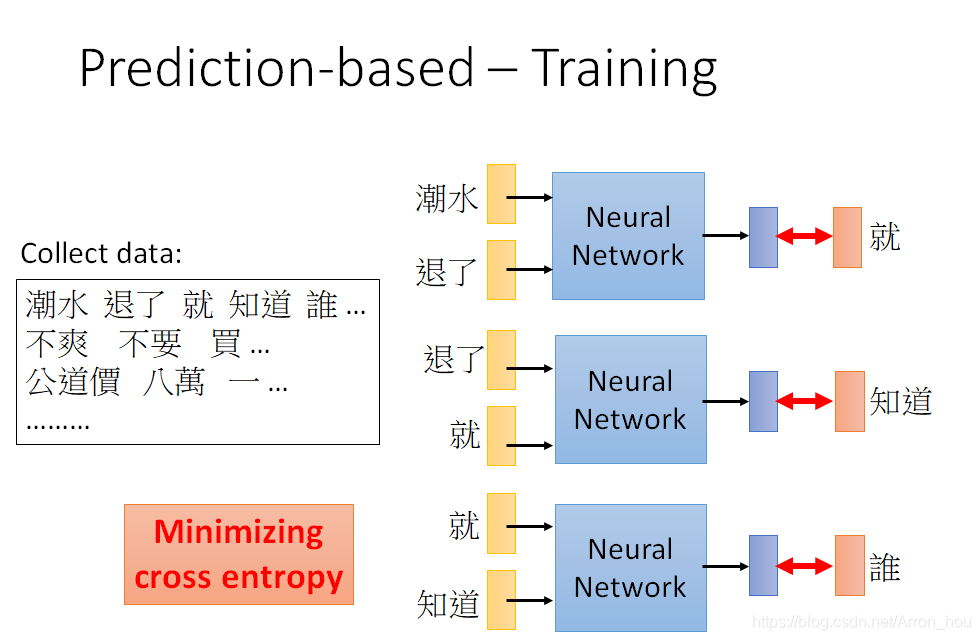

Perdition based

输入一个词,预测下一个的机率.

可以作为监督学习模型训练,神经网络的中间层就是word embedding.

loss function 选择cross entropy.

在训练中,需要输入连续的10个词,才能得到reasonable的结果.

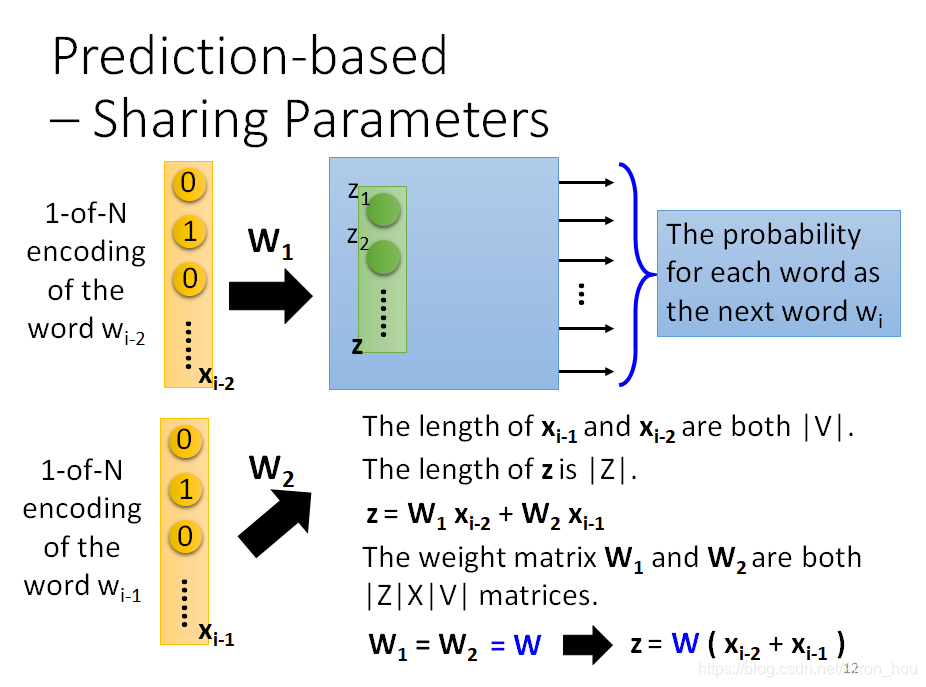

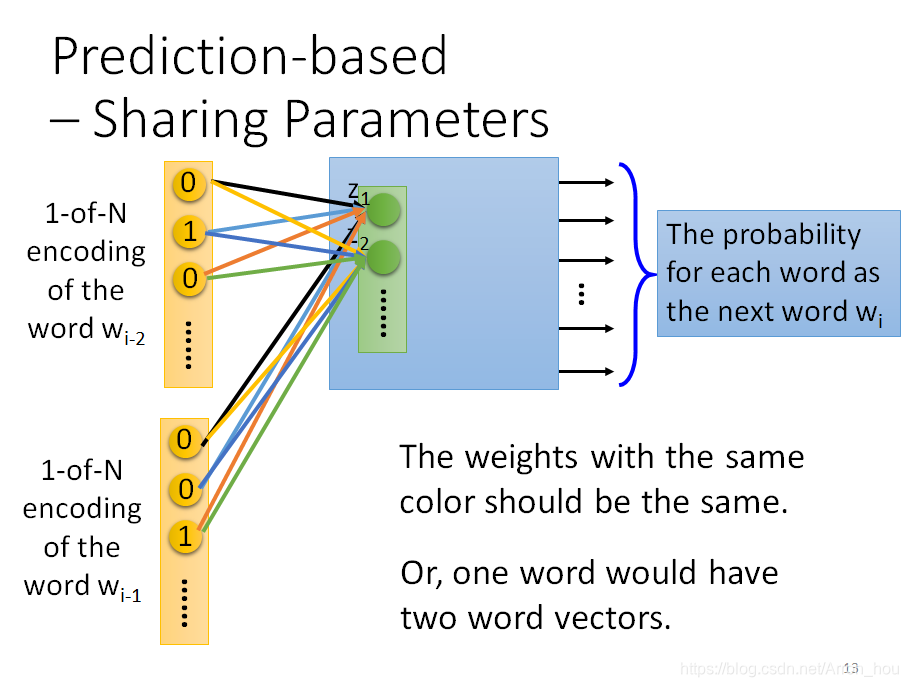

按照顺序输入10个词,同时让每一个词的每一个维度与其他词的相同维度使用同一个参数,所以如下图,相同颜色表示的权重是一样的.

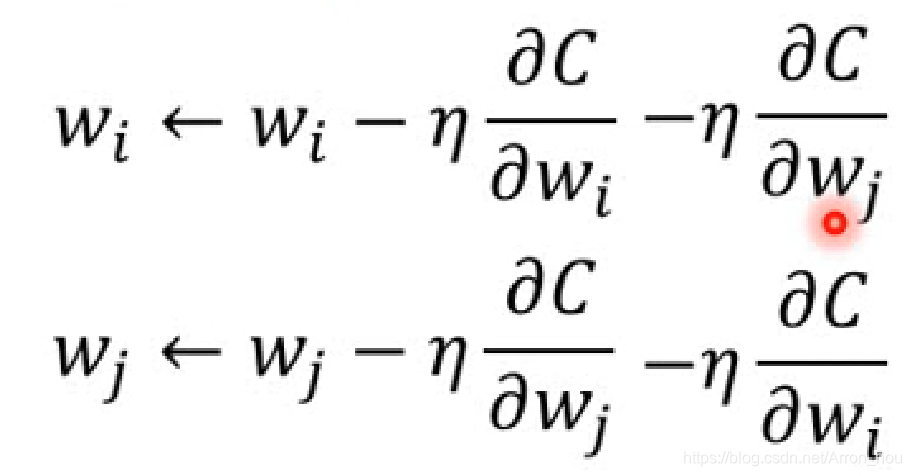

为了达到上述效果,对应位置参数使用相同的值初始化,在反向传播时,更新参数时减去所有的每一个词向量的偏导数.

变形

注意所有的Neuarl Network是只有1层的神经网络.

Word Embeddng的应用

发掘词与词之间的关系

word vector paper

Tomas Mikolov

https://blog.csdn.net/m0epnwstyk4/article/details/79124801

https://blog.csdn.net/itplus/article/details/37969519

- Paragraph Vector: Le, Quoc, and Tomas Mikolov. "Distributed Representations of Sentences and Documents.“ ICML, 2014

- Seq2seq Auto-encoder: Li, Jiwei, Minh-Thang Luong, and Dan Jurafsky. “A hierarchical neural autoencoder for paragraphs and documents.” arXiv preprint, 2015

- Skip Thought: Ryan Kiros, Yukun Zhu, Ruslan Salakhutdinov, Richard S. Zemel, Antonio Torralba, Raquel Urtasun, Sanja Fidler, “Skip-Thought Vectors” arXiv preprint, 2015.