- 摘要

对智能移动应用的需求飙升需要在移动设备上部署强大的深度神经网络(DNN)。然而,DNN的出色性能众所周知地依赖于越来越复杂的模型,而这反过来又与计算开销的增加相关,远远超过了移动设备的容量。更糟糕的是,应用服务提供商需要收集和利用包含敏感信息的大量用户数据来构建复杂的DNN模型。在公共移动设备上直接部署这些模型会带来过高的隐私风险。为了从没有容量和隐私问题的设备深度学习中受益,我们设计了一个私有模型压缩框架RONA。遵循知识蒸馏范式,我们联合使用提示学习,蒸馏学习和自学习来训练紧凑而快速的神经网络。从繁琐的模型中提取的知识被自适应地限制并且被小心地扰乱以实施差异隐私。我们进一步提出了一种优雅的查询样本选择方法,以减少查询次数并控制隐私丢失。一系列实证评估以及Android移动设备上的实施表明,RONA不仅可以有效地压缩繁琐的模型,还可以提供强大的隐私保障。例如,在SVHN上,当保证有意义的(9.83; 10-6) - 差异隐私时,由RONA训练的紧凑模型可以获得20倍压缩比和19倍加速,只有0.97%的准确度损失。

- 简介

近年来,各个领域的深度学习取得了令人瞩目的突破。 由于大量数据和计算资源的易用性,定制的深度学习模型获得了前所未有的性能,超过了传统机器学习算法的许多记录。

另一方面,深度学习的重大进步因其依赖于需要大量数据来学习其数百万个参数的繁琐模型而臭名昭着。 这一主要缺点限制了深度学习应用程序的大规模部署,特别是深度神经网络在智能手机,可穿戴设备和医疗监视器等移动设备上的可部署性(Cao等人2017; Sun等人2017)。 移动应用服务提供商面临着在其移动应用中广泛采用DNN的一系列挑战。

容量瓶颈。 尽管移动芯片和移动电池取得了巨大进步,但移动设备的容量有限性仍然存在固有的瓶颈,使得资源要求苛刻的应用仍然不受限制(Wang等,2018)。 具有数百万个参数的现代DNN通常需要在计算受限的设备上执行禁止的运行时间。 更糟糕的是,执行过程中的大规模浮点运算加剧了处理芯片的负担,并且很容易控制整个系统的能耗,从而扩大了DNN与移动设备可部署性之间的鸿沟。 到目前为止,很难在移动系统上直接采用强大的DNN(Lee 2017)。

数据隐私和智力盗版问题。 开发强大的预测性DNN需要丰富的数据。 可访问的数据越多,DNN就越有效和强大。 在实践中,应用服务提供商通常收集和利用来自用户的大量数据,这些数据通常包含敏感信息,以构建其复杂的DNN模型。 直接发布由用户数据训练的这些模型存在潜在的隐私问题,因为攻击者可以恢复公共模型中编码的敏感信息(Abadi等人,2016)。 在医学等许多领域直接分享个人数据或模型是非法的(Claerhout和DeMoor,2005)。 除了数据隐私之外,由于智能盗版,发布DNN模型可能会侵犯应用服务提供商的权利。 对于应用服务提供商来说,分享他们有价值且高度调整的模型有时并不吸引人(Osia等人2017)。

为了在移动设备上部署有效的DNN,学术界和工业界提出了许多模型压缩方法,其中知识蒸馏起着关键作用(Bucilua,Caruana和Niculescu-Mizil,2006)。 在知识蒸馏中,嵌入在繁琐模型中的知识(称为教师模型)被提炼出来以指导训练称为学生模型的较小模型。 学生模型具有不同的体系结构和较少的参数,但可以通过模仿繁琐模型的行为来实现相当的性能。 其他压缩方法,如量化和低秩分解(Han,Mao和Dally 2016;Howard等人2017)是知识蒸馏的补充,也可用于进一步缩小学生模型的大小,这超出了 这篇报告。 尽管压缩率令人鼓舞,但目前的知识蒸馏方法还没有完全解决隐私问题。

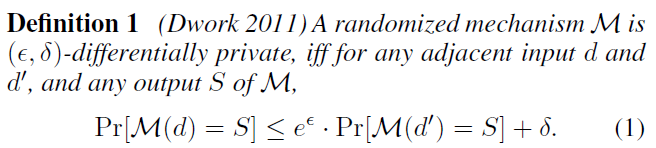

在本文中,我们介绍了严格的差异隐私标准(Dwork 2011),并设计了一个名为RONA的私有模型压缩框架,以克服上述挑战并促进在移动应用中采用深度学习。

建议的框架中考虑了模型压缩和数据隐私。我们假设应用服务提供商已根据敏感数据和公共数据训练了一个功能强大的繁琐模型。根据知识蒸馏范例,RONA仅使用公共数据来训练小型学生模型,其特征表示被鼓励与繁琐模型的特征表示类似。然后将小型学生模型发布给移动应用程序用户,同时由应用程序服务提供商保留繁琐的模型以及敏感数据。直观地,保留了隐私,因为学生模型的训练不依赖于敏感数据;繁琐的模型和敏感数据都不会暴露给公众或对手可以访问。然而,纯粹的直觉是不够的。为了提供可证明的隐私保障,我们会仔细扰乱从繁琐模型中提取的知识,以满足差异隐私的标准。

联合压缩大型DNN,保护隐私和控制模型性能损失是一个非常重要的问题。 提出了一套新方法来解决这个问题。 我们的主要贡献有四方面:

促进移动应用程序深度学习的框架。 我们考虑了在移动应用中采用DNN的关键约束,即隐私,性能和开销,并设计了一个私有规划框架,用于通过知识蒸馏训练紧凑神经网络。 据我们所知,提出的RONA是第一个将知识蒸馏应用于具有有意义隐私保证的压缩模型的框架。

差异化的私人知识蒸馏。 为了在理论上保证隐私,我们提出了一种新的机制来从差异隐私的意义上扰乱知识蒸馏。 与现有的逐个样本查询模式不同,我们提出的机制以批处理模式进行查询以减少查询数量。 由教师模型响应的批量损失被自适应范数限制,然后仔细扰动以保护隐私。

一种用于知识蒸馏的查询样本选择方法。 隐私损失取决于查询的数量。 为了控制学生模型对教师模型的访问,应减少知识蒸馏期间使用的样本数量。 因此,我们提出了一种查询样本选择方法来选择样本子集,使得在子集上提取的知识在整个样本中具有竞争性。

彻底的实证评估。 我们通过使用广泛用于知识蒸馏工作的三个标准基准来评估所提出的RONA。 结果证明了上述新方法的有效性,通过严格的隐私保证为小型模型的训练带来了显着的改进。 我们的代码在https://github.com/jwanglearn/Private_Compress上开源。

- 初步及相关工作

深度神经网络压缩。为了将DNN压缩到移动设备中,DNN压缩引起了人们的极大关注。压缩方法可大致分为四类:参数共享,网络修剪,低秩分解和知识蒸馏(Han,Mao和Dally 2016; Howard等人2017; Chen等人2017)。前三种方法主要尝试减小给定模型的size,而不会显着改变模型的体系结构。最后一个,知识蒸馏,利用繁琐模型捕获的知识来指导教师 - 学生范式中较小模型的训练(Bucilua,Caruana和Niculescu-Mizil,2006)。 Hinton等人 (Hinton,Vinyals和Dean 2014)使用教师生成的分类概率作为训练学生模型的软目标。罗梅罗等人(Romero等人,2015)通过训练学生模仿教师的中间代表来扩展这项工作。基于这两项工作,Chen等人设计了一个压缩物体检测模型的框架(Chen et al.2017),试图解决阶级失衡问题。现有的模型压缩方法很少考虑到隐私问题。在训练期间可以根据需要多次查询教师模型,如果我们想要保护隐私,那么这是不可行的。

差异私人深度学习。 由于尊重隐私的迫切需要,隐私保护数据分析已成为一个新兴的话题。 一个最先进的隐私标准是差异隐私(Dwork 2011),它提供了可证明的隐私保障。

通常,除了仅一个数据项外,d和d’是相邻的输入。 参数ε表示隐私预算(Dwork 2011),控制M的隐私损失。 较小的值可以强制实施更强大的隐私保障。

对于确定性函数f,高斯机制由下式给出,