论文地址:http://arxiv.org/abs/1811.10559

github地址:无

本文于18年发表,提出了基于filter相关性的模型压缩方法。其特点是在建立相关性系数后对相关性强的filter进一步增强相关性,从而降低了filter剪枝后的损失。

Motivation

以往的基于重要性指标的剪枝方法没有充分考虑filter之间的冗余,仅考虑filter的重要程度,因此存在重要但冗余的filter不会被剪枝,从而在压缩冗余上做不到最优性。因此,本文提出基于filter相关性的剪枝方法提升网络压缩率。

Methods

本文提出基于filter相关性系数的迭代式剪枝过程。其框架图如图所示:

具体流程:Episode Selection阶段逐层计算任意两个filter的相关系数,将相关系数作为每对filter的重要性指标,相关系数越趋于0,则越重要,线性相关度越低;越趋于±1则越不重要,filter之间线性相关度越高。每层抽取出N个最不重要的filter对,构成第t次迭代剪枝的episode S t S_t St。在Optimization阶段,在损失函数中加入正则化项。

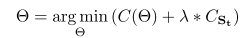

C ( θ ) C(\theta) C(θ)为损失函数, C S t C_{S_t} CSt为正则化项,用于提高 S t S_t St中filter对的相关系数,从而减少剪掉每对filter其中一个filter后的信息损失。 C S t C_{S_t} CSt表达式如下:

其中 ρ X Y \rho_{XY} ρXY为 C S t C_{S_t} CSt中filter对的皮尔森系数,可推得当 C S t C_{S_t} CSt减小时,指数项的相关系数增大,即达到提高相关性的作用。

Discard N Filters:该阶段从 C S t C_{S_t} CSt中选取前N个不重要的filter对,剪去每对中的任意一个,得到剪枝后的网络。

之后进行微调,在可允许的最大误差范围内反复循环上述过程,达到最大程度的压缩。

Experiment

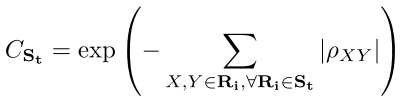

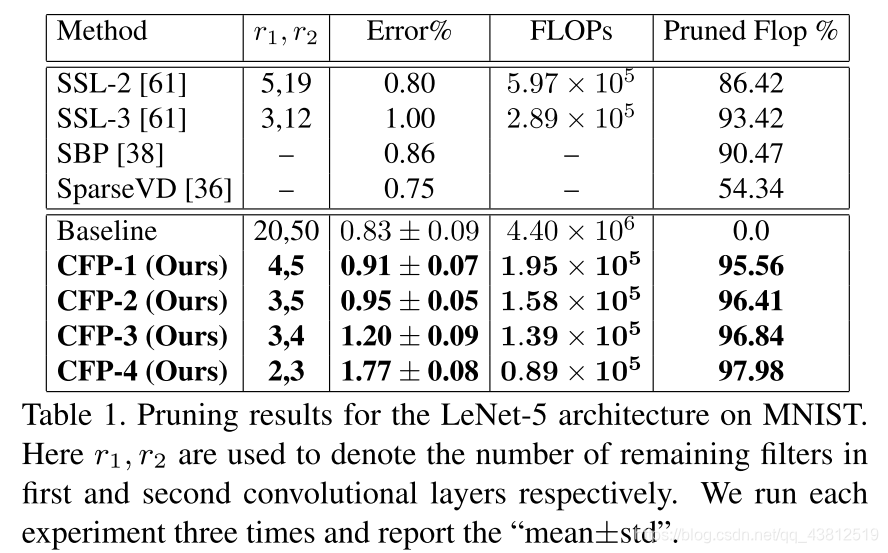

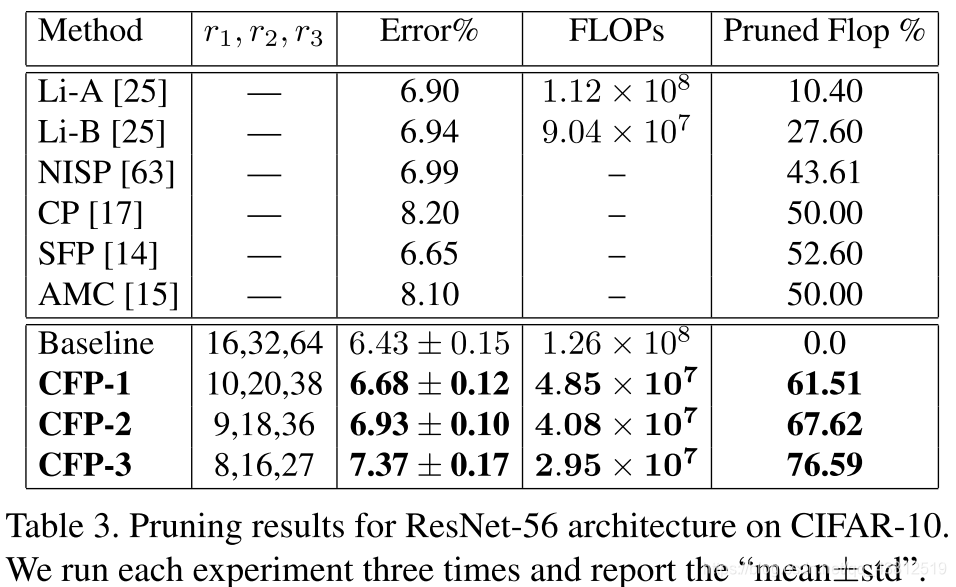

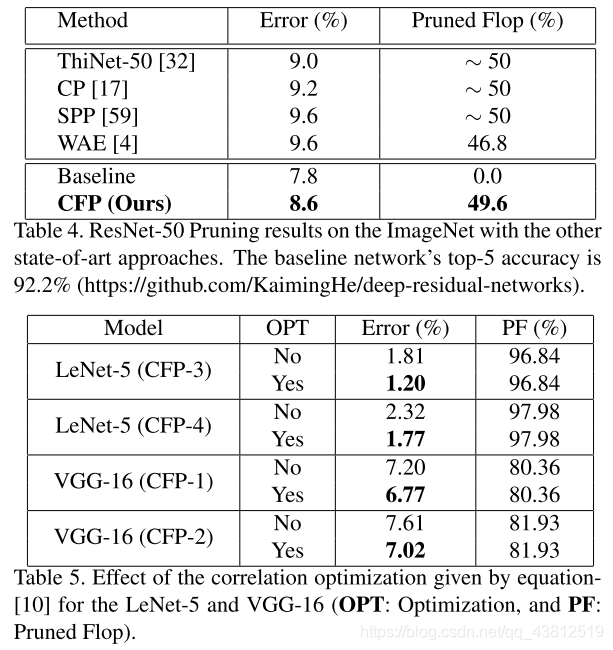

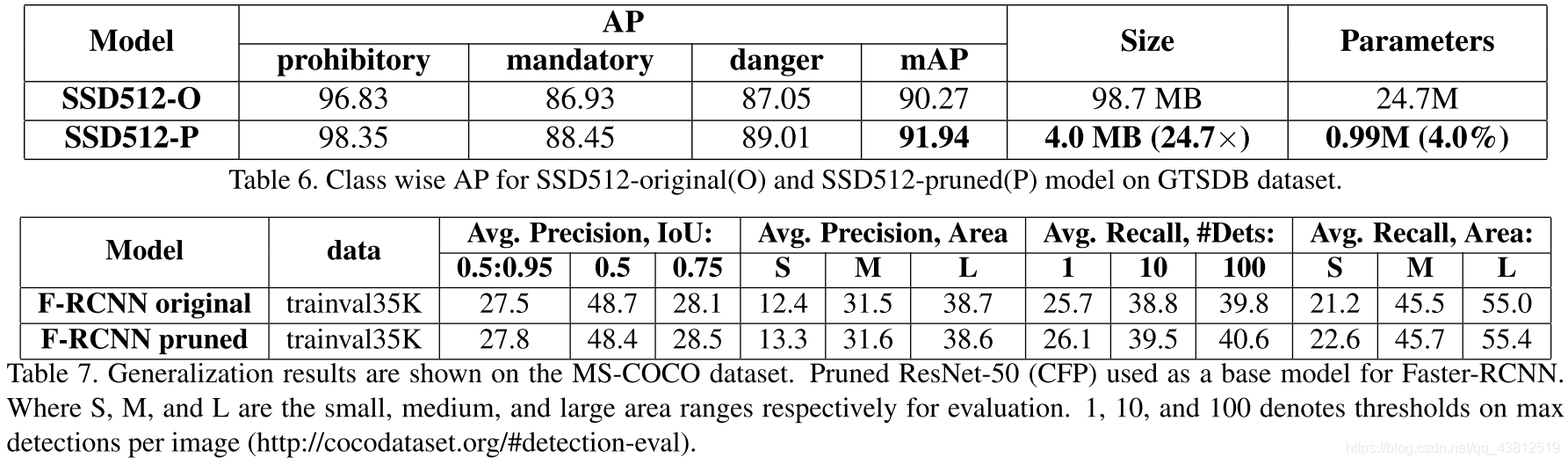

本文从分类和检测两个任务检验方法的有效性。对于分类模型,选用LeNet-5,VGG-16,ResNet-50, 56;对于检测,选用Faster-RCNN和SSD网络。

GPU:GTX 1080 Ti

λ \lambda λ(正则化前的超参):1

Results

Thoughts

这篇我觉得是基于重要性指标的剪枝方法的补充,因为大部分剪枝算法计算的是其重要性,无论是最简单的L1,L2Norm还是最近的HRank,其计算重要性指标时均未考虑重要的滤波器可能具有高度的相关性,这也是另一种冗余。因此,该方法可以和其他剪枝方法相结合,进行二次剪枝,可能能达到更高的压缩率。